开源网页采集软件:十大详细分析!

优采云 发布时间: 2023-03-06 12:21在当今信息大爆炸的时代,数据已经成为了企业决策的重要基础。但是,如何获取大量且准确的数据却是一个不小的挑战。这时候,开源网页采集软件就成为了一种重要的选择。本文将从以下十个方面对开源网页采集软件进行详细分析。

一、什么是开源网页采集软件?

开源网页采集软件是指基于开放源代码技术的网络数据采集工具,可以帮助用户快速而准确地获取互联网上所需的各类数据。相较于传统数据获取方式,开源网页采集软件具有效率高、成本低等优势。

二、为什么需要使用开源网页采集软件?

1.快速获取所需数据

相比手动复制粘贴或者编写爬虫程序,使用开源网页采集软件,可以更快速地获取所需数据。

2.提高工作效率

通过使用开源网页采集软件,可以大幅度减少人工处理时间和工作量,提高工作效率。

3.优化SEO

通过对所采集的数据进行分析和处理,可以帮助企业优化SEO,并提升品牌知名度和竞争力。

三、常见的开源网页采集软件有哪些?

目前市面上有很多种开源网页采集软件,比如Scrapy、BeautifulSoup、WebHarvy等等。这些工具各有特点和适用场景,在选择时需要根据实际需求进行综合考虑。

四、Scrapy:强大的Python爬虫框架

Scrapy是一款基于Python语言编写的强大爬虫框架,支持异步IO操作,并且可扩展性非常好。在使用Scrapy进行爬虫时,可以通过编写Spider来定义抓取规则,并通过Pipeline进行数据处理。

代码示例:

```

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['http://www.example.com']

def parse(self, response):

#解析页面内容

pass

```

五、BeautifulSoup:Python中最流行的HTML解析库

BeautifulSoup是Python中最流行的HTML解析库之一,它可以轻松地从HTML或XML文档中提取信息,并支持CSS选择器和XPath语法。

代码示例:

```

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_doc,'html.parser')

print(soup.title.string)

```

六、WebHarvy:易于使用且功能强大的网络爬虫工具

WebHarvy是一款易于使用且功能强大的网络爬虫工具,它支持自定义抓取规则,并可将结果导出为CSV、Excel等格式。

七、如何选择适合自己的开源网页采集软件?

在选择适合自己的开源网页采集软件时需要考虑以下几个方面:

1.功能是否满足需求

在选择时需要根据实际需求来确定功能是否满足要求。

2.易用性如何

易用性是影响用户体验和效率的重要因素之一。

3.可扩展性如何

可扩展性可以保证在未来应对新需求时能够快速扩展和更新功能。

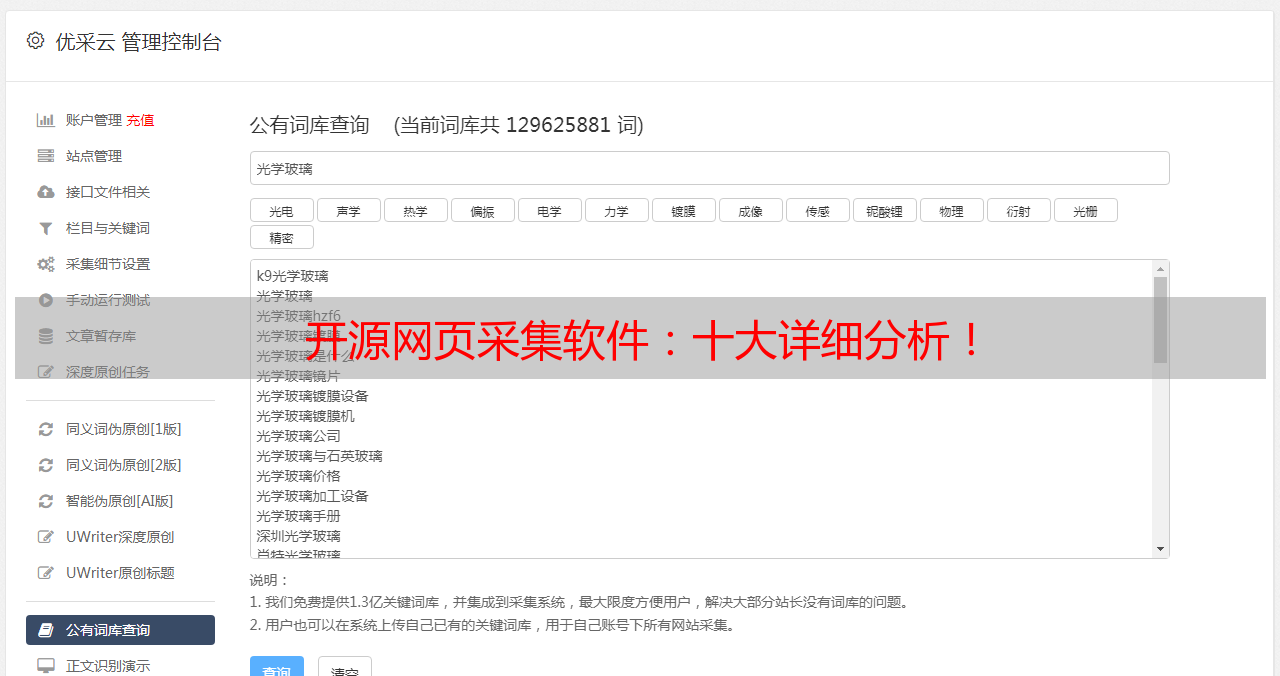

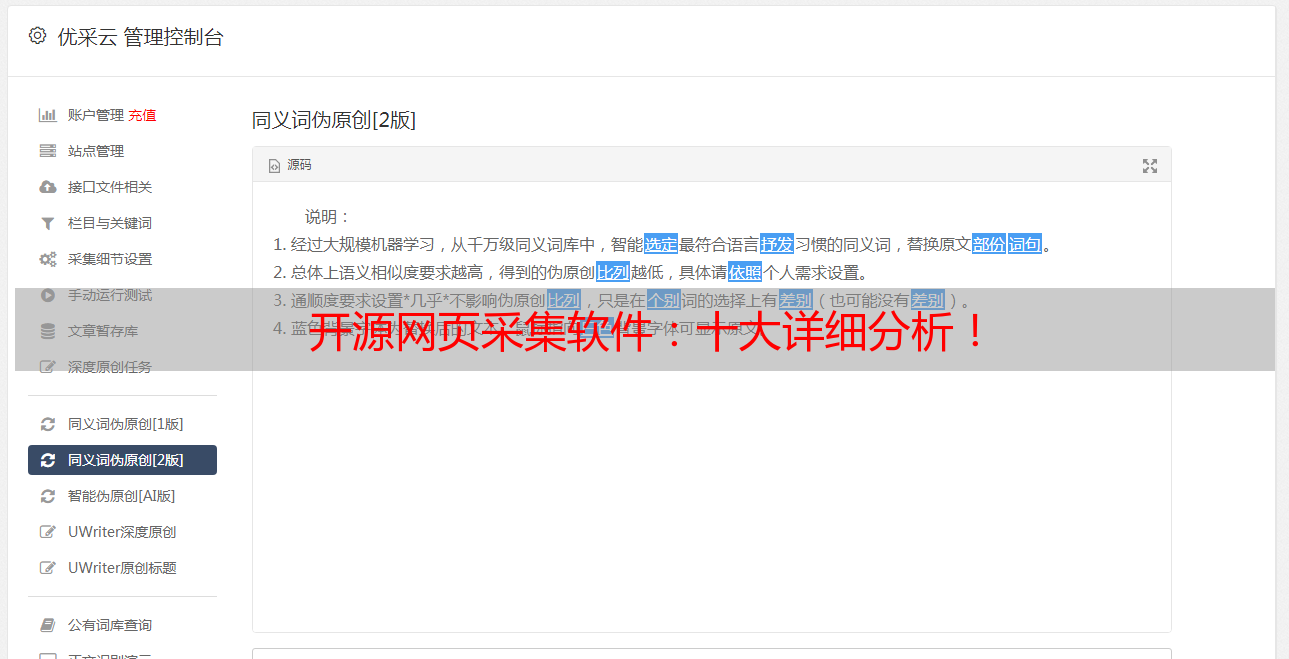

八、如何使用优采云进行数据处理与分析?

优采云是一款专业的数据处理与分析平台,在使用优采云进行数据处理与分析时可以遵循以下步骤:

1.导入所需数据

通过优采云平台导入所需数据,并根据实际情况进行清洗和预处理。

2.运用算法进行分析

通过运用各种算法对所导入的数据进行分析并生成图表或报告。

3.输出结果并导出文件

最后将结果输出并导出文件以便进一步利用或分享。

九、如何通过SEO优化提升品牌竞争力?

SEO(Search Engine Optimization)即搜索引擎优化,在当今竞争激烈的市场环境下,通过SEO优化来提升品牌竞争力已经成为了企业必须面对的问题。而利用开源网页采集软件来获取关键词排名等相关信息,则成为了SEO优化过程中必不可少的一环。

十、结语

通过本文对开源网页采集软件进行详细分析后我们可以发现,在当今数字化时代中,获取准确且大量的数据已经成为了企业决策和发展过程中不可或缺的一部分。而利用开源网页采集软件,则成为了实现这一目标所必须掌握和应用的重要技能之一。在此同时也需要注意保护隐私并遵守相关规定,同时推荐大家尝试使用专业且安全可靠的平台比如优采云(www.ucaiyun.com),以便更好地管理和利用所收集到的数据,并提升品牌竞争力。