爬虫采集简历数据必知9项 注意,抓取质量与合法性同等重要!

优采云 发布时间: 2023-03-06 09:18随着互联网技术的不断发展,人才招聘已经不再局限于传统的方式。越来越多的企业开始采用数据挖掘和分析技术,以更高效、精准的方式寻找合适的人才。而在这些技术中,爬虫技术无疑是最为重要和实用的一种。

那么,什么是爬虫?简单地说,爬虫就是一种程序,它可以自动化地访问互联网上的网站,并从中提取所需信息。在人才招聘领域中,我们可以通过爬虫技术来采集大量的简历数据,并对这些数据进行分析和挖掘,以便更好地了解求职者的基本信息、*敏*感*词*、教育背景等。

下面,我们将从以下9个方面来逐步分析讨论如何使用爬虫采集简历数据。

一、确定采集目标

在使用爬虫采集简历数据之前,首先需要确定采集目标。这包括确定需要采集哪些信息、从哪些网站上采集、以及如何设置搜索条件等。例如,在寻找销售人员时,我们可以从各大招聘网站上获取相关信息,并通过关键词搜索来筛选出符合要求的简历。

二、选择合适的爬虫工具

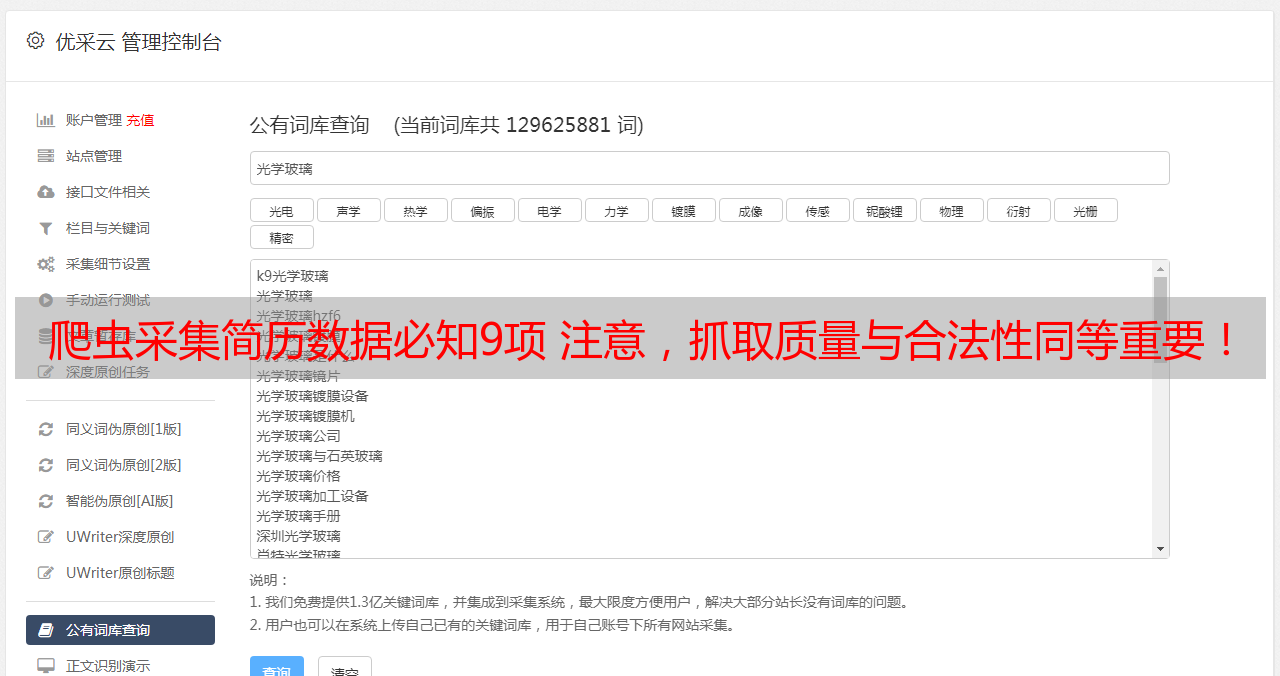

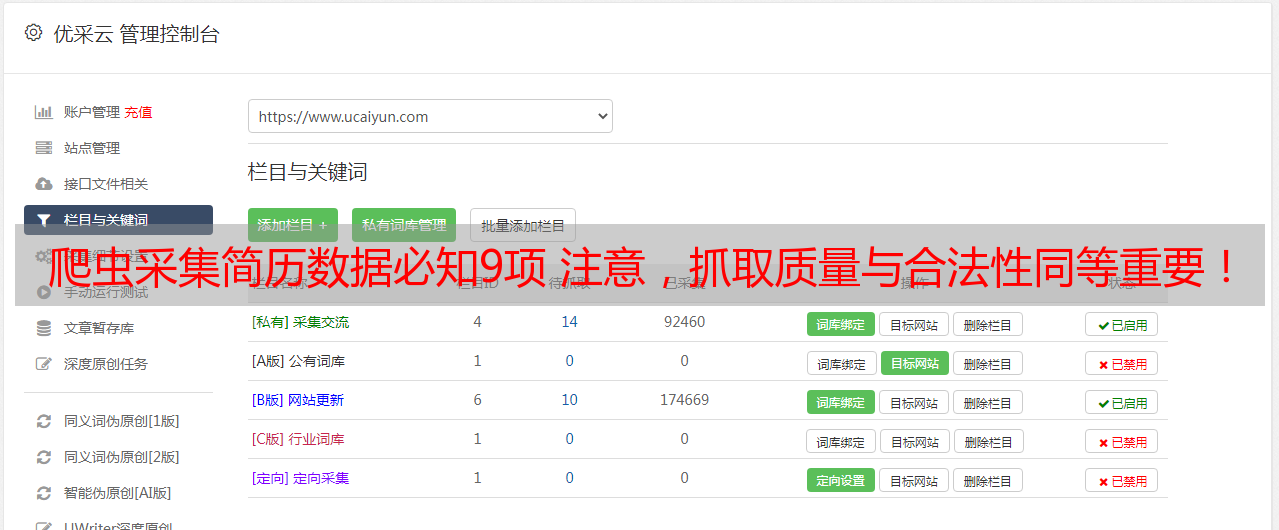

选择合适的爬虫工具非常重要。一般来说,我们可以选择Python、Java等编程语言来编写自己的爬虫程序。同时,也可以使用一些第三方开源框架或工具来快速构建自己的爬虫系统。例如,优采云就是一个非常实用和方便的爬虫工具平台。

三、设计合理的数据结构

在采集简历数据之前,需要设计合理的数据结构来存储和管理这些数据。一般来说,我们可以使用数据库或者文件系统等方式来存储这些数据,并通过索引和查询等方式来快速检索所需信息。

四、制定合理的访问策略

在进行爬虫操作时,需要制定合理的访问策略以遵守相关法律法规和网站规定。例如,在进行大量访问时需要设置访问间隔时间、限制并发连接数等措施以保证不对目标网站造成过大压力。

五、处理反爬机制

很多网站都会设置反爬机制以防止被恶意访问和抓取。因此,在进行简历采集时需要处理相关反爬机制,并通过相应手段绕过这些限制。

六、清洗和处理数据

在获取到大量简历数据后,需要对这些数据进行清洗和处理以去除重复或无用信息,并将其转换为能够直接使用或分析挖掘的格式。

七、进行分析和挖掘

在清洗和处理完毕后,我们可以通过各种统计学方法、机器学习算法等手段对这些简历数据进行分析和挖掘,并得出有价值的结论或预测。

八、实现自动化操作

为了更好地利用这些简历数据并提高工作效率,我们可以将相关操作实现自动化。例如,在某个特定时间点自动更新最新简历信息等。

九、SEO优化

为了更好地将自己发布招聘信息推广出去并吸引更多求职者关注,在发布招聘信息时需要注意SEO优化。优采云提供了强大的SEO优化功能,可以帮助企业更好地推广自己发布的招聘信息。

总之,在当今竞争激烈的市场环境下,使用爬虫技术采集简历数据已经成为了越来越多企业寻找人才的主要方式之一。而借助优采云这样实用而方便的平台,则可以更加轻松快捷地实现相关操作,并获得更好的效果。