爬虫抓取总是不全?10种技巧帮你完整获取网页源码

优采云 发布时间: 2023-03-06 08:11在当今这个信息爆炸的时代,互联网上的内容日新月异,许多人都希望通过爬虫技术来获取所需的数据。然而,我们经常会发现,爬虫抓取总是抓不全网页源码。这是为什么呢?在本文中,我们将从10个方面进行逐步分析讨论。

第一、网站反爬虫机制

很多网站都设置了反爬虫机制。这些机制可以防止爬虫对网站进行大量访问和抓取数据。常见的反爬虫机制包括IP限制、User-Agent限制、验证码、JavaScript加密等。当我们使用普通的爬虫程序去访问这些网站时,很容易被识别并拒绝访问。

第二、动态加载

现在很多网站采用了动态加载技术,即页面上的数据不是一次性加载出来的,而是通过Ajax等技术实现了异步加载。这就导致了我们在使用爬虫程序抓取页面时无法获取所有数据。

第三、JavaScript渲染

有些网站使用JavaScript来渲染页面,这种情况下,我们只能获取到JavaScript代码,而无法获取到最终生成的HTML代码。这就需要使用一些解析JavaScript代码的工具来解决。

第四、CDN加速

一些大型网站采用了CDN加速技术,即将静态资源(如JS、CSS、图片等)分布到全球各地的服务器上,使用户可以从离自己最近的服务器获取资源。但这也会导致我们在抓取页面时无法获得完整的HTML代码。

第五、动态URL

有些网站通过动态URL来生成页面内容,在每次请求时都会生成一个新的URL。这样就导致了我们无法准确地确定每个页面的URL地址,从而无法进行有效的抓取。

第六、AJAX异步请求

除了动态加载外,很多网站还采用了AJAX异步请求技术。当我们使用普通的爬虫程序去访问这些页面时,只能获取到部分数据,并不能获取到完整的HTML代码。

第七、重定向跳转

有些网站采用了重定向跳转技术,在我们请求某个URL时会自动跳转到另一个URL。这样就导致了我们无法准确地确定每个页面的URL地址。

第八、cookie认证

有些网站需要进行cookie认证才能访问其内容。如果没有正确设置cookie信息,则无法正常访问和获取数据。

第九、HTML格式错误

有些网站存在HTML格式错误或嵌套错误等问题,在使用爬虫程序进行解析时容易出现错误或漏洞。

第十、网络环境问题

最后一个原因是网络环境问题。由于网络环境不稳定或者网络延迟过高等原因,在使用爬虫程序进行抓取时可能会出现丢包或者超时等问题。

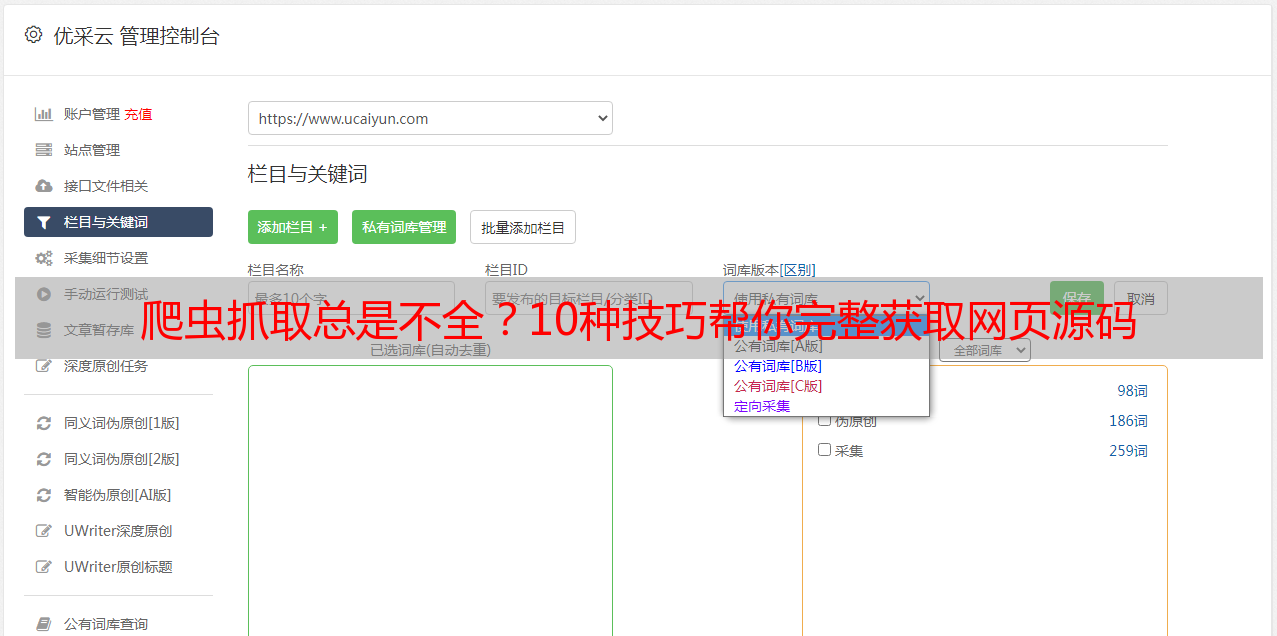

以上是造成爬虫抓取总是抓不全网页源码的10个主要原因。为了解决这些问题,我们可以采用一些方法来提高数据采集效率和准确性。例如可以使用专业的SEO优化工具——优采云(www.ucaiyun.com),该工具可以帮助我们快速发现并解决各种SEO问题和优化建议,并提供强大的数据分析功能和数据可视化报表。此外还可以针对特定问题选择合适的解决方案和工具来提高数据采集效率和准确性。

通过以上分析和方法介绍,相信大家已经对造成爬虫抓取总是抓不全网页源码有了更深入的理解,并且掌握了一些实用方法来提高数据采集效率和准确性。