“爬虫无法抓取”的HTML代码混淆方法与实现,了解这10个原理!

优采云 发布时间: 2023-03-05 00:10在网络时代,信息获取和数据分析是非常重要的。然而,某些网站为了保护自己的数据和隐私,会采取各种方法来防止被爬虫抓取。其中,HTML代码混淆就是一种非常有效的方法。本文将从以下10个方面详细介绍HTML代码混淆的原理、方法和实现。

1. 什么是HTML代码混淆?

2. HTML代码混淆的原理是什么?

3. HTML代码混淆有哪些常见方法?

4. 为什么使用HTML代码混淆可以防止爬虫抓取?

5. 在什么情况下需要使用HTML代码混淆?

6. HTML代码混淆对SEO优化有何影响?

7. 如何实现HTML代码混淆?

8. HTML代码混淆有哪些注意事项?

9. HTML代码混淆对网站性能和用户体验有何影响?

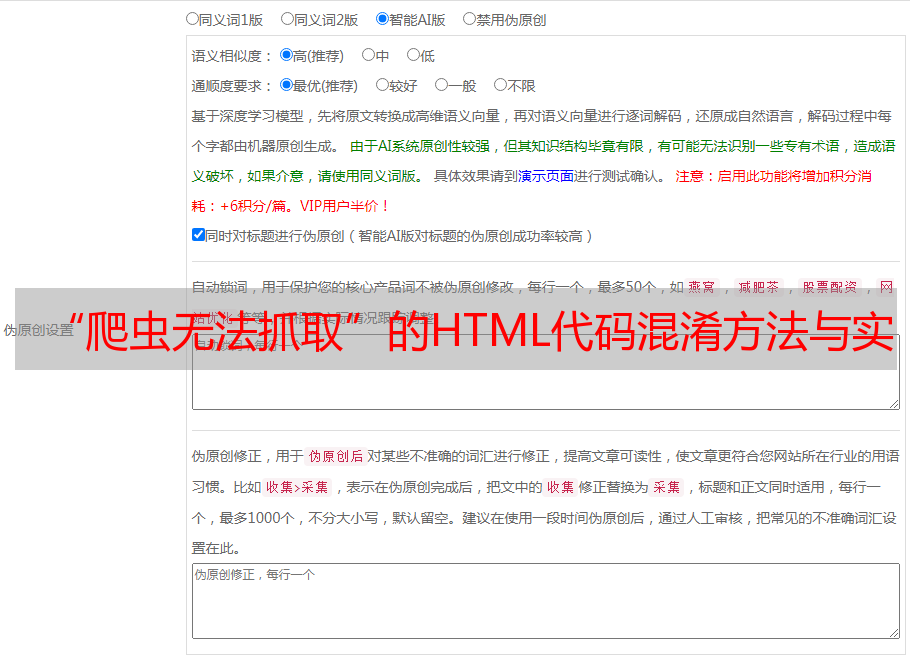

10. 优采云:一款强大的SEO优化工具

HTML代码混淆是指通过修改、添加或删除HTML标签、属性和内容等方式,使得网页源码变得难以理解和识别,从而防止爬虫抓取数据。HTML代码混淆在保护网站数据安全、保护隐私、防止恶意攻击等方面起到了重要作用。

HTML代码混淆的原理是利用浏览器解析HTML源码时的容错机制。浏览器会自动修复一些错误或不规范的标签和属性,从而使得页面能够正常显示。而这种容错机制也为HTML代码的“破坏”提供了契机。

常见的HTML代码混淆方法包括:删除空格、换行符、注释等无关紧要的字符;使用Unicode编码替换某些字符或字符串;使用CSS样式隐藏部分内容等。这些方法都可以有效地干扰爬虫对网页源码的解析和分析。

使用HTML代码混淆可以防止爬虫抓取数据,尤其是对那些敏感信息或商业机密更加重要。如果不采取措施,爬虫可以轻松地获取网站上所有公开信息,甚至可能导致严重后果。

在需要保护隐私或商业机密的场合下,例如金融、医疗、电商等领域,都需要采取HTML代码混淆等措施来加强安全保护。

HTML代码混淆对SEO优化有一定影响。一方面,过度使用HTML代码混淆可能导致搜索引擎无法正常识别网站内容,从而影响排名和流量;另一方面,在特定情况下适当使用HTML代码混淆可以增加页面权重和防止竞争对手模仿。

实现HTML代码混淆主要有两种方式:手动编写JavaScript脚本或使用专业工具进行自动化处理。手动编写JavaScript脚本需要具备一定的前端技术基础,并且效率较低;而使用专业工具则可以更快速地实现*敏*感*词*的HTML代码压缩和加密。

在进行HTML代码压缩和加密时需要注意以下几点:避免破坏页面结构和布局;选择合适的压缩算法和加密方式;测试压缩后页面是否正常显示等。

由于HTML代码压缩和加密会增加服务器负载、降低加载速度等问题,因此需要在安全性与性能之间做出权衡,并根据实际需求选择最适合自己的方案。

优采云是一款专业的SEO优化工具,内置了多种功能模块,包括关键词排名监测、网站流量统计、竞争对手分析等功能。同时还支持对网站进行全面优化,包括页面结构调整、关键词布局优化、图片压缩等。使用优采云可以快速提升网站SEO效果,并且不需要过多地关注技术细节。

总之,在进行爬虫开发或者运营SEO优化时都需要考虑到网站安全问题,并且根据实际需求选择最适合自己的解决方案。