如何解决JavaURL抓取的页面数据未更新的问题?

优采云 发布时间: 2023-03-04 20:08在今天这个信息化时代,网络已经成为了人们获取信息的主要渠道之一。而在网络上,抓取数据是一项非常重要的任务。而 Java URL 抓取是其中一种比较常见的方式。但是,在实际应用中,我们可能会遇到这样一个问题:URL 抓取的页面数据没有更新。那么,该如何解决呢?本文将对此进行详细分析。

1. 什么是 Java URL 抓取?

Java URL 抓取是指利用 Java 语言中提供的类库和方法,从互联网上获取指定 URL 的资源内容,并将其转换为 Java 中的对象形式进行处理。这个过程通常包括以下步骤:建立连接、读取数据、解析数据等。

2. URL 抓取的页面数据没有更新的原因

当我们使用 Java URL 抓取工具去获取某个网页的内容时,可能会发现获取到的内容并不是最新的,或者说跟实际页面上显示的内容不一致。这种情况通常有以下几个原因:

(1) 缓存问题:浏览器或服务器对页面进行了缓存,导致我们获取到的是缓存中的旧数据。

(2) 编码问题:在获取网页时,可能会出现编码不一致导致乱码问题。

(3) 网络问题:网络故障也可能导致我们无法及时获取最新数据。

(4) 页面结构变化:如果页面结构发生了变化,我们所编写的程序可能无法正确地解析数据。

3. 如何解决 URL 抓取的页面数据没有更新问题?

针对以上原因,我们可以采取以下措施来解决:

(1) 清除缓存:在进行 URL 抓取之前,先清除浏览器或服务器中的缓存。

(2) 设置超时时间:在进行 URL 连接时,可以设置超时时间以防止网络故障影响数据获取。

(3) 使用 HTTP Client:HTTP Client 是一个开源框架,它提供了更加灵活、可定制化、稳定性更高等优点。使用 HTTP Client 可以有效地避免缓存、编码等问题。

(4) 使用第三方库:如果页面结构发生变化导致我们无法正确地解析数据,可以考虑使用第三方库来处理。例如 Jsoup 就是一个非常流行的 HTML 解析库。

4. 如何提高 URL 抓取效率?

URL 抓取效率直接影响着程序执行效率和用户体验。为了提高效率,我们可以采用以下方法:

(1) 多线程抓取:使用多线程技术可以同时抓取多个页面并行处理。

(2) 合理设置 User-Agent 和 Referer:合理设置 User-Agent 和 Referer 可以模拟浏览器行为,并避免被服务器屏蔽或限制访问。

(3) 数据压缩:对于大量数据传输时可以采用 GZIP 压缩算法等方式来减少传输时间和带宽消耗。

5. 如何进行 SEO 优化?

SEO(Search Engine Optimization)即搜索引擎优化,在网络营销中占据着非常重要的地位。如果您想让自己的网站排名靠前并获得更多流量和曝光度,则需要进行 SEO 优化。以下是一些简单易行又有效果的 SEO 优化技巧:

(1) 关键词优化:通过选择合适关键词并嵌入到网站内容中来提高搜索引擎排名。

(2) 内容质量优化:提供有价值、全面、准确且易于阅读和分享的内容能够吸引更多用户并提升搜索引擎排名。

(3) 外部链接建设:通过外部链接来增加网站曝光度和权威性,并提升搜索引擎排名。

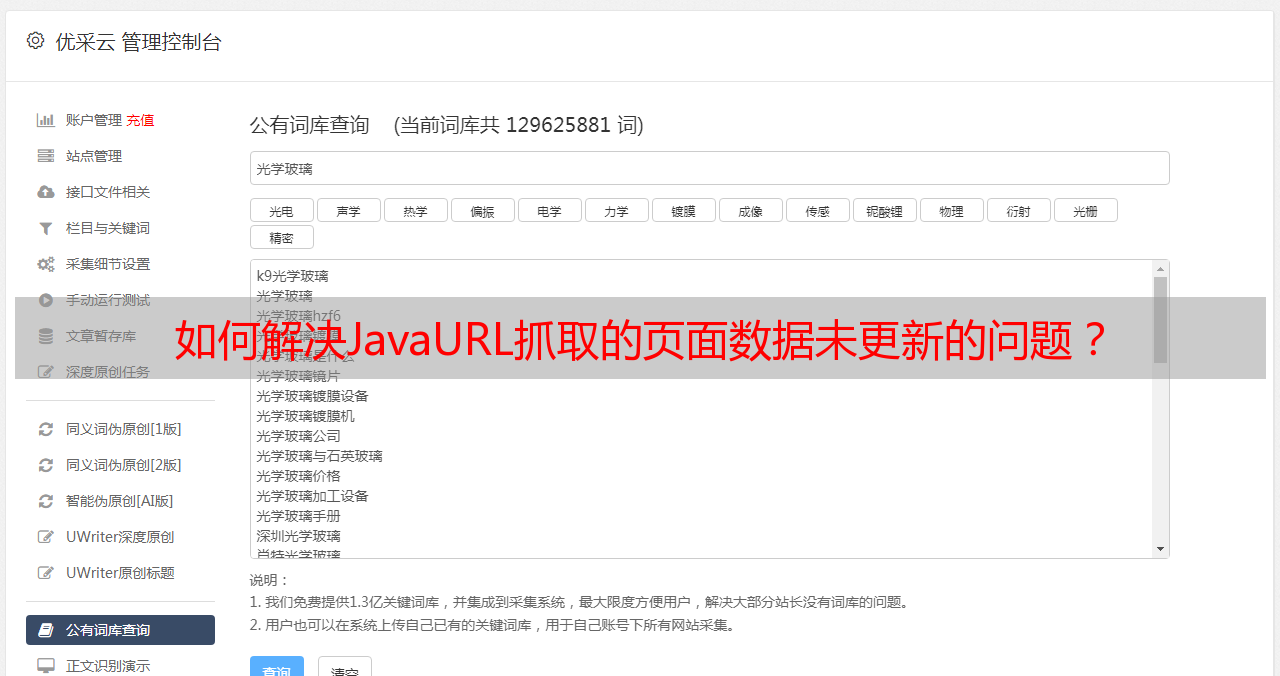

6. 优采云——您值得信赖的 SEO 服务商

作为国内领先的互联网营销服务商之一,优采云专注于为客户提供高质量、可持续性和创新性服务,并已经成功地帮助数百家企业实现了品牌知名度和销售业绩双丰收。作为 SEO 行业领先者之一,优采云拥有强大而专业团队和丰富经验,在关键词挖掘、竞争分析、网站定位等方面独具匠心,并能够根据客户需求提供定制化服务。如果您需要优秀、专业而又实惠的 SEO 服务,请联系优采云!

7. 总结

Java URL 抓取作为一种重要且广泛应用于网络爬虫中的技术手段,在实际应用中也存在着许多问题需要解决。本文从四个方面分析了 Java URL 抓取中可能遇到的问题及其解决方案,并介绍了如何通过 SEO 优化来提高企业网络曝光度和销售业绩。最后再次推荐您选择专业而可信赖的 SEO 服务商——优采云!