网页采集的10个详细技巧,让你轻松掌握相关知识!

优采云 发布时间: 2023-03-04 20:08随着社会信息化程度的不断提高,互联网成为人们获取信息的主要途径。而在这个信息爆炸的时代,如何高效地收集和分析网络数据已成为各行各业的必备技能。本文将从10个方面详细介绍网页采集的相关知识和技巧,帮助读者更好地进行数据挖掘和分析。

一、什么是网页采集?

在对网页采集进行深入了解之前,我们需要先明确什么是网页采集。简单来说,网页采集就是通过程序自动地抓取网络上的数据,并进行处理和分析的过程。这其中涉及到多个领域的知识,包括编程、网络技术、数据处理等。

二、为什么需要进行网页采集?

在*敏*感*词*融行业中,通过抓取股票行情信息来进行趋势分析和投资决策也是一种常见的应用场景。

三、网页采集的分类

根据不同的需求和目标,我们可以将网页采集分为两类:结构化采集和非结构化采集。结构化采集指的是对具有固定格式和规则的数据进行抓取和处理,例如表格、列表等;非结构化采集则指对没有固定格式和规则的数据进行抓取和处理,例如新闻文章、博客等。

四、网页采集工具

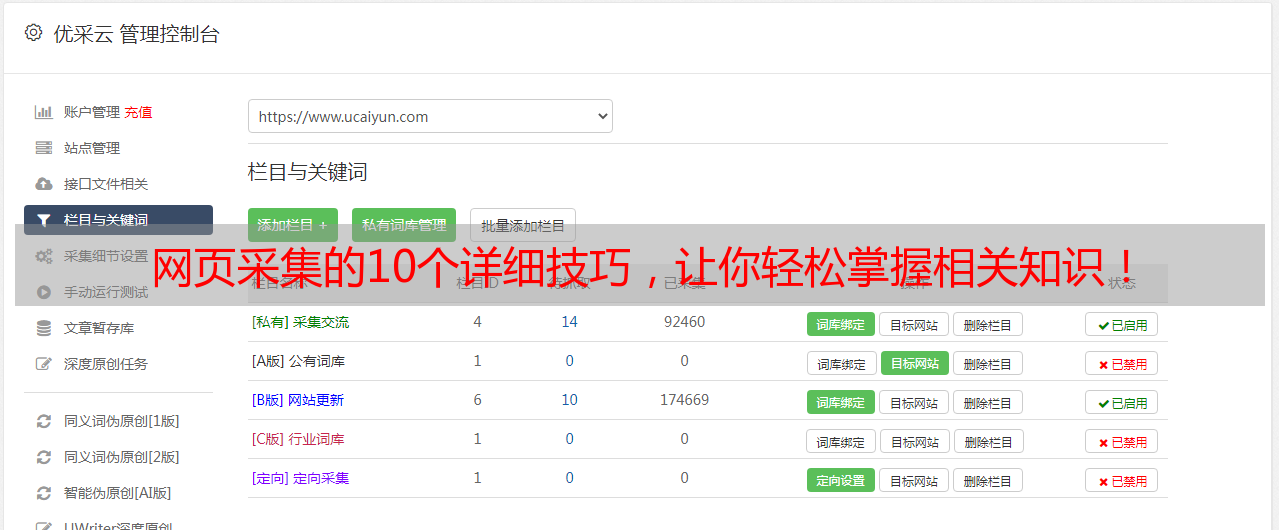

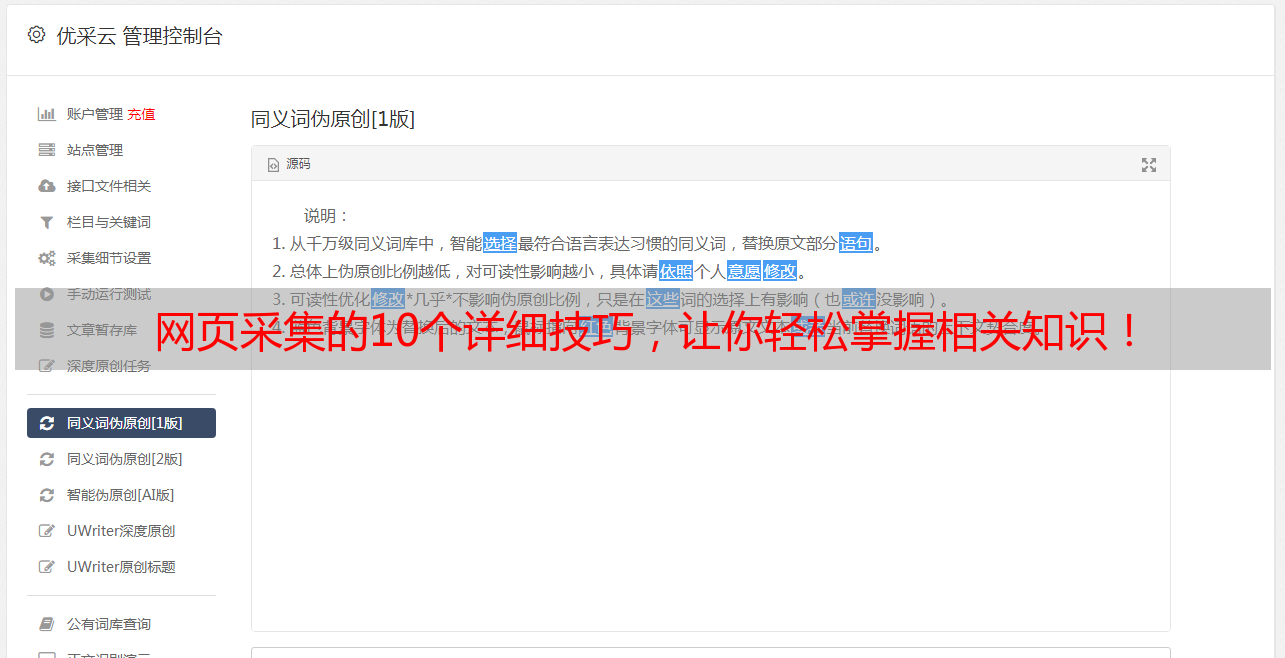

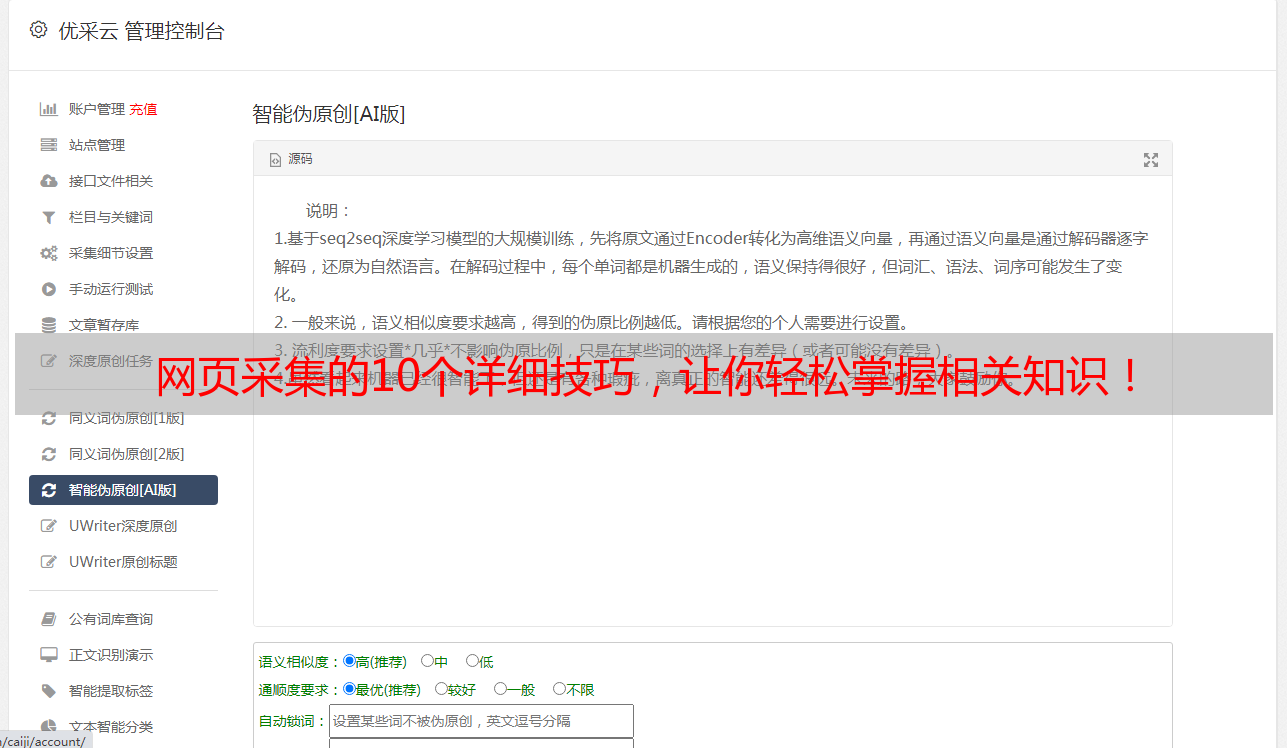

在进行网页采集时,我们需要使用相应的工具来帮助我们完成任务。目前市面上有很多优秀的网页采集工具可供选择,例如Python中常用的BeautifulSoup库、Scrapy框架等。此外,还有许多在线工具可供使用,如优采云(www.ucaiyun.com)等。

五、网页采集流程

一个完整的网页采集过程通常包含以下几个步骤:确定目标页面 -> 分析页面结构 -> 编写代码 -> 运行程序 -> 处理结果 -> 存储数据。其中最关键的步骤是分析页面结构和编写代码。

六、反爬虫机制

由于一些恶意爬虫对于服务器造成了压力甚至破坏,因此许多站点都设置了反爬虫机制。这些机制包括IP限制、验证码验证、User-Agent识别等。针对这些机制我们可以通过IP代理池、验证码识别库以及User-Agent池等方式来应对。

七、数据清洗

在完成数据抓取后,我们还需要对其进行清洗以满足后续分析需求。这里所说的清洗包括去除噪声数据、填充缺失值以及统一格式等操作。通过清洗后我们可以得到更加干净规整的数据。

八、数据存储

在完成数据清洗后,我们需要将其存储到相应数据库或文件中。目前常见的存储方式包括MySQL数据库、MongoDB数据库以及CSV文件等。

九、SEO优化

对于企业而言,在做好产品服务本身之外,还需要考虑如何提高品牌曝光度和用户粘性。这就需要借助SEO(搜索引擎优化)来实现了。SEO优化包括站内优化(标题关键词设置、内容质量提升等)和站外优化(外链建设、社交媒体推广等)两个方面。

十、未来展望

随着人工智能技术不断发展壮大,在未来更多领域中将涌现出更加智能化高效率地软件系统,并且也会有越来越多人投身于此领域并且创造出更多有价值创新性质项目。