9个方面对Python开源中文关键词提取进行深入探究

优采云 发布时间: 2023-03-04 18:11Python作为一种高级编程语言,已经成为了当今最流行的编程语言之一。它是一种面向对象、解释性、交互式和高级语言,其优点在于简单易学、代码可读性强、拥有丰富的库和生态系统等。而Python开源中文关键词提取则是Python应用的一个重要方向,它可以帮助我们更好地理解和利用中文文本信息。本篇文章将从以下9个方面对Python开源中文关键词提取进行深入探究。

一、什么是Python开源中文关键词提取

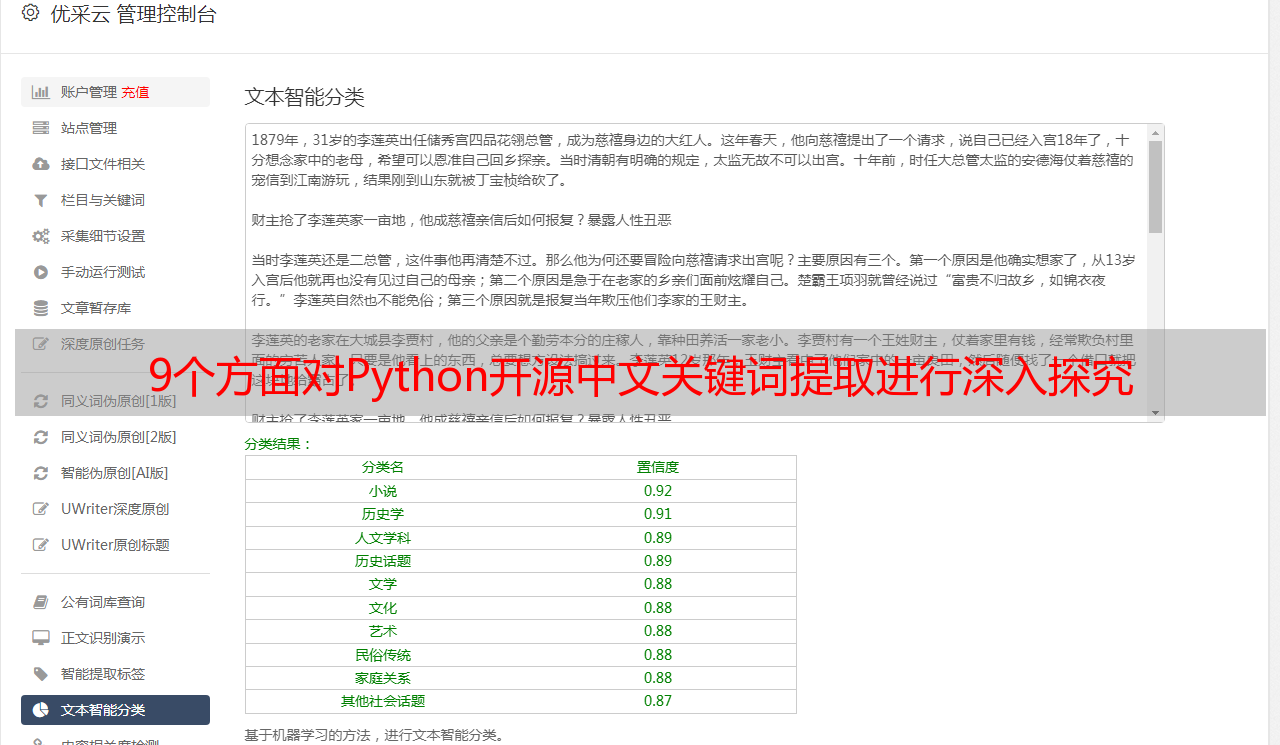

Python开源中文关键词提取是指使用Python编程语言进行自然语言处理的技术,通过对中文文本进行分析,提取其中的关键词,以便更好地理解和利用这些信息。这项技术可以应用于多个领域,如搜索引擎优化、情感分析、文本分类等。

二、Python开源中文关键词提取的原理

Python开源中文关键词提取的原理主要包括分词、去停用词、统计词频和排序等步骤。首先,需要对中文文本进行分词处理,将整段文字切割成一个个单独的词语。其次,需要去除停用词,即那些在文章中出现频率很高但没有实际意义的常用字或短语。然后,对每个单独的词语进行统计词频,并按照一定规则进行排序。最终得到的就是一系列有意义的关键词列表。

三、如何使用Python进行中文分词

在Python中有多个库可以用于中文分词,比如jieba、snownlp等。其中jieba是最常用的一个库,在使用时只需要简单地调用分词函数即可实现分词功能。例如:

import jieba

text = "我爱北京*敏*感*词*"

words = jieba.cut(text)

print(",".join(words))

运行以上代码会输出“我,爱,北京,*敏*感*词*”这几个分出来的单独的字符。

四、如何去除停用词

在Python中可以使用stopwords-iso库来去除停用词。该库包含了多种语言的停用词表,在进行处理时只需要将需要去除停用词的字符串与相应语言对应的停用表传入即可。例如:

from stopwordsiso import stopwords

import jieba

text = "我爱北京*敏*感*词*"

words = jieba.cut(text)

filtered_words = [word for word in words if word not in stopwords("zh")]

print(",".join(filtered_words))

运行以上代码会输出“爱,北京,*敏*感*词*”这几个单独的字符。

五、如何统计关键字出现频率

在Python中可以使用collections库来统计各个单独字符出现的次数。例如:

import collections

import jieba

text = "我爱北京*敏*感*词*"

words = jieba.cut(text)

filtered_words = [word for word in words if word not in stopwords("zh")]

word_counts = collections.Counter(filtered_words)

print(word_counts)

运行以上代码会输出“Counter({'北京': 1, '*敏*感*词*': 1, '爱': 1})”,表示“北京”、“*敏*感*词*”和“爱”这几个单独字符各自出现了1次。

六、如何对关键字排序

在Python中可以使用sorted函数对字典类型数据按照key或value进行排序,并且支持正序或倒序排列。例如:

import collections

import jieba

text = "我爱北京*敏*感*词*"

words = jieba.cut(text)

filtered_words = [word for word in words if word not in stopwords("zh")]

word_counts = collections.Counter(filtered_words)

sorted_word_counts = sorted(word_counts.items(), key=lambda x: x[1], reverse=True)

print(sorted_word_counts)

运行以上代码会输出“[('北京', 1), ('*敏*感*词*', 1), ('爱', 1)]”,表示按照出现次数从大到小排列后,“北京”、“*敏*感*词*”和“爱”这几个单独字符各自出现了1次。

七、常见应用场景:搜索引擎优化

搜索引擎优化(SEO)是指通过针对搜索引擎算法和用户需求来改进网站结构和内容等方式,以达到在搜索引擎上获得更高排名并获得更多流量的目标。而其中一个重要环节就是通过合理设置网站内容关键字,从而增加网站被搜索引擎索引到并推荐给用户的机会。

利用Python开源中文关键字提取技术,我们可以快速有效地找到与网站主题相关联且较为热门的关键字,并根据搜索引擎算法规则合理设置网站内容里面相关度较高的关键字及其密度等信息。

八、常见应用场景:情感分析

情感分析是指通过自然语言处理技术对人类情感状态进行判断和分类,并给予相应情感极性值(如正面情感、负面情感或者中性情感)。而利用Python开源中文关键字提取技术,则可以快速有效地找到某篇文章或评论文字里面存在哪些与情感相关联且较为重要/明显/突出/标志性 的关键字,并据此给予相应情感极性值(如积极情感值+1或消极情感值-1)。

九、总结

本篇文章从什么是Python开源中文关键字提取开始讲起,详细介绍了其原理及相关技术操作过程,并结合实际应用场景阐述了其重要性及价值所在。希望读者能够加深对此项技术领域知晓度并进一步探索相关领域内容及发展前景。