揭秘爬虫网站内核的黑科技,让你了解如何快速获取网络数据!

优采云 发布时间: 2023-03-04 17:11搜索引擎已经成为人们获取信息的重要途径,而这背后的技术就是爬虫网站内核。爬虫网站内核是一种自动化程序,它能够在互联网上抓取、分析和存储大量的网页内容,以便搜索引擎进行索引和检索。本文将从以下九个方面为您揭秘爬虫网站内核的黑科技。

一、网络爬虫的基础

网络爬虫是一种程序,可以自动地遍历互联网上的各个页面,并将这些页面上的信息抓取下来。网络爬虫是搜索引擎的基础,通过网络爬虫可以获取到大量的数据并进行分析。

二、URL管理

URL管理是爬虫网站内核中非常重要的一部分。URL管理器可以帮助程序员对需要抓取的URL进行管理和过滤,避免出现重复抓取和无效链接。

三、网页解析

网页解析是指对抓取下来的HTML文档进行分析和处理,以便提取出其中有用的信息。常见的网页解析方法有正则表达式、XPath、CSS Selector等。

四、反爬机制

由于网络爬虫可能会给服务器带来很大压力,很多网站都会采取反爬机制来防止被爬虫访问。例如,设置验证码、IP封禁等方式都可以有效地防止网络爬虫。

五、并发处理

并发处理是指同时处理多个请求或任务。在网络爬虫中,并发处理可以有效地提高数据抓取和处理速度,减少资源浪费。

六、数据存储

数据存储是指将抓取下来的数据进行存储和管理。常见的数据存储方式有MySQL、MongoDB等数据库,也可以使用NoSQL数据库或者文件系统进行存储。

七、分布式架构

随着数据量不断增加,单机架构已经无法满足需求。分布式架构可以将任务分配到多台机器上进行并行处理,提高效率和可靠性。

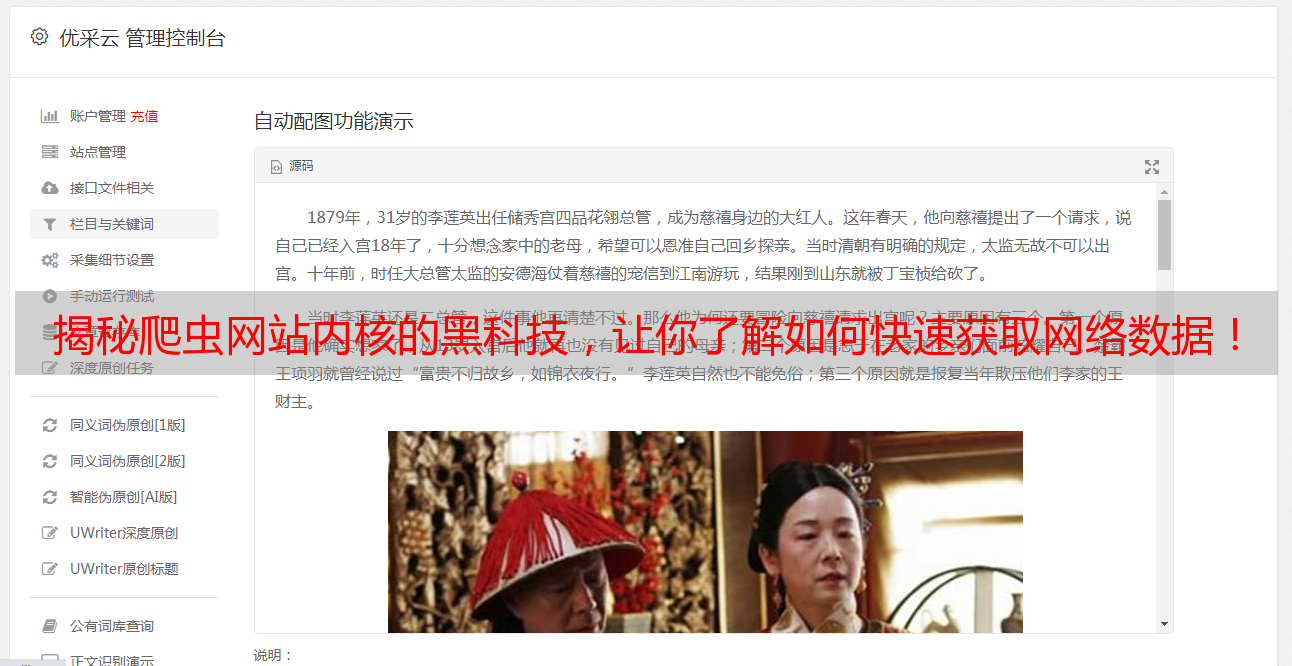

八、自然语言处理

自然语言处理是指利用计算机技术对人类语言进行分析和理解。在搜索引擎中,自然语言处理可以帮助用户更好地理解查询意图,并提供相关结果。

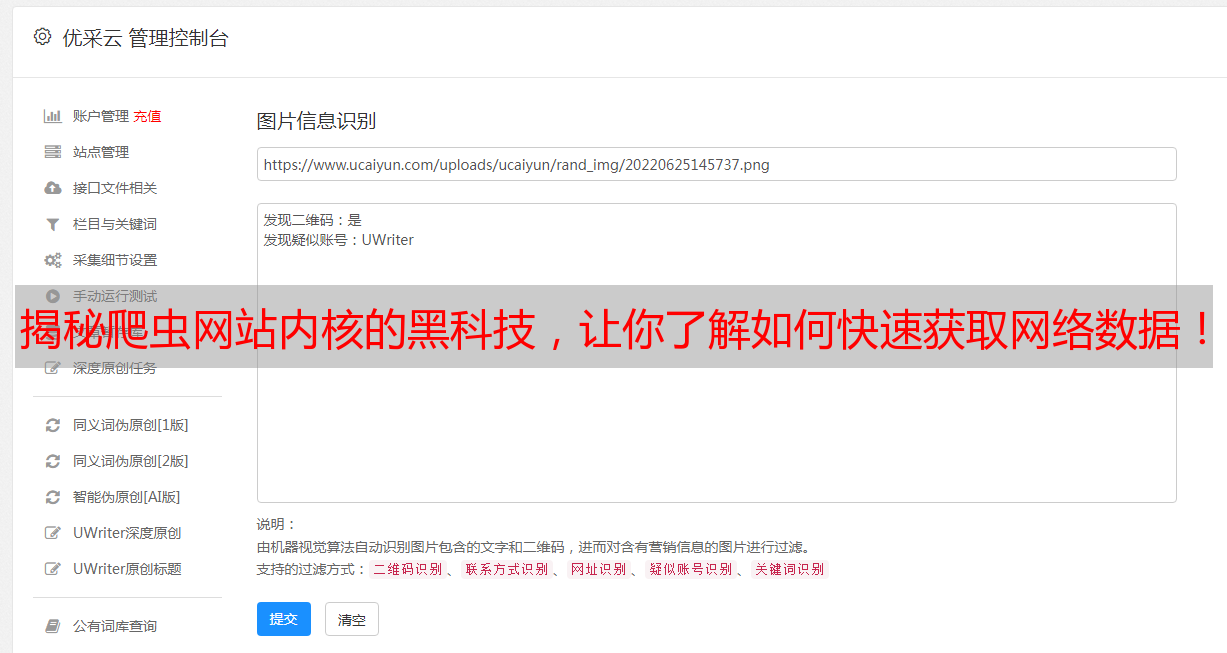

九、深度学习应用

深度学习是人工智能领域中最热门的技术之一。在搜索引擎中,深度学习可以帮助识别图片和视频内容,并提供更加精准的结果。

总之,爬虫网站内核是现代搜索引擎不可或缺的一部分。了解其背后的黑科技不仅可以让我们更好地理解搜索引擎工作原理,还可以为我们日常生活中快速获取信息提供更好的支持。