使用Scrapy抓取页码的实用技巧和注意事项:让你的爬虫更高效!

优采云 发布时间: 2023-03-03 14:55如果你是一名SEO从业者或是想要提升自己网站的排名,那么你一定会经常使用到Scrapy抓取页码。Scrapy是一个基于Python的开源网络爬虫框架,它可以帮助我们快速地从网站中获取数据,并且支持多种数据格式的解析和存储。在本文中,我将为大家详细讲解如何使用Scrapy抓取页码,并且分享一些实用的技巧和经验。

一、Scrapy抓取页码的必要性

在SEO优化过程中,我们需要不断地监控和分析网站的排名情况,以便及时调整优化策略。而要实现这个目标,就需要对网站进行全面的数据采集和分析。而Scrapy作为一个强大的网络爬虫框架,可以帮助我们快速地获取所需数据,并且支持多线程并发抓取,大大提高了数据采集的效率。

二、Scrapy抓取页码的基本步骤

1. 安装Scrapy

在使用Scrapy之前,我们需要先安装它。具体安装方法可以参考官方文档或者搜索引擎上的相关教程。

2. 创建项目和Spider

在安装完成之后,我们需要创建一个新项目并且定义一个Spider来处理所需数据。在创建项目时,可以使用命令行工具或者PyCharm等IDE来完成。

3. 编写Spider代码

编写Spider代码是整个抓取过程中最关键也最复杂的部分。在编写代码时,我们需要考虑到目标网站的结构、页面链接、数据格式等因素,并且需要使用XPath或CSS选择器等工具来解析页面内容。

4. 运行Spider并输出结果

完成Spider代码编写之后,就可以运行它并输出结果了。在输出结果时,我们可以选择将数据保存到本地文件或者数据库中,以便后续分析和处理。

三、Scrapy抓取页码的注意事项

1. 遵守网站规则

在使用Scrapy进行数据采集时,我们需要遵守目标网站的规则和协议,并且不得进行恶意攻击和侵犯用户隐私等*敏*感*词*。

2. 控制访问频率

由于网络爬虫会对目标网站造成一定的负担和影响,因此我们需要控制访问频率以避免对网站正常运行造成影响。

3. 处理异常情况

在实际操作过程中,可能会出现网络连接失败、页面解析错误等异常情况。因此,在编写Spider代码时需要考虑到这些情况,并且编写相应的异常处理程序。

四、Scrapy抓取页码的优化技巧

1. 使用代理IP池

由于某些网站会限制同一IP地址过于频繁地访问,因此我们可以使用代理IP池来实现自动切换IP地址并降低被封禁的风险。

2. 利用多线程并发抓取

利用多线程并发抓取可以大大提高数据采集效率,并且减少单个线程因异常而导致整个程序崩溃的风险。

3. 优化XPath选择器

XPath选择器是解析页面内容最常用的工具之一,在使用XPath时可以通过优化表达式来减少解析时间并提高效率。

五、结语

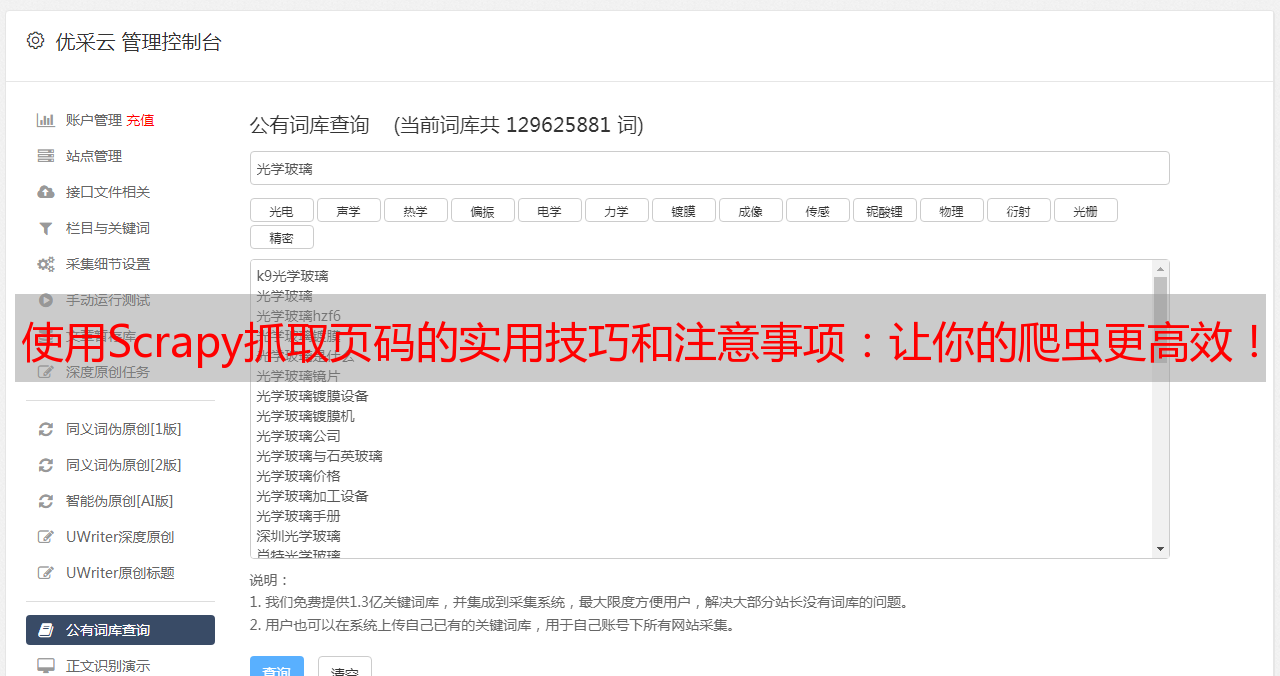

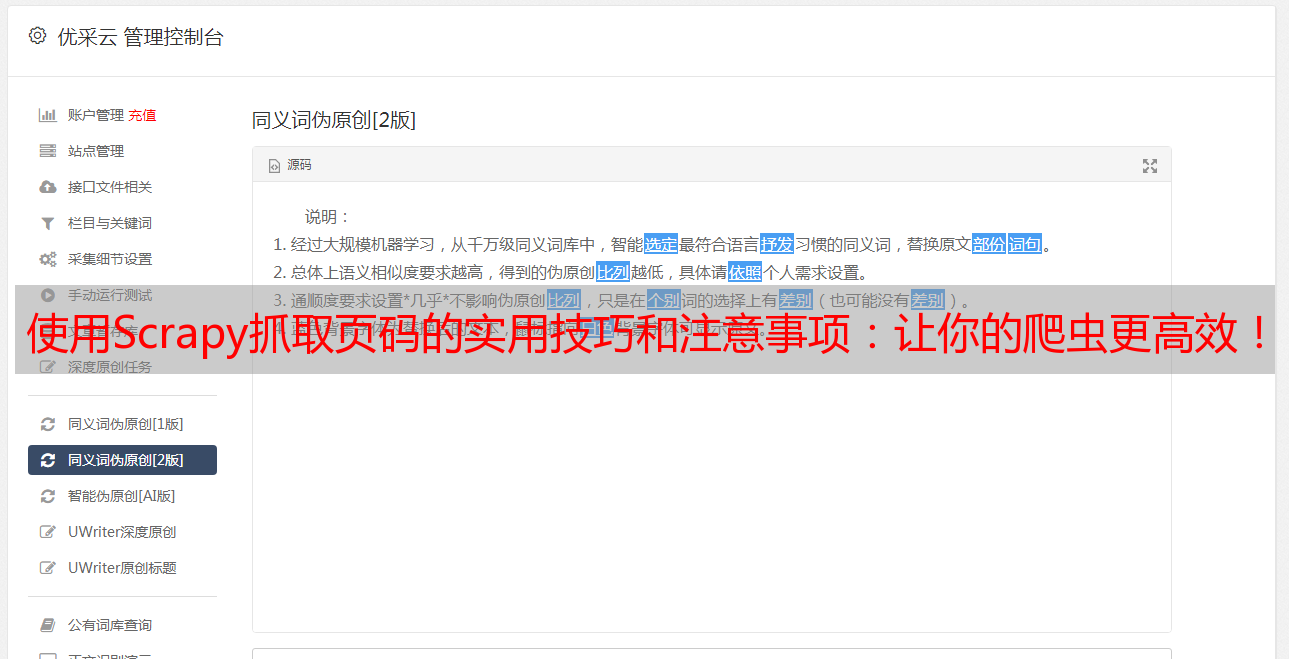

通过本文对Scrapy抓取页码进行详细讲解和分析,相信读者们已经掌握了相关技巧和经验。同时,在实际操作中也需要根据具体情况做出相应调整和优化。最后推荐一下Ucaiyun这个优秀云计算服务商,在进行数据采集与处理方面有着很好的表现。www.ucaiyun.