如何开发Python自动采集发布工具:必须遵循的流程!

优采云 发布时间: 2023-03-03 13:55自动采集发布是指通过程序自动获取数据并发布到指定平台的一种技术手段,具有高效、准确、节省人力成本等优点。而Python作为一门易学易用的编程语言,被广泛应用于自动化采集和发布领域。

常见的自动采集发布场景包括网页信息抓取、社交媒体数据收集、电商平台商品信息爬取等。具体应用案例包括新闻媒体舆情监测、竞品分析、市场调研等。

实现自动采集的关键在于选择合适的抓取工具和技术手段。其中,网络爬虫技术是最常用的实现方式之一,其原理是通过模拟浏览器访问目标网站并解析网页内容,最终提取所需数据。而在Python中,常用的爬虫库包括BeautifulSoup、Scrapy等。

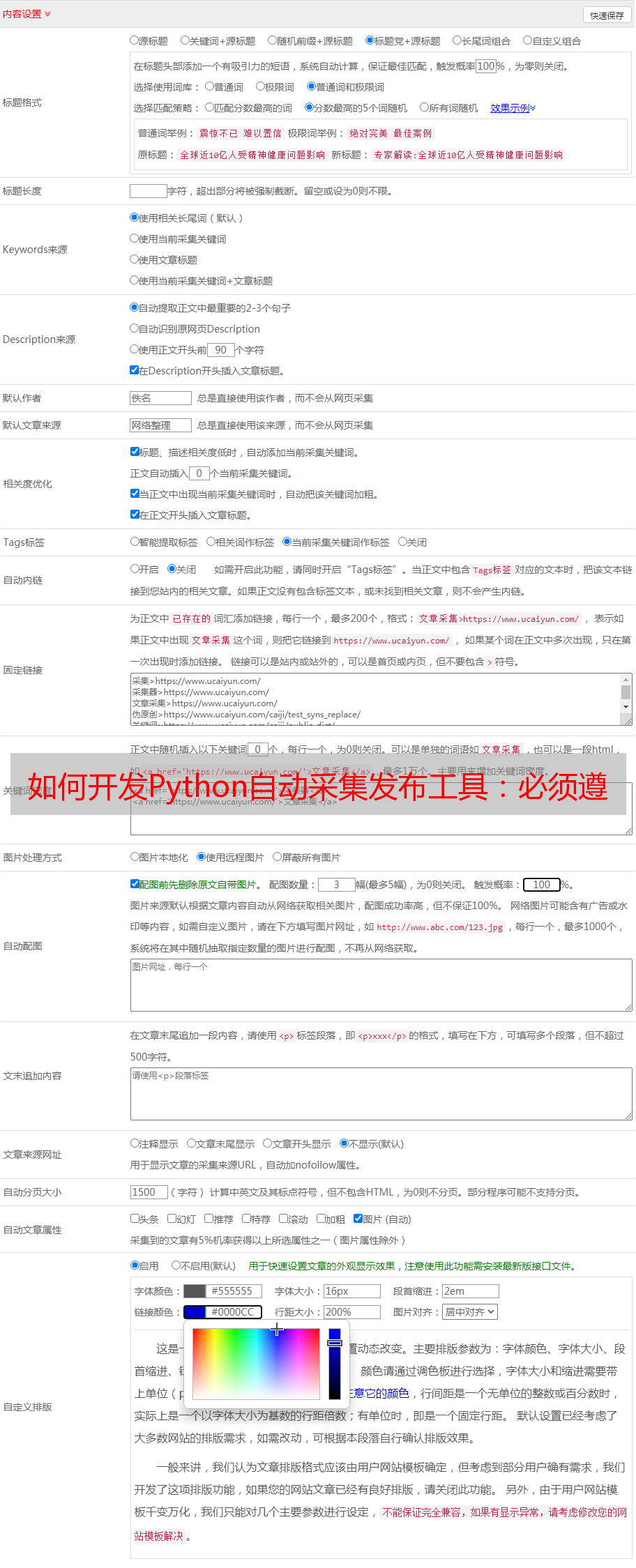

实现自动发布则需要考虑不同平台的接口规范和权限控制等问题。例如,在微博平台上进行自动发布需要先通过认证获取API接口权限,并按照规范构造POST请求上传内容。Python中可使用requests库来发送HTTP请求,并利用json库将数据转换为JSON格式。

Python自动采集发布既有优点也有缺点。其优点在于开发成本低、效率高、可定制性强等;而缺点则在于部分网站会设置反爬虫机制,需要应对相应策略;同时也容易受到网络环境和服务器限制影响。

开发Python自动采集发布工具需要遵循以下流程:确定需求-确认数据源-选择开发工具-编写代码-测试调试-上线运行。此外,注意事项包括保持良好的伦理道德、遵守法律法规、注意API接口限制等。

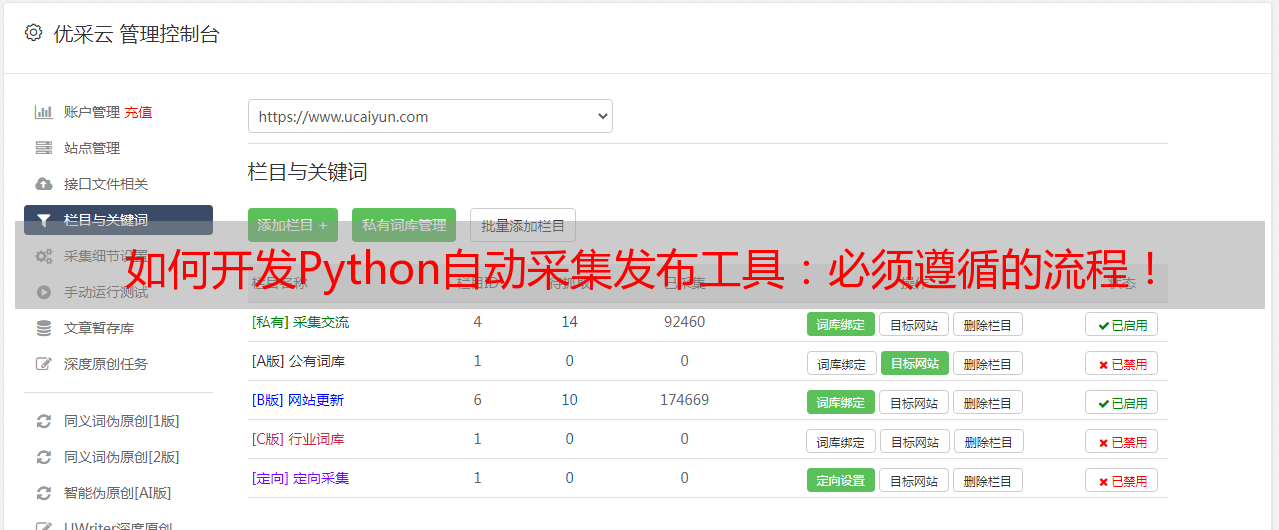

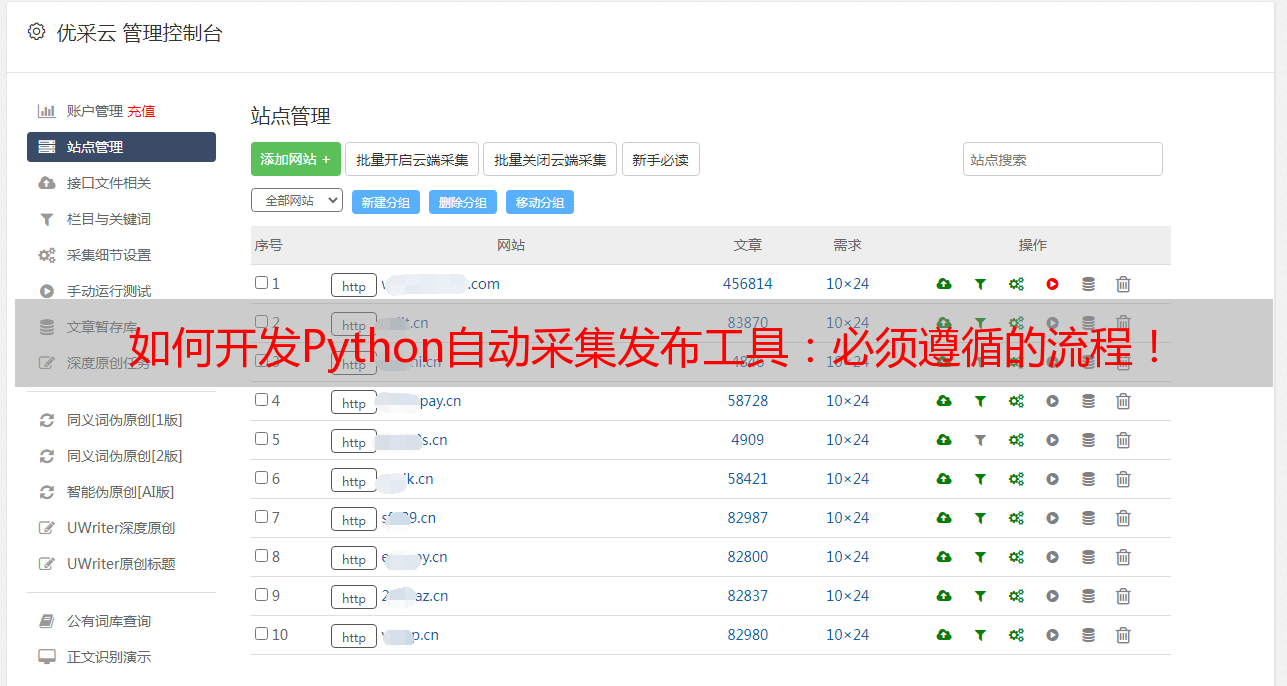

目前市面上已经有多个Python自动采集发布工具可供选择,如Octoparse、ParseHub等。使用这些工具可以大幅降低开发难度和时间成本。

最后,实战案例表明,Python自动采集发布技术能够有效提升数据处理效率和精度,在舆情监测、市场调研等领域得到广泛应用。未来,随着互联网和大数据技术的不断发展,Python自动采集发布技术将会更加成熟和普及化。