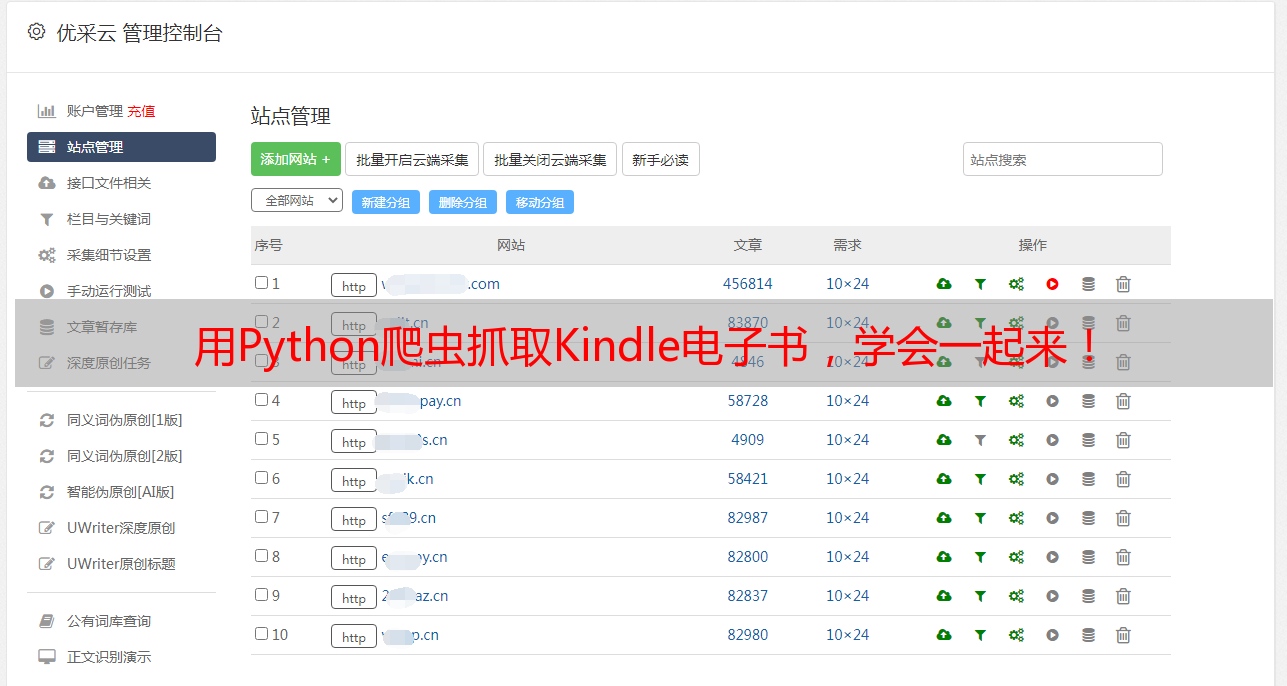

用Python爬虫抓取Kindle电子书,学会一起来!

优采云 发布时间: 2023-03-02 05:27

你是否曾经因为Kindle书太贵而放弃购买?是否曾经因为想要读的书在Kindle商店找不到而苦恼?如果是,那么本文将为你解决这些问题!

Kindle电子书是我们日常生活中常用的一种阅读方式,但是在Kindle商店中购买电子书往往会因为价格昂贵而让人望而却步,甚至有些书在商店中根本就找不到。不过,我们可以使用爬虫技术,在互联网上获取电子书资源,以极低的价格或者免费的方式获得自己想要的电子书。

下面,就让我们*敏*感*词*地学习如何使用Python爬虫爬取Kindle电子书吧!

第一步:准备工作

在学习如何爬取Kindle电子书之前,我们需要准备好以下几个工具:

1. Python编程语言:本文中我们将使用Python编写爬虫程序;

2. 开发工具:为了方便编写程序,我们可以选择安装一些常用的Python开发工具,例如PyCharm、VS Code等;

3. 爬虫框架:我们可以使用一些已有的Python爬虫框架,例如Scrapy、BeautifulSoup等;

4. 网络请求工具:为了获取网页数据,我们需要使用网络请求工具,例如Requests、Selenium等;

5. 存储工具:为了存储爬取到的数据,我们需要使用一些存储工具,例如MySQL、MongoDB等。

当准备好以上工具后,我们就可以开始学习如何爬取Kindle电子书了!

第二步:分析网页结构

在开始爬取之前,我们需要先分析Kindle商店的网页结构。我们可以使用Chrome浏览器的开发者工具对网页进行分析。打开Chrome浏览器,进入Kindle商店,打开开发者工具(快捷键F12),在Elements标签中查看网页的DOM结构和CSS样式,可以找到我们需要的信息的位置和特征,例如书名、作者、价格等。

第三步:编写爬虫程序

在了解网页结构后,我们可以编写爬虫程序来获取我们需要的信息。这里我们以Scrapy框架为例,先定义爬虫的起始URL和规则,再定义网页解析函数,最后将爬取到的数据存储到MySQL数据库中。

具体的程序实现细节可以参考以下代码:

import scrapy

from scrapy import Selector

from scrapy.spiders import CrawlSpider, Rule

from scrapy.linkextractorsclass KindleSpider(CrawlSpider):

name = "kindle"

allowed_domains = ["www.amazon.com"]

start_urls = ["https://www.amazon.com/s?k=kindle+ebooks&i=digital-text&ref=nb_sb_noss_2"]

rules = (

Rule(LinkExtractor(allow=("/s\?k=kindle\+ebooks&i=digital-text&page=\d+",))),

Rule(LinkExtractor(allow=("/dp/.*",)), callback="parse_book"),

)

def parse_book(self, response):

sel = Selector(response)

title = sel.css("#productTitle::text").get().strip()

author = sel.css(".author a::text").get().strip()

price = sel.css(".a-price-whole::text").get()

rating = sel.css(".a-star-4-5 span::text").get()

yield {

"title": title,

"author": author,

"price": price,

"rating": rating,

}

我们先定义了爬虫的名称为“kindle”,然后设置了起始URL为Kindle商店的网址。然后我们定义了两个规则,第一个规则用于爬取每一页的URL,第二个规则用于爬取每一本书的URL,并将其回调到parse_book函数中进行解析。在parse_book函数中,我们使用了Selector工具来解析网页内容,找到了书名、作者、价格和评分等信息,并将这些信息存储到字典中,最后通过yield关键字返回这个字典,让Scrapy框架将其存储到MySQL数据库中。

第四步:运行爬虫程序

在编写完爬虫程序后,我们就可以使用Scrapy框架来运行它了。在终端中输入以下命令即可启动爬虫程序:

scrapy crawl kindle

爬虫程序会自动爬取Kindle商店中的电子书信息,并将其存储到MySQL数据库中。

最后,提醒大家,在使用爬虫技术爬取数据时,一定要遵守法律法规,不要进行侵犯他人利益的行为。同时,我们也要注意保护自己的网络安全,不要在非法网站上下载电子书,以免感染病毒或泄露个人信息。

优采云提供SEO优化服务,是一家专注于为企业提供全网营销解决方案的公司,欢迎访问我们的官网www.ucaiyun.com了解更多信息。