解决方案:什么是TAG标签,怎样优化TAG标签页面?

优采云 发布时间: 2022-12-24 23:11解决方案:什么是TAG标签,怎样优化TAG标签页面?

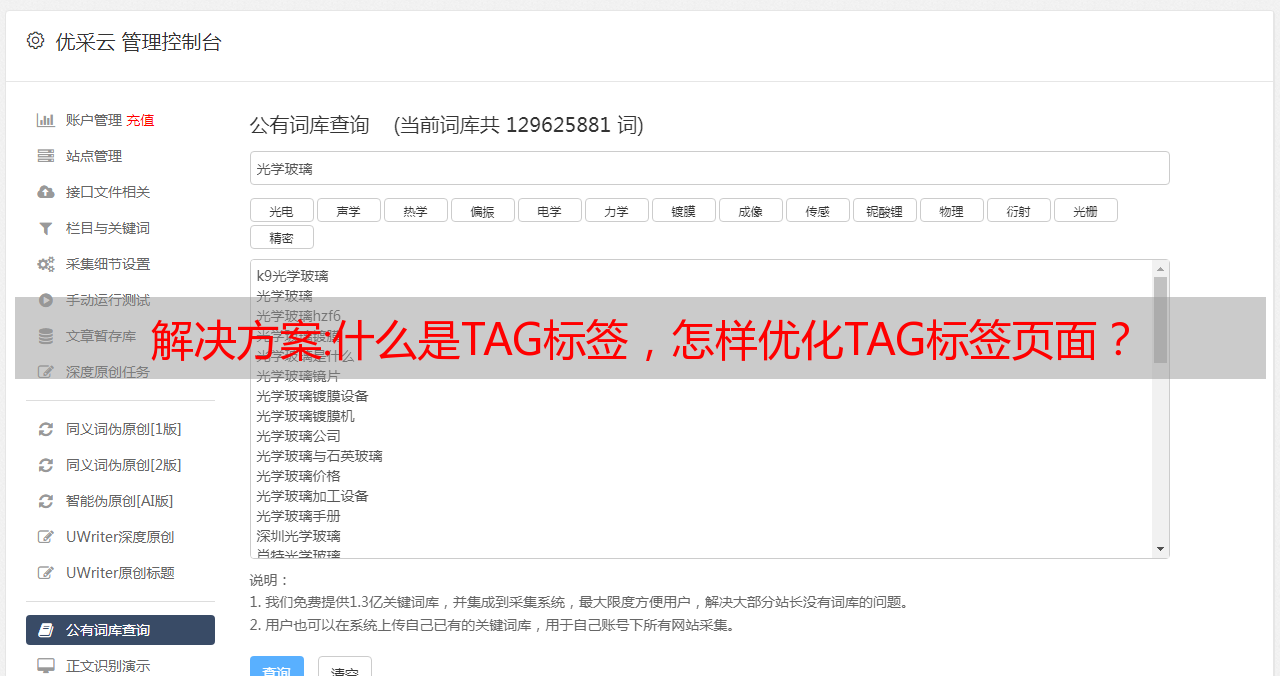

TAG标签是站长自己定义的关键词,比分类更准确、更具体,可以概括文章的主要内容。 一般站长会根据文章的内容给文章添加标签。 TAG标签相当于聚合页面的桥梁,聚合了站点中的相关内容,从而增加页面的相关性,提升用户的浏览体验。

TAG标签在早期是SEO排名的重要手段之一,但由于采集内容溢出产生无效聚合页面,导致大量关键词被搜索引擎算法惩罚。 TAG标签用得好,搜索引擎会给它一定的权重和排名; 用不好会碰百度金风算法。

一、TAG标签的主要作用

① 满足用户体验;

②提高页面pv,降低网站跳出率;

③完善网站内容收录;

④ 提高关键词排名;

⑤增加网站内部链接,有利于页面权重的相互传递。

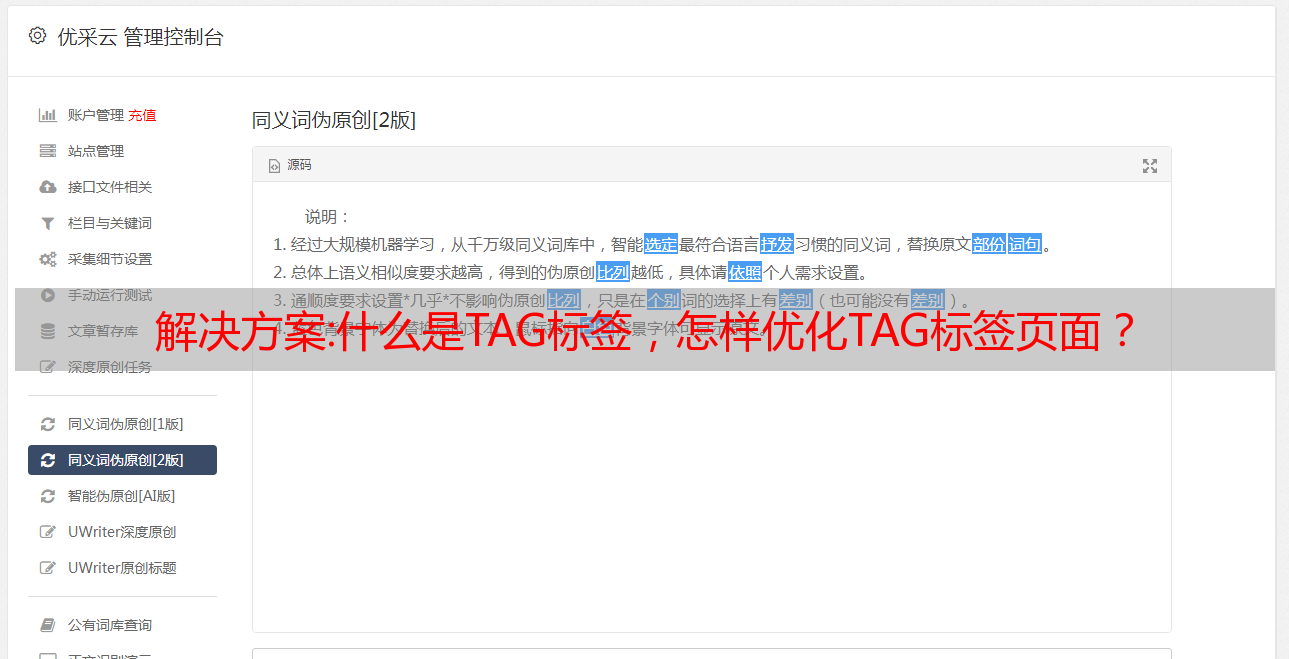

2、TAG标签页优化要点

TAG网站是关键词的内容聚合页面,所以与关键词的关联度通常很高,所以TAG页面的排名和权重都会交给搜索引擎; 一定的排名。

①SEO在写Tags的时候,应该按照分类的角度来写。 多个标签应以空格或逗号分隔。 建议 Tag 数量小于 5 个。

②tag标签要避开热门关键词。 建议在标题周围定义一些长尾关键词来优化tag标签。

③Tag标签是针对用户的,所以Tag标签要保证与信息内容的相关性。

④ 确保每个标签列表下有5文章,以吸引搜索引擎的注意。

⑤不要轻易修改Tag标签。 每次修改都得等搜索收录重新索引,重新赋予权重。

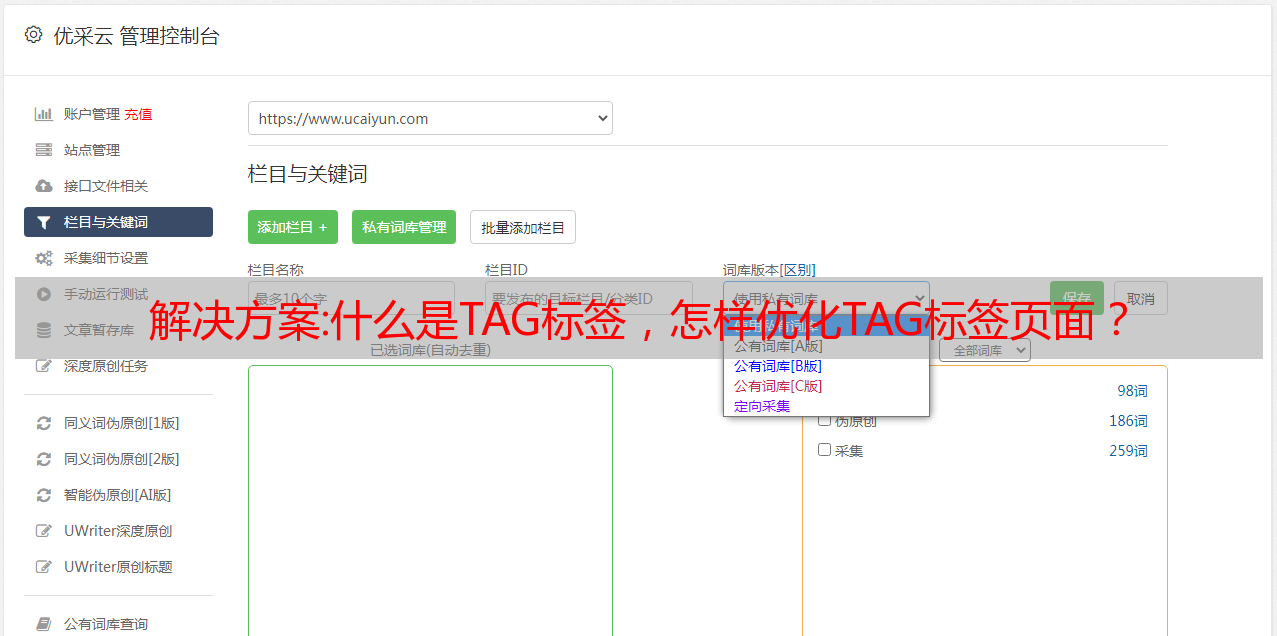

3. TAG标签与强风算法

TAG标签页引入强风算法,使TAG页更加正规。 避免被强风算法打击,注意TAG页面的文章调用次数不要太少,也不要与TAG标签的主题不符,这样会导致算法的攻击。

TAGS标签:

解决方案:基于scrapy实现的简单蜘蛛采集程序(scrapy爬虫实例)

本文介绍一个简单的基于scrapy的蜘蛛采集程序。 分享给大家,供大家参考。 详情如下:

# Standard Python library imports#第三方从 scrapy 导入。 贡献。 蜘蛛从 scrapy 中导入 CrawlSpider、Rule。 贡献。 链接提取器。 sgml 从 scrapy 导入 SgmlLinkExtractor。 选择器导入 HtmlXPathSelector# 我从诗歌分析中导入。 项目导入 PoetryAnalysisItemHTML_FILE_NAME = r'。 +\。 html'class PoetryParser(object): """ 为这种特定格式的诗歌提供通用的解析方法。""" date_pattern = r'(\d{2} \w{3,9} \d{4})' def parse_poem(self, response):hxs = HtmlXPathSelector(response)item = PoetryAnalysisItem()# 所有诗歌文本都在pre tagstext = hxs.

选择('//前/文本()')。 提取物()项目['文本'] =''。 加入(文本)项目['url'] =响应。 url# head/title 收录标题 - authortitle_text = hxs 的一首诗。 选择('//头/标题/文本()')。 提取物()[0] 项目['标题'],项目['作者'] = title_text。 split(' - ') item['author'] = item['author']. replace('a poem by', '') for key in ['title', 'author']: item[key] = item[key]. strip() item['date'] = hxs. select("//p[@class='small']/text()"). re(date_pattern) return itemclass PoetrySpider(CrawlSpider, PoetryParser): name = '例子。

com_poetry' allowed_domains = ['www. 例子。 com'] root_path = 'someuser/poetry/' start_urls = ['. 例子。 com/someuser/poetry/recent/','. 例子。 com/someuser/poetry/less_recent/'] 规则 = [Rule(SgmlLinkExtractor(allow=[start_urls[0] + HTML_FILE_NAME]),callback='parse_poem'),Rule(SgmlLinkExtractor(allow=[start_urls[1] + HTML_FILE_NAME] ), callback='parse_poem')]

希望本文对大家的Python编程有所帮助。