总结:【第3916期】0基础搭建一个属于你自己的SEO伪原创工具:适合自媒体人或站长(

优采云 发布时间: 2022-12-24 16:15总结:【第3916期】0基础搭建一个属于你自己的SEO伪原创工具:适合自媒体人或站长(

一、课程介绍

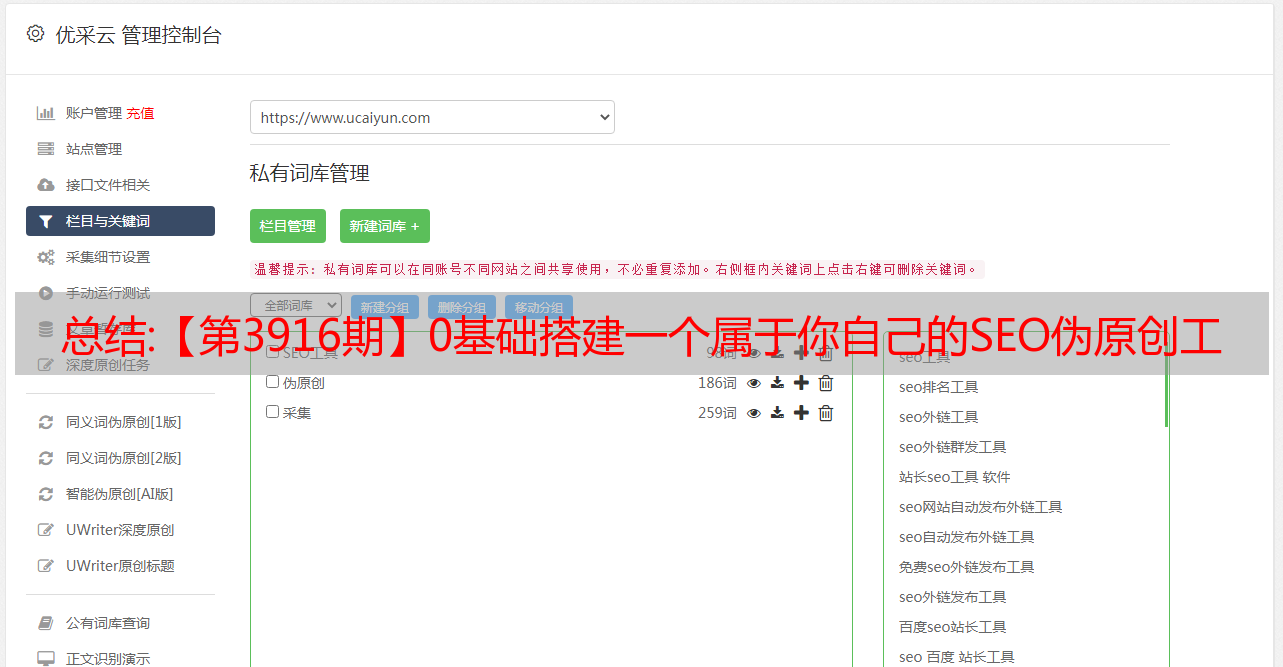

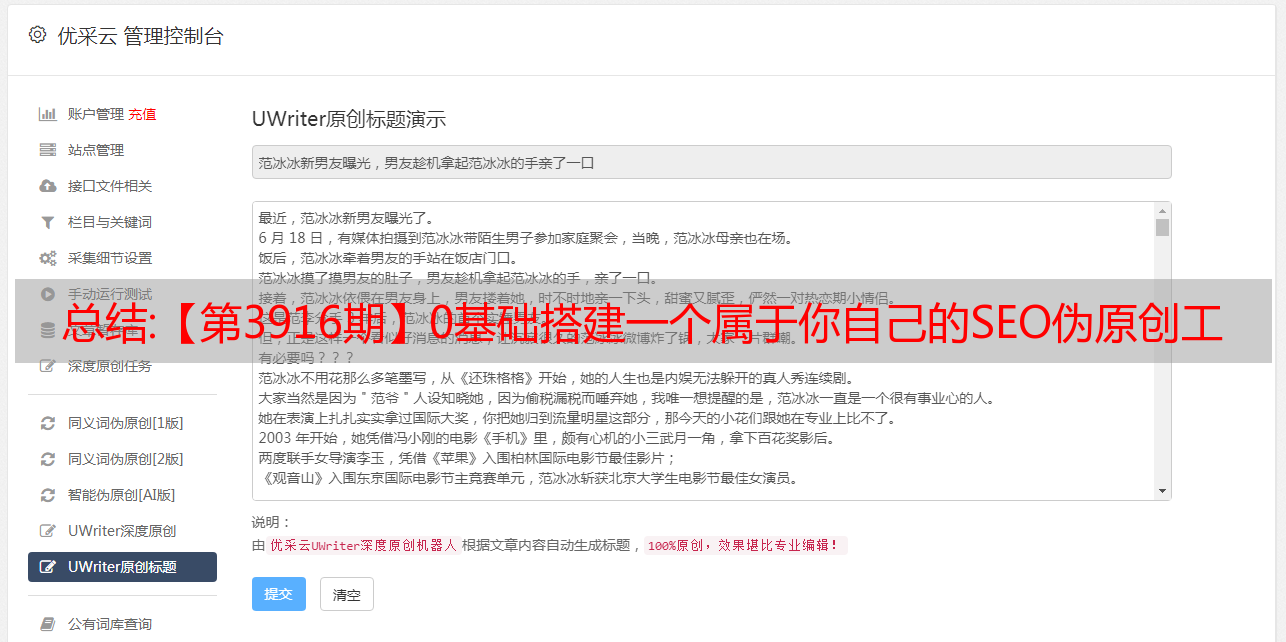

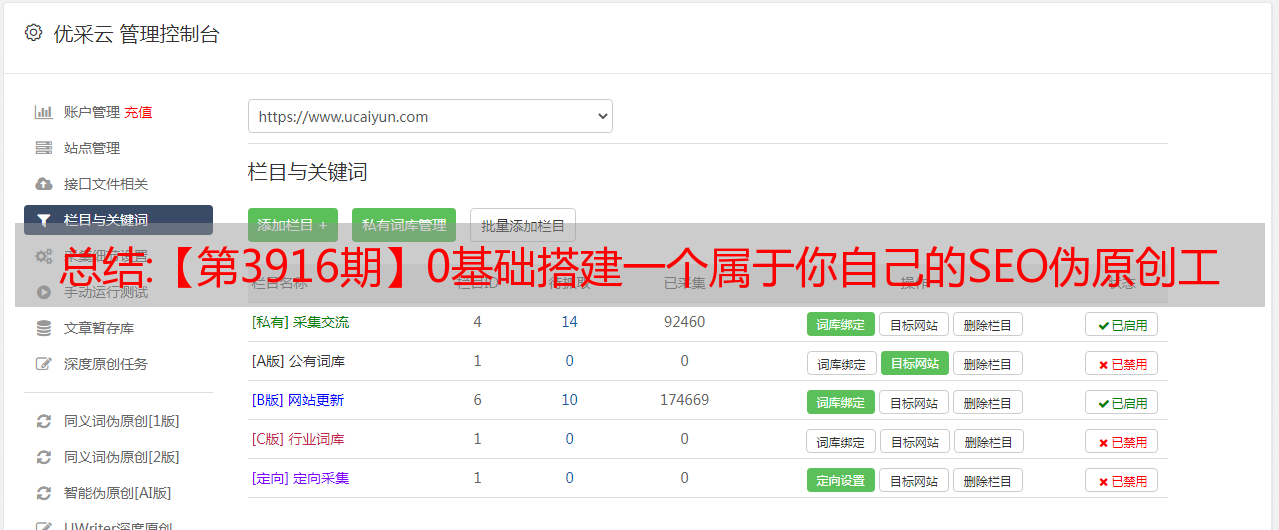

SEO伪原创工具是针对互联网垂直领域的SEO、网站、新媒体、文案编辑等开发的软文编写工具。 它利用爬虫技术采集和抓取同行业数据,利用深度学习分析句法和语义。 (自然语言处理)

利用索引技术精准推荐用户需要的相关内容,集文章采集、伪原创、原创检测于一体,

进行智能伪原创和相似度检测分析,实现简单、高效、智能地利用工具完成软文文章写作,实现伪原创从互联网到回馈的生态链互联网,让我们的网站文章更容易被收录,自自媒体软文更容易获得推广效果。

2.实践教学

1.将源码上传到虚拟机或服务器并解压。

2.选择php版本5.6

3.访问:域名/install/index.php安装

资源下载 资源下载价格为10永锶币,请先登录

核心方法:【数字化2.0】利用Python进行NLP,建立英文基础词库

作为热水器数字化2.0的子项目之一,英文观察平台通过采集海外电商网站的产品信息和用户评论进行深度分析。 目标是通过数据洞察,实现对海外市场、用户和产品的全面分析。

天文台用户评论文本分析的目的是解读用户的关注点和诉求,洞察用户需求。 Observatory 使用自然语言处理 (NLP) 和机器学习方法从海量用户评论中提取用户意见。 NLP 是 AI 的一个子领域,也是 AI 中最难的问题之一。 英文观察平台对海外电商网站进行英文文本分析,难度高于中文。 汉语可以根据词典进行分词,英语不能根据语法结构进行分词。 目前,它只能按空格分割单词。

英语天文台是如何实现海量英文文本分析的? 什么是关键词,如何快速准确地提取核心关键词进一步拓展? 答案马上揭晓。

什么是关键词

关键词=核心词、特征词和高频词,在文本中承载重要信息。 关键词一般由特征词+情感词组成,特征词代表用户评论的主题,情感词代表用户的感受。

关键词提取步骤

Step1:人工提取关键词,为机器学习提供学习语料

Step2:建立自然语言的基本词库

Step3:机器学习训练

以python为例介绍基础英文关键词词库的建立方法

☟☟☟

第一步:使用Nltk库进行分词和词性标注

Nltk(natural languagetoolkit)库是python处理自然语言的工具包。 它具有丰富的功能,包括分词、词性标注和文本分类。

第二步:根据特定词性提取关键词

根据英语的日常使用,归纳出常见的词性组合,如:

利用常见的词性组合在原创评论中提取更多用户关注点。

Step3:丰富的关键词

可以通过替换同义词之间的情感词来生成新的关键词。

当然,关键词的扩展方法远不止上述几种,基础词库的建立只是第一步。 Observatory通过NLP和机器学习洞察市场规律、解读用户声音、发现产品痛点,通过数据驱动为Digital 2.0提供大数据支持,助力业务单元数字化运营。