干货内容:从百度飓风算法深入剖析SEO优化过程原创文章的重要性

优采云 发布时间: 2022-12-20 18:33干货内容:从百度飓风算法深入剖析SEO优化过程原创文章的重要性

百度于11月推出飓风算法,旨在打击不良文章采集,维护原创优质站的公正性。 今天,我将从什么是百度飓风算法,什么是原创优质站点,如何建设原创优质站点等方面,为大家深入讲解原创文章。

1、什么是百度飓风算法?

百度飓风算法是一种严厉打击以不良采集为主要内容来源的网站的算法。 可自动彻底清除百度搜索引擎索引库中的不良采集链接,为优质原创内容提供更多展示机会。 飓风算法不是一天形成的,它是从早期攻击新闻源和站群的算法不断迭代形成的。 通俗地说,就是大力扶持原创优质文章站,促进搜索生态的健康发展。

二、什么样的原创才是优质?

很多SEO优化人员认为只要更新原创内容就可以打动用户,让他们喜欢上网站。 其实,优质的内容并不只是需要每天更新,一步步写一些网上没有出现的内容。 必须满足以下三点之一才能称为优质内容。 1、可以解决用户问题; 2、可以为用户提供解决问题的思路; 3、可以让用户进行二次传播。 因此,在更新内容时,首先要考虑的是内容能否为用户带来价值,而不是文章是否原创。

3.原创的过程中有哪些误区是必须要避免的?

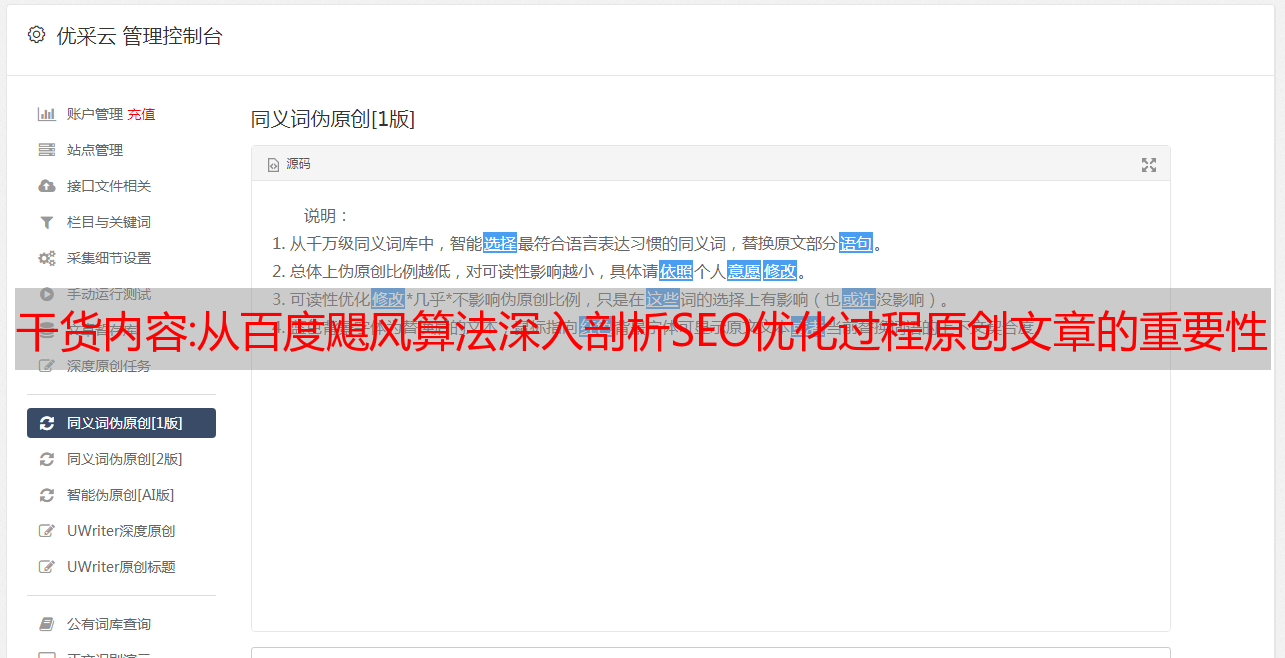

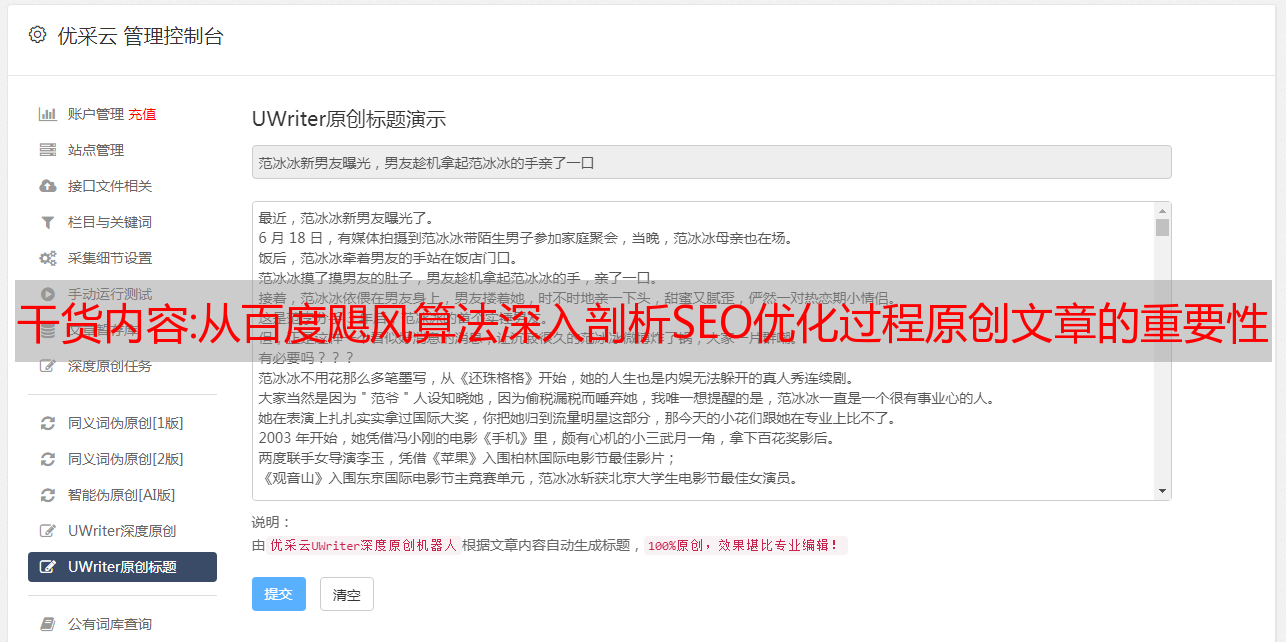

我曾经和志同道合的朋友聊过原创和伪原创。 有朋友认为,原创容易导致词穷,也就是不知道写什么,伪原创更容易纠正。 根据我对 SEO 的要求和经验,我不同意。 首先,原创性要符合主题和中心思想; 其次,不得为了原创而写一些与主题无关或与主题无关的内容; 最后,坚决反对通过采集工具和相关词的替换来伪原创。 坚持一个原则,“宁可不足,不可过度”。

4、如何打造原创优质的站内内容?

很多SEO优化人员都想知道如何打造原创优质的网站内容? 在谈到这个问题的时候,我们SEO人员应该思考以下几个问题: 1、用户需要什么内容,如何写出有深度、有意义的内容? 2、用户不喜欢什么内容,网站应该如何规避? 3、如何让用户自发转发一些原创内容。 其实,只要你是站长,愿意经常用心、用脑、用手,那你就根本不会为网站的内容发愁。

总之,无论出现什么算法,只要我们对网站质量高标准严要求,合理SEO,就不会被百度的算法调整。

解读:数据挖掘之链接分析学习

链接分析最重要的应用是搜索引擎。 此外,它还用于论文检索和社交网络。

1. 使用了哪些链接分析技术?

2. PageRank技术的基本定义是什么?

3. PageRank 有哪些改进? 考虑了哪些因素?

4、链接作弊有哪些技巧? 如何消除这些作弊?

5.什么是HITS算法? 与 PageRank 有什么区别?

1. 使用了哪些链接分析技术?

1)倒排索引:第一代搜索技术,将网页的数据分解为关键词项,然后按关键词建立索引,通过关键词索引找到对应的网页。 此外,还有非主属性值,称为次键值。 带有倒排索引的文件称为倒排文件,倒排文件中的二级关键字索引称为倒排列表。 从倒排表可以对集合进行合并、求交等操作,得到结果后可以对记录进行操作。

2)PageRank:关注链接的入度和出度,即本网页与其他网页的关系,计算出一个PR值,从而判断该网页的重要程度。 词条是搜索引擎查询的另一个依据,可以说是第一过滤项。

3)HITS:分析网页的导航和权限,判断网页的作用。

2. PageRank的基本定义是什么?

有向图,每个顶点都有入度和出度,自带网页跳转概率。 将这样一个图的关系用矩阵表示,形成网络传输矩阵M。

冲浪者(surfer's)位置的概率分布可以用一个n维向量v来描述,其中第j个分量表示冲浪者在第j个网页上的概率。

而v1 = M*v0,表示冲浪者经历了一次操作/跳跃。 当冲浪者经过多次跳跃后,冲浪者的分布接近于一个极限,即v = M*v,冲浪者的位置分布是不同的。 再次改变。

此时v恰好是M的特征向量。

PageRank 的出现受到引文分析的启发。

PageRank是一个概率分布,其值的计算需要经过一个迭代过程。

普通PageRank的结构有两个问题:

1)终止点现象,即有些顶点只有入度没有出度,所以当到达网页时,冲浪者就消失了,再也不会出来了。

2) 采集器 trap spider trap:一组网页,进入后只在内部相互跳转,从不指向外部网页。 这样一来,上网者进入后只会出现在这组网页中,无法离开。

这两个问题都可以通过“抽税”来解决。

解决方案:

1)终点问题:

一种。 删除终止,但可能会创建更多终止或孤立的子图。

b. 修改随机冲浪者的冲浪过程,即“征税”。与采集器陷阱相同

2)采集器陷阱:

它还经过税收处理,让每个随机冲浪者以很小的概率随机跳转到一个随机网页。 即v = b*M*v + (1-b)*e/n,b是一个选定的常数,通常在0.8到0.9之间。 e 是所有分量都等于 1 的向量,n 是图中所有节点的数量。

b*M*v表示随机一个冲浪者以概率b选择一个出口跳转的情况,(1-b)*M*e/n表示一个新的冲浪者随机以概率(1-b)选择一个网友访问.

这避免了陷阱和终止点问题。

3. 什么是面向主题的 PageRank? 它解决了什么问题?

先说问题的根源。 纯pagerank算法只考虑网页本身的因素,没有考虑用户自身的习惯、喜好等因素。 每个人都有自己的特点。 如果考虑到这些因素,那么 PageRank 会更准确。 所以每个人都要存储自己的PageRank,但是这是不可能的,因为PageRank向量本身是巨大的n,而每个人m都有一个唯一的PageRank,所以需要的空间是n*m。 所需的存储空间太大且不必要。 而且,记录客户的历史操作,很容易引发用户隐私问题。

如何考虑用户偏好?

即使用面向主题的PageRank对网页进行分类,如体育、娱乐、政治、经济、军事等。每一类网页都有一个PageRank值,每个用户只需要保留每一类网页的特征数据即可网页。 每一类网页的表示都是使用面向主题的PageRank。

解决方案:

Biased random walk model,topic-oriented PageRank与普通PageRank的形式相同,即v = b*M*v + (1-b)*Se/|S|,不同的是Se是一个biased new的surfer vector,将属于同一topic的分量设为1,其他分量设为0,从而形成有偏迁移模型,最终通过迭代计算出的PageRank值就是该topic的PageRank值。

4、链接作弊有哪些技巧? 危害有多大? 如何消除这些作弊?

链接作弊,如果您试图提高网页/网站的 PageRank 值。

怎么做? 一般有两种方式:

1)自己建一些网页,将一些链接指向需要作弊的网页,即自建Farm,俗称垃圾农场;

2)通过其他网页的消息功能,将作弊链接放入消息中,比如是的,关于...,请看

作弊有多危险?

用一个简单的模型推导出垃圾网页的pagerank值的计算:

假设目标网页的pagerank值为y,有m个网页链接到它。 如果“抽税”的参数是b,一般取0.85,那么支持/链接垃圾邮件的网页的pagerank值为

b * y / m + (1 - b) / n

如果外部支持垃圾邮件的目标网页的值为x,内部垃圾邮件支持网页的值为b * m * (b * y / m + (1 - b) / n),则红色部分就是上面每个支持网页的m个页面的pagerank值乘以m。

那么y = x +b * m * (b * y / m + (1 - b) / n) = x + (b^2) *y + b * (1-b) * m / n,解方程:

y = x / (1 - b^2) + c * m / n, c=b/(1+b)

b的值为0.85,则1/(1-b^2) = 3.6,c = 0.46。 因此,这样一来,外部链接的效果可以放大3.6倍,垃圾邮件占所有页面的比例比m/n all的值高0.46倍。

如何杜绝作弊?

完全杜绝是不可能的,总会有新的作弊方式。

常用方法:

1) TrustRank:使用面向主题的PageRank 来降低垃圾网页的pagerank 值。

2)垃圾邮件群发,即识别出可能是垃圾邮件的网页,让搜索引擎删除或降低这些网页的pagerank值。

信任等级:

主题网页获取方式有两种:

一种。 手动检查一系列网页以确定哪些是可靠的。 您可以先筛选出排名靠前的网页进行检查。 因此,通过作弊获得前几页的难度更大。

b. 选择受限域名,这些域名可信度较高,如.edu.、.gov。

垃圾邮件群发垃圾邮件:

首先,计算正常的pagerank值r,和Trust topic pagerank值t(偏向随机游走模型)

然后,可以计算每个网页p的垃圾程度:(r - t)/r,如果接近1,则说明网页p可能是垃圾页面,如果较小且接近0,则说明表示网页 p 不是垃圾邮件。 r值接近t,即如果网页的正常pagerank计算值与topic pagerank计算值相似,则可信度高; 否则,它的 pagerank 值可能来自某些垃圾邮件贡献。

5.什么是HITS算法? 与 PageRank 有什么区别?

“导航页和权威页”的计算方法和pagerank类似,通过matrix-vector迭代直到一个收敛点。 它的算法也称为HITS算法。

Pagerank考虑的是网页重要性的一维重要性信息,而HITS则认为网页具有二维的重要性信息:

1)权威页面:一些网页提供某个主题的信息,有非常重要的信息。 这些网页称为权威页面。

2)导航页:不提供主题信息,但可以找到该主题的网页信息,这样的网页称为导航页。

表现形式:每个网页都有一个权威度和导航度属性。 如果用h和a分别表示网页的两个属性,那么h和a的第j个分量分别表示权限值和第j个网页的值。 导航度值。

每个网页的导航度等于其链接出的网页的权威度累加,每个网页的权威度等于其链接入的网页的导航度累加。 并保证规范化。

这就创建了一个回归方程:“导航页面指向许多权威页面,而权威页面又被许多导航页面指向”。 本质上,它仍然是一个矩阵向量迭代乘法运算。

若网页的链接矩阵为L,则导航度向量h,权威度向量a。

则 h = d* L * a,其中 d 为常数,

a = u * Lt * h,其中 Lt 是 L 的转置。L 是 0-1 矩阵。

从上面的重叠操作方法推导出:

h = d * u * L * Lt * h

a = d * u * Lt * L * a

由于L*Lt的求解不方便,所以h和a最好重叠计算,每次计算都需要归一化。

但是,端点和采集器陷阱不会影响 HITS 解决方案。 所以不需要税收机制。