总结:网站的SEO优化过程中怎样分析网站日志?

优采云 发布时间: 2022-12-20 17:58总结:网站的SEO优化过程中怎样分析网站日志?

在网站SEO优化过程中,不可避免地要对网站日志进行分析。 对网站日志的分析诊断,就像治疗网站的病一样。 通过对网站日志的分析,我们可以更清楚地了解网站的健康状况,利用这些数据更有利于开发网站SEO优化。 通过网站日志,您可以清楚地知道用户在什么IP、什么时间、什么操作系统、什么浏览器、什么分辨率显示器的情况下访问了您网站的哪个页面,以及访问是否成功。 对于从事搜索引擎优化的专业人士来说,网站日志可以记录每个搜索引擎蜘蛛机器人爬取网站的详细信息,例如:哪一天哪个IP的百度蜘蛛机器人访问了该网站多少次,访问了哪些页面,以及访问了哪些页面。 页面返回的 HTTP 状态代码。

一、网站日志的作用

1、通过网站日志可以了解蜘蛛在网站上的基本爬行情况,可以知道蜘蛛的爬行轨迹和爬行量。

2、网站的更新频率还与蜘蛛在网站日志中抓取的频率有关。 一般来说,更新频率越高,蜘蛛的爬行频率就越高。 我们网站的更新,不仅仅是内容的增加,更是我们运营的微调。

3、我们可以根据网站日志的响应,对我们空间的某些操作和问题进行预警,因为如果服务器出现问题,会在第一时间反映在网站日志中。 需要知道服务器的稳定速度和周转率。 这两者的打开速度都会直接影响到我们的网站。

4、通过网站日志,我们可以知道网站的哪些页面非常受蜘蛛的欢迎,哪些页面根本就没有被蜘蛛接触过。 同时,我们也可以发现一些蜘蛛正在过度爬取我们的服务器资源。 损失很大,必须要做好屏蔽工作。

2. 如何下载网站日志

1、首先我们的空间必须支持网站日志下载。 这个非常重要。 在购买空间之前,您需要知道是否支持日志下载,因为有些服务提供商不提供此服务。 如果支持的话, space 后台通常有一个log WebLog日志下载功能,可以下载到根目录,然后用FTP传输到本地。 对于服务器,可以设置要下载的日志文件到指定路径。

3、网站日志数据分析

1、网站日志中的数据量太大,所以我们通常要借助网站日志分析工具进行检查。 117.26.203.167 - - [02/May/2011:01:57:44-0700] "GET/index.php HTTP/1.1" 500 19967 "-" "Mozilla/4.0(兼容;MSIE8.0;Windows NT 5.1; Trident/4.0;AskTbCS-ST/5.11.3.15590;.NET CLR 2.0.50727;Alexa 工具栏)”剖析:

117.26.203.167访问ip;

02/May/2011:01:57:44 -0700 访问日期-时区; GET/index.php HTTP/1.1 根据HTTP/1.1协议爬取(域名下)/index.php页面(GET表示服务器动作); 500 服务器响应状态码; 服务器响应状态码通常有以下几种状态码:200、301、302、304、404、500等,200表示用户已成功获取请求的文件。 如果是搜索引擎,则证明蜘蛛在这次爬取中成功找到了一些新的内容。 而301表示用户访问的某个页面的url已经用301重定向优化过(永久),302是临时重定向。 404 意味着访问的页面不再存在,或者访问的 url 根本就是错误的。 500 是服务器错误。

19967表示抓取了19967个字节;

Mozilla/4.0(兼容;MSIE 8.0;Windows NT 5.1;Trident/4.0;AskTbCS-ST/5.11.3.15590;.NET CLR 2.0.50727;Alexa Toolbar表示访问者使用Firefox浏览器和AlexaToolbar等访问终端信息; 2.如果你的日志格式不是这样的,说明日志格式设置不一样。

3、如果能在很多日志中看到200 0 0和200 0 64,说明正常爬取。

4、爬取频率通过查看每日日志中百度蜘蛛爬取的次数得知。 抓取频率没有标准时间表或频率编号。 我们通常通过对比几天的日志来判断。 当然,我们希望百度蜘蛛每天爬取尽可能多的次数。

5.有些情况下我们的路径不一致,有没有斜线都有问题。 蜘蛛会自动识别为301,跳转到斜杠页面。 这里我们发现搜索引擎可以判断我们的目录,所以我们要统一我们的目录。

6.我们分析日志分析时间比较长,可以看到蜘蛛的爬行规律,可以看到同目录下单个文件的爬行频率区间和不同目录的爬行频率区间,爬行频率间隔时间 由蜘蛛根据网站权重和网站更新频率自动确定。

7、蜘蛛对我们页面的抓取是分级的,按照权重从大到小排序。 一般顺序是首页、目录页、内页。

4、通过网站日志我们可以知道什么?

1、我们买的空间能不能稳定?

2. 蜘蛛喜欢我们页面的什么,不喜欢什么?

3、蜘蛛在什么情况下会频繁爬取我们的网站,什么时候需要更新内容?

总结:关于SS6.0采集器文章倒序采集功能的建议

原帖由 茄子 于 2008-1-3 14:43 发表

这意味着您的列表页面设置有问题

明明只需要采集其中一个列表页的文章,何必写100个列表

茄子,你没明白我的意思,可能是我没表达清楚

.

让我们举个例子。 以SS5.5为例,我想采集本列表页【论坛资源】下的文章。 因为里面的内容每天更新不超过5篇(基本是1-2篇),所以我只需要将每次采集的文章数设置为5篇即可(注意不是所有列表页都是40篇) ), 同时选择 Do not allow headers to be 采集 repeatedly if I run the 采集器 every day. 这样一来,我每天只需要跑一次采集,绝对可以采集到里面所有的信息。

我所说的设置采集文章数的意思是这样设置的:

但是如果我切换到SS6.0的逆序采集,同样的设置,我采集的地块永远是最后5块内容。 为了能够得到最新的更新,我必须设置采集的文章数来匹配列表页面显示的所有文章数,这里是40篇。

但是想象一下,如果一个网站的列表页面每页显示 200文章……? 假设这个网站每天更新的内容是前5篇,但是如果我要倒序采集的话,我每次都得看这200条就可以了。

这就是我认为现在的逆序采集规则不合理的地方。 目前的规则是,运行采集器后,系统会先访问这个列表页面,记录下所有符合规则的文章url,然后从下往上或从上往下倒序或正序采集这些url集合文章内容量。 而我觉得应该是系统接入,只记录置顶采集的设定文章数的url,然后按照正序或逆序采集,这样就解决了前面的问题。 和现在的采集规则相比,只是多了一步而已,但是这样一来,倒序采集这个非常非常好的功能,就会有更加广阔的实际应用空间。 希望开发者考虑一下。

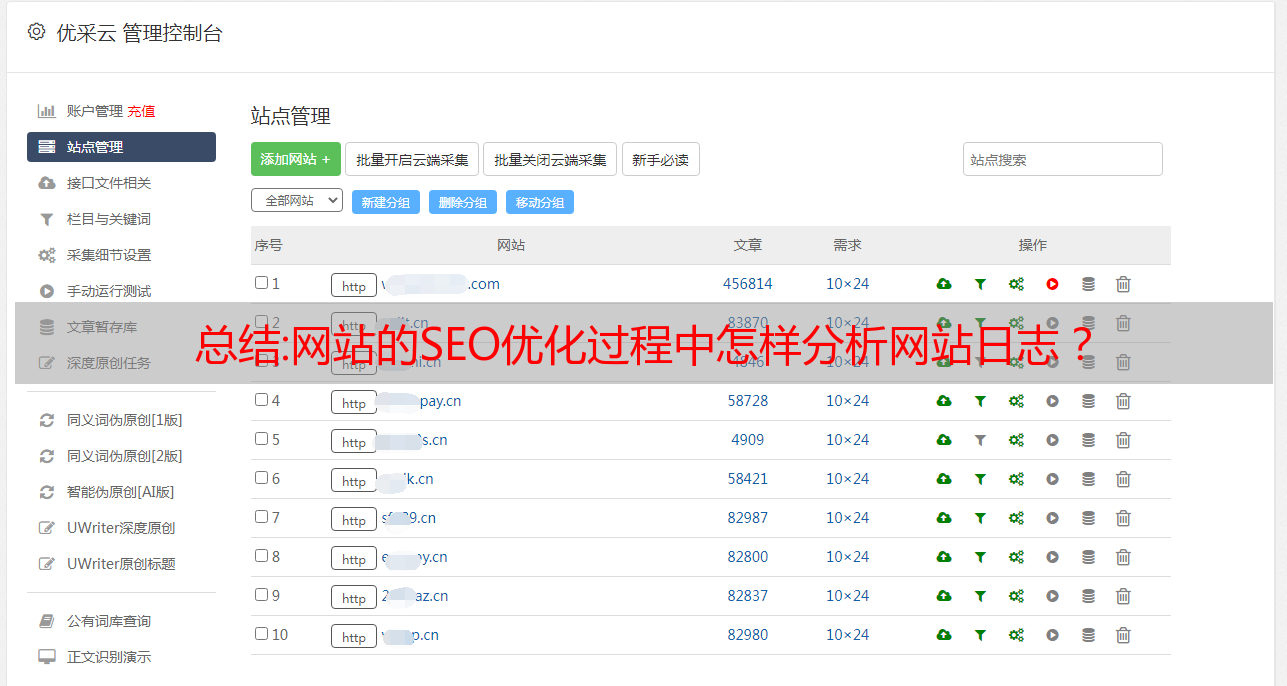

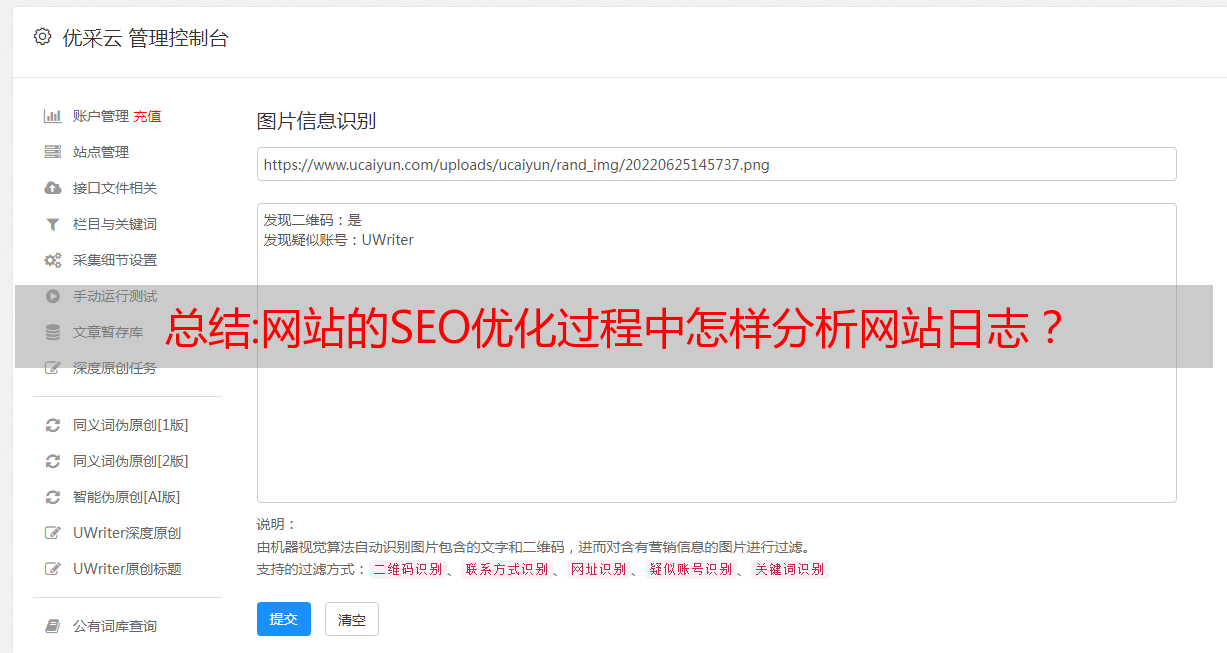

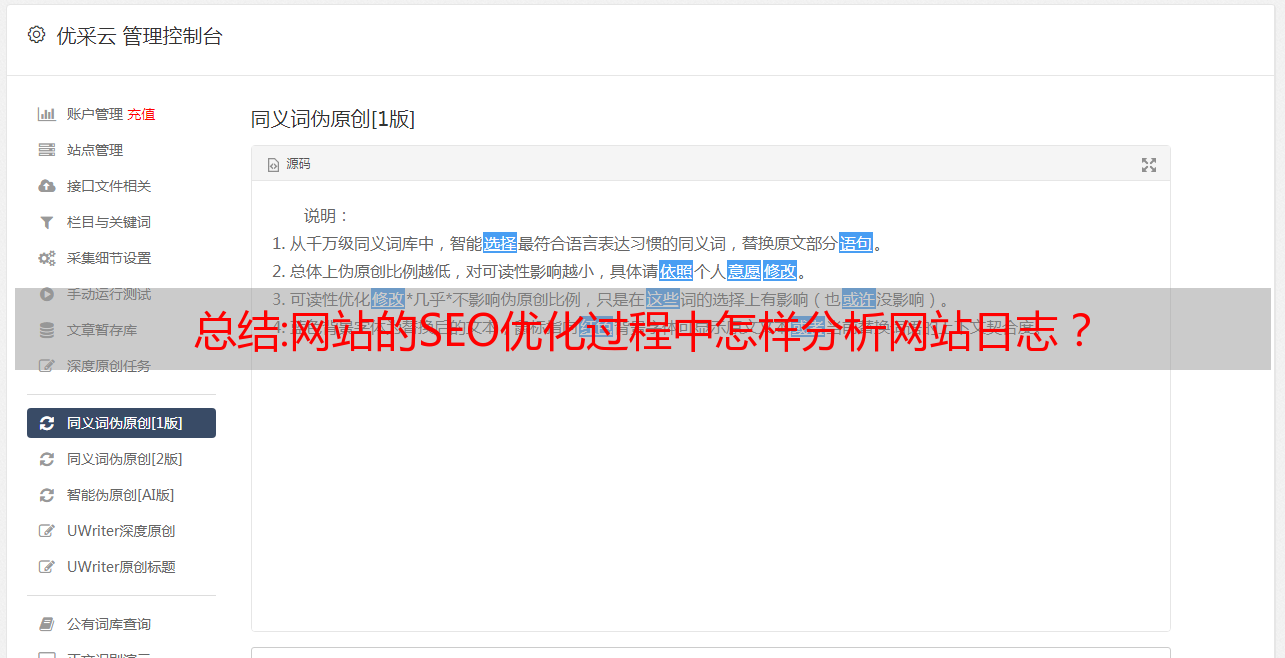

配以下图片:

希望这次我说清楚了