汇总:网站常用数据分析工具吐血推荐

优采云 发布时间: 2022-12-17 14:33汇总:网站常用数据分析工具吐血推荐

我很久以前就想写这个文章。之前回老家玩了10天,比较懒,就没写了。今天终于调整了心情,准备写出来,自己找工作。

回顾我3年多的网络推广,数据分析起到了非常重要的作用。能够做好数据分析工作,离不开一些好的数据分析工具的辅助。今天给大家分享一些我经常使用的数据分析工具。主要是网站流量数据和网站SEO数据的分析工具。

一:网站流量来源数据分析工具

我主要使用两种数据分析工具来分析网站流量来源。一个是市场覆盖率最大的51LA统计数据,一个是CNZZ最新发布的商业统计数据。其实免费在线流量统计的基本功能都差不多。这里我就说说我比较喜欢的51LA和CNZZ商业统计的一些亮点。

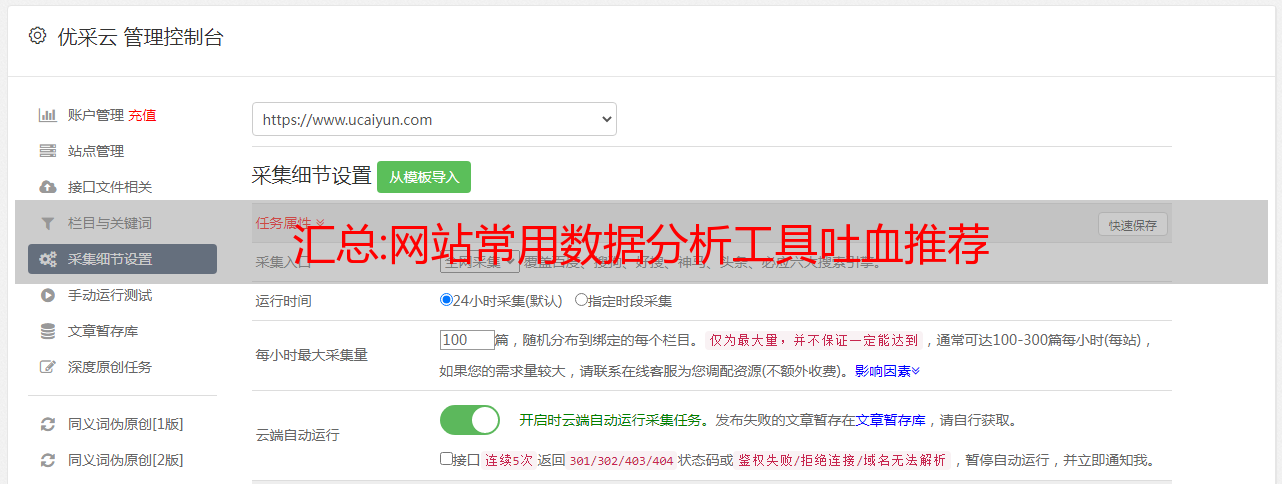

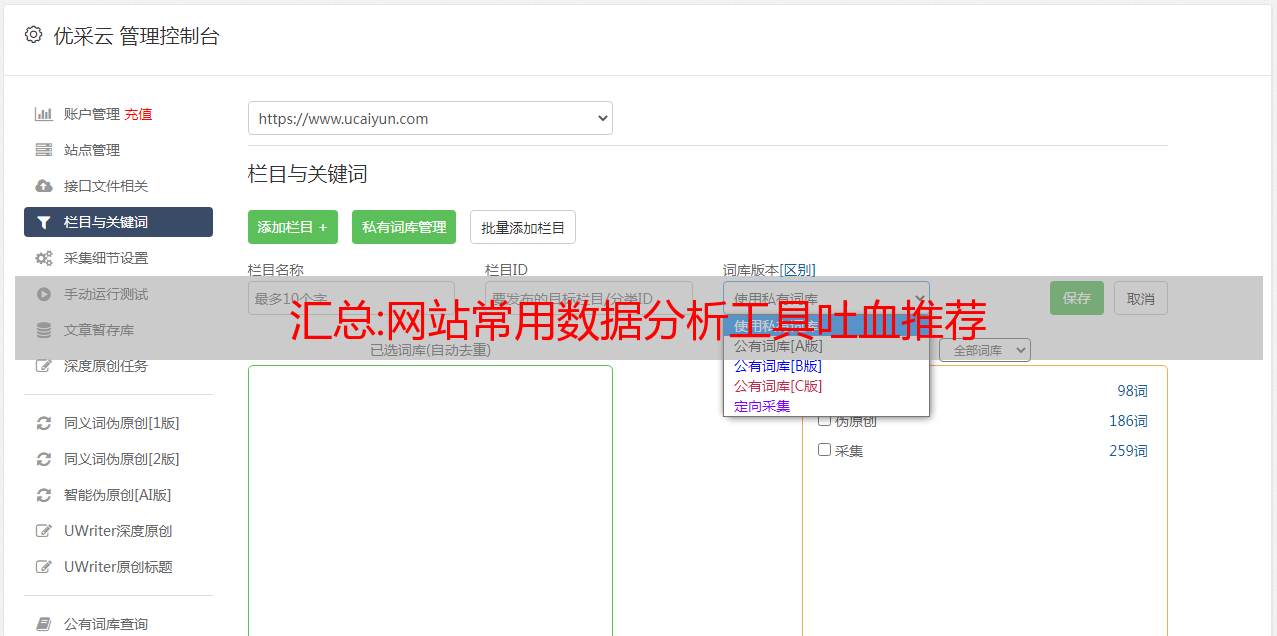

图一:51LA的单个网站历史查询功能

通过这个功能,我可以知道某个流量来源,以及最近一个月的流量变化,可以让我更好的掌握各个推广渠道的流量趋势。

图2:CNZZ业务统计的用户查看流量分析功能

通过该功能,您可以分析网站用户在任意页面的点击情况。比如10000人进入了你的网站首页,你可以分析哪些栏目,哪些文章。为了分析用户的点击习惯,我们可以改进网站的产品。这对于产品经理提高产品入口,对于个人站长提高联盟广告的点击率都非常有帮助。CNZZ的业务统计免费试用地址:

二:搜索引擎收录、反向链接、PR值、网站排名综合查询工具

以上函数用来判断一个网站的质量标准,一个网站可以被很多搜索引擎收录搜索到,有很多反向链接,PR值比较高而网站的排名可以体现出这个网站的好坏。这些功能也可以在admin5 chinaz的站长工具栏中找到。在这里推荐一款可以一次综合查询的工具。

图3:综合查询各项指标

从图3可以看出,网站的收录和各个搜索引擎的反向链接都可以通过这个网站查询一次性查到。还可以查到googlePR值和sogouPR值。ALEXA排名和中国网站排名也一下子查出来了。此外,还有网站百度最新的收录状态,百度快照的日期,网站导出的链接数等。查看了的许多重要质量指标网站 一次。这样,当大家想知道自己的网站和合作网站的基本素质时,使用这个工具就可以一目了然了。

三:友情链接查看工具

这个功能是我最喜欢的,因为它对我的SEO工作很有帮助,有效的提高了工作效率。在做SEO之前,我做了很多友情链接。但是我们不能每天花时间一一查看对方是否还有我们的链接,对方是否突然被百度K,对方是否按照我们的要求链接了关键词,或者与 网站 合作更新 PR 不符合我们的链接标准。自从发现这个工具以来,所有这些问题都得到了解决。不再需要花费人力和时间去一一检查。你只需要使用这个工具,输入网址并按下回车键就可以搞定一切。

图 4:通过此工具检查您博客的链接状态

从上图我们可以看出我链接的网站对方的百度收录情况,对方的PR值,我的链接是否链接到对方首页的内页,以及被链接的关键词是对方外链的位置,对方最新百度快照的日期是什么?这些都是交换友情链接衡量SEO效果的标准。有了这个工具,无论交换多少友情链接,都来不及查看。我现在每周查看一次,当我发现有提示我的网站没有被链接时,我去实际查看确认对方已经删除了,我会相应删除。网站 地址:

四:分析百度SEO工具关键词

由于百度禁止了查询相关词的功能,站长们要想在某个热门关键词下找到更多的关键词就更加困难了,必须一个一个的去查。这个词的百度指数是多少,是否值得去SEO。第一次优化一个网站的时候,我也采集了大约200个与网站内容相关的相关词,然后一一查百度索引。前面的数据分析我花了很多时间。时间更少了,但自从有了这个工具,这些就不再是问题了,我可以随心所欲地进行网站内容关键词分析。通过这个工具,我可以找出某个热词下的所有相关词,还可以得到每个关键词的百度索引。如果不,

图 5:关键词 与热词“美”相关的百度指数

从图5可以看出,我通过这个工具输入关键词“美女”,得到了一些美女相关热词的百度索引。假设我想为一个美图网站做SEO,我知道除了主要的关键词“beauty”还有哪些词的搜索量比较大,值得做SEO。

今天的数据分析工具分享就到此结束吧。怕篇幅太长,大家看得不耐烦了。上面的数据分享工具我没有做详细的介绍,只是提到了我比较喜欢的地方。比如51LA和CNZZ的商业统计有很多优势。比如CNZZ的商业统计还有其他流量统计网站没有的流量预警等特殊功能。而我上次提到的SEO工具有很多实用的功能,比如“百度竞品分析”可以分析出某个关键词TOP30网站的基本SEO情况,从而更好的了解竞品

汇总:日志收集系统

一、项目背景 二、解决方案

一个。实时采集本机日志,统一存储在中央系统

b. 然后索引这些日志,通过搜索就可以找到对应的日志

C。通过提供友好的web界面,可以通过web完成日志搜索

三、面临的问题/挑战

一个。实时日志量非常大,每天数十亿条日志

b. 准实时采集日志,延时控制在分钟级别

C。能够水平扩展

4.行业解决方案ELK

4.1 ELK简介

通俗地说,ELK是三个开源软件的组合:Elasticsearch(弹性搜索引擎)、Logstash(日志采集)、Kibana(查看日志/可视化web界面)。ELK是elastic公司开发的一套完整的软件。ELK是一个企业级的日志采集、分析和展示解决方案。在这三个软件中,每个软件用来完成不同的功能。ELK 也称为 ELK 堆栈。

对比架构图,我们来看看这三只猛兽的工作流程

1.用户向服务器发送请求

2、服务端通过网络请求将需要记录的日志数据发送到logstash

3、logstash过滤清洗数据后,发送到Elasticsearch

4. Elasticsearch 负责索引和存储数据

5、用户可以通过访问kibana的网页实时查看日志(延迟小于一秒)

参考:

麋鹿配置

麋鹿细节

4.2elk方案问题

一个。运维成本高,每次增加日志采集都需要手动修改配置

b. 缺少监控导致无法准确获取logstash的状态

C。Logstash属于服务器的角色,难免会出现集中的热点问题

d. 因为需要大量匹配操作(格式化日志),CPU消耗也大,没有使用scale out

5.用kafka设计日志系统

各成分介绍:

一个。Log Agent,日志采集客户端,用于采集服务器上的日志,每台服务器都有一个日志代理

b. Kafka,高吞吐分布式队列,linkin开发,apache顶级开源项目

C。ES,elasticsearch,开源搜索引擎,提供基于http restful的web界面

d. Hadoop,一个分布式计算框架,一个能够分布式处理大量数据的平台

5.1 Kafka应用场景:

1.异步处理,将非关键进程异步化,提高系统响应时间和健壮性

2.应用解耦,通过消息队列

3.流量削峰

比如双十一秒杀事件期间,访问量突然暴增,消息队列可以有效的实现流量减峰的效果,即限制发送到后端处理的数据量一度。

5.2 zookeeper(分布式存储系统)应用场景

在日志采集系统中,一般kafka会连接一个zookeeper

1. 服务注册&服务发现

当服务商扩容或缩容时,服务商会将服务注册到注册中心;

注册中心通知服务消费者服务变更,服务消费者根据注册变更信息实现任务自动调度优化(分发数据给新的服务提供者或向将停止服务的提供者发出调用请求)

2.配置中心(自动配置)

1.在wep平台修改业务,将变更信息传给zk

2. zk将服务业务变更信息发送给对应的业务应用,

3、对应的业务应用在本地拉取变更信息,修改业务配置

实现自动配置

3.分布式锁

zookeeper 是强一致的

多个客户端同时在Zookeeper上创建同一个znode,只有一个创建成功

5.3 zookeeper和kafka安装:

由于zookeeper和kafka都是基于java的,所以先安装JDK

sudo apt-get update

sudo apt-get install openjdk-8-jdk

动物园管理员安装:

在 ubuntu 上安装 zookeeper

安装动物园管理员

sudo apt-get install zookeeperd

配置动物园管理员

cat /etc/zookeeper/conf/zoo.cfg | more //查看zoo.cfg的配置信息

# The number of milliseconds of each tick

tickTime=2000

# The number of ticks that the initial

# synchronization phase can take

initLimit=10

# The number of ticks that can pass between

# sending a request and getting an acknowledgement

syncLimit=5

# the directory where the snapshot is stored.

dataDir=/var/lib/zookeeper

# Place the dataLogDir to a separate physical disc for better performance

# dataLogDir=/disk2/zookeeper

# the port at which the clients will connect

clientPort=2181

# specify all zookeeper servers

# The fist port is used by followers to connect to the leader

# The second one is used for leader election

server.1=zookeeper1:2888:3888

启动动物园管理员

启动server

$ sudo /usr/share/zookeeper/bin/zkServer.sh start

查看启动状态

$ sudo /usr/share/zookeeper/bin/zkServer.sh status

查看启动信息

ps -aux | grep zookeeper

链接服务器

sudo /usr/share/zookeeper/bin/zkCli.sh -server 127.0.0.1:2181

查看日志信息

日志信息是可以配置的,通过zoo.cfg,默认在:

/var/log/zookeeper/zookeeper.log

可以查看日志信息查看一些错误和细节

卡夫卡安装

ubuntu18.04下kafka安装部署

安装卡夫卡:

ubuntu下可以直接使用wget下载,我下载到/home/cyl/kafka目录下

wget https://dlcdn.apache.org/kafka/3.1.0/kafka_2.12-3.1.0.tgz

解压:

tar -zxvf kafka_2.12-3.1.0.tgz

改名

mv kafka_2.12-3.1.0 ./kafka

<p>

</p>

创建日志存放目录

yunlongchen@cyl:~/kafka$ mkdir logs-1

修改kafka-server的配置文件

yunlongchen@cyl:~/kafka/kafka$ sudo vim config/server.properties

修改配置文件中第21、31、36、60行

broker.id=1

listeners=PLAINTEXT://10.141.184:9092 #为了能顺利启动broker

advertised.listeners=PLAINTEXT://10.141.184:9092

log.dirs=/home/wzj/kafka/logs-1

启动动物园管理员

必须先修改config/zookeeper.properties配置

yunlongchen@cyl:~/kafka/kafka$ sudo ./bin/zookeeper-server-start.sh -daemon config/zookeeper.properties

建议使用:

$ sudo /usr/share/zookeeper/bin/zkServer.sh start

链接server

$ sudo /usr/share/zookeeper/bin/zkCli.sh -server 127.0.0.1:2181

启动卡夫卡服务

启动流程参考

使用kafka-server-start.sh启动kafka服务

yunlongchen@cyl:~/kafka/kafka$ sudo ./bin/kafka-server-start.sh ./config/server.properties

创建主题

使用kafka-topics.sh创建单分区单副本topic测试

yunlongchen@cyl:~/kafka/kafka$ sudo ./bin/kafka-topics.sh --create --bootstrap-server 10.141.65.188:9092 --replication-factor 1 --partitions 1 --topic nginxLog

此处不能使用localhost:9092,

遇到的问题

问题一:版本命令变化

bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic 测试

错误“线程“main”joptsimple.UnrecognizedOptionException 中的异常:zookeeper 不是可识别的选项”

在 Kafka 的较新版本(2.2 及更高版本)中,不再需要 ZooKeeper 连接字符串,即 - -zookeeper localhost:2181。使用 Kafka Broker 的 --bootstrap-server localhost:9092 而不是 --zookeeper localhost:2181。

问题二:

警告 [AdminClient clientId=adminclient-1] 无法建立与节点 -1 (localhost/127.0.0.1:9092) 的连接。经纪人可能不可用。(org.apache.kafka.clients.NetworkClient)

必须和配置文件中存放的*敏*感*词*器保持一致,例如

listeners=PLAINTEXT://192.168.156.131:9092

# 在命令使用时也必须使用192.168.156.131:9092作为连接的地址,如下

./kafka-console-producer.sh --broker-list 192.168.156.131:9092 --topic userlog

查看主题列表

yunlongchen@cyl:~/kafka/kafka$ sudo ./bin/kafka-topics.sh --list --bootstrap-server 10.141.65.188:9092

生成消息并创建消息生产者

yunlongchen@cyl:~/kafka/kafka$ sudo ./bin/kafka-console-producer.sh --broker-list 10.141.65.188:9092 --topic nginxLog

消费消息,创建消息消费者

yunlongchen@cyl:~/kafka/kafka$ sudo ./bin/kafka-console-consumer.sh --bootstrap-server 10.141.65.188:9092 --topic nginxLog --from-beginning

在生产消息窗口输入内容,在消费窗口打印出来

查看主题新闻

yunlongchen@cyl:~/kafka/kafka$ sudo ./bin/kafka-topics.sh --describe --bootstrap-server 10.141.65.188:9092 --topic nginxLog

Topic: nginxLog TopicId: t6M81RsMRPGj2tZVXaxltw PartitionCount: 1 ReplicationFactor: 1 Configs: segment.bytes=1073741824

Topic: nginxLog Partition: 0 Leader: 1 Replicas: 1 Isr: 1

第一行给出所有分区的摘要,每增加一行给出一个分区的信息。由于我们只有一个分区,所以只有一行。

“Leader”:是负责给定分区的所有读写的节点。每个节点将成为分区中随机选择的部分的领导者。

“副本”:是复制该分区日志的节点列表,无论它们是否是领导者,或者即使它们当前处于活动状态。

“Isr”:是一组“同步”副本。这是当前处于活动状态并定向到领导者的复制列表的子集。

删除话题

yunlongchen@cyl:~/kafka/kafka$ sudo ./bin/kafka-topics.sh --delete --bootstrap-server 10.141.65.188:9092 --topic nginxLogtest

启动命令:

bin/kafka-server-start.sh -daemon config/server.properties

创建topic

./kafka-topics.sh --create --bootstrap-server spark01:9092 --replication-factor 1 --partitions 1 --topic test2

查看topic

./kafka-topics.sh --bootstrap-server spark01:9092 --list

向指定topic中生产数据

./kafka-console-producer.sh --broker-list spark01:9092 --topic test2

例如:{"id":"1","name":"xiaoming","age":"20"}

查看topic具体内容

./kafka-console-consumer.sh --bootstrap-server spark01:9092 --topic test2 --from-beginning

创建消费者组

./kafka-console-consumer.sh --bootstrap-server spark01:9092 --topic test2 --group kafkatest

查看消费者组

./kafka-consumer-groups.sh --bootstrap-server spark01:9092 --list

查看消费者详情

./kafka-consumer-groups.sh --bootstrap-server spark01:9092 --describe --group kafkatest

消费数据

./kafka-console-consumer.sh --bootstrap-server spark01:9092 --topic test2 --from-beginning

6 代码实现

logagent实现代码github

1.kafka演示:

package kafka

import (

"fmt"

"github.com/Shopify/sarama"

)

func main() {

//配置kafka环境

config := sarama.NewConfig()

config.Producer.RequiredAcks = sarama.WaitForAll

config.Producer.Partitioner = sarama.NewRandomPartitioner

config.Producer.Return.Successes = true

client, err := sarama.NewSyncProducer([]string{"10.141.65.188:9092"}, config)

if err != nil {

fmt.Println("producer close, err:", err)

return

}

<p>

defer client.Close()

for i := 0; i