汇总:全自动采集小说网站源码无需数据免受权版 送码网

优采云 发布时间: 2022-12-16 19:25汇总:全自动采集小说网站源码无需数据免受权版 送码网

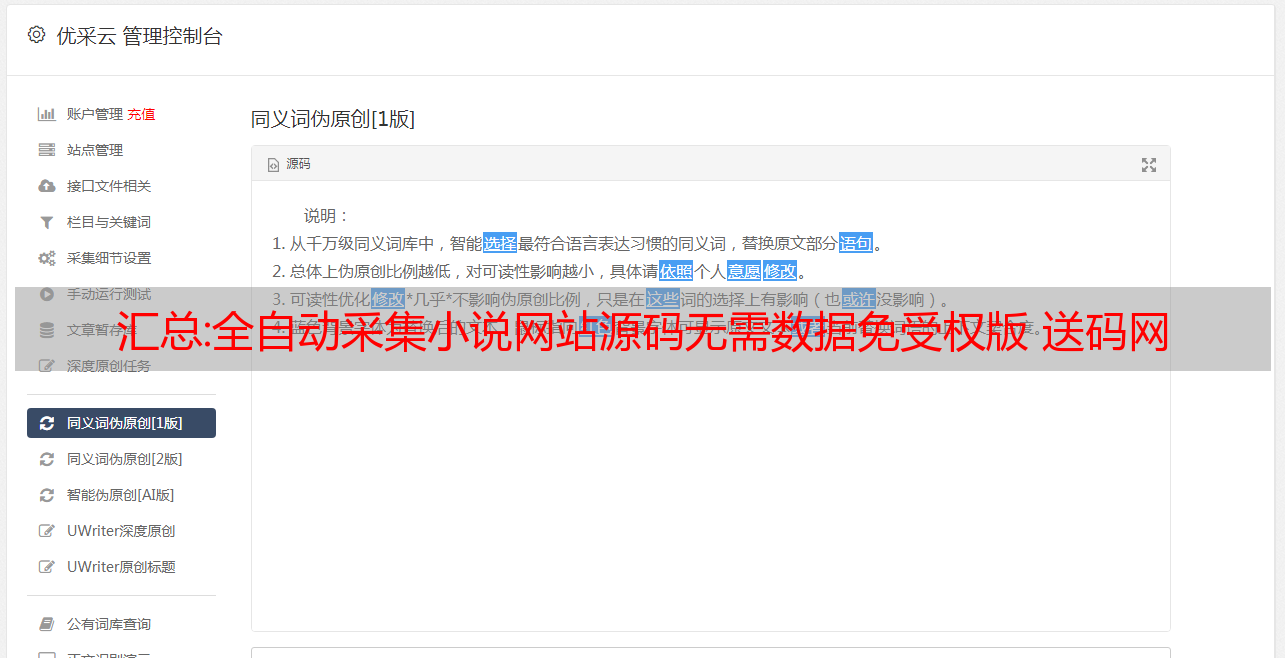

智云小说源码是用PHP+MySQL开发的PHP小说采集网站程序,不需要数据库,上传二级目录即可访问(需要修改访问路径)真正的 优采云 是必要的。

本小说的程序以文本缓存的方式存储,程序运行速度非常快。

未经授权使用飞飞小说进行修改优化!

本程序无需操心管理,让不懂程序开发,又没有太多时间频繁升级数据的朋友们可以快速搭建属于自己的小说网站。

使用本系统前,请确认您的空间支持伪静态,服务器环境请使用Apache或nginx,php版本7.0以下,推荐5.6PHP版本

1、通用参数配置:

后台地址:域名/admin 客户端名称和密码都是admin

上传源码并解压,请登录后台设置修改访问的域名

如果您修改后台路径,请在robots.txt文件中将Disallow: /admin/ 更改为您修改后的名称。

如果是二级目录,后端地址:域名/目录/admin 客户端名称和密码都是admin

更多优质源码+详情请到优品资源网了解

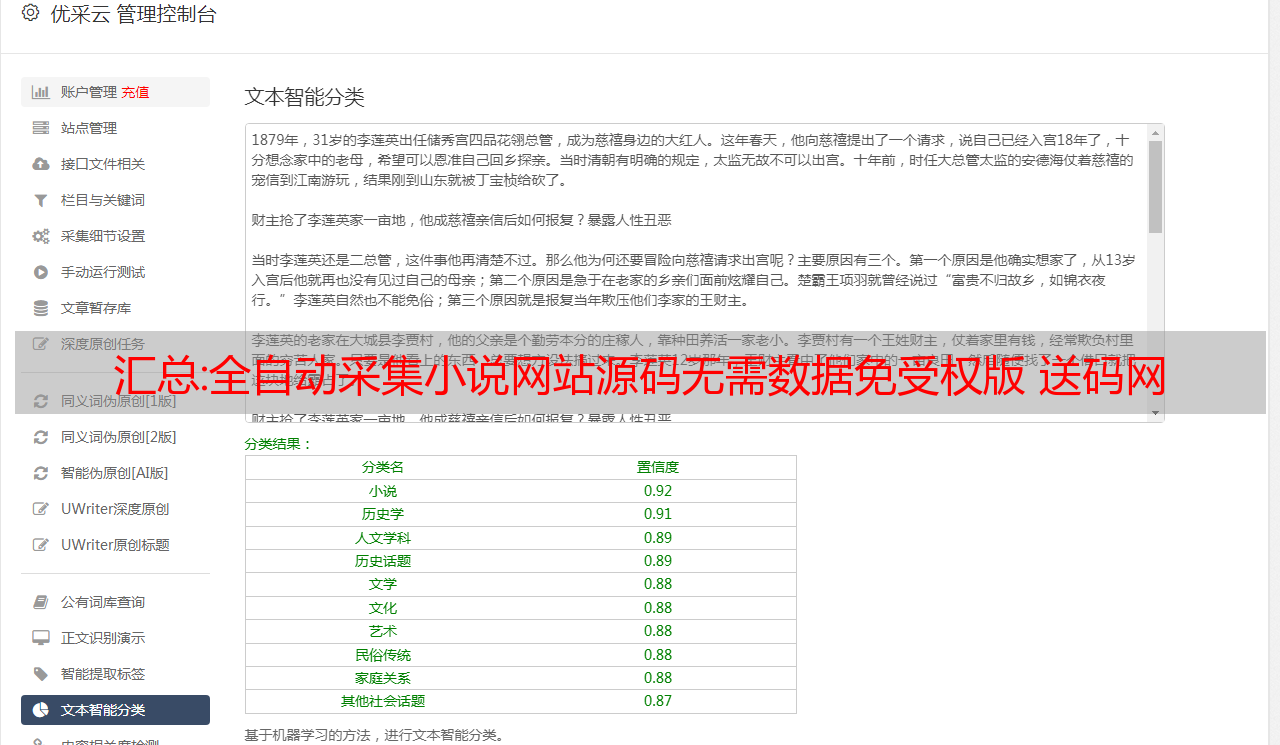

2.亲方效果截图:

汇总:JAVA采集图书的ISBN编号编码、出版社、出版时间、版次、正文语种、定价等信息

今天,我分享一个实践项目,以采集本书的ISBN编号,出版商,出版时间,版本,文本语言,定价和其他信息。

本项目介绍了如何使用代理IP和多线程采集公开数据,该项目尚不具备使用条件,仅供学习参考。

该项目需要用Maven引入,如果输入参考文本打开后出现错误,可以检查是否是JDK版本问题。

运行初学者类以启动爬网程序。

如果您需要使用代理 IP,请转至无忧代理 IP

你需要修改 test.config 包下面的 Memory 类,你可以修改:

1. 是否使用代理IP

2. 图片保存路径

3. 代理IP的API接口

4. 线程池数量

5. 默认超时时间

GITHUB: crawler-isbn.git

代码如下:

<p>package test.crawler;

import java.io.File;

import java.util.HashMap;

import java.util.HashSet;

import java.util.Map;

import java.util.Set;

import java.util.concurrent.atomic.AtomicInteger;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import test.bean.BookIsbn;

import test.config.Memory;

import test.util.CrawlerUtil;

import test.util.ImageBase64Util;

import test.util.LogUtil;

import test.util.StrUtil;

/**

* 抓取ISBN书号:https://www.kongfz.com/

*/

public class BookIsbnCrawler extends Crawler {

String TAG = "BookIsbnCrawler";

String savePath = Memory.imgSavePath;

Map headerMap = new HashMap();

int retryTime = 3;

AtomicInteger atoInt = new AtomicInteger(1);

Set uniqSet = new HashSet();

public void crawl() {

File imgDir = new File(savePath);

if( !imgDir.exists() ) {

imgDir.mkdir();

}

atoInt.addAndGet(uniqSet.size());

headerMap.put("Host", "item.kongfz.com");

headerMap.put("Referer", "https://www.kongfz.com/");

headerMap.put("accept", "text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9");

headerMap.put("accept-encoding", "gzip, deflate, br");

headerMap.put("accept-language", "zh-CN,zh;q=0.9");

headerMap.put("cache-control", "max-age=0");

headerMap.put("Cookie", "PHPSESSID=rh9lknq116ckuo9pgiqb2jouj4; shoppingCartSessionId=a62472297b0c7627de495fa5a03c6587; reciever_area=1006000000; utm_source=101002001000; kfz_uuid=68d0723f-2cf9-4f43-a759-d23153c286e0; kfz_trace=68d0723f-2cf9-4f43-a759-d23153c286e0|0|a5954114894d36e7|101002001000; Hm_lvt_bca7840de7b518b3c5e6c6d73ca2662c=1624890843; Hm_lvt_33be6c04e0febc7531a1315c9594b136=1624890843; kfz-tid=048e6e30d06d6d348cc8f9744e5324b5; TINGYUN_DATA=%7B%22id%22%3A%22XMf0fX2k_0w%23nUhCMQN2SSk%22%2C%22n%22%3A%22WebAction%2FURI%2Findex.php%22%2C%22tid%22%3A%22257dbf3edb0fcdc%22%2C%22q%22%3A0%2C%22a%22%3A298%7D; acw_tc=2760776516249390685651311e6bd932d369439bf419d2356de273bb15146b; Hm_lpvt_33be6c04e0febc7531a1315c9594b136=1624939075; Hm_lpvt_bca7840de7b518b3c5e6c6d73ca2662c=1624939075");

crawlKongFuZi();

LogUtil.logInfo(TAG, "采集任务已完成");

}

private void crawlKongFuZi() {

Set urlSet = init();

for(String one : urlSet) {

String parts[] = one.split("@#@");

String cat1 = parts[0];

String cat2 = parts[1];

String url = parts[2];

String html = null;

for( int i = 1; i