解决方案:如何文章采集引擎通过机器抓取网站的所有内容?(图)

优采云 发布时间: 2022-12-15 05:09解决方案:如何文章采集引擎通过机器抓取网站的所有内容?(图)

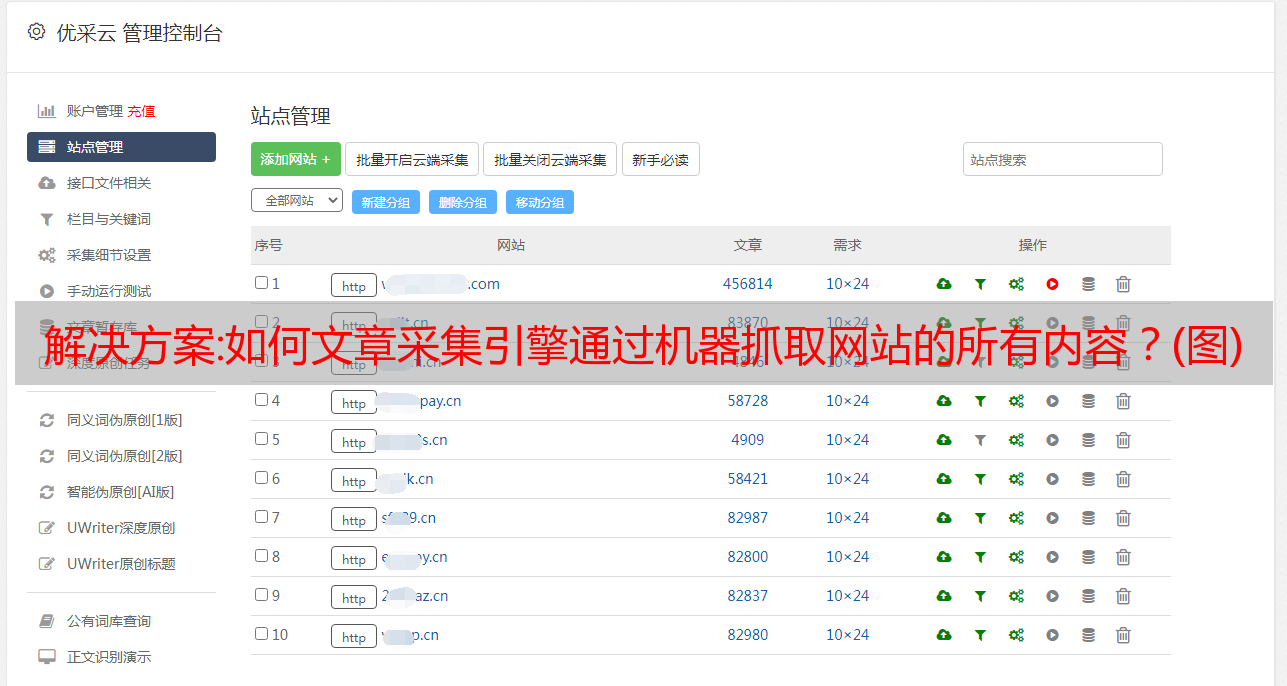

如何文章采集引擎通过机器抓取网站的内容后,将里面的文章通过各种形式发布到引擎上。还有可能是网站或网页本身有特殊的需求,网站方会主动把一些优质的文章放在网站上。那么作为网站的开发者,如何获取网站的所有内容,并且采集到本地进行整理呢?网络爬虫——这个被大家称之为网络蜘蛛的角色则是本文的主角。那么如何获取网站的所有内容呢?或者说,我们要如何写出一篇通过网络爬虫爬取所有网站内容的代码呢?我将在接下来详细地介绍我的思路。

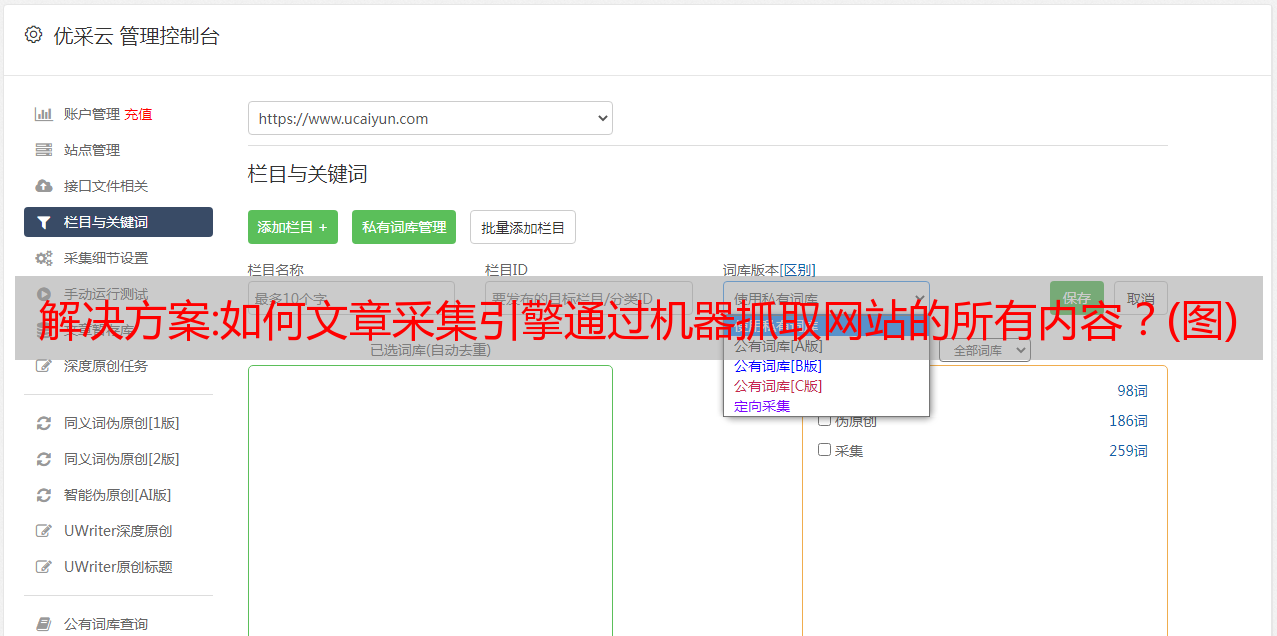

首先,我们先来谈谈为什么要采集网站,因为采集网站,是最容易实现或者是最便捷的办法。既然要采集网站,自然要求必须正规化。那么网站正规化到底指的是什么呢?网站正规化指的就是网站标识已经包含于爬虫采集程序中。网站标识,可以是js加载文件(jquery或者是自己写的css),或者是源代码。那么在我们开始采集网站之前,我们先来看一下网站链接或者连接的格式和对应的关键词是如何定义的。

所有的网站链接基本格式都是http,而http通常又包含了我们所熟悉的协议、子协议、uri和应用程序程序代码以及静态资源。所以我们需要先定义清楚爬虫到底要抓取哪个协议或者什么样的协议。关于http协议,我之前在其他地方总结过一篇,有兴趣的小伙伴可以去我的公众号【洪言微语】(hyqihui002)回复http获取高清大图。

那么以上我说的都是有用的。接下来我们需要了解网站连接通过关键词进行分类,其中:*负责发送http请求到服务器的是http服务器*负责返回http响应请求的是http客户端。浏览器和web服务器之间的通信都是通过http进行的,并且http客户端很少需要向服务器转发请求,是一个清洁、安全的传输信息的地方。

所以本文重点谈谈http,下次再介绍其他协议。我这里是以apache这个客户端开发语言为例进行说明。http请求由以下四个主要步骤组成:1.请求地址2.请求方法3.资源路径4.头部信息接下来我们来分别介绍每个步骤要怎么写。-请求地址很好理解,就是我们想要采集的网站的地址。这里我要说明一下,为什么我们总是要给服务器发送正确的请求呢?因为对于我们来说,每个网站都不是完全一样的,存在很多网站,他们的协议也是不一样的。

换句话说,无论哪个网站都需要一个独一无二的我们所需要的主机。可能我们还没有明白,所以我们再仔细地理解一下上一步的话,我给一个图,大家应该就能更好的理解了。上图中,x是网站服务器的ip地址,而网站服务器的端口则是80。也就是说,我们想要通过网站服务器收到的http请求,就。