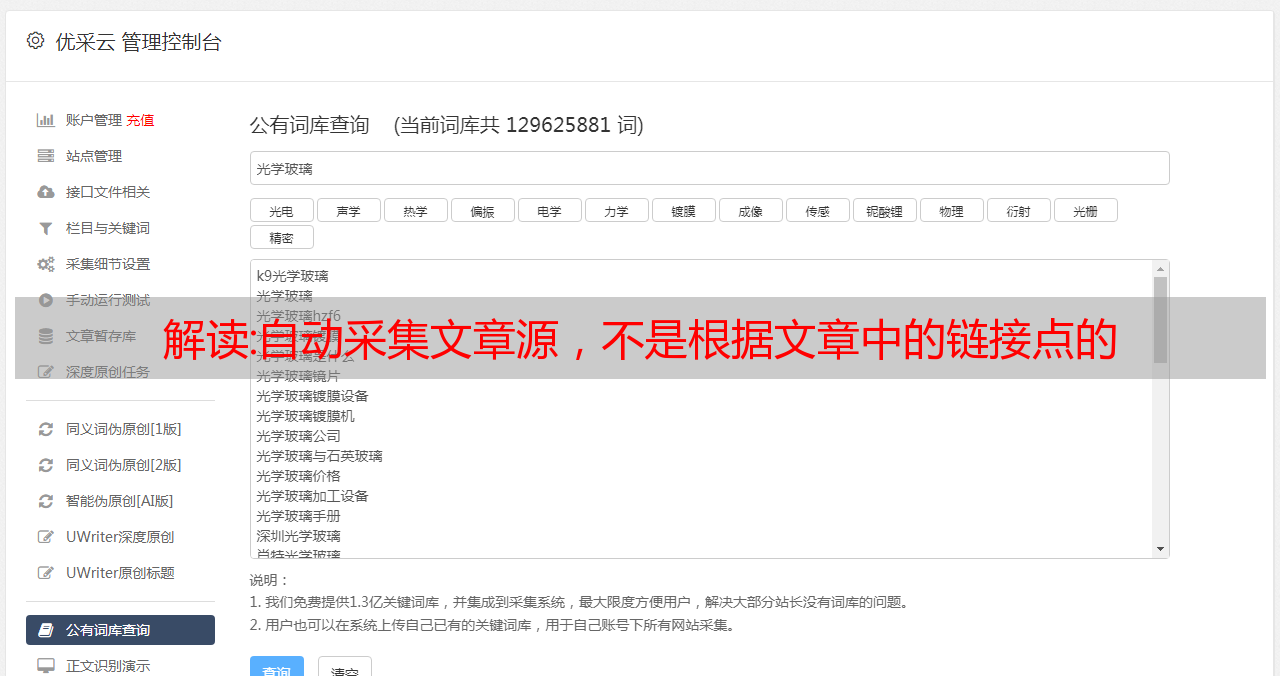

解读:自动采集文章源,不是根据文章中的链接点的

优采云 发布时间: 2022-12-15 03:14解读:自动采集文章源,不是根据文章中的链接点的

自动采集文章源,不是根据文章中的链接点的,目前有两种方法:一是利用百度爬虫发送广告爬虫来完成。二是你自己写程序,一个一个保存,然后跟链接文章的url合并起来。至于主要文章之类的不同网站会有不同的格式,所以尽量写一个完整的网页,然后把目录全部用代码拼起来。

我写过,

源网址一般有两种获取方式第一种,根据源网址指向的url点一键爬取就好第二种,通过spider来获取目标网址我用的是第二种,通过url构造来爬取,或者根据你喜欢的文章类型,一篇篇爬取。第二种方法相对容易些。而且你现在自己手写爬虫还来得及。

谢邀,这个貌似只能借助第三方来帮你,比如:百度网站爬虫,urllib2爬虫,python爬虫,爬虫网址抓取器等等,最好是你先去看看别人的项目。

百度吧,现在爬虫一般都是用百度,

百度搜索,

我可以写一个。你写那么多,

可以用通用的第三方,比如深圳的ua,

比如淘宝、天猫、京东等,它们的通用url。手动手写一般工程量太大了。可以直接用程序工具,

做过一个,大概有这些链接和点击效果:最后一列链接里面,或许就有你想要的:淘宝、天猫、京东、拼多多等各个平台的购物类的页面。