最新版:一键备份微博并导出生成PDF,顺便用Python分析微博账号数据

优采云 发布时间: 2022-12-14 22:24最新版:一键备份微博并导出生成PDF,顺便用Python分析微博账号数据

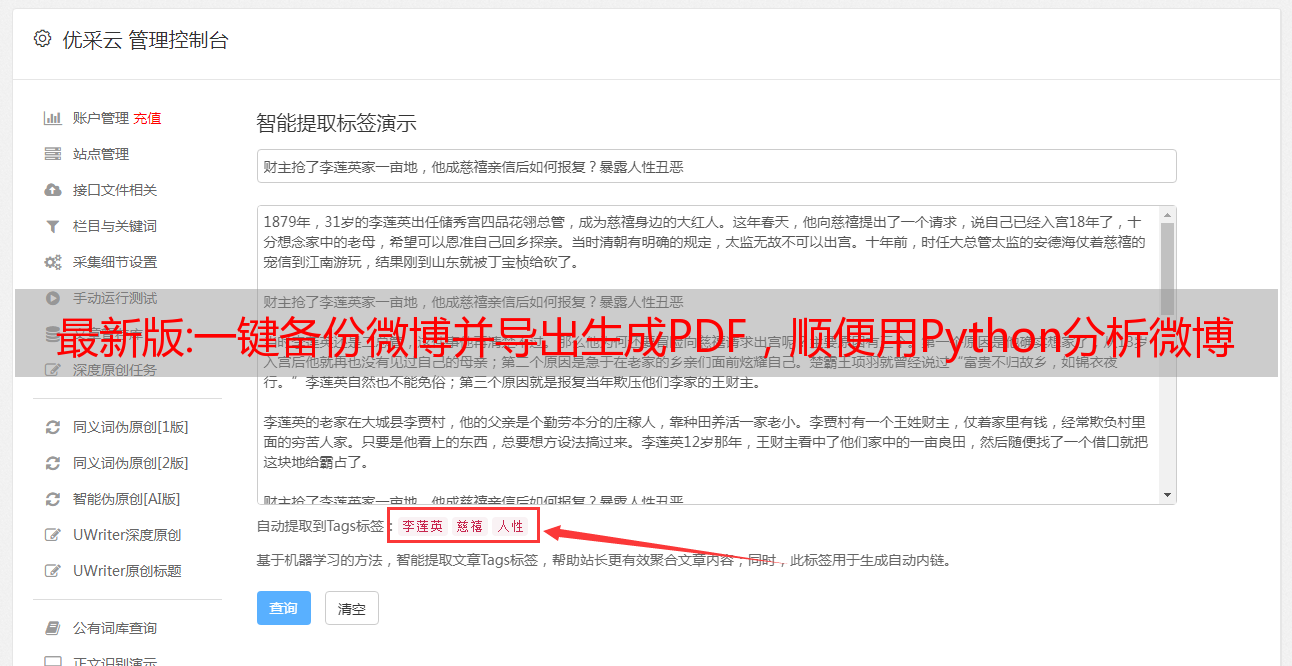

下面分享一下如何快速导出你所有的微博数据,然后用Python分析一个微博账号的数据,比如微博好评、转发、评论、微博词云、微博发布时间线、使用过的手机等.

稳定的部落

这是一款专业的微博记录备份导出工具。备份原理是登录后模拟浏览器访问,获取登录用户发布的所有微博并备份。博可以备份。

请参阅此工具的使用说明,它支持 Windows 和 Mac 版本。

打开软件后,登录自己的微博,在这里也可以浏览微博。

打开系统设置,一共可以看到2695条微博,269个页面,爬取了2个多小时。

设置排序规则,是否需要图片,PDF分辨率和时间范围。

支持增量备份, 备份过一次后, 可以只备份前10页内容, 加快备份速度

可在【管理数据】标签页中浏览已备份的微博记录列表

支持断点续传, 中途停止后, 可以记下备份的页码, 再次运行时修改【备份范围】配置项, 从该页之后再备份即可

32位操作系统下, 当pdf体积超过2GB后, 会提示文件已损坏. => 解决方案是更换64位操作系统, 或调整【时间范围】/【自动分卷】配置项, 通过限定单本pdf容量, 手工将pdf体积控制在2GB之内

利用【开发者模式】配置项, 可以极大加快微博备份速度。

复制

点击开始备份,可以看到运行日志。

2020-05-26 19:56:44.780: [FetchCustomer] 本次抓取的页码范围为:0~10

2020-05-26 19:56:44.824: [FetchCustomer] 准备抓取第1/271页微博记录

2020-05-26 19:56:45.275: [FetchCustomer] 第1/271页微博记录抓取成功, 准备存入数据库

2020-05-26 19:56:45.967: [FetchCustomer] 第1/271页微博记录成功存入数据库

2020-05-26 19:56:45.968: [FetchCustomer] 已抓取1/271页记录, 休眠20s, 避免被封

2020-05-26 19:57:05.970: [FetchCustomer] 准备抓取第2/271页微博记录

2020-05-26 19:57:06.310: [FetchCustomer] 第2/271页微博记录抓取成功, 准备存入数据库

2020-05-26 19:57:07.039: [FetchCustomer] 第2/271页微博记录成功存入数据库

2020-05-26 19:57:07.040: [FetchCustomer] 已抓取2/271页记录, 休眠20s, 避免被封

<p>

2020-05-26 19:57:27.041: [FetchCustomer] 准备抓取第3/271页微博记录</p>

复制

开始下载图片。

执行后,你的微博电子书就在本地生成了。

生成的目录下有源文件和PDF。

打开里面的HTML文件,备份的微博是按月分类的。

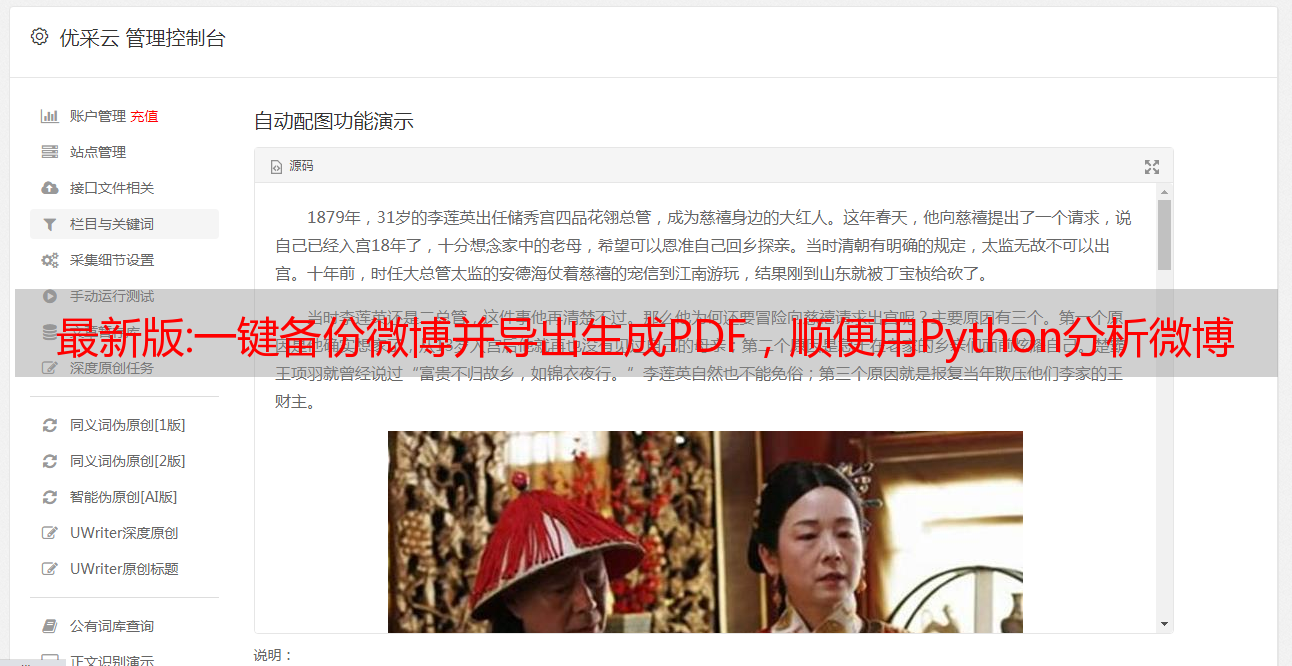

看看2019年4月7日的这条微博,所有图片都下载到本地了。

生成的PDF文件将近30MB,不算大。

本工具只能备份自己的微博数据。如果你想备份别人的数据,可以使用下面的Python脚本。它还可以分析某个微博账号的数据。

Python备份与分析微博

这是一个开源项目,使用方法很简单,先登录微博复制你的cookie,然后修改配置文件,然后执行脚本,看我的操作过程。

打开并登录你的微博账号,获取headers cookie,也就是箭头中的一长串字符。

在本地下载代码,因为在国外网站下载会比较慢,可以在公众号回复微博获取。

然后修改配置文件config.json。这里user_id_list填写你要分析的微博账号的uid。可以填写多个。这里填上我最喜欢的歌手李健。如果filter为1,表示分析原创微博。如果要分析所有的微博,就填0。since_date是微博开始分析的日期,然后把上面复制的cookie填到相应的位置。

{

"user_id_list": ["1744395855"],

"filter": 1,

"since_date": "2015-01-01",

"write_mode": ["csv", "txt"],

"pic_download": 1,

"video_download": 1,

"cookie": "xxx",

"mysql_config": {

"host": "localhost",

"port": 3306,

"user": "root",

"password": "123456",

"charset": "utf8mb4"

<p>

}

}</p>

复制

然后执行pip install -r requirements.txt 安装如下依赖包。

requests==2.22.0

jieba==0.42.1

wordcloud==1.6.0

scipy==1.2.1

seaborn==0.10.0

pandas

lxml

tqdm

复制

当然你也可以单独安装pip --trusted-host install -U tqdm -i

scipy需要安装指定版本 pip --trusted-host install scipy==1.2.1 -i

以上配置完成后,开始执行脚本python weibospider.py。我在Windows下使用的是Python3.7,可能和笔者环境不一样,遇到了一些问题。

如果出现错误 SSLError(SSLCertVerificationError(1, '[SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed),更改文件 weibospider.py 中的 requests 参数。

html = requests.get(url, cookies=self.cookie,verify=False).content

需要注意的是,如果提示cookie错误或已过期,请刷新并复制cookie填写配置文件。

如果没有问题,可以看到脚本已经开始执行了。

抓拍后生成了李健的微博词云图。他的微博关键词是音乐、北京、朋友、歌手、电影,甚至还提到了周杰伦。

从每月转发的总评论和点赞数来看,2016-2018年的微博数据是高峰期。

原创微博与转发微博的数据比。

李健发微博使用的工具主要是PC网页和iPad。

生成的目录还收录所有微博图片、视频、txt文件和excel数据。

原创微博转发最多的是2015年宣传片《太平轮》的主题曲爱天意也不过2万多,有些流量明星转发几百万确实不行相比之下,毕竟有不少海军部队。

下图是李健转发次数最多的20条微博,平均转发和评论不到1万,点赞数上万。

ps:如果你想分析某个微博账号,又不会用Python,联系我,我教你包会,当然我也可以直接给你数据。

官方数据:Google网站流量统计

Google Analytics 网站 流量统计分析:

谷歌分析简介:

Google Analytics功能(Google Analytics很强大,这里介绍一些与SEO相关的点):

1.加载解析代码对网页速度影响不大。

2.详细的流量来源数据分析,包括:直接点击、搜索引擎、推荐、Adword、其他等。

3、各关键词的流量数据分析,包括:当天的搜索量、一定时间段内的搜索流量趋势、流量的区域分布、各搜索引擎的相关关键词、跳出率。

4. 提供促销来源的链接网站。

5、提供各页面的浏览量。

6、分析用户在网站的平均停留时间、新访比例、用户图谱分布、电商转化率。

7.分析用户客户端。

8.多个用户(不同账户)可以一起查看分析数据。

Google Analytics 的注册和使用:

1. 访问。

2. 输入谷歌账号的邮箱和密码直接登录。如果没有 Google 帐户,请注册创建一个。

3. 注册时,记得在下拉列表中选择 或 ,然后输入您的网址。在“帐户名称”字段中输入帐户的别名,然后单击“继续”以输入联系信息。

4.同意服务条款,提交注册,完成。