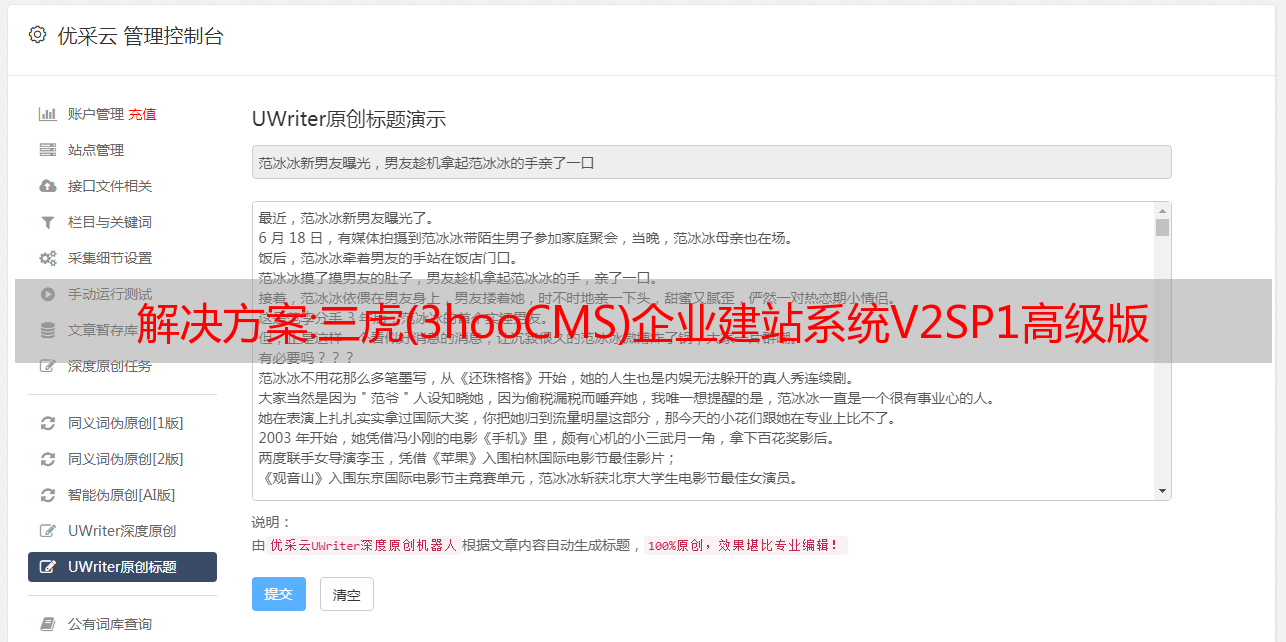

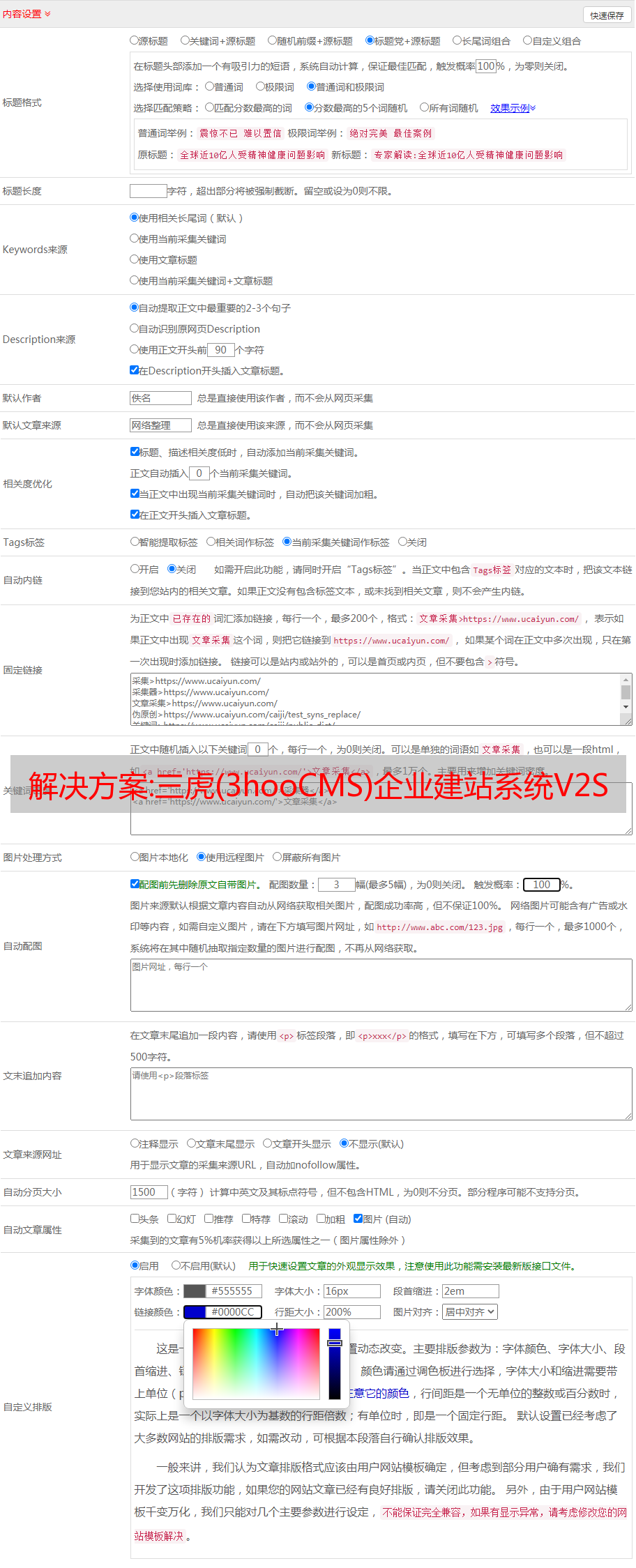

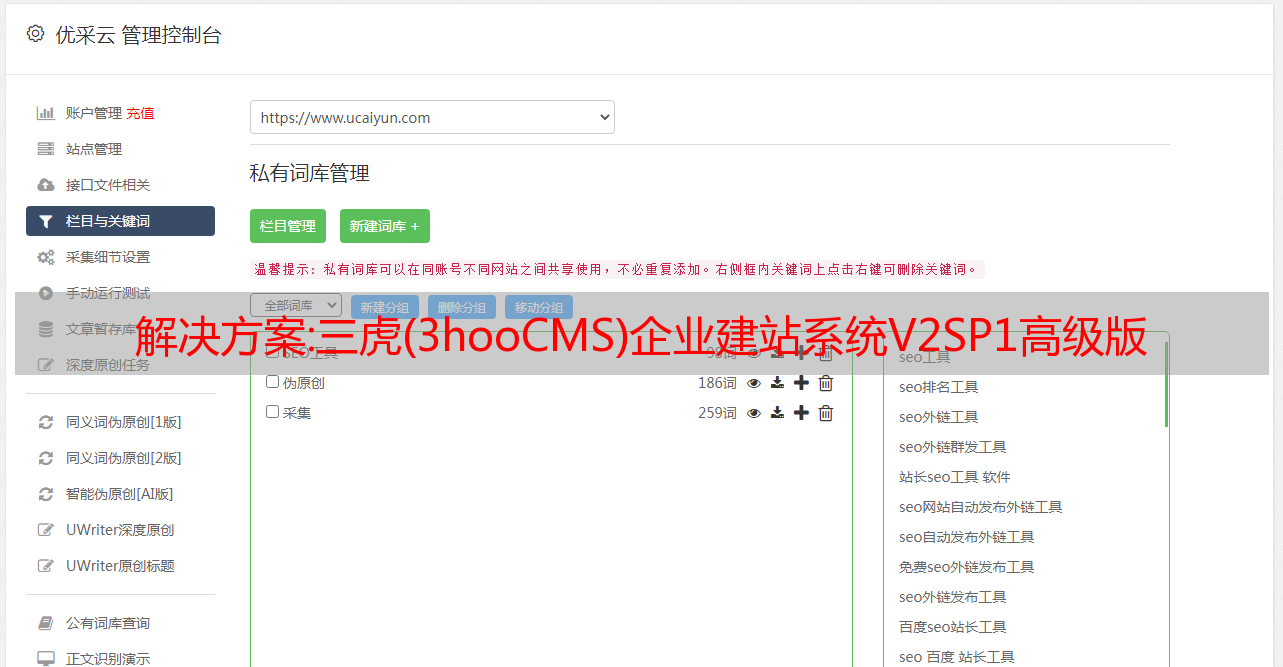

解决方案:三虎(3hooCMS)企业建站系统V2SP1高级版

优采云 发布时间: 2022-12-07 23:39解决方案:三虎(3hooCMS)企业建站系统V2SP1高级版

三虎企业网站内容管理系统(3hoocms)是三虎网络科技针对中国中小企业国情定制开发的适合企业建站的系统。其主要目的是为中小企业建站提供一个方便的后台管理程序。

本系统借鉴了众多成功的企业建站产品的功能和数据模型。历时一年开发,基本可以满足大部分企业的建站需求,也对一些特定行业进行了完善。全站全局防SQL注入,安全性能高。模板编辑首页,引入先进的MVC设计理念。

目前已有上百家企业成功使用三虎建站系统,搭建出令他们满意的网站。

预防措施:

该版本的后台界面(UI)完全重写,界面更加美观。

后台使用了CSS滑门技术,请注意上面的滑门选项标签。一些管理字段可能在另一页上。

帮助系统已集成。每个管理或提交页面的最后一个选项卡是帮助。如果您对操作有任何疑问,可以先阅读说明。

对于网页设计师,我们提供了详细的模板标签库和帮助说明。所有的帮助都集成在后台,你不需要打开任何网址。

关于授权,本系统授权所有用户免费使用(包括商业用户),但不允许修改源代码或部分修改以出售源代码或发布源代码牟利!

本系统高级版需要ASPJPEG和ASPUPLAD组件的支持,全功能版需要ISPA_RE伪静态组件!

解决方案:如何基于深度学习实现图像的智能审核

背景

美团每天产生数百万张图片,运营人员负责审核相关图片内容,删除涉及法律风险、不符合平台规定的图片。由于图片数量庞大,人工审核费时费力,审核能力有限。另外,对于不同的审稿人,审稿标准很难统一,实时变化。因此,有必要借助机器来实现智能审计。

图像智能审核一般是指利用图像处理和机器学习相关技术,对图像内容进行识别,进而识别图像是否违规。图片智能审核旨在建立自动图片审核服务。机器自动禁止不符合规定的图片类型(反例),自动批准符合规定的图片类型(正例),机器不确定的图片交给人工审核。因此,衡量智能审计系统性能的指标主要是准确性和自动化程度。

通常的自动审核思路是穷举不符合规定的图片类型(如水印图片、*敏*感*词*图片、暴力图片、明星脸、广告图片等),剩下的图片会作为自动通过积极的例子。由此带来的问题是新增非法内容的可扩展性不足。另外,它必须等到所有的模型都建好之后,才能起到自动过滤的作用。如果我们能主动挖掘出符合要求的图片(比如正常人物图片和场景一致图片)自动通过,结合正例过滤和负例过滤,就可以更快的省去人工审核。所以,我们的图片智能审核系统分为图片负例过滤模块和图片正例过滤模块。待处理的图片先进入反例过滤模块判断是否禁止,然后进入正例过滤模块自动通过。其余机器不确定 图片需人工审核。整个技术方案如图1所示。

图1 图片智能审核技术方案

负例过滤和正例过滤模块会涉及到检测、分类和识别等技术,而深度学习是该领域的首选技术。下面将介绍深度学习在水印过滤、名人人脸识别、*敏*感*词*图片检测和场景分类等智能图片审核中的应用。

基于深度学习的水印检测

为了保护版权和支持原创内容,需要自动检测商家或用户上传的图片是否收录禁止水印(竞品水印、其他产品的logo)。与其他刚体对象不同,水印具有以下特点。

图2 主题变化

图 3 复杂背景

传统的水印检测采用滑动窗口的方法提取固定大小的图像块,并将其输入到预训练的识别模型中,得到该块的类别。这样就可以遍历图片中的所有候选位置,得到一张图片密集的类别得分图。得分高于某个阈值的块被认为是水印候选区域,可以通过非最大化抑制得到最终结果。识别模型的特征可以使用文本识别领域常用的边缘方向统计特征,或者通过CNN进行特征学习,提高对裁剪、变形、复杂背景的鲁棒性。为了进一步提高分数的置信度,可以加入类型原型的信息,输入图像块特征与聚类中心特征的相似度(夹角的余弦值)可以作为识别置信度。但是,上述方法的检测效率极低。由于水印的位置和大小不固定,需要在所有位置区分多尺度的图像,从而产生大量的冗余窗口。

一种思路是减少滑动窗口方法的子窗口数量。首先,通过无监督/监督学习生成一系列候选区域,然后使用 CNN 分类器来确定该区域是否收录目标以及它是什么类型的目标。这类方法比较有代表性的是R-CNN系列。由于这类方法得到的候选框可以映射到原创图像的分辨率,所以定位框的精度足够高。

另一种解决方案是直接在特征图上使用回归的方法。我们知道,对于CNN网络的卷积层来说,输入图像的尺寸可能不是固定的,但是从全连接层要求输入尺寸是一致的。因此,当一张任意大小的图片输入到CNN,直到第一个全连接层时,只需要一次前向操作就可以得到所有层的特征图。那么回归的对象就是待检测目标的位置信息和类别信息。它们可以根据目标大小的需要在不同层次的特征图上进行回归。这类方法以Yolo和SSD为代表。这类方法的特点是在保证检测精度高的前提下,实时性较好。

图 4 给出了上述两类框架与 DPM(可变形部件模型)传统最佳方法的性能比较:

图4 基于深度学习的主流目标检测方法性能评价

考虑到水印检测任务对定位框的精度要求不高,需要满足每天百万张图片的吞吐量,我们借鉴了SSD框架和Resnet网络结构。在训练数据方面,我们人工采集了25类共计15000张带水印图像,通过随机裁剪被摄体和合成前景背景进行数据增强。

基于训练好的模型,对在线数据进行了相关测试。随机选取3197张在线图片作为测试集,其中2795张图片不收录水印,402张收录水印的图片中302张收录训练集中出现过的水印,另外100张收录训练集中没有出现过的小生境水印。基于这个测试集,我们对传统方法(人工设计的特征+滑动窗口识别)和基于SSD框架的方法进行了评估。

从图5可以看出,与传统方法相比,SSD框架在召回率和查准率方*敏*感*词*有明显优势。进一步分析发现,深度学习方法召回了38张小众水印图像,说明CNN学习到的特征泛化能力更强。

图5 水印检测性能评估

名人人脸识别

为避免侵犯明星肖像权,审核场景需要识别用户/商户上传的图片是否收录明星肖像。这是一个典型的人脸识别应用,具体是1:(N+1)人脸比对。整个人脸识别过程包括人脸检测、人脸关键点检测、人脸校正和归一化、人脸特征提取和特征比对,如图6所示。深度卷积模型是要训练的识别模型进行特征提取。下面我们将分别介绍人脸检测和人脸识别技术方案。

图6 名人人脸识别流程

人脸检测

人脸检测方法可以分为两类:传统检测器和基于深度学习的检测器。

传统检测器主要基于VJ框架,通过设计Boosted级联结构和人工特征来实现检测。特征包括Harr特征、HOG特征、基于像素点比较的特征(Pico、NPD)等。该类检测器在受限环境下具有较好的检测效果和运行速度,但对于复杂场景(光照、表情、遮挡) ),人为设计的特征会大大降低检测能力。为了提高性能,相关研究将人脸检测和人脸关键点定位两个任务结合起来进行联合优化(JDA),将关键点检测作为人脸检测的重要评价标准,但其准确率有待提高进一步改善。

深度学习检测器有三种想法。第一类是使用VJ框架,但用级联CNN网络(Cascaded CNN)代替传统特征。第二类是基于region proposal和bounding box regression的框架(比如Faster R-CNN)。第三类是基于全卷积网络直接回归的框架(如DenseBox)。

我们采用了Faster R-CNN框架,并从以下几个方面对其进行改进:高难度反例挖掘(抑制雕像、人像、动物头等反例)、多层特征融合、多尺度训练与测试、上下文信息融合,这样就可以更好地抵抗复杂背景、类人脸、遮挡等干扰,有效提高小人脸和侧脸的检测率。

人脸识别

人脸识别有两种主要方法。一种是直接转换为图像分类任务。每个类别对应一个人的多张照片。比较有代表性的方法有DeepFace、DeepID等。另一种是将识别转化为度量学习问题。通过特征学习,同一个人的不同照片距离比较近,不同人的照片距离较远。比较有代表性的方法有DeepID2、FaceNet等。

由于任务中待识别的ID是一个半封闭集,我们可以结合图像分类和度量学习的思想进行模型训练。考虑到triplet loss(Triplet Loss)对负例挖掘算法要求高,实际训练中收敛很慢,我们使用Center Loss来最小化类内方差,同时结合Softmax Loss来最大化类间方差。为了平衡这两个损失函数,需要通过实验选择超参数。我们使用的网络结构是Inception-v3,在实际训练中分为两个阶段:第一阶段使用Softmax Loss+C×CenterLoss,使用公开数据集CASIA-WebFace(共包括10 575个ID和490个, 000人脸图片)初始化网络参数,优化超参数C。根据实验,C=0.01;第二阶段使用Softmax Loss+0.01×Center Loss,业务数据(5200张明星人脸ID和100万人脸图像网络参数微调)。

为了进一步提升性能,借鉴了百度采用的多模型融合策略,如图7所示。具体来说,根据人脸关键点的位置将人脸区域划分为多个区域,以及为每个区域训练一个特征模型。目前人脸区域分为9个区域,加上人脸整体区域,一共需要训练10个模型。

图7 基于集成学习的人脸识别

在测试阶段,针对待验证人脸区域和候选人脸区域,基于图7所示的10个区域提取特征。然后对每个区域,计算两个特征向量之间的相似度(余弦距离)。最后通过相似度加权的方法判断两张人脸是否属于同一个人。表 1 显示了主流方法在 LFW 数据集上的评估结果。可以看出,美团模型在相对有限的数据下取得了较高的准确率。

表1 公开数据集评估结果

*敏*感*词*图片检测

*敏*感*词*图片检测是图片智能审核的重要组成部分。传统的检测方法通过肤色、姿势等维度来识别图片的合规性。随着深度学习的发展,现有技术【Yahoo NSFW(Not Suited for Work)模型】直接定义*敏*感*词*图片检测的二分类(*敏*感*词*,正常)问题,通过海量数据进行端到端的训练卷积神经网络。.

对于训练好的模型,不同的层次学习不同的特征。有的level学习肤色特征,有的level学习局部轮廓特征,有的level学习姿势特征。但是,由于人类对*敏*感*词*的定义非常宽泛,露点、性暗示、艺术等都可能被归类为*敏*感*词*,而且在不同的场景或面对不同的人群时,*敏*感*词*的定义无法统一。因此,最初学习的模型泛化能力有限。为了提高机器的预测精度,需要不断地加入错误分类的样本,让机器通过增量学习来学习更多的特征来纠正错误。此外,我们还优化了以下几个方面。

表2 *敏*感*词*图片检测准确率

场景分类

作为一个贯穿吃喝玩乐各个环节的互联网平台,美团的业务涉及多个垂直领域,如表3所示,需要对运营的类别或用户上传的图片进行识别,以保持一致商家的经营范围。另外,为了进一步提高显示效果,还需要对业务相册中的图片进行分类,如图3所示。8.

表3 美团点评一级品类及图片占比

图8 商务相册图片分类

深度卷积神经网络在图像分类相关任务(如ILSVRC)中已经超越了人眼的识别率,但作为典型的监督学习方法,其在特定领域对标记样本的数量和质量要求突出. 的。对于我们的场景分类任务,如果完全依赖reviewer来筛选清洗图片,成本会比较高。因此,有必要对基于迁移学习的模型进行微调。

迁移学习旨在通过维护和利用从一个或多个相似任务、领域或概率分布中学到的知识,快速有效地提高目标任务的性能。模型迁移是迁移学习领域常用的迁移方法。它通过学习原域(Source Domain)模型和目标域(Target Domain)模型的共享参数来实现迁移。深度神经网络因其层次结构和隐藏层表示抽象和不变特征的能力而非常适合模型迁移。

对于在原域训练的深度卷积神经网络,需要注意哪些层参数可以传递,如何传递。不同层级具有不同程度的可迁移性,目标领域与原领域相似度越高的层级越有可能被迁移。具体来说,较浅的卷积层学习到的特征更通用(如图像颜色、边缘、基本纹理),因而更适合迁移,而较深的卷积层学习到的特征更具有任务依赖性(如图像细节) ,因此不适合迁移,如图9所示。

图9 深度卷积神经网络层次结构及特征描述

模型传输通过固定网络特定层的参数,使用来自目标域的数据来训练其他层。对于我们的场景分类任务,我们首先根据分类类别的数量修改网络输出层,然后固定较浅的卷积层并根据业务标记数据训练网络最后几层的参数。如果有更多的训练数据可用,则可以进一步微调整个网络的参数以获得额外的性能提升,如图 10 所示。与直接提取图像的高级语义特征进行监督学习相比,采用阶段式参数传递对原创域和目标域之间的差异更具鲁棒性。

图10 基于深度卷积神经网络的模型迁移

基于上述迁移学习策略,我们在食物场景图和酒店房间图的分类上进行了相关实验。基于有限的(10,000级图像)标记样本,实现了较高的识别准确率。在测试集上的表现如表4所示。

表 4 美食场景分类

如前所述,基于深度学习的图像分类检测方法在智能图片审核中已经取代了传统的机器学习方法。在公共模型和迁移学习的基础上,通过对海量数据的不断学习,实现了业务场景的落地。.

参考

[1] H. Chen、SS Tsai、G. Schroth、DM Chen、R. Grzeszczuk 和 B. Girod。“在具有边缘增强的最大稳定极值区域的自然图像中进行稳健的文本检测。” ICIP 2011。

[2] Z Zhong, LJin, SZhang, ZFeng. “DeepText:自然图像中文本提议生成和文本检测的统一框架”。建筑科学2015。

[3] 廖明辉, 石宝光, 白向, 王兴刚, 刘文宇. “文本框:具有单个深度神经网络的快速文本检测器”。美国人工智能协会 2017 年。

[4] S. Ren、K. He、R. Girshick 和 J. Sun。更快的 r-cnn。“使用区域提议网络实现实时目标检测。” 国家知识产权局 2015 年。

[5] 格雷夫斯,A.;费尔南德斯,S。戈麦斯,F.;和 Schmidhuber, J. “连接主义时间分类:用递归神经网络标记未分段的序列数据。” ICML 2006。

[6] R Girshick、JDonahue、TDarrell、JMalik。“用于准确对象检测和语义分割的丰富特征层次结构。” CVPR 2014。

[7] J. Redmon、S. Divvala、R. Girshick 和 A. Farhadi。“你只看一次:统一的实时对象检测”。CVPR 2016。

[8] W. Liu、D. Anguelov、D. Erhan、C. Szegedy 和 S. Reed。“SSD:单发多盒检测器”。ECCV 2016。

[9]“使用经过区分训练的基于部件的模型进行对象检测”。TPAMI 2010。

[10] 鲁棒的实时对象检测。保罗维奥拉,迈克尔琼斯。国际联合会 2004 年。

[11] N. Markus、M. Frljak、IS Pandzic、J. Ahlberg 和 R. Forchheimer。“在决策树中组织像素强度比较的对象检测”。CORR 2014。

[12] 廖胜才、Anil K. Jain 和 Stan Z. Li。“快速准确的无约束人脸检测器”,TPAMI 2015。

[13]陈东,邵庆任,孙健.“联合级联人脸检测和对齐”,ECCV 2014。

[14] 李浩翔, 林哲, 沉晓慧, Jonathan Brandt, 华刚. “用于人脸检测的卷积神经网络级联”,CVPR.2015。

[15]黄力超, 杨怡, 邓亚峰, 于一楠. “DenseBox:通过端到端对象检测统一地标定位”CVPR 2015。

[16] Taigman Y、Yang M、Ranzato MA 等。Deepface:缩小人脸验证中与人类水平性能的差距。CVPR 2014。

[17]Sun Y, Wang X, Tang X. 从预测 10,000 个类中深度学习人脸表征。CVPR 2014。

[18]孙毅,陈毅,王旭,等.通过联合识别-验证的深度学习人脸表示。NIPS。2014.

[19]FaceNet:人脸识别和聚类的统一嵌入。CVPR 2015。

[20] 一种用于深度人脸识别的判别特征学习方法。ECCV 2016。

[21] 重新思考计算机视觉的初始架构。CVPR 2016。

[22]Alex Krizhevsky、Ilya Sutskever、Geoffrey E. Hinton。“使用深度卷积神经网络的 ImageNet 分类”。2014.

[23] Murray, N., Marchesotti, L., Perronnin, F.“Ava:用于美学视觉分析的大型数据库”。CVPR 2012。