官方数据:国际站-如何统计6个月内的TM询盘数据和对应国家占比呢?(进阶版)

优采云 发布时间: 2022-12-07 08:38官方数据:国际站-如何统计6个月内的TM询盘数据和对应国家占比呢?(进阶版)

大家好。我是喜欢交朋友的Sky。

“我经常看到一些小伙伴说阿里后台的TM数据有点膨胀,认为这个数据参考价值不大。但是在做数据报表的时候,需要计算准确的TM数,所以有有点苦恼和困惑,那今天就给大家带来一个TM查询数据一个月内(去重)的统计方法和对应的查询类型,话不多说,直接开始吧。

上面提到的情况在我上一个公众号里已经有了答案,没看过的朋友可以看看。这一次,我要说的是上次的进阶版。我将分享如何统计6个月内特定月份的TM查询数据和对应国家的比例。订单率和 TM 询价到订单的转化率。

最终的大概效果如下:

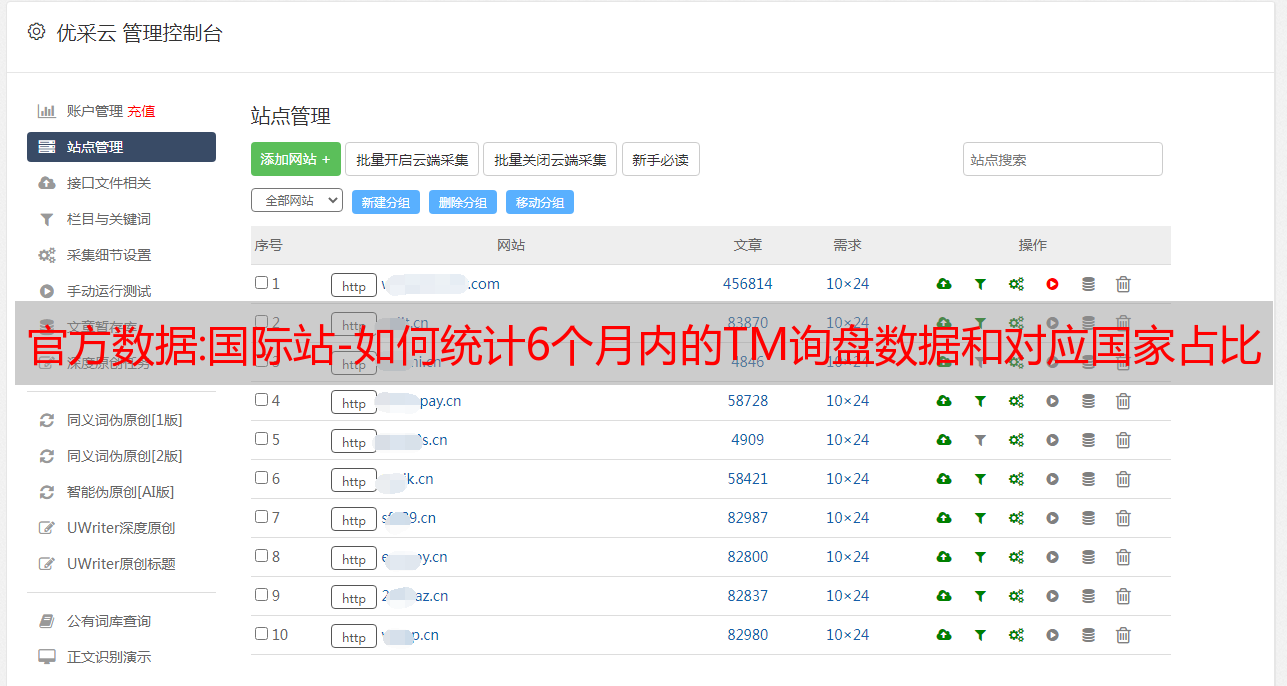

之前的方法是使用优采云采集器采集过去30天的TM查询数据,然后对查询和TM进行量化和类型分析。优点:使用起来比较简单快捷。缺点:TM查询的查询时间只能将近30天,同时无法看到TM查询对应的国家数量和比例,所以今天带来了进阶版,时间可以选择日期之后的采集查询近6个月的数据,数据比较全面。

你怎么看?如果你也准备尝试一把小刀,那就开始吧!

第 1 步:寻找可以抓取六个月数据的渠道

用于抓取近30天数据的URL:

#feedback/assignLog

因为上面的url只能抓到将近一个月的数据,后来去查看该url运行时网络中的爬取请求,发现了另外一个url,也是一个隐藏url。

这个 URL 正好适合 采集 过去 6 个月的数据。

#/

第二步:下载数据采集插件并抓取

之前优采云采集器有朋友跟我说用起来不方便,所以这次给大家介绍一个新的数据采集插件,叫做Instant Data Scraper。本插件可在浏览器中安装使用,安全免费。

这是下载地址(记得用科学上网工具打开)

下载插件后,打开刚才你要采集数据的网址,选择你要的时间段采集(我选的是10月份的数据),准备好采集数据. 首先点击浏览器插件中的精灵球按钮,点击try anothertable,直到*敏*感*词*区域覆盖我们想要的数据列采集。

然后点击Locate Next按钮后,选择图片中的按钮作为下一个跳转操作。

步骤设置好后,点击开始按钮开始抓取数据,浏览器插件会自动开始抓取数据。大约几分钟后,将捕获数据。点击下载表格按钮,下载刚才的数据。

第三步:去重表数据

打开数据表,修改表列标题方便查看,开始去除重复数据

① 删除分配类型栏,删除人工分配和客户优先分配栏

②选择邮箱栏,删除国内邮箱包括qq、126、163等。

③ 选择邮箱栏,进行筛选。多次出现的同一个邮箱可以删除,直到只剩下一个邮箱

完成以上3步后,表中的数据基本没有旧查询和旧TM了。

第四步:对TM查询进行数据统计和类型分析

如果你在这里,恭喜你

,这时候你可以用CTRL+F从表格中搜索TM新闻和询价,区分TM和询价,并统计相应的数据,足够你写日报、周报和月报了。

当然,如果你也对询盘的来源和占比感到好奇,我们也可以在表格中找到答案。同样使用CTRL+F搜索以下词

TM消息-来自XXX(表示本次咨询是TM)

Inquiry from(表示本次询价为询价)

商品详情页询盘(表示本次询盘为访问商品后发送的询盘)

商城首页询盘(表示本次询盘为访问商城首页后发送的询盘)

Inquiry from Search List(表示该询盘是从搜索列表发出的询盘)

Favorite Product Page Inquiry from Favorite Product Page(表示本次询价为商品采集页询价)

Inquiry from Order page(表示本次询盘为订单页面发送的询盘)

来自促销页面的询价(表示此询价是在促销页面发送的询价)

同样的,你也会得到各种查询的数量,从而计算出他们的占比。

第五步:将Pokeball抓取的TM查询数据与阿里员工分析表进行匹配

因为刚才采集的数据中没有TM查询对应的国家的数据,所以这时候我们需要用另外一张表进行联动,就是阿里里面的员工分析表。

这个表格也有单位时间内店铺的TM查询数据,但是相比之前的表格,这个表格多了TM查询对应的国家,响应时间等数据。

网址在这里:

这里我们需要下载表格。这里我也选择了10月份的数据。

眼尖的小伙伴已经猜到,会员ID一栏的前两位数字代表的是TM/询价对应国家的简称。至此,接下来我们遇到的问题就是如何将我们之前去重后的TM查询数据与员工数据表中的数据进行匹配。

别着急,看我操作。

首先,员工分析表中的TM查询数据也进行了去重。您可以使用会员ID过滤重复项,将多次出现的同一ID行删除为仅一行。

其次,因为两个表都有相同的项,那就是TM查询的发送名称。

利用这一点,我们可以利用WPS的标记重复数据的功能,在阿里员工分析表中标记去重的TM查询数据,提取标记的查询数据。

接下来就是对发送方的会员ID(客户ID)进行分类,得到客户对应国家的简称。

第六步:匹配分析对应国家的阿里分析表中的TM查询

看到这里,你有什么想法吗?你一定会知道国家数量的统计数据。但是我们如何转换两个字母的国家/地区缩写呢?

哈哈,万万没想到,答案在这里:找到每个国家缩写对应的国家名称,做一个表(如图),用vlookup函数进行匹配。

ps 各个国家的名字表是我自己做的。有需要的请加我,私发给你。还有如果可以去百度一下Vlookup功能的使用方法,不会的也可以问我。

看到这里,如何去采集TM查询数据,并匹配对应的查询类型和国家。想必大家都已经知道了,效果大概就是如图所示。

第七步:添加查询国家的换算率

如果你是金商,也可以去采集查看访客画像中每个国家的访客数,然后使用Vlookup功能匹配数据,添加访客数这一栏在刚才不在表中的每个国家。

经过这一步,我们可以得到如下表格,其中收录了每个国家的访问量、去重后的TM查询量、TM查询率、TM和各类查询的占比。

如果你想让表格更丰富,也可以去数据顾问-访客画像-贸易买家(黄金产品专属,如果你是出口通的合作伙伴,可以去我的订单使用精灵球采集看贸易国,结果一样),使用采集插件计算采集每个国家的贸易买家数,并添加到表中。

然后我们可以计算出国家/买家总数,每个国家的买家比例,国家/买家TM询价转化率,国家/买家TM询盘转化率。数据。.

最后扑通扑通~一张涵盖了各国最重要的TM询价率和TM询价订单转化率的表格。

如何使用这些数据?

这里最重要的是询价率和订单转化率。朋友们可以把这两个率比较高的国家标出来。之后,在直通车推广过程中,针对这部分地区进行针对性推广。这样,在同样的预算下,可以更有效的提升店铺的询盘量和订单量。

最后需要提醒大家的是,直通车的区域定向推广功能已经对直通车等级L3的商户开放。所以,如果你是L3,看完文章记得去直通车后台调整推广国家。同时,L4商户也全面开放L3+买家溢价。如果你想获得更多的大用户,别忘了给这个标签加点溢价。

好了,今天的分享就到这里了,希望这篇文章对您有所帮助。我是国际站运营商Sky,一起交个朋友,欢迎加我领取表格。另外,对运营感兴趣的朋友也可以进群与其他朋友交流。

直观:Python 三国人物数据快速采集极简方法汇总

作为数据分析师而不是开发工程师,你需要掌握爬虫的必要知识,获取所需的数据。如果您需要更多基于爬虫工程师的专业内容,请浏览“Scrapy爬虫框架”版块。

以最基础的《三国志13》人物数据采集为例,了解和掌握基本的爬虫技能和数据组织技能。

整套自学教程用到的资料都是《三国志》和《真三国无双》系列游戏的内容。

数据对象

武将名单-三国之恋百科全书

我们想得到这个页面的所有通用数据信息。

爬虫请求的几种基本用法

"""例"""

from urllib import request

response = request.urlopen(r'https://sangokushi13wiki.wiki.fc2.com/wiki/%E6%AD%A6%E5%B0%86%E4%B8%80%E8%A6%A7')

#返回状态 200证明访问成功

print("返回状态码: "+str(response.status))

返回状态码: 200

请求静态页面数据获取

静态网页的URL形式通常以.htm、.html、.shtml、.xml等为后缀,一般来说就是最简单的HTML网页,服务端和客户端是一样的。HTML格式的网页也可以出现各种动态效果,如GIF格式的*敏*感*词*、FLASH、滚动的字母等,这些动态效果只是视觉上的。

我们本地抓取的目标是静态页面。

使用request()包装请求,然后通过urlopen()获取页面,俗称伪装。让服务器知道我们是通过浏览器访问页面的,在某些情况下可能会直接杀掉。

# 加载第三方使用插件和基础配置

import requests

from bs4 import BeautifulSoup

import pandas as pd

import random

import warnings

warnings.filterwarnings("ignore")

# 浏览器 header

USER_AGENT_LIST = [

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 (KHTML, like Gecko) Chrome/22.0.1207.1 Safari/537.1",

"Mozilla/5.0 (X11; CrOS i686 2268.111.0) AppleWebKit/536.11 (KHTML, like Gecko) Chrome/20.0.1132.57 Safari/536.11",

<p>

]

# 使用本地代理 可以使用也可以不使用

proxies = {

"http": "http://127.0.0.1:19180",

"https": "https://127.0.0.1:19180"

}

headers = {

"User-Agent":random.choice(USER_AGENT_LIST),

}

# https://sangokushi13wiki.wiki.fc2.com/wiki/武将一覧

url = "https://sangokushi13wiki.wiki.fc2.com/wiki/%E6%AD%A6%E5%B0%86%E4%B8%80%E8%A6%A7"

html = requests.get(url,headers=headers,proxies=proxies,verify=False)

soup = BeautifulSoup(html.text,"lxml")

soup

</p>

请求动态页面数据获取

动态网页的后缀形式有.asp、.jsp、.php、.perl、.cgi等。动态网页与网页上的各种*敏*感*词*、滚动字幕等视觉动态效果没有直接关系。动态网页还可以收录纯文本内容或收录各种*敏*感*词*的内容。这些只是网页具体内容的表现形式。,不管网页是否有动态效果,使用动态网站技术生成的网页都称为动态网页。动态网站也可以采用动静结合的原则。使用动态网页的地方适合使用动态网页。如果需要静态网页,可以考虑使用静态网页。在网上,

import requests

from bs4 import BeautifulSoup

url = "http://news.cqcoal.com/blank/nl.jsp?tid=238"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

soup.text

如果爬取该网页时看不到任何信息,则证明这是一个动态网页。正确的爬取方法如下。

import urllib

import urllib.request

import requests

url = "http://news.cqcoal.com/manage/newsaction.do?method:webListPageNewsArchivesByTypeid"

post_param = {'pageNum':'1',\

'pageSize':'20',\

'jsonStr':'{"typeid":"238"}'}

return_data = requests.post(url,data =post_param)

content=return_data.text

content

总结一下:如果页面内容发生变化,URL也会发生变化。基本上就是静态网页,否则就是动态网页。

请求异常处理

from urllib.request import Request, urlopen

from urllib.error import URLError, HTTPError

req = Request("http://www.111cn.net/")

try:

response = urlopen(req)

except HTTPError as e:

print('服务器无法满足请求.')

print('错误代码: ', e.code)

except URLError as e:

print('不能访问服务器.')

print('原因: ', e.reason)

else:

print("OK!")

print(response.read().decode("utf8"))

不能访问服务器.

原因: [Errno 11001] getaddrinfo failed