详细数据:蜘蛛访问数据在哪里查看

优采云 发布时间: 2022-12-03 01:16详细数据:蜘蛛访问数据在哪里查看

搜索引擎使用蜘蛛来抓取我们的网站页面并对页面进行评估,所以蜘蛛访问是我们网站收录和排名的前提。对于没有收录的情况,我们首先要分析的是是否没有蜘蛛访问。今天我们就来说说到哪里查看蜘蛛日志。

1.搜索资源平台视图

无论是百度、谷歌还是搜狗都有自己的蜘蛛,搜索资源平台后台都会有相应的蜘蛛在各自平台的爬行频率、爬行诊断、爬行异常等数据反馈。

搜索资源平台可以查看各个平台自己的蜘蛛访问我们的网站的数据。其他搜索引擎需要登录其他搜索资源平台查看。

2. 网站日志

网站日志是服务器自动生成的文本记录,详细记录了网站的访问详情。通过网站日志,我们需要判断日志中各个蜘蛛的访问状态。虽然在日志中可以看到不同的爬虫,但是布局优化不够。我们需要自己筛选判断。

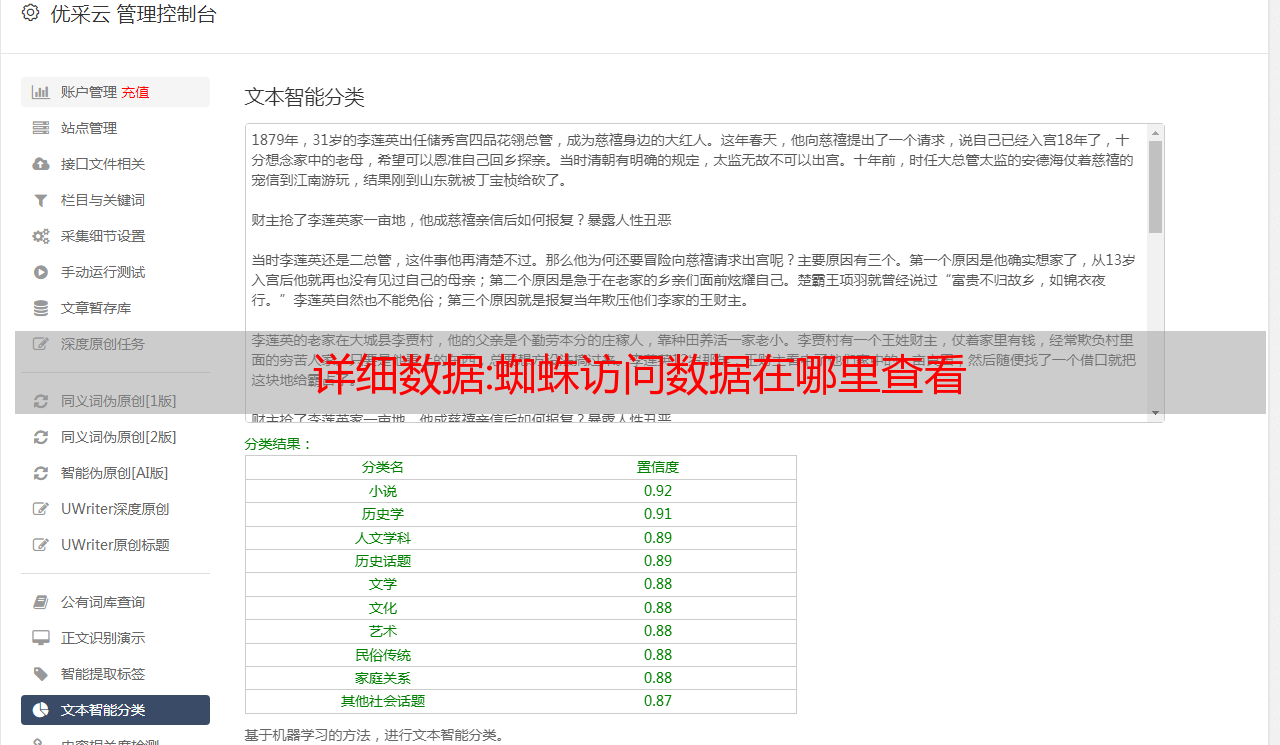

3.搜索引擎优化工具

SEO工具具有网站日志的特点,可以自动提取和分析蜘蛛访问信息,并以图表的形式直观地显示在屏幕上。如图所示,我们可以一屏查看各平台搜索引擎蜘蛛的访问情况,并根据数据自动生成蜘蛛访问曲线来判断网站是否健康。

关于查看搜索引擎爬虫日志的方法分享到此结束。SEO工具不仅有爬虫日志查看,还有内容编辑、自动采集发布、URL提交推送、网站检查等功能。如果大家喜欢这篇文章文章,记得采集点赞哦。

解密:用python编写自动信息收集脚本(三) -ip收集

本人只是一个python初学者,本文只适合初学者观看学习。伙计们,请绕道(或指出需要改进的地方)!在日常的渗透测试过程中,我们都知道在渗透目标之前需要进行一波信息采集。搜集的信息越多,渗透的过程就越顺畅,所以信息搜集就显得尤为重要。但是信息采集往往需要花费很多时间,所以我们想写一个自动采集信息的脚本,但是代码量太大了。本文以whois信息开头,代码不好的地方。希望大家多多评论!

该模块与之前用python 1和2编写的自动信息采集脚本配合使用

导入线程#多线程

导入请求

导入时间

从 lxml 导入 etree

import re #正则表达式

导入 csv

import telnetlib #建立tcp链接,实现端口扫描

类 xxsj(对象):

def __init__(自我):

global dk #创建一个全局变量,用于后面的端口扫描

self.wz = input("请输入您要查询的网站") #接收网站地址

dk = 自我.wz

self.a = re.sub(r"www.","",self.wz) #正则表达式,匹配删除

self.header = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36'}

def ip(自己):