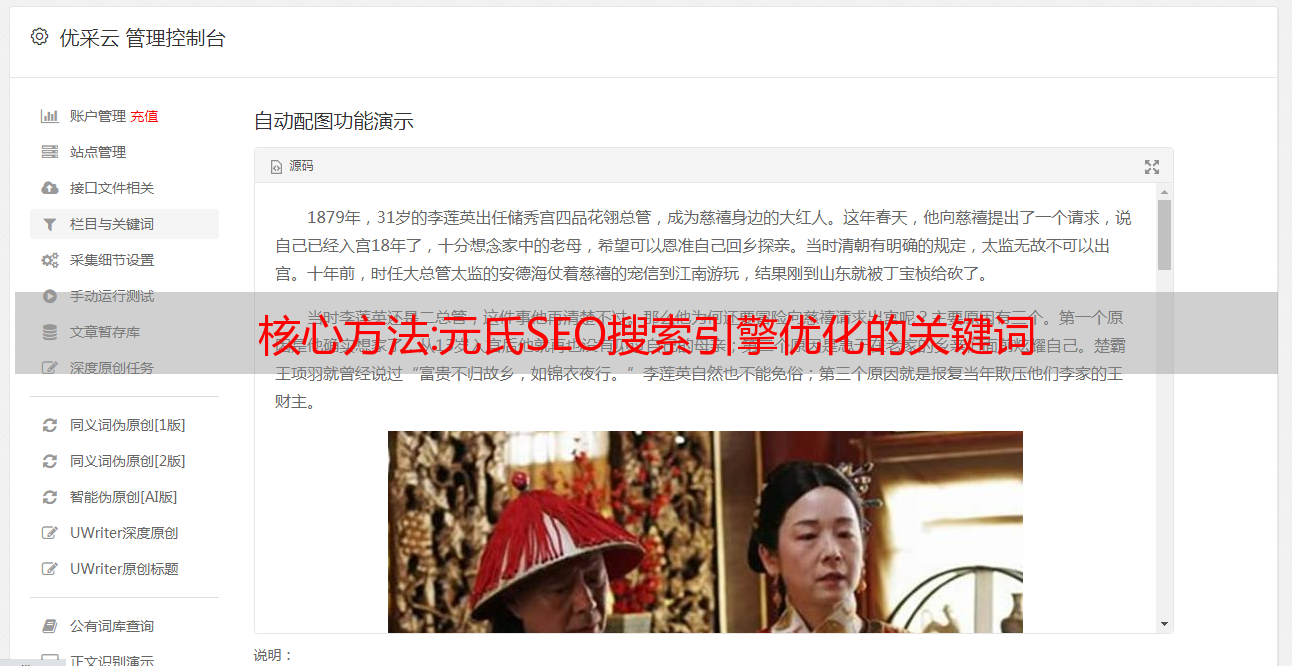

核心方法:元氏SEO搜索引擎优化的关键词

优采云 发布时间: 2022-12-01 11:25核心方法:元氏SEO搜索引擎优化的关键词

. 第一种:关键词匹配 在索引数据库中查找用户提交的搜索词A和词B,通过倒排索引列出文件,并在此判断形成完全匹配的文件集合

" target="_blank">采集

集合放在前面,然后通过关键词密度和方向等各种方法对文件进行排序。在这个排序过程中,搜索引擎还会判断外部链接的数量和质量等具有参考意义的因素。. 关键词 匹配的相关性也决定了网页的排名。希望SEOer们也进行一定的研究。

" />

第二种:语义分析不能完全根据关键词和外链判断文章内容。比如iPhone和Apple这两个词在语义分析上是同义的,只是通过关键词和外部链接搜索引擎是无法把这两个词联系在一起的,所以语义分析是非常必要的,语义分析其实很简单的。搜索引擎会对数据库中的海量文件进行分析,通过关键词相关性来判断两个词的相关性以及是否具有相同的含义。因此,在网站的实际运营中,如果要在网站上对这两个词进行排列,想要获得更好的排名,就需要仔细考虑一下如何对这两个关键词进行布局。

" />

关键词:

解决方案:从0到1搭建大数据平台之数据

" target="_blank">采集

大家好,我是脚先生(o^^o)

最近忙于实时流任务的开发。

坏处无处不在,好在都被成功克服了。

一直想做技术的快乐就在于解决一个难题时那种难以言喻的快乐。

非常令人兴奋。

多日后,我们正式进入大数据平台的采集篇章。

我希望它能给我的朋友带来欢乐。

1、大数据采集预热

在之前的《从0到1构建大数据平台入门》中,我们详细分析了大数据平台框架。

一步步往前,从一层到八层。

好像有点恐高。

小伙伴选择大数据平台,大概是因为传统的关系型数据库无法满足业务的存储和计算需求,面临海量数据的存储和计算问题。

那么要利用大数据平台的计算能力,首先要做的就是对数据进行整合。

简而言之,就是将需要处理的数据导入大数据平台,利用大数据平台的计算能力对数据进行处理。

2. 大数据采集来源

在《从0到1搭建大数据平台入门》中,我们知道了大数据的特点。

海量数据:庞大而复杂的数据集。

复杂数据:数据类型多样,包括文本、图片、视频和音频。

高速数据:数据的产生呈指数级增长,需要越来越高的速度来处理数据。

数据的类型大致分为结构化数据、半结构化数据和非结构化数据。

数据类型差异

结构化数据

它用二维数据库表抽象表示。数据库数据和文本数据都是结构化数据。

半结构化数据

介于结构化和非结构化之间,主要指XML、HTML、JSON文档、Email等,也称非结构化

非结构化数据

数据没有按照预定义的方式组织,不能用二维表进行抽象,如图片、图像、音频、视频等。

数据采集是根据海量数据的不同类型,选择合适的采集工具,将数据集成到大数据平台中的过程。

通常,有两种主要类型的数据源。

1、各业务系统的关系数据库可以称为业务的交互数据。主要是业务交互过程中产生的数据。例如,您需要使用支付宝支付医疗费用、淘宝购物等这些过程中产生的相关数据。一般存储在DB中,包括Mysql、Oracle。

2、各种埋点日志可以称为埋点用户行为数据。主要是用户在使用产品和与客户端交互过程中产生的数据。比如浏览量、点击量、停留量、评论量、点赞量、采集

量等。总之,在夜深人静的时候,当你躲在被窝里看不知名的快播神器大片时,这些行为都会产生数据,被*敏*感*词*。

其实还有一个数据来源,就是爬虫爬取的数据。外部数据有很多,比如天气、IP地址等数据,我们通常会抓取相应的网站数据存储。

总结:大数据采集

的数据来自日志、数据库、爬虫。

2.1 日志采集

2.1.1 浏览器页面日志

浏览器页面日志采集

主要分为两类。

页面浏览(显示)日志采集:页面浏览日志是指

浏览器加载和呈现页面时采集

的日志。该日志的主要价值在于两个基本指标:页面浏览量(PV)和访客数(UV)的统计。

页面交互日志采集:即用户行为数据的采集,主要是用户在使用产品过程中与客户端交互产生的数据。

2.1.2 无线客户端APP日志采集

众所周知,日志的采集

大多是为了后续的数据分析。

移动数据采集。

一是为开发者服务,协助开发者分析各种设备信息;

二是帮助每个APP更好地了解自己的用户,了解用户在APP上的各种行为,帮助每个应用不断优化和提升用户体验。

一般而言,App日志采集是使用采集SDK完成的。

但其采集

方式与浏览器日志不同。

根据不同的用户行为分为不同的事件,“事件”为无线客户端登录行为

最小的单位。

2.2 多源异构数据采集

业务系统中有各种类型的数据,包括来自关系数据库的结构化数据。

如MySQL、Oracle、DB2、SQL Server等:也有非关系型的

数据库的非结构化数据,如HBase、MongoDB等,这类数据通常存储在数据库表中。

还有一类是文件形式的数据存储,如:文件系统FTP、阿里云对象存储等。

采集这些不同来源的数据,使用采集工具从数据源中读取数据,转换成中间状态,将中间状态的数据在目标数据系统中转换成相应的数据格式写入.

3. 大数据采集工具

如上所述,对于不同的数据源,选择的大数据采集组件是不同的。

俗话说,好马配好鞍。

面对如此多的数据源,我们如何选择大数据采集技术栈?

我们已经知道,大数据采集

的数据来自于日志、数据库和爬虫。

接下来,解释用于每个数据源的工具。

3.1 日志采集工具

目前广泛使用的日志采集

工具有Flume、Logstash、Filebeat、Fluentd。

我们知道用于采集

日志数据的工具。

那么这几个日志采集

工具,小伙伴们肯定会说。

" />

我很难选择。

如何选择也是一个问题。

Flume:Cloudera提供的高可用、高可靠、分布式的海量日志采集、聚合、传输系统。支持在日志系统中自定义各种数据*敏*感*词*进行数据采集;同时,Flume 提供了对简单处理数据并写入各种数据接收方(可定制)的能力。

Logstash:具有实时管道功能的开源数据采集

引擎。Logstash 可以动态统一来自不同来源的数据,并将数据规范化到您选择的目的地。

Filebeat:一个轻量级的日志传输工具,可以监控指定的日志文件或位置,采集

日志事件,转发给Elasticsearch或Logstash进行索引。

Fluentd:一个日志采集

、处理和转发系统。通过丰富的插件系统,可以采集各种系统或应用的日志,转换成用户指定的格式,转发到用户指定的日志存储系统。

大数据日志采集工具种类繁多,您可以根据业务需求选择合适的。

3.2 多源异构数据采集工具

目前公司项目,线下数据的整合与同步,利用大数据采集技术栈导入导出多源异构数据使用较多。

多源异构数据采集的大数据技术栈,目前广泛使用的有Sqoop和Datax。

1. Sqoop:SQL–to–Hadoop。Sqoop顾名思义,主要用于Hadoop、Hive和传统数据库(MySql)之间的数据传输。它可以将数据从关系型数据库导入到Hadoop的HDFS中,或者将HDFS中的数据传输到关系型数据库中。

其架构如下

Sqoop工具接收到客户端的shell命令或Java API命令后,通过Sqoop中的任务翻译器将命令转换为相应的MapReduce任务,然后将关系数据库和Hadoop中的数据进行传输,完成数据拷贝。

2、Datax:阿里巴巴开源的异构数据源离线同步工具,致力于实现包括关系型数据库(MySQL、Oracle等)、HDFS、Hive、ODPS、HBase、FTP等各种异构数据源之间的稳定。高效的数据同步功能。

DataX本身作为一个离线数据同步框架,是采用Framework+plugin的架构构建的。数据源读写抽象成为Reader/Writer插件,融入到整个同步框架中。

它的架构如下所示:

DataX在设计之初就将同步的概念抽象为框架+插件的形式。框架负责内部序列化传输、缓冲、并发、转换等,核心技术问题,数据采集(Reader)和登陆(Writer)完全交给插件执行。

以上就是最常用的异构数据源采集工具。至于你应该选择哪种技术栈,这取决于你的业务需求。

总结:Sqoop依托于Hadoop生态系统,对HDFS和Hive友好。它在处理大型数据仓库表时比较快,但不具备统计和校验能力。

DataX不能分布式部署。可以在传输过程中进行过滤,可以对传输数据的信息进行统计。因此更适合复杂的业务场景(表结构变化),更好地支持不同的数据源。

而且DataX的开源版本目前只支持单机部署,需要依赖调度系统实现多客户端,不支持自动建表和分区。

3.3 外部数据爬虫

简单地说,网络爬虫就是一种自动从互联网上进行定向或非定向信息采集的程序。

目前常用的爬虫工具是Scrapy,它是一个爬虫框架,为开发者提供了方便的爬虫API接口。开发者只需要关心爬虫API接口的实现,不需要关心具体的框架是如何爬取数据的。

Scrapy框架大大降低了开发者的开发速度,开发者可以快速完成一个爬虫系统的开发。

至此,我们通过大数据采集技术栈,将不同来源的海量数据采集到大数据平台。

好了,今天的聊天就到这里,祝大家成功,收获多多!

期待老铁的关注!!!