使用好的工具来完成网页数据抓取工作-即使您不是程序员,也可以采集高质量的网页数据

优采云 发布时间: 2020-08-07 11:47”

容易吗?就这么简单!接下来,转到优采云并重新配置

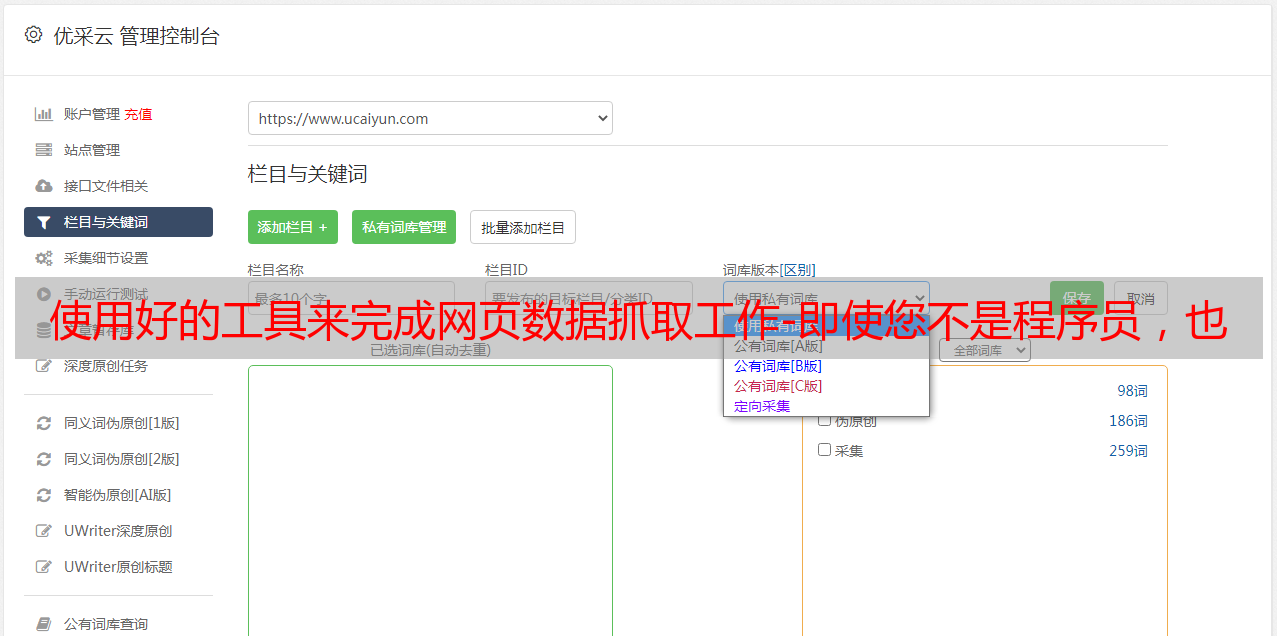

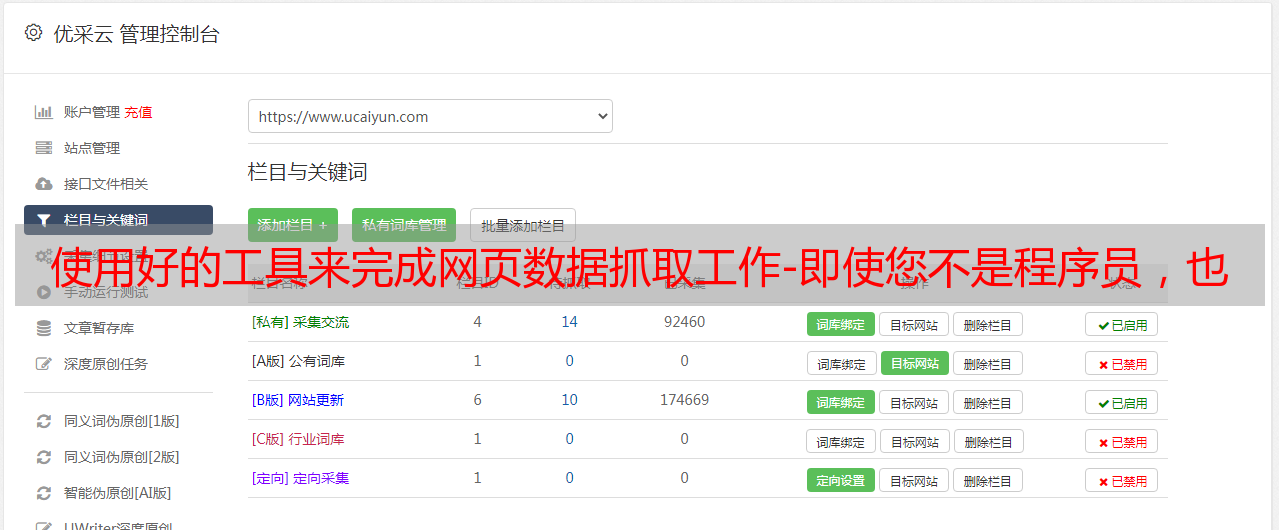

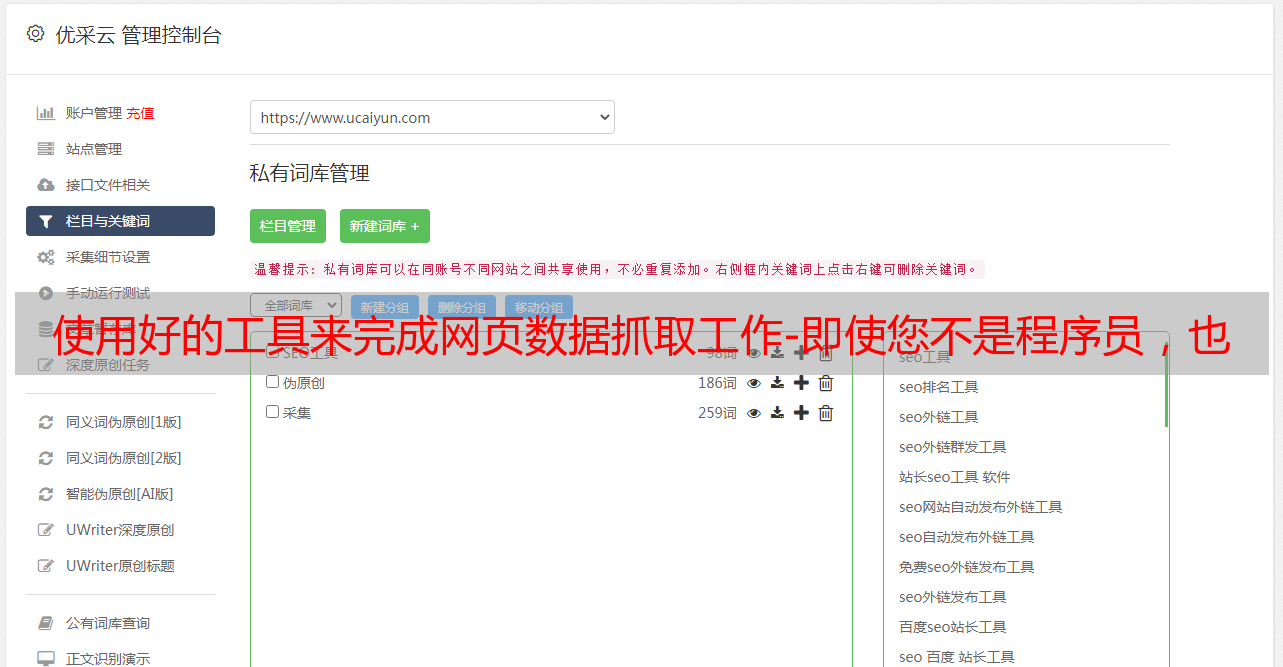

根据该工具的配置向导添加要抓取的URL

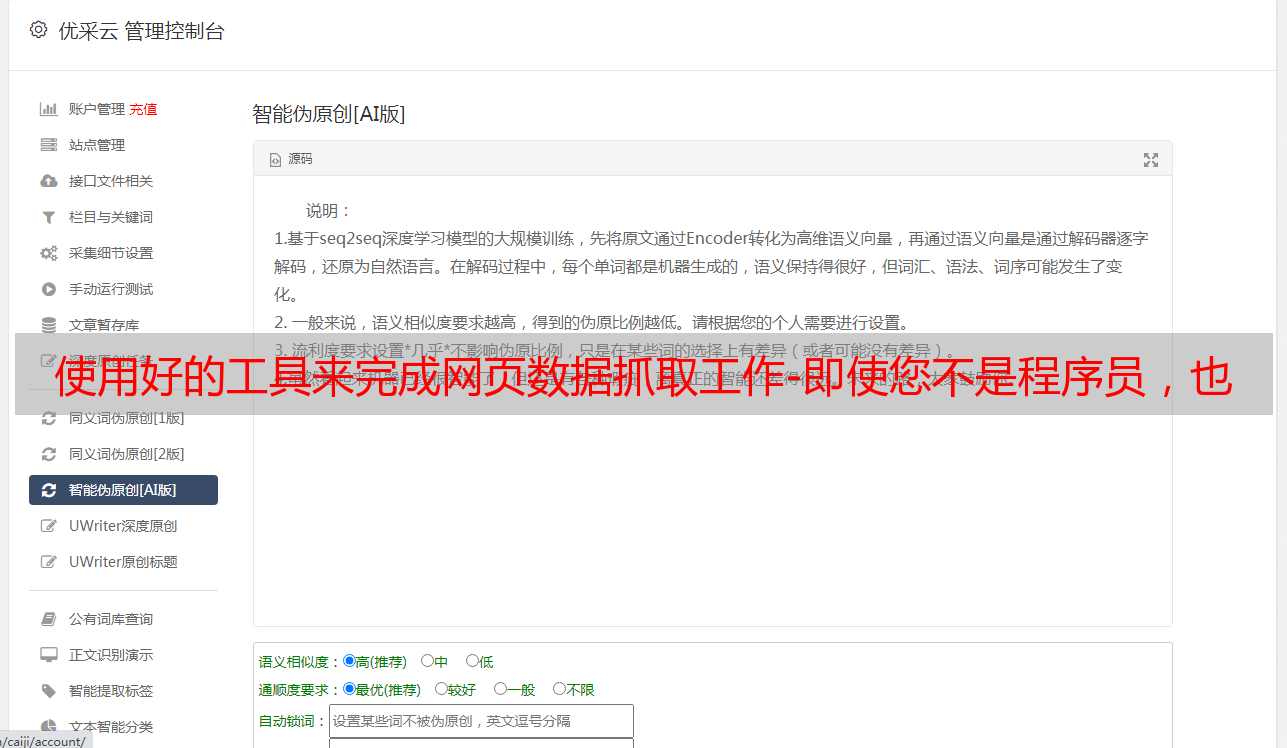

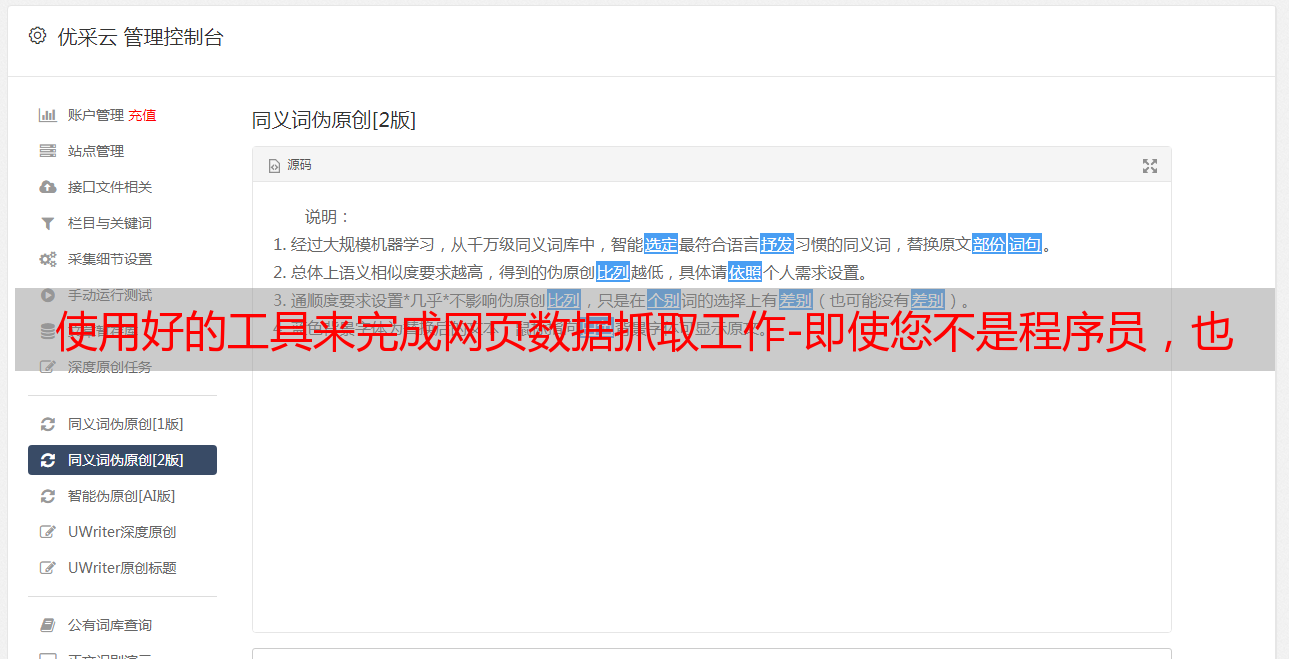

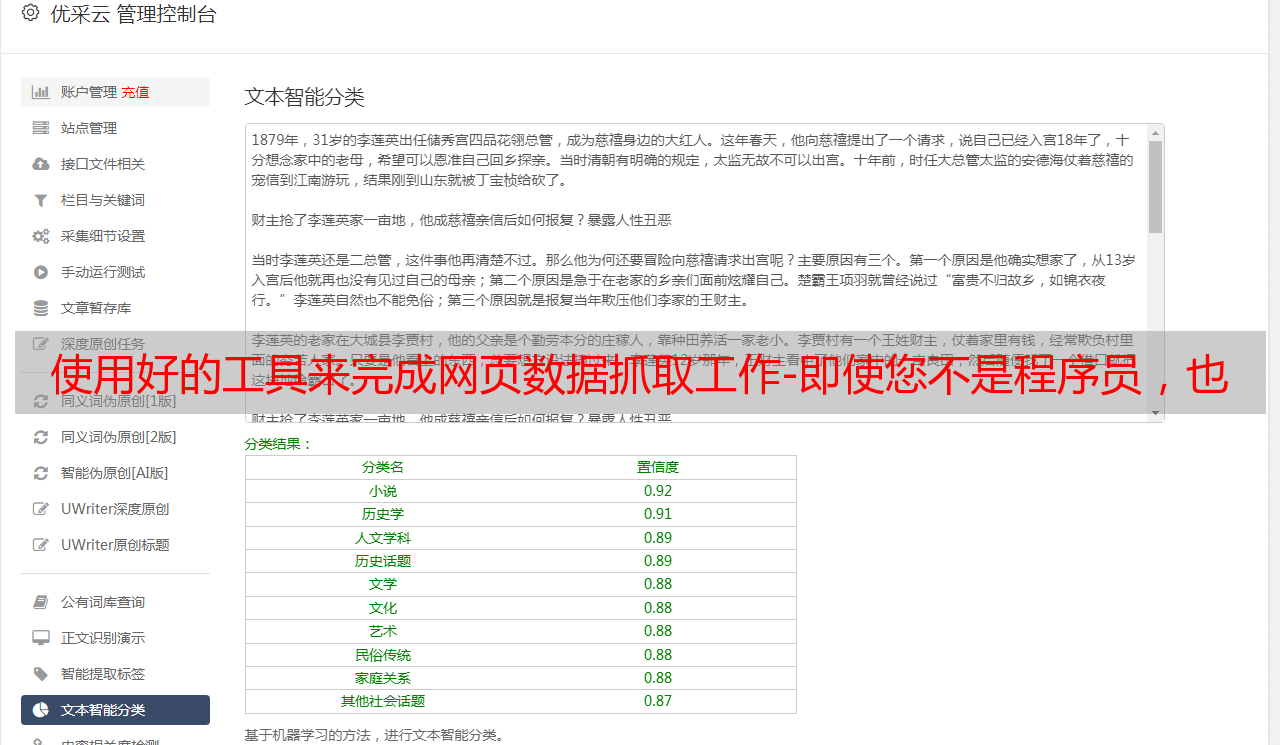

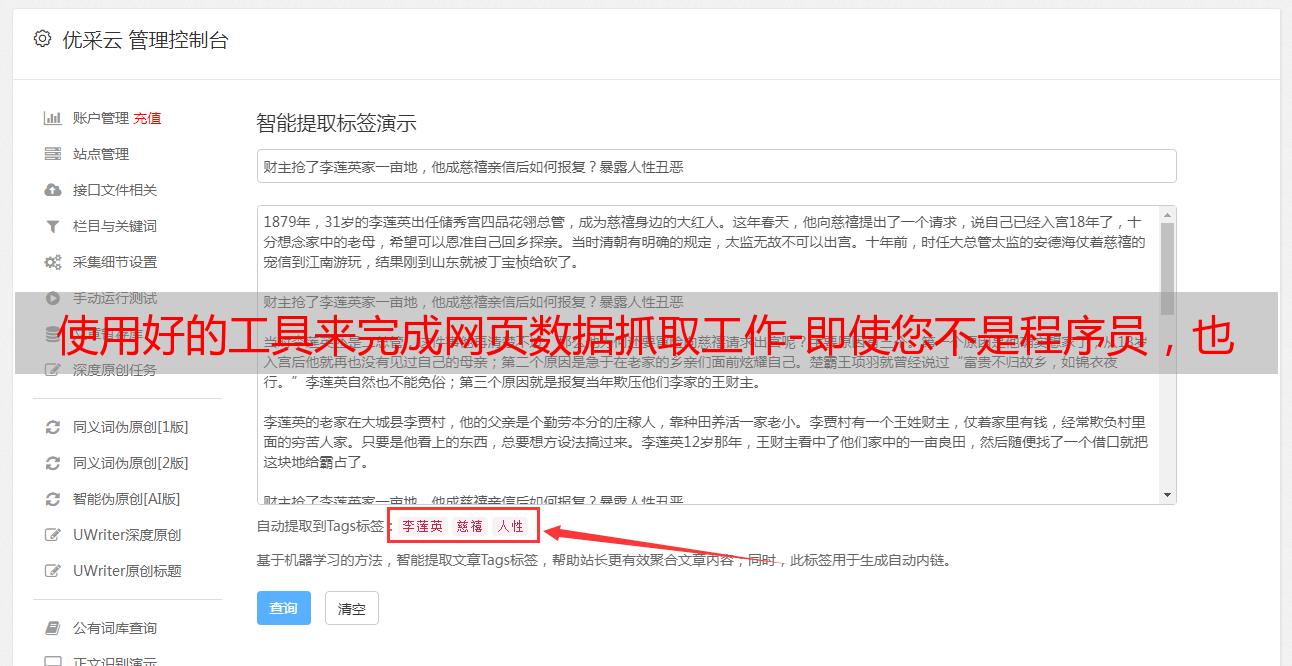

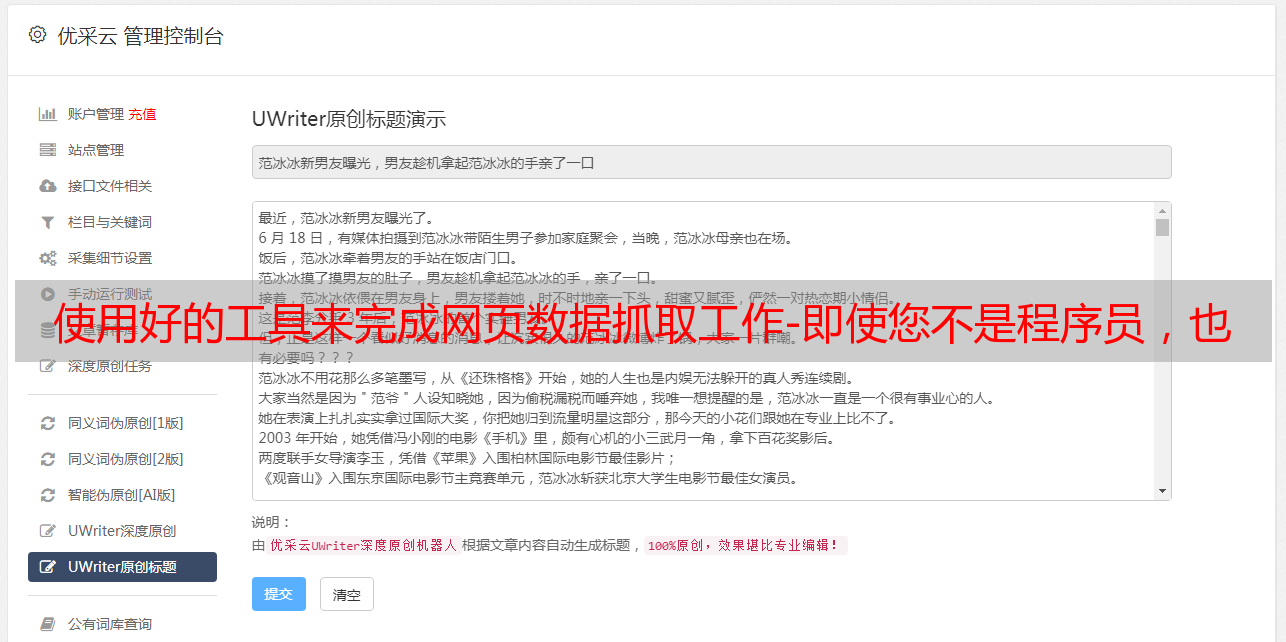

下一步是创建需要在内容采集规则中采集的标签逻辑. 更不用说了,请参见下图,然后输入先前的逻辑.

至此,字段的提取逻辑配置完成. 让我们看看效果如何?是否采集了所有地址?其他字段配置方法相同,因此在此不再赘述.

接下来,按如下所示从数据库中导出数据并将其放入excel预览中. 为什么我们需要将其导入到excel中,因为我们还需要根据商店URL来爬行商店的详细数据(实际上,主服务器可以通过抓取任务“部分数据”爬行来完成这两个操作,因此我将介绍如何配置它等我有机会的话.

第二步: 攀登商店详细数据. 将第一步中抓取的“ Store URL”的所有数据存储到txt文本中

将URL采集规则的URL更改为保存的文本,然后配置一堆规则. . . .

采集详细的数据后,通过URL对两个表进行联接(我使用Mysql,所以执行了类似的语句)

到目前为止,我们已经完成了将结果再次导出到excel的操作(您可以根据需要继续在数据库中进行操作,感觉如何)

第三步是采集纬度和经度信息. XGeocoding工具在这里.

首先,您需要为XGeocoding准备数据源. 为了使提取的经纬度更加准确,此处需要4个字段

通过“新建”→“导入文件”→“ txt / csv”导入准备好的数据

选择字段0作为“同步ID”,字段1作为“城市/县”,字段2作为“企业名称”,字段3作为“地址”. 选择“百度”作为坐标类型. 当然,您拥有其他地图的KEY,也可以使用其他地图来源

下一步,将要求您选择“工作图”并输出地图坐标. 在这里您可以根据实际需要进行选择. 必须先使用API KEY配置工作图,然后才能调用它(进入其开发者门户网站以应用)

然后使用“结果”→“导出数据”预览采集的纬度和经度数据,然后将其导出.

清理导出的数据并保留ID,经度和纬度. 只需加入ID和第二步数据即可.

最后,我们通过Tableau预览数据.

摘要:

本文以在北京的Tuhumen商店信息采集为例,对数据采集工具的操作进行了基本演示(一些详细信息未解释,如果您不了解,可以留言) ,即使不是IT人员也可以自行完成在线数据爬网. 但是还有几点要提醒大家:

1. 工具必须有局限性,并非一无所有.

2. 采集的结果也会有一定的偏差. 此时,需要采取一些手段和方法来避免偏差. 例如,在本文中,我们使用省份,地址和商店名称进行多次数据验证. 即使这样,仍然会有异常数据. 因为地址本身具有相同的名称或彼此接近,所以当输入信息不足时,仍然会发生错误. 如果您需要进一步改善数据采集