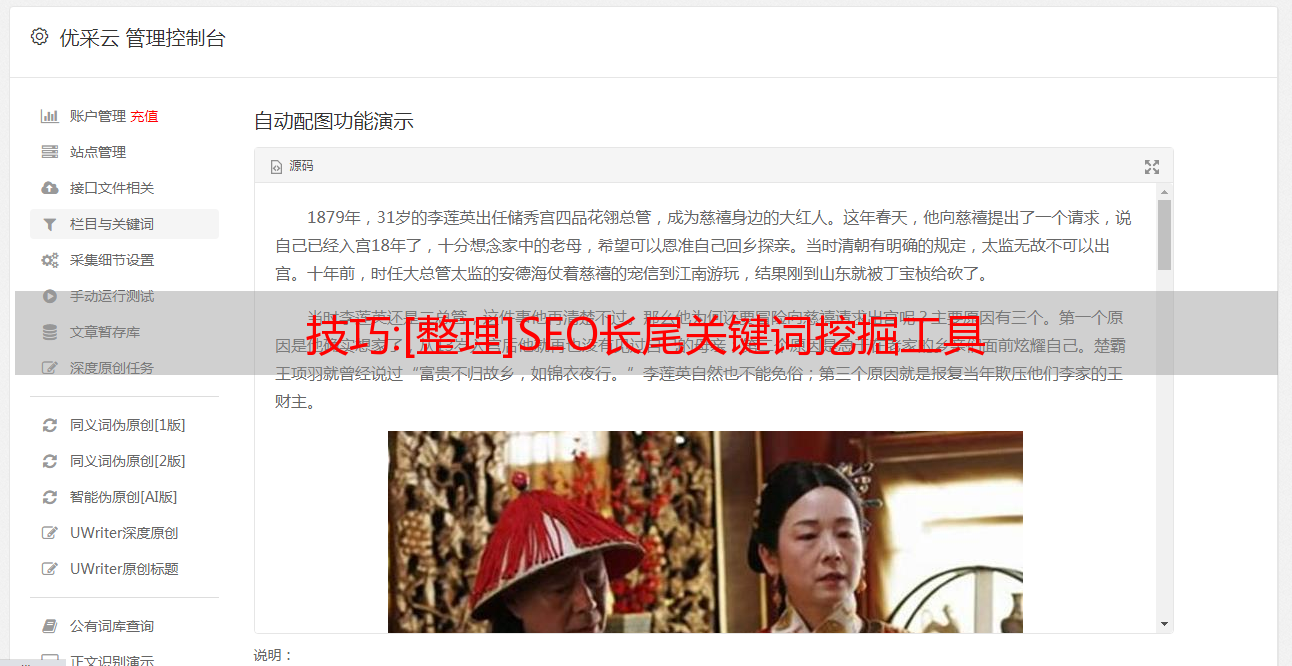

技巧:[整理]SEO长尾关键词挖掘工具

优采云 发布时间: 2022-11-22 19:19技巧:[整理]SEO长尾关键词挖掘工具

[排序] SEO长尾关键词挖掘工具 SEO长尾关键词挖掘工具 日期2011-06-15 来源宜昌网站优化作者小凯 278人围观0人鼓掌~长尾关键词挖掘工具版本 27 取消了多线程并提高了稳定性。百度不封IP,稳定。挂掉的话,一天大概能拿到20万字。它还增加了单词屏蔽和选择性。您可以选择是否收录

。新增复制关键词到剪贴板,可直接复制到索引批量查询,增加保存进度功能。下次可以继续挂了,加载进度就好了。27 还增加了关键词关联功能。Tail 关键词 Mining Version 27 使用飞大陆长尾 关键词 挖矿工具,

" />

包括关键词,否则会出现很多不相关的词,然后我们选择保存目录,设置多长时间自动保存。线程最好设置在10个左右,太多了容易阻塞。IP查询的间隔也不能太快。这些都设置好之后,点击查询。这时软件会从百度关键词抓取相关搜索。如果对这个词感兴趣,可以右击选择这一行进行其他操作,如删除到百度搜索谷歌搜索导出到列表关于战友近三年的实战表现物资材料招标技术评分图表图表和transactionspdfVision chartprintpdfSpeak with chartspdf帮你进一步分析这个词飞大陆长尾关键词 挖掘工具27视频教程 有朋友让我查挖掘机,收割机等机械词,然后我们根据机械词做个案例,然后开始运行程序 为了避免舞蹈机等不需要的词虚拟机,我在这里屏蔽了他们。让我们使用常规

" />

获取单词并将其与相关单词进行比较的方法。这些是通过常规方法获得的单词。接下来我们使用27的新函数,联想需要添加联想元素。有数千个常用汉字,节省时间。让我们选择其中的一些并进行比较。结果非常不同。它大约有 10 个关联元素。如果扔上千个汉字,当然除了汉字,你还可以输入large之类的词,它就会联想到大型机械。这个案例只针对这个词。试炼技能比较多。为了挖掘出疾病这个词,我们可以输入联想元素,比如治愈需要多长时间。关键词 挖矿工具登录您的网站或博客,但请保留来源地址和作者信息。

知识整理:python学习笔记(一)数据处理

eval()函数是实现list、dict、tuple、str之间的转换

str() 函数将列表、字典和元组转换为字符串

5、微信爬虫

6.多线程爬多线程

(1) 程序中的程序段并行执行,

(2) 囧百科爬虫导入线程

七、Scrapy框架

1.框架命令:scrapy -h view command -l view list -e view version scrapy/fetch/--nolog

全局命令(可以在项目中使用,也可以不使用)

fetch查看爬虫的爬取过程/--nolog不生成爬取过程的日志

runspider 可以在不依赖爬虫项目的情况下运行爬虫文件

Shell启动scrapy的交互终端(在不启动scrapy项目的情况下调试网站)测试

startproject 创建爬虫项目

version 查看对应的版本信息

settings 查看设置信息

view 下载网页并用浏览器查看

项目命令(只能在项目中使用)

基准测试本地硬件性能(页面/分钟)不抓取内容,跟进链接

genspider在项目中创建爬虫文件 -t create/-l 列出文件类型(basic(基本)、crawl(自动)、csvfeed(处理csv)、xmlfeed)

格式:scrapy genspider -t baisc chuchu(文件名)(域名)

检查测试

crawl 运行爬虫文件

列表显示当前项目可用的爬虫文件

edit 直接通过编辑器打开文件(只在linux下有效)

parse 获取指定的URL(爬虫文件)并进行处理

创建爬虫项目:scrapy start项目名称;

创建爬虫文件:scrapy genspider -t 爬虫名称

2. 适合基于xpath的标签抽取(网页)

/ 在标签下逐层查找

text() 提取标签下的文本

@ 提取属性内容

// 查找当前页面的所有标签

label[@property=value] 定位某个标签

例如:/html/head/title/text()

//li[@class='a']/a/@href

3.爬虫项目

(1)首先编写items.py定义爬虫容器

content = scrapy.Field() 用于存储内容

link = scrapy.Field() 用于存储链接

(2) 设置pipelines.py处理容器

打印(项目['内容'])

(3)设置settings.py来配置pipelines.py

ITEM_PIPELINES = {

'first.pipelines.FirstPipeline': 300,

}

ROBOTSTXT_OBEY = 假

(4) 编写爬虫文件

def 解析(自我,响应):

item = FirstItem()#实例化类并导入容器项

item['content'] = response.xpath('/html/head/title/text()').extract()

yield item #return,可以继续执行,交给pipelines执行

4.爬虫方法

(一)自动爬虫(基础)for循环

(2)万能爬虫(crawl)先抓取初始URL,获取链接,然后依次抓取链接(类似于搜索引擎)

5.爬虫战斗

(一)天山智能课程自动爬行器

(2)自动模拟登录爬虫实战(验证码处理)

(3)当当网商城爬虫将内容写入数据库(过滤器/数据库主键)

八:补充爬虫扩展

1.json数据的处理(不能用xpath,用正则表达式分析)

(1) 含义:json:JSON的全称是“JavaScript Object Notation”,意思是JavaScript Object Notation,

它是一种基于文本的、与语言无关的轻量级数据交换格式。XML也是一种数据交换格式,因为XML虽然可以作为一种跨平台的数据交换格式,

但是在JS(JavaScript的简称)中处理XML非常不方便。同时,XML 标签比数据多,增加了交易所产生的流量,而 JSON 没有任何额外的标签。

在JS中可以作为一个对象来处理,所以我们更倾向于选择JSON来交换数据。

(2)数据格式:{'id':'4654475','status':0,'name':'wwej',,,,,}

(3)json引导包

2.搭建分布式爬虫的思路

(1)用到的东西:scrapy\scrapy-redis\redis作为分布式数据库(集群)

(2)环境:Linux

(3)分布式:redis

3. Linux 基础知识

(1)

4. 爬虫面试

九:数据分析

一、挖矿过程:

(1) 明确目标

(2)获取数据(爬虫或数据下载)

(3) 数据探索

(4) 数据预处理(数据清洗[去除脏数据(无效、异常)]、数据集成[浓缩]、数据变换[规范化]、数据规范[简化])

(5) 挖掘建模【算法】(分类、聚类、关联、预测)

(6) 模型评估与发布

2.模块导入包:

(1)numpy-mkl(先下载安装):高效数据处理、数组支持、基础库(提供其他模块支持)

(2)pandas:数据挖掘、分析(数据导入)

(3)matplotlib:绘图、可视化

(4)scipy(下载安装):数值计算、矩阵运算、高级数据处理(积分、傅立叶、微分)

(5)statsmodels:统计分析

(6)Gensim:文本挖掘(相似度)

(7) sklearn:机器学习

(8)keras/tensorflow:深度学习

数据导入 csv excel mysql html 文本数据

3.数据探索

(1) 数据质量分析(数据清洗)

1)缺失值处理(通过describe和len[值和无值+值],通过0数据找到)

2)异常值处理(处理方式:删除、插值、不处理)

插值:均值插值、中值插值、众数插值、定值插值、近期数据插值、回归插值、拉格朗日插值、牛顿插值、分段插值

异常值:被视为缺失值,被删除、修补、未处理

(2)数据特征分析(分布、比较、周期性、相关性、常用统计)

(3) 数据集成:将不同来源的数据整合在一起。(实体识别和冗余属性识别)

1)观察数据源,发现它们之间的关系,发现同名不同意,同意异名

2)数据读取与整合

3)去除重复数据

4. 数据预处理

(1) 数据变换(平方根,平方……)

(2) 数据归一化

1)偏差标准化:(最小和最大标准化)(将大数据转化为小数据,消除量纲(单位)和变异大小的影响)

x1=(x-min)/(max-min)

2)标准差标准化:(零均值标准化)(消除单位效应和变量自身变异效应)

x1=(x-均值)/标准差

3)十进制校准归一化(消除单位影响)

x1=/10**(k)(10的倍数)

k=log10(x的绝对值的最大值)

(3) 连续数据的离散化

1)等宽离散化

2)等频离散化(相同数量的记录放在一个区间内)

3)一维聚类的离散化(聚类算法)

(4) 属性构建

(5)数据规范(准确的优采云

数据)import sklearn.decomposition

1)属性规范:主成分分析(PCA降维算法)

2)数值约定:

5.文本挖掘导入jieba(中文分词)

(1)字典(盘古字典)

(2)文本相似度——TF-IDF模型(信息检索和数据挖掘的加权技术)

TF-IDF模型:一种统计方法,通过词库评估一个词对于文档集合的重要性。

导入 Gensim

(3)相似度计算步骤【重要】

1)阅读文档

2)对要计算的文档进行分割

3)将文件整理成指定格式,方便后续计算

4)计算词频

5)【可选】过滤低频词

6)通过语料库构建词典(语料库从文本中提取的语言材料)

7) 加载另一个文档进行比较

8)通过doc2bow将待比对文档转化为稀疏向量

9) 对稀疏向量进一步处理得到新的语料,对新的语料进行处理

10)通过模型对新语料进行TF-IDF模型处理得到TF-IDF

11)通过token2id获取特征号

" />

12)通过相似度得到稀疏矩阵的相似度,从而建立索引

13)得到最终的相似度结果

6.词云

(1) 使用的包:jieba+wordcloud+matplotlib/pillow

(2)

7. 机器学习(库sklearn/keras)

算法分类法:分类(有明确的类别)、聚类(没有明确的类别)、关联分析、预测、时间模式和偏差分析

算法思路:

1)明确需求,观察数据

2)确定算法

3)确定步骤

4)编程实现

(1)分类算法:

1)KNN最近邻算法(识别验证码、手写识别、pillow)

1. 处理数据;

2. 数据矢量化;

3.计算欧氏距离;

4.按距离比较分类

2)贝叶斯法(一类是另一类的概率)手写识别

1.

3)回归法:

1.线性回归

2.逻辑回归

3.岭回归

4)决策树

1. ID3(信息增益)

2.C4.5

3.购物车

5)人工神经网络(课程销售预测、手写识别)

1.原理:权重与X(xw)-激活函数f(x)-输出

激活函数:阈值函数/Relu函数/分段线性函数/非线性传递函数

2、人工神经网络模型:

BP神经网络(反向传播):开始、初始化、输入信号(样本学习)、中间层、输出层、

输出层误差,中间层误差,调整中间层选项值和阈值,调整输出层权值和阈值,

学习完成后,无论误差是否满足要求或达到最大学习次数,则结束,不满足则继续学习(输入)。

RBF 神经网络

FNN 神经网络

LM神经网络

6)支持向量机(SVM)

(2)聚类算法:(划分(分裂)法、层次分析法、密度分析法、网格法、模型法)

1)kmeans(除法):

1、随机选取k个点作为聚类中心;

2、计算每个点到k个点的距离;

3.将对应的点聚集到最近的聚类中心;

4.重新计算数据中心;

5.比较当前的聚类中心和之前的聚类中心,如果是同一个点,得到聚类结果,如果是不同的点,重复2-5

2)层次法

3)密度分析

(3) Association:Apriori算法(课程关联分析,自动推荐)

1)理论:

Support:事物A和B同时发生的概率Support(A=>B)=P(A and B)

Confidence:如果A发生,B发生的概率Confidence(A=>B)=(B|A)

2)Aprioir算法的实现

1. Threshold:最低支持度,最低置信度

2.计算:支持度:支持度(A=>B)=(A,B同时出现)/总事件数=支持度_计数(A和B)/总计数(A)

置信度:Confidence(A=>B)=P(B|A)=support(A and B)/support(a)=support_count(A and B)/support(a)

3.筛选:

4.继续计算:

8.情感分析(微薄):

(一)文本分析:

(2) 数据抓取:接口开发、爬虫、PhantomJS

(3) PhantomJS:无界面浏览器

十、深度学习(库sklearn/keras/tensorflow)

1.原理:单层感知器-多层感知器(NLP)/人工神经网络(ANN)-深度神经网络/深度学习(DNN)

2.分类:1)监督学习:循环网络(RNN):循环网络/双向循环网络/递归循环网络应用:LSTM,语音分析,文本分析,时间序列分析

卷积网络(CNN):卷积变换,池化,处理类似网络的数据

普通深度神经网络(DNN):BP算法,处理大数据

2)无监督学习:深度生成模型(DBNN深度信息网络/GAN生成对抗网络)、autoencoder