百度爬虫公开课之网站抓取和收录的一个原理

优采云 发布时间: 2021-05-28 22:10百度爬虫公开课之网站抓取和收录的一个原理

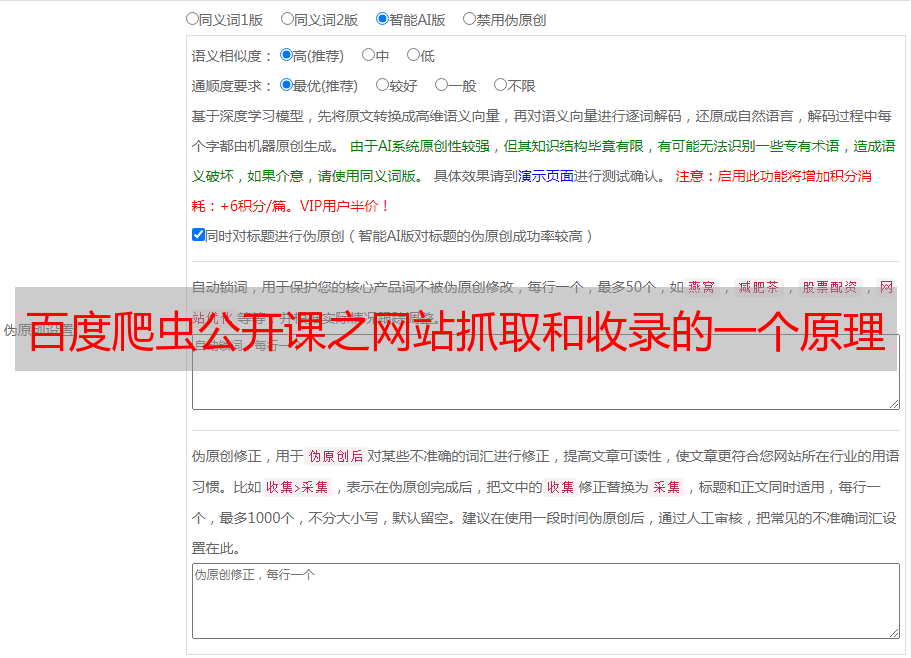

大家好,今天百度资源平台正式播出了一个公共课堂,主要是向您介绍网站抓取和收录的原理,在这里我为您做了详细的说明(一句话看完之后,可以说收录基本上不是什么大问题。

百度爬虫的工作原理

首先,百度的抓取工具将与网站的首页进行互动。获取网站的主页后,它将了解该页面,包括(类型,值计算),其次,它将获取网站的所有主页。如下图所示,主页上的超链接称为“反向链接”。当进行下一轮爬网时,爬网程序将继续与这些超链接的页面进行交互,获取页面以进行细化,然后一层又一层地继续。抓一层,构成一个抓环。

适用于爬网的优化

1、 URL规范:

任何资源都是通过URL获取的。 URL与网站的房屋号码相关,因此URL计划非常重要。尤其是在上图所示的“要爬网的URL”环境中,当爬网程序位于主页上时,它不知道URL的外观。

优质URL的特征是主流且简单的,因此您可能不想制作一些非主流的样式来使人们看起来很直观。

优秀URL的示例:

如上图所示,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址非常简单,而且采集器看起来非常不错。

如上图所示,第三篇文章的段落多于百度。首先,第一段是网站的站点,第二段是站点的第一级目录,第三段是站点的第二级目录。最后一段是网站的内容ID。这样的URL也是标准的。

不友好的网址示例:

如上图所示,这种链接乍看之下很长且很复杂,有经验的网站管理员可以看到这种URL收录字符,并且该URL收录标题文章,从而导致网址偏向。与简单的URL相比,较长的较长的URL不利。百度网站管理员平台的规则明确规定该网址不能超过256个字节。我个人建议将URL长度控制在100个字节以内,100个字符足以显示URL的资源。

如上图所示,此URL收录统计参数,这可能会导致重复爬网并浪费站点权限。因此,可以不使用参数。如果必须使用参数,则还可以保留必要的参数。参数字符实际上是可能的。使用常规连接器,例如“?”和“&”,以避免使用非主流连接器。

2、合理的链接发现:

采集器从主页逐层爬网,因此您需要做好主页和资源页之间的URL关系。这种爬虫爬行相对省力。

如上图所示,从首页到特定内容的超链接路径关系称为发现链接。当前,大多数移动台对发现链接关系并不太关注,因此爬网程序无法抓取内容页面。

如上图所示,这两个站点是移动网站建立站点的常用方法。从链接发现的角度来看,这两种类型的网站都不友好。

Feed流媒体建议:大多数进行feed流媒体的网站在后台都有大量数据,并且当用户继续刷新时会显示新内容,但是无论您刷新多少次,您都只能刷新到大约1%的采集器相当于一个用户。采集器无法以此方式搜寻网站的所有内容,因此将导致某些页面被搜寻。即使您拥有100万内容,也可能只能获取1-2百万。

仅搜索条目:如上图所示,主页上只有一个搜索框。用户需要输入关键词才能找到相应的内容,但是爬网程序无法输入关键词然后进行爬网,因此,爬网程序只有在爬网到首页之后,才不会出现反向链接。自然爬行和收录并不理想。

解决方案:索引页面下的内容以与发布时间相反的顺序排序。这样做的好处是,搜索引擎甚至可以通过索引页面来获取网站最新资源,而新发布的资源应该是实时的。在索引页面同步中,许多纯静态的网页都有更新的内容,但是主页(索引页)不出来。这将导致搜索引擎甚至无法通过索引页面抓取最新资源。第三点是反向链接。 (最新的文章)的URL需要直接在源代码中公开,以方便搜索引擎进行爬网。最后,索引页不多。一些高质量的索引页面就足够了,例如“长城”,它基本上只使用主页来做索引页面。

最后,这是向所有人提供的更有效的解决方案,即直接通过百度网站管理员资源平台主动提交资源,以便搜索引擎可以绕过索引页面并直接获取最新资源。这里有两点需要注意。

问:提交更多资源更好吗?

A:收录效果的核心始终是内容质量。如果提交大量劣质,淹没的资源,将导致惩罚性打击。

问:为什么我提交了正常的收录,却没有收到?

A:资源提交只能加速资源发现,并且不能保证短期爬网。当然,百度表示,该算法不断进行优化,可以更快地抓取高质量的内容。

3、访问友好度:

抓取器必须与网站交互并确保网站稳定,以便抓取器可以正常爬网。那么访问友好主要包括以下几个方面。

访问速度优化:建议将加载时间控制在2S以内,因此,无论是用户还是履带,打开速度更快的网站都将更受青睐,尽管这样可以避免不必要的跳跃,尽管这是一个很小的部分,但是网站中仍然存在许多级别的跳转,因此对于爬网程序而言,很有可能在多级跳转的同时将其断开连接。通常,将不带www的域名重定向到带有WWW的域名,然后将带有WWW的域名重定向到https,最后替换新站点。在这种情况下,将存在三到四个重定向级别。如果有与网站相似的版本,建议直接跳转到新域名。

标准化的http返回代码:正确使用常见的301/302和404是主要的常规问题。使用常规方法解决它们。例如,如果遇到无效资源,请使用404来执行此操作。不要使用一些特殊的退货状态代码。

访问稳定性优化:首先,尽可能选择国内大型DNS服务,以确保站点的稳定性。对于域名DNS,阿里云实际上是相对稳定和可靠的。然后,第二,使用技术手段小心地阻止爬虫。对于爬网,如果您不想在百度上显示某些特定资源,则可以使用漫游器来阻止它们。例如,网站的背景链接大部分被机器人阻止。如果爬网频率过高,导致服务器压力过大并影响正常用户访问,则可以通过资源平台的工具降低爬网频率。第二个是防止防火墙错误地禁止爬网程序,因此我建议您可以将搜索引擎的UA添加到白名单中。最后一点是服务器的稳定性,尤其是在短时间内提交大量高质量资源时。此时,您必须注意服务器的稳定性,因为当您提交大量资源时,爬网程序也会相应增加。这会在此时导致您的服务器吗?压力太大,无法打开,这个问题需要网站管理员的关注。

<p>如上图所示,这三个示例是被第三方防火墙拦截的状态。当普通用户以这种状态打开时,搜索引擎在爬网时也会处于这种状态,因此,如果遇到CC或DDOS时,打开防火墙时必须放开搜索引擎的UA。