解决方案:网页应用程序接口采集文章发布(爬虫)

优采云 发布时间: 2022-11-18 01:15解决方案:网页应用程序接口采集文章发布(爬虫)

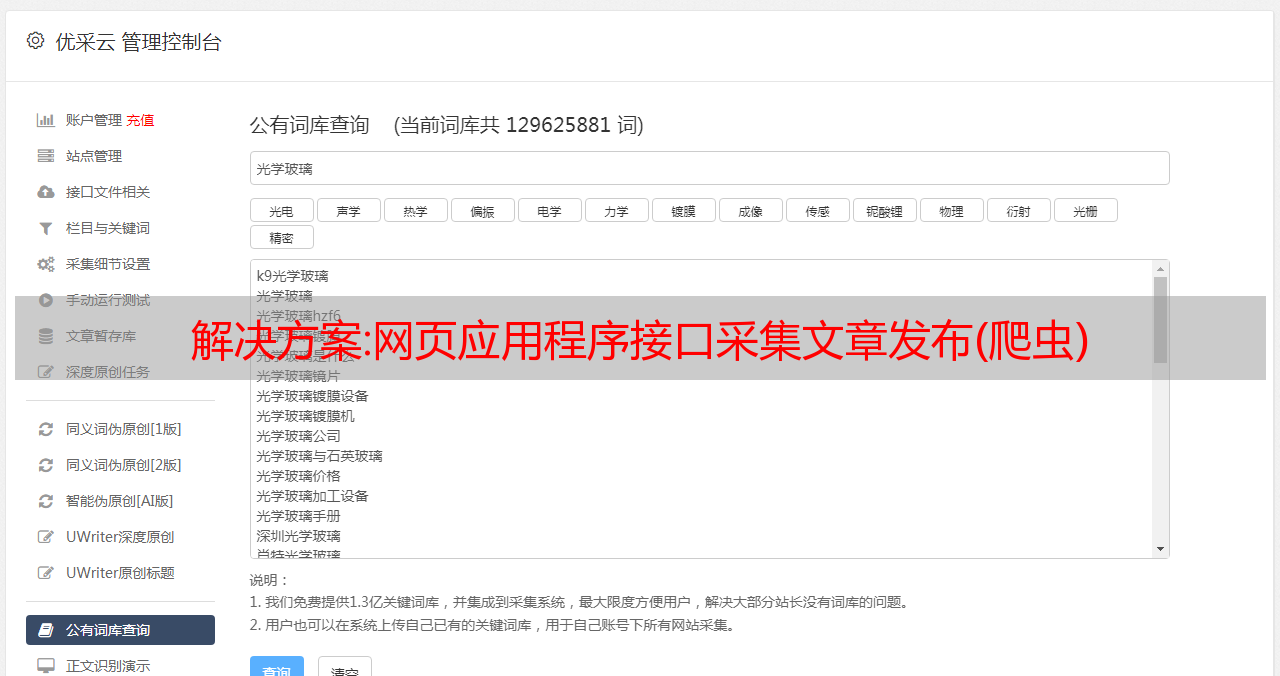

关键词采集文章发布一、爬虫概述爬虫是一种网页应用程序接口(interface),可以使用http协议从互联网上获取页面信息,并解析页面内容并输出数据。爬虫分为两种:一种是http协议爬虫,一种是采用scrapy或其他采集框架的scrapy爬虫。他们主要区别在于程序接口上,前者实际可以理解为后者的变种,即传统的网页采集系统(如postman)。

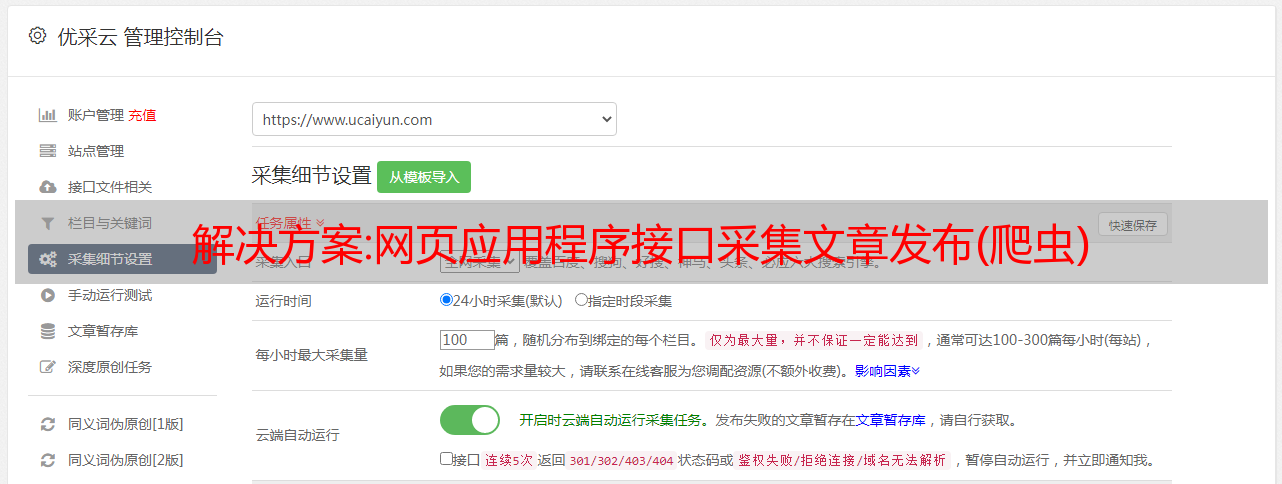

二、采集流程1.构建程序采集前在保持统一配置的情况下,打开浏览器,访问网址并进行相应操作,成功后保存访问信息,以后就不再需要重复这一步骤。采集结束后,关闭浏览器,打开浏览器,访问网址,再次采集数据。一般情况下每个页面数据量较大且需要取出导出,这时候scrapy或其他采集框架都会提供一个单独的程序,我们称这个文件为scrapy爬虫的程序文件。

爬虫程序中需要request与response这两个类型,request是定义请求信息的,response则是定义响应数据的。我们可以把scrapy程序中定义的所有变量作如下称呼:request(网页):返回一个网页response(响应信息):返回一个网页的原始数据2.获取全部数据爬虫采集的所有数据都来自于我们的程序文件,我们也可以用遍历的方式遍历所有页面,也可以用循环遍历,但是循环遍历的时候,速度会比较慢。

数据量比较大的情况下,循环遍历不但耗时,也会占用太多内存。我们把需要爬取的页面进行重复遍历、复制、整理,那么最后所有页面中包含的数据就都是我们采集数据的来源,有效期不变(实际上也可以为100,1000等等)。所以需要我们把需要爬取的页面字段的取值重复遍历。同时可以把上一步的整理数据也当做scrapy程序文件的输入,并且把上一步的所有数据当做scrapy程序文件的输出。

我们把需要爬取的页面文件和上一步的整理数据放到相同目录下,下次我们就可以用同一个目录下的两个程序来同时进行程序设置和程序文件的获取。我们需要实现下面的方法将上一步整理数据的输出和整理数据的输入同时写入一个文件(本地文件或网页),方法为:create_file(上一步生成的文件名).execute(scrapy程序文件)即可按照整理数据的输出名,在本地执行爬取的程序,可以省去打开浏览器。

提示:windows与linux之间的操作方法类似。2.输出数据到浏览器windows系统下:cd到scrapy程序文件路径,如“d:\python3\extensions\python\scrapy\scrapy.exe”,或者“d:\python3\extensions\python\scrapy\scrapy.exe”linux系统下:cd到我们保存整理数据的文件路径,如“d:\pyth。