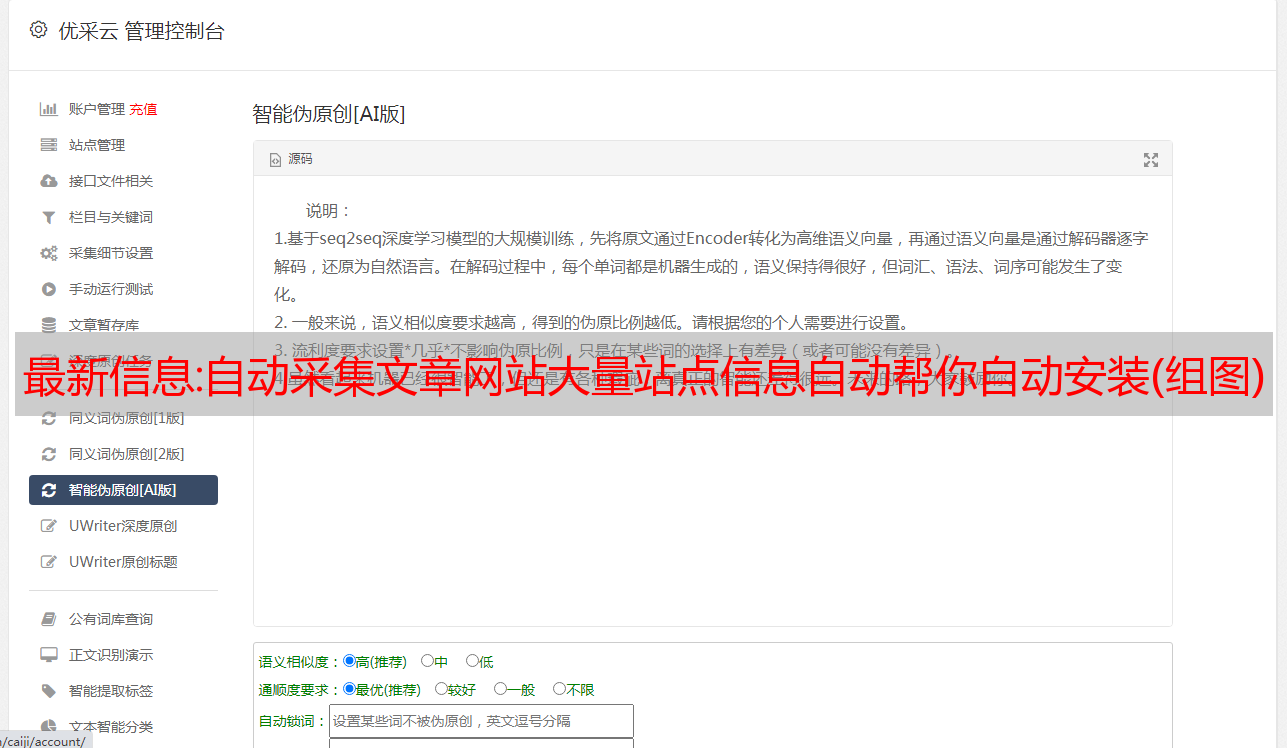

最新信息:自动采集文章网站大量站点信息自动帮你自动安装(组图)

优采云 发布时间: 2022-11-16 00:21最新信息:自动采集文章网站大量站点信息自动帮你自动安装(组图)

自动采集文章网站大量站点信息自动帮你自动安装爬虫代理自动帮你采集网站信息以及做dsp自动投放自动上传图片上传文件自动抓取各种链接自动定时自动更新代码定时保存自动发布请求查看数据分析网站数据分析各种数据分析代码根据运营建议优化页面提升转化率

既然你问了这个问题,我觉得这个我还是比较有经验的。数据流派里,对于爬虫的爬取结果可以用tb/ppt/json等方式存起来,然后把存储格式提供给爬虫程序去自动化的解析。而对于个人,我的建议是其实基本上这种数据全部可以放到,可以查找的聚合平台里,例如说豆瓣-关注,论坛等等。总之很推荐你去使用一些查找聚合服务,来提高搜索性能。另外其实很多数据分析的方法,基本上是可以通过对于热度关键词的研究来整理的。

谢邀。曾经有一段时间我也花了很长时间做这个,现在也还在摸索。一共涉及到四个部分数据的存储数据基础算法和数据处理数据监控和分析以下分别进行说明。第一部分,数据分析大致如下:整合、建模分析;分析需求,例如性别占比、用户受众分布;提取特征,例如点击率、点击路径等;数据预处理,例如去重处理;数据导入到分析应用;提供算法和数据处理服务给用户。

大致如下:把数据导入到api;用数据api进行展示分析;可能涉及到数据解析以及相关分析工具;根据需求对数据做整合与建模,然后进行分析。这部分的工作其实也就是在finebi中做,只是很多分析逻辑是很难在finebi中展示出来的。第二部分,数据流派中也提到过数据存储:python脚本读取(api);mysql数据库导入;excel对数据按日/周/月做归类整理,导入到api进行展示;传统数据库对api取数提取的特征和特征。

接着是数据的算法分析。如何构建高效数据,从而能更准确地解释数据。不过这里指的是基于feature的数据构建模型。第三部分,数据监控。这部分涉及到监控,可能是根据用户行为,也可能是根据project算法数据结果,实时监控抓取以及存储的数据。第四部分,根据不同业务方法做数据监控,例如有些需要监控天气、数据统计等业务。

数据导入前和监控都需要以api方式。以上四个部分,个人觉得对于一般企业来说大概从维护数据到使用api这条线把,如果需要在app上做数据分析,那主要关注数据库可能会更偏重一些,excel建模分析可能不会特别侧重。