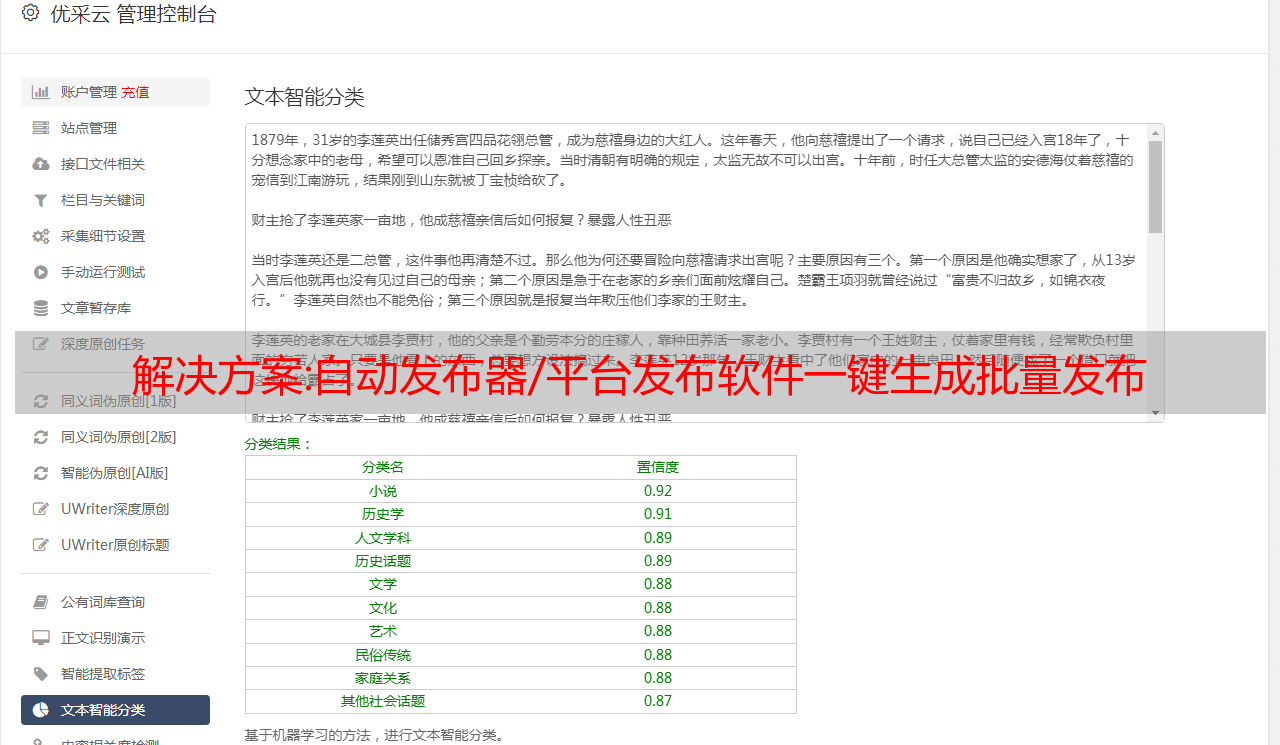

解决方案:自动发布器/平台发布软件一键生成批量发布

优采云 发布时间: 2022-11-11 03:07解决方案:自动发布器/平台发布软件一键生成批量发布

一键批量发布自动发布/平台发布软件-万花筒

乐推软件具有以下特点: 1、对于已经办理过B2B收费的会员,每天可以发送上千条消息。麻木了吗?*敏*感*词*钱。

2.支持自动随机生成标题,自动城市名和任意结尾词,标题对应内容,图片自动上传,无数句子可以组合成不同的原创内容,只要你发站出色地!您可以从已设置的不同内容中随机选择一个内容。

3、可实现*敏*感*词*B2B;包括门户博客和大型、文章投递、分类信息、贴吧问吧、WIKI百科、相册、评论、各种中小博客等高价值自动注册和文章信息会自动发布。

4.可以设置固定数量的帖子然后跳转到另一个继续发帖,并且可以添加无数个自动切换帖子。

5、可设置完成任务后自动关机。晚上可以自动让电脑发布,无需工作人员在现场工作,可以根据自己的网络设置发布速度。自动发帖

6、收录诸多智能功能如:一键采集关键词、一键采集图片、自动生成标题、自动生成内容、随机智能过滤各种词等;

7、批量产品推广、信息发布、产品信息免费送达。

8.有的可以多轮发布,最大的信息量可以随心所欲的发布!并且发布的产品标题和内容的重复率几乎为零。,您可以设置每次发布的条数,或者批量更新信息。

欢迎来到深圳市创变网络*敏*感*词*网站。具体地址为宝安区西乡街道古兴社区唐东光电研发大楼1-1501。负责人是孟琳琳。

Contact Mobile是主要运营八方资源网的一站式企业服务平台,提供B2B行业海量行业信息、供应信息、采购信息、公司黄页信息。致力于为中小企业提供域名空间、网站建设、商机发布、网络营销、搜索引擎优化等一站式电子商务解决方案。.

单位注册资本 本单位注册资本小于100万元。

解决方案:基于 Golang 的云原生日志采集服务设计与实践

- 背景 -

云原生技术的浪潮已经到来,技术变革迫在眉睫。

在这一技术趋势下,网易推出了青州微服务云平台,集微服务、Servicemesh、容器云、DevOps等于一体,在公司集团内部得到广泛应用,也支持众多外部客户的云原生转型。和迁移。

其中,日志是很容易被忽视的部分,但却是微服务和DevOps的重要组成部分。没有日志,就无法解决服务问题。同时,日志采集的统一也是很多业务数据分析、处理、审计的基础。

但是在云原生容器化环境中,采集 的日志有点不同。

- 容器日志的痛点采集 -

传统主机模式对于部署在传统物理机或虚拟机上的服务,日志采集工作清晰明了。

业务日志直接输出到主机,服务运行在固定节点上。手动或使用自动化工具,在节点上部署日志采集代理,添加代理配置,然后启动采集日志。同时,为了方便后续的日志配置修改,也可以引入配置中心,发布代理配置。

Kubernetes 环境和在 Kubernetes 环境中,情况并没有那么简单。

一个 Kubernetes 节点上运行着很多不同服务的容器,容器的日志存储方式也有很多种,例如 stdout、hostPath、emptyDir、pv 等。由于频繁的主动或被动迁移,频繁的销毁和在 Kubernetes 集群中创建 Pod,我们不能像传统方式那样手动向每个服务发出 log采集 配置。另外,由于日志数据会集中存储在采集之后,所以根据namespace、pod、container、node等维度,甚至是环境变量和标签等维度对日志进行检索和过滤是非常重要的。容器。

以上都不同于传统log采集配置方式的需求和痛点。究其原因,传统方式与Kubernetes脱节,无法感知Kubernetes,无法与Kubernetes集成。

随着近年来的快速发展,Kubernetes 已经成为容器编排的事实标准,甚至可以被视为新一代的分布式操作系统。在这个新的操作系统中,控制器的设计思想驱动着整个系统的运行。控制器的抽象解释如下图所示:

由于 Kubernetes 良好的可扩展性,Kubernetes 设计了自定义资源 CRD 的概念。用户可以自己定义各种资源,在一些框架的帮助下开发控制器,用控制器把我们的期望变成现实。

基于这个思路,对于日志采集,记录一个服务需要采集,需要什么样的日志配置,是用户的期望,而这一切都需要我们开发一个日志采集 的控制器来实现。

- 探索与建筑设计 -

有了上面的方案,除了开发一个控制器,剩下的就是围绕这个思路做一些选型分析了。

日志采集代理选择日志采集控制器只负责连接Kubernetes和生成采集配置,不负责真正的日志采集。目前市面上有很多log采集代理,比如传统ELK技术栈的Logstash、CNCF*敏*感*词*项目Fluentd、最近上线的Loki、beats系列的Filebeat等。下面进行简要分析。

代理集成方式对于日志采集代理,在Kubernetes环境中一般有两种部署方式。

1、一种sidecar方式,即与业务容器部署在同一个Pod中。这样Filebeat只需要采集业务容器的日志,只需要配置容器的日志配置即可。很简单,隔离很好,但最大的问题是每个服务必须有一个Filebeat才能去采集。通常,一个节点上有很多 Pod,合并后的内存等开销并不乐观。

2. 另一种也是最常见的方式是在每个节点上部署一个 Filebeat 容器。相比之下,内存占用一般要小很多,而且对 Pod 没有侵入性,更符合我们平时的使用习惯。

同时普遍采用Kubernetes的DaemonSet部署,省去了Ansible等传统自动化运维工具,部署和运维效率大幅提升。

所以我们优先使用 Daemonset 来部署 Filebeat。

- 整体结构 -

选择Filebeat作为日志采集代理,集成自研日志控制器后,从节点的角度来看,我们看到的架构如下:

日志平台下发特定的 CRD 实例到 Kubernetes 集群,日志控制器 Ripple 负责 List&Watch Pods 和来自 Kubernetes 的 CRD 实例。通过Ripple的过滤和聚合,最终生成一个Filebeat输入配置文件。配置文件描述了服务的采集Path路径、多行日志匹配等配置,还默认配置了PodName、Hostname等到日志。在元信息中。Filebeat 会根据 Ripple 生成的配置自动重新加载并采集 登录节点,并发送到 Kafka 或 Elasticsearch。

由于 Ripple *敏*感*词* Kubernetes 事件,它可以感知 Pod 的生命周期。无论 Pod 被销毁还是调度到任何节点,它仍然可以自动生成相应的 Filebeat 配置,无需人工干预。

Ripple 可以感知 Pod 挂载的日志卷。无论是docker Stdout的日志,还是HostPath、EmptyDir、Pv存储的日志,都可以在节点上生成日志路径,告诉Filebeat去采集。

Ripple 可以同时获取 CRD 和 Pod 信息,所以除了默认在日志配置中添加 PodName 等元信息外,还可以结合容器环境变量、Pod 标签、Pod Annotation 等对日志进行标记,以方便后续的日志过滤、检索和查询。另外,我们在Ripple中加入了定期清理日志等功能,保证日志不丢失,进一步增强了日志采集的功能和稳定性。

- 基于 Filebeat 的练习 -

功能扩展 总的来说,Filebeat 可以满足大部分 log采集 的需求,但还是难免有些特殊场景需要我们自定义 Filebeat。当然,Filebeat 本身的设计也提供了很好的扩展性。

Filebeat目前只提供了elasticsearch、Kafka、logstash等几种类型的输出客户端,如果我们想让Filebeat直接发送到其他后端,需要自定义自己的输出。同样,如果您需要过滤日志或添加元信息,您也可以制作自己的处理器插件。不管是加输出还是写处理器,Filebeat提供的大体思路基本一致。一般来说,有3种方式: