核心方法:为什么百度权重会下降?可以利用枫树seo站长工具提高百度权重

优采云 发布时间: 2022-11-09 12:37核心方法:为什么百度权重会下降?可以利用枫树seo站长工具提高百度权重

每个从事SEO的人都会接触到网站权重的概念,每个站长都渴望增加网站权重,但不知道从哪里开始,今天枫叶SEO小编就跟大家一起了解什么是百度权重?为什么网站体重下降了?如何增加百度权重?

什么是百度权重?

网站权重是指一个网站在搜索引擎上的综合排名能力,

但实际上,百度并没有这种说法网站权重,百度权重是由第三方站长工具平台估算的,百度搜索引擎要网站关键词热度评级,分为0~9级,网站权重越高,越网站越受搜索引擎喜爱。

如何检查网站体重?

站长工具可用于查询网站权重,如:Maple SEO、爱站、站长之家等平台可以进行SEO综合查询,定期查看网站权重分析网站数据,可以给出有效的发展计划。

为什么网站体重下降了?

1、网站使用了被百度发现的关键词堆、BLOG群发、斗篷法等黑帽SEO方式,网站被判定作弊后降级;

2、服务器空间宕机,导致网站无法访问或访问速度过慢,搜索引擎蜘蛛抓取网页不流畅,用户浏览体验不好;

3、网站过度的SEO优化,搜索引擎会认为网站是垃圾网站,认为网站在作弊;

4.网站结构模仿其他网站;

5、网站上的内容大多文章通过采集输送其他网站,没有太多实质性和有意义的原创内容;

6.网站动不动就改版,搜索引擎令人难忘,网站频繁的改版会导致搜索引擎下次访问时找到相应的内容进行抓取,从而减少抓取,减轻重量;

7、网站频繁更换网站标题,会导致搜索引擎无法稳定收录网站,权重可能会下降,影响网站的排名;

8. 网站被恶意镜像;

9、竞争对手在网站评论下留下过多垃圾锚文本链接,影响网站反向链接质量;

10、网站长时间未更新,或大部分更新内容与网站主题无关,内容无意义;

11、网站短时间内添加大量反向链接,被搜索引擎判断作弊,导致网站降级;

12. 短时间内反向链接大幅减少也会导致网站降级;

13. 网站朋友链或同一IP地址网站已被搜索引擎判断为作弊并受到惩罚。

如何增加百度权重?

1. 域名和服务器的选择

注册网站域名时,尽量选择有记录、黑历史长的老域名,因为老域名可以增加搜索引擎的信任度;在预算范围内选择最好、高速、稳定的服务器,可以保证搜索引擎蜘蛛和用户可以正常访问网站查看内容。

2. 设置首选域名

由于一个网站中至少有两个域名呈现给搜索引擎,虽然搜索引擎会默认使用同网站有WWW,域名没有www,但为了防止网站多个域名造成权限分散,网站应该选择其中一个域名作为首选域名,这样可以使网站的PR值更加集中和准确。

3. 网址标准化

如果可以通过不同的URL访问网站主页,则需要指定指向主页的URL,并且所有内部和外部链接都集中在一个URL上。

4. 选择合适的关键词

在网站关键词中仔细选择,不要选择竞争太强而无法排名的词。举个例子:如果枫叶SEO网直接把“SEO”作为网站关键词,如果想想“SEO”这个关键词,是不是上千人干的,你如何保证你的网站在这千人中脱颖而出?竞争太激烈了,所以这个时候可以缩小范围,把关键词定为“南宁SEO”,会不会竞争性差很多?这样的关键词排名速度快,也会有效缩短网站发重的时间。

5. 交换好友链,为您的网站添加高质量的反向链接

高质量的反向链接受到搜索引擎的高度重视和信任,将它们链接到网站也可以增加自己网站的权威性。

6. 创建百度百科词条百度百

科权威性很高,如果百度建立自己的网站百科词条,可以获得大量的流量、曝光率和转化率。

7.稳定更新优质网站内容

网站上线后,要持续稳定地更新网站内容,不要全部更新。

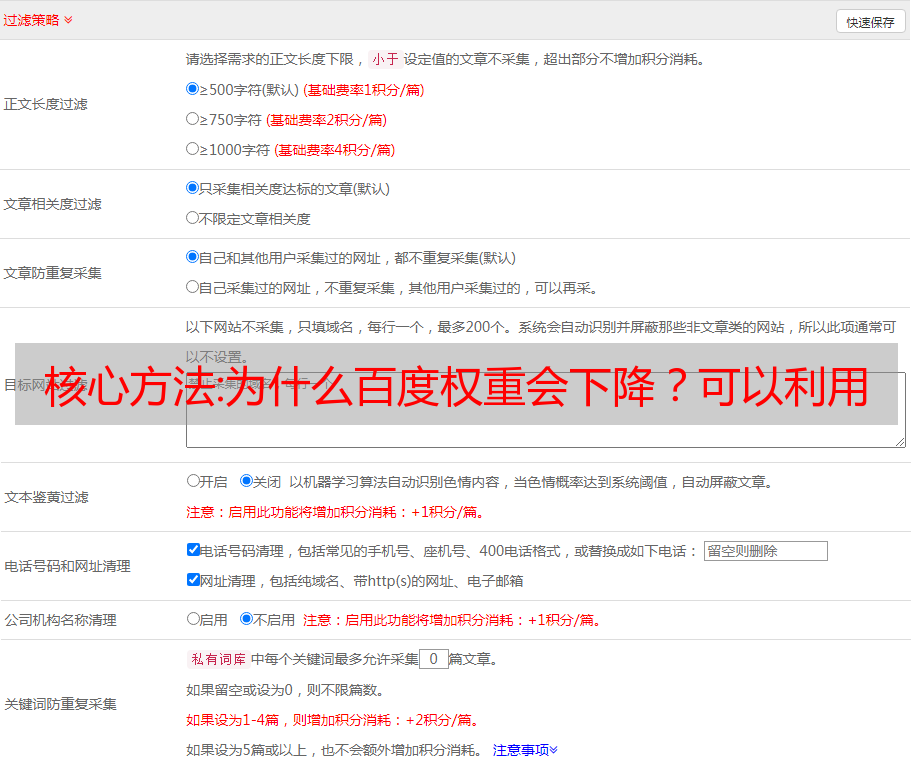

突然而不更新,可以设置一个时间点发布内容,更新的内容应与网站相关,并以解决用户需求为出发点,为用户和搜索引擎提供有价值的内容。您也可以使用 Maple seoURL 推送工具绑定网站,让站长工具自动抓取网站更新的网页并提交给百度,可以减少百度蜘蛛发现网页的时间,加快收录速度,提高网站排名。

8. 网站上的定向锚文本

网站中的每个内页都应该是一个锚文本,以网站权重集中在网站首页上。

9. 面包屑

痕迹导航可以反映网站的结构,可以让用户了解当前位置,可以引导用户通过网站,帮助用户快速了解网站内容,降低网站跳出率;搜索引擎蜘蛛还可以沿着面包屑的链接爬网,非常方便。面包屑不仅有利于搜索引擎爬行,还有助于改善用户的浏览体验,因此您可以在网站中设置它们。

10. 密切关注竞争对手

如果要稳定网站

排名,要时不时观察竞争对手的网站在做什么变化,关键词如何优化,网站排名和收录有没有变化等等,在取其本质去掉渣的过程中,这样你就有机会超越别人。

技巧:抓取网页数据的几种方法[通俗易懂]

抓取网页数据有几种方法【通俗易懂】相信每个网站站长都有抓取别人数据的经历。目前抓取别人的数据只有两种方式网站:1.使用第三方工具,其中最著名的是优采云采集器,这里不再介绍. 2.自己写程序来抓包,这种方式需要站长自己写程序,可能需要站长的开发能力。起初,我也尝试使用第三方工具来获取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不明白怎么用。

大家好,我是建筑师,一个会写代码,会背诗的建筑师。今天就来说说几种爬取网页数据的方法【通俗易懂】,希望能帮助大家进步!!!

我相信所有个人 网站 网站管理员都有捕获他人数据的经验。目前,获取他人网站数据的方式只有两种:

1、使用第三方工具,其中最著名的是优采云采集器,这里不再介绍。

2.自己写程序来抓包,这种方式需要站长自己写程序,可能需要站长的开发能力。

起初,我也尝试使用第三方工具来获取我需要的数据。因为网上流行的第三方工具要么不符合我的要求,要么太复杂,一时不明白怎么用,就干脆决定自己写了。嗯,现在基本上半天就能搞定一个网站(只是程序开发时间,不包括数据采集时间)。

经过一段时间的数据爬取生涯,我也遇到了很多困难。最常见的一种是分页数据的爬取。原因是数据分页的形式有很多种。下面我主要介绍三种形式。抓取分页数据的方法,虽然在网上看过很多文章,但是每次拿别人的代码,总是会出现各种各样的问题。以下方式的代码都是正确的。实现,我目前正在使用它。本文中的代码实现是用C#语言实现的。我认为其他语言的原理大致相同。

让我们切入正题:

第一种方式:URL地址收录分页信息。这种形式是最简单的。使用第三方工具爬取这个表单也很简单。基本上,您不需要编写代码。对我来说,我宁愿花半天时间自己写。懒得学第三方工具的人还是可以自己写代码来实现的;

该方法是通过循环生成数据分页的URL地址,如: 这样通过HttpWebRequest访问对应的URL地址,返回对应页面的html文本。接下来的任务是解析字符串并将需要的内容保存到本地数据库;抓取的代码可以参考以下:

publicstringGetResponseString(stringurl)

{

string_StrResponse="";

HttpWebRequest_WebRequest=(HttpWebRequest)WebRequest.Create(url);

_WebRequest.UserAgent="MOZILLA/4.0(COMPATIBLE;MSIE7.0;WINDOWSNT5.2;.NETCLR1.1.4322;.NETCLR2.0.50727;.NETCLR3.0.04506.648;.NETCLR3.5.21022;.NETCLR3.0.4506.2152;.NETCLR3 .5.30729)";

_WebRequest.Method="GET";

WebResponse_WebResponse=_WebRequest.GetResponse();

StreamReader_ResponseStream=newStreamReader(_WebResponse.GetResponseStream(),System.Text.Encoding.GetEncoding("gb2312"));

_StrResponse=_ResponseStream.ReadToEnd();

_WebResponse.Close();

_ResponseStream.Close();

return_StrResponse;

}

上面的代码可以返回对应页面的html内容的字符串,剩下的工作就是从这个字符串中获取你关心的信息。

第二种方式:可能通过网站的开发遇到,它的分页控件通过post的方式将分页信息提交给后台代码,比如.net下Gridview自带的分页功能,点击页面时分页号,你会发现URL地址没有变,但是页码变了,页面的内容也变了。仔细看会发现,当你把鼠标移到每个页码上的时候,状态栏会显示 javascript:__dopostback("gridview","page1") 等等,这个表格其实并不难,因为毕竟,有一个地方可以得到页码的规则。

我们知道提交HTTP请求有两种方式:一种是get,另一种是post,第一种是get,第二种是post。具体提交原理无需赘述,不是本文重点

爬取这类页面需要注意页面的几个重要元素

1. __VIEWSTATE,这应该是.net独有的,也是.net开发者又爱又恨的东西。当你打开网站的某个页面时,如果你发现了这个东西,并且后面有很多乱七八糟的字符,那么这个网站一定要写;

2、__dopostback方法,这是页面自动生成的javascript方法,包括两个参数,__EVENTTARGET,__EVENTARGUMENT,这两个参数可以参考页码对应的内容,因为当你点击翻页时,页面号码信息将传递给这两个参数。

3. __EVENTVALIDATION 也应该是独一无二的

不需要太在意这三样东西是干什么的,只要在自己写代码抓取页面的时候记得提交这三个元素就可以了。

和第一种方法一样,_dopostback的两个参数必须通过循环拼凑,只有收录页码信息的参数需要拼凑。这里有一点需要注意,就是每次通过Post提交下一页的请求,都应该先获取当前页的__VIEWSTATE信息和__EVENTVALIDATION信息,这样第一页的分页数据就可以可以通过第一种方法获得。然后同时取出对应的__VIEWSTATE信息和__EVENTVALIDATION信息,然后循环处理下一页,每爬完一页后,记录__VIEWSTATE信息和__EVENTVALIDATION信息,提交给下一页post数据使用

参考代码如下:

for(inti=0;i