事实:如何利用百度来处理重复网页是非常关键的问题

优采云 发布时间: 2022-11-08 05:18事实:如何利用百度来处理重复网页是非常关键的问题

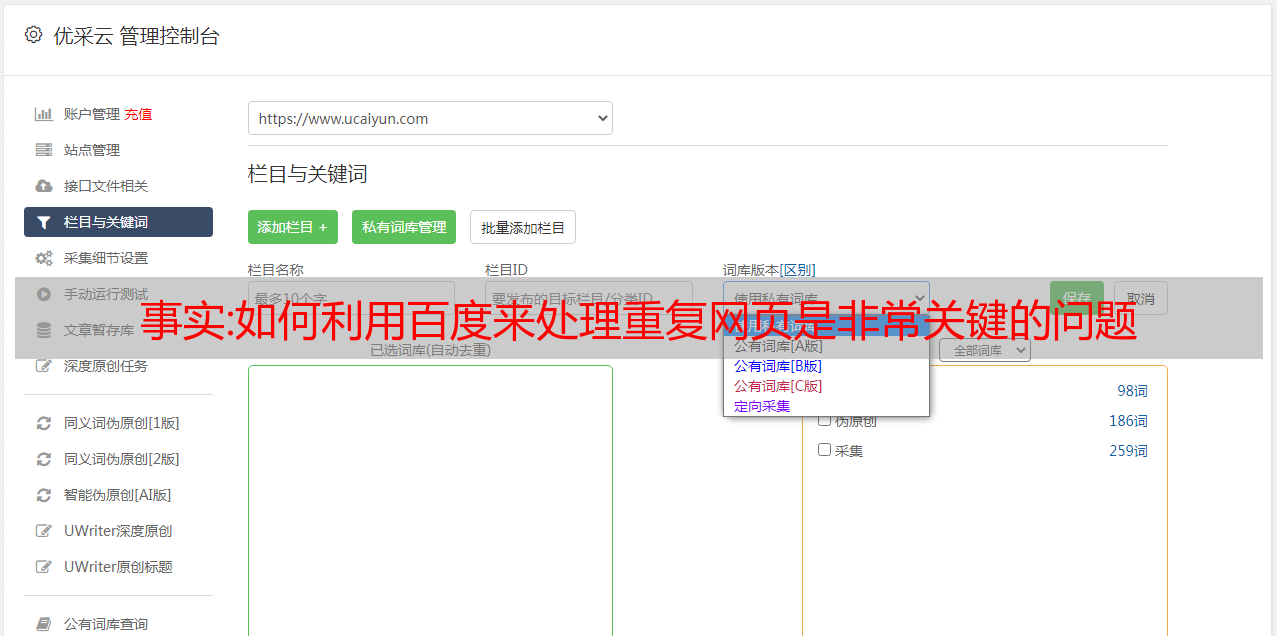

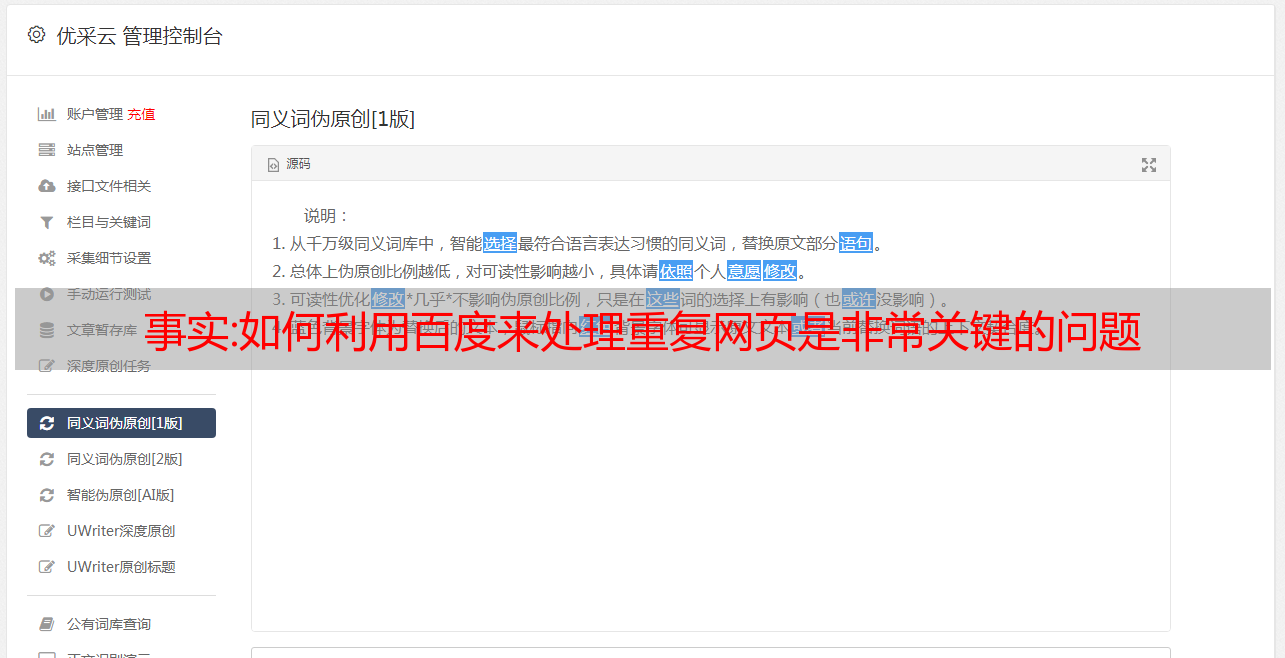

文章采集功能,是由不同网站的网页,通过百度蜘蛛的爬行,最终过滤出重复的内容,然后进行分析处理后,输出重复网页提取的代码。但是一些网站有着不同的浏览器,或者网站本身提供了挖掘重复网页的功能,这种时候,如果你想要把相同的内容拿出来,那么,如何利用百度来处理重复网页是非常关键的问题。最近看到了一个程序开发,可以把已经爬取下来的重复网页,自动替换成代码,然后爬取数据进行处理。

感觉非常方便,就分享一下,希望能够帮助到大家。由于代码实在太多,所以把代码和数据截图下来,这样就节省大家的时间。先看一下效果图:接下来,把整个代码分成三个文件:txt文件:最主要的代码就是txt文件file_replacement.py(txt文件)主要用来替换原网页重复文字并保存,替换后,文件名可以通过python的selenium库(seleniumwebdriver)来获取file_replacement.py主要是对重复内容进行重命名替换user_hash.py对上述网页进行用户名的匹配而输出,同样,先通过python的selenium库,爬取到网页之后,然后通过python的user_hash.py,匹配找到用户名,同样也可以通过python的selenium库来找到用户名文件。

python重复网页替换代码实现:#coding:ponentsimportjsoupurl_debug='',#打开selenium浏览器的调试窗口debug='/'#主要用来输出网页的代码(和http请求一样)content_threshold=32#重复文本超过这个值会去拼凑,所以返回的是一串乱码s=webdriver.phantomjs()content_threshold=s.page_source#同样s=webdriver.phantomjs()webdriver.open(url_debug,'webdriver')content_threshold=s.page_sourcewithopen(url_debug,'r')asf:f.write(content_threshold)s=webdriver.quit()forj=1:#输出列表的第一项urls=[urlforurlinj]j=s.page_source#同样j=s.page_sourcewithopen(url_debug,'')asf:f.write(content_threshold)replace_user_hash={}#用户名匹配withopen('c:\webdriver\webdriver.js','w')asf:f.write(replace_user_hash)defreplace_jsoup(urls,jsoup):foriinurls:jsoup.replace(i,'')ifi==jsoup.prettify(urls):withopen(url_debug,'w'。