官方数据:数据采集在网站运营中有什么作用

优采云 发布时间: 2022-11-08 04:15官方数据:数据采集在网站运营中有什么作用

数据 采集 在 网站 操作中扮演什么角色?在这个大数据时代,数据采集是我们无法回避的话题。通过data采集可以了解行业动态,也可以通过data采集了解我们用户的相关信息,当然这些都需要分析。所以不管怎样,只要能通过数据记录,就离不开数据采集。

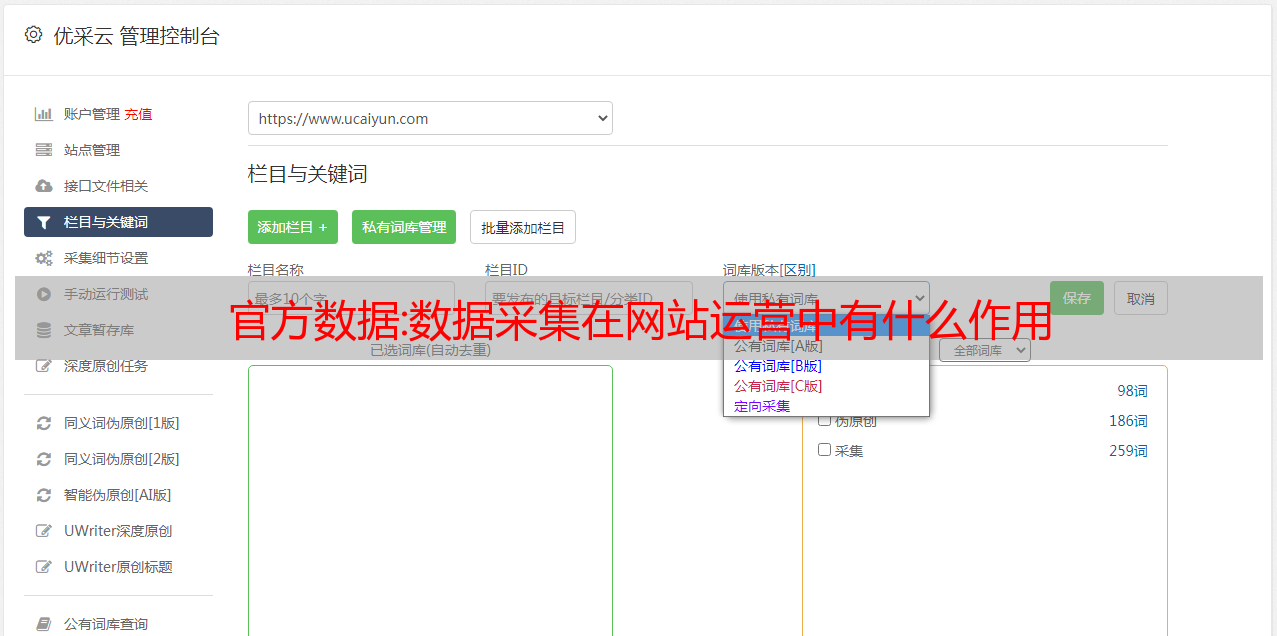

网络数据采集由于采集的数量巨大,网络数据复杂。往往需要我们掌握复杂的采集规则才能完成采集。其实我们可以通过data采集软件来做采集。

数据采集软件页面简洁,具有定向采集和增量采集功能,在插件页面输入URL即可选择,所有操作可见,采集支持标签保留、图片水印去除、敏感词过滤等,保证采集数据和内容准确可用。

对网站来说,流动和血液一样重要,没有流动的网站就没有生命力。无论我们选择哪种方式,从事网站运营的人从搜索引擎获得流量,SEM和SEO有两种方式。说到采集,大家可能首先会想到采集网站,认为SEM不需要使用采集。其实这是一种错误的看法。

对于互联网新手或新手站长来说,SEO和SEM的概念以及它们的优缺点不是很清楚。下面博主将为大家展示SEO和SEM的优缺点。

SEO是在符合搜索引擎规则的前提下,通过一系列优化让我们的关键词排名靠前,网站获得自然流量的一种方式。通过SEO获得的流量是比较持续的。即使经过SEO优化的网站终止了SEO服务,如果关键词的排名没有变化,那么它拥有的自然流量在一段时间内也不会消失。将保持在稳定的流量范围内。当然,做SEO也有不足之处。比如传播成本高,网站的展示和点击没有保障,关键词的排名和流量波动稳定性差。

SEM的优势非常明显。可以让网站关键词的排名占据显着位置,短短几分钟的流量就能实现质的飞跃。SEM方法的缺点也比较明显,主要体现在成分高。相对于 SEO,用户转化率较低。SEM服务停止后,流量会一落千丈,不可持续。

不管我们选择SEM还是SEO,都需要用到data采集。比如建站之前,我们用data采集对比行业数据采集,选择cms或者关键词有个大概的了解。比如在SEO过程中,我们可以通过采集industry关键词得到自己的关键词,然后通过数据和自我分析。所以 data采集 是我们的 网站 构造、网站 操作和优化中不可访问的部分。

汇总:网站日志分析常用工具,如何对网站日志进行提取404页面链接?

网站常用的日志分析工具,为什么要分析网站日志?作为一名合格的seo优化师,网站日志分析是必不可少的seo工作。为什么要分析 网站 日志?分析什么?网站日志分析常用的工具有哪些?别担心,这里有详细信息:

高端网站建筑"/>

深圳高端网站建设

网站日志分析常用的工具有以下两个,因为现在市面上的分析工具很多,只要能用这两个分析工具就够了。可以说,这两款分析工具真是天作之合。一个是日志分析工具,叫“Lagehao”,URL是“”;另一种是shell命令下的cygwin日志分析工具。

网站的日志分析的目的,无非是为了让网站做更好的seo优化,查询网站的一些数据?你可以知道搜索引擎蜘蛛的来龙去脉,知道它喜欢爬哪些页面,停留时间,蜘蛛来爬的时间段?什么重量的蜘蛛来爬行?是什么蜘蛛来爬的?还有很多。如下所示:

从图中可以看出,如果你的网站是大站点,那么大站点难免会被修改,网站也会出现死链接等很多问题。当然,日志分析将发挥重要作用。借助这些分析工具,您可以一步解决。但是,这个好的分析工具并不能完全提取404等链接并保存在文件中。需要一一复制粘贴。如果有数千个 404 页面怎么办?是不是有点不切实际?这也是它的缺陷。所以需要这个分析工具来配合“Cygwin”。这个工具可以从官网第一页百度搜索“cygwin”下载。

如何使用cygwin提取404页面链接?方法步骤如下:

1.还需要安装一个工具:Notepad++;

2.以百度搜索引擎蜘蛛爬取为例:打开cygwin,输入:pwd,就可以知道自己的安装路径;

3. 将你下载的网站日志修改为.log并保存为文档。将此文件放入安装目录;如下所示:

4、将百度抓取的所有链接分开;然后,用记事本++打开刚才百度抓取的文档;

5、因为我们要查找404页面的所有链接,找出状态码在哪一行。我这里是第九行,其中一个圆圈代表一行,也就是一个空的地方就是一行,如如下图所示:

6.找到所有404页面后,我们要的是它的链接,所以找到链接的行数并提取: 但是可以看到404的所有链接,当然需要在前面加上你关联。域名,替换掉,然后将所有链接提交到百度站长后台。整个过程就结束了。当然这里涉及到一些代码,可能有些人看不懂。没关系。我也会把代码步骤发给大家,自己想一想,学会了是你的。

Cygwin日志分析查询工具使用步骤如下:

1、分离蜘蛛:输入 cat 1.log|grep 'Baiduspider'|head -5 回车;

2.然后输入:cat 1.log|grep 'Baiduspider'>>baidu.txt;

3、再次判断404情况:统计状态码的命令: $ cat baidu.txt|awk '{print }'|sort|uniq -c 那么一行中的这个“9”是什么意思呢?

4.然后输入:$ cat baidu.txt|grep '404'>>404.txt回车;

5.然后输入:$ cat 404.txt|awk '{print }'>>baidu404.txt回车;

6.查看一个链接被重复爬取的次数,然后给他做相应的nofollow操作:输入:cat baidu.txt|awk '{print }'|sort|uniq -c 然后回车查看到达;

查看你的专栏被爬了多少次:输入:$ cat baidu.txt|awk '/hlw/'|sort|uniq -c 然后回车;如果后面网站出现不是收录的问题,可以用这个查询方法解决问题的根源。好了,成长超人就在这里跟大家分享一下!

Growthman Growthman 专注于为企业提供数字营销服务。成长超人作为营销成长、高端网站建设、网站制作公司,先后为富士康、钉钉、泰菱、天虹、爱尔眼科、海澜集团、金蝶、飞亚达、云米等知名企业提供专业成长服务。

官方网站: