解读:教大家如何利用采集豆瓣电影top250内容,挖掘用户画像的潜在价值

优采云 发布时间: 2022-11-07 01:06解读:教大家如何利用采集豆瓣电影top250内容,挖掘用户画像的潜在价值

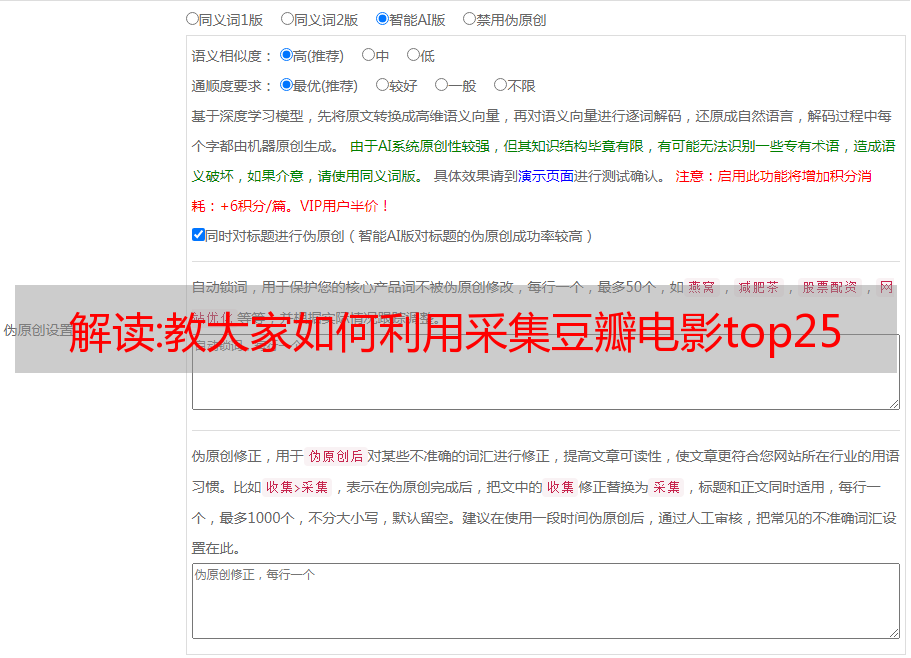

文章采集文章采集是网络爬虫与文字工程常用的技术之一,它的用途非常广泛,可以帮你爬到你想要的结果,并且在公司内部应用非常广泛。本文将教大家采集豆瓣电影top250内容,目前有总共6821部在豆瓣可以找到。同时,我也将教大家如何利用采集到的数据进行数据分析与机器学习,挖掘用户画像的潜在价值。设置环境我们使用python的urllib2库来抓取豆瓣的数据。

我们首先要进行的是设置采集规则:一般可以使用requests库将request_headers传入urllib2程序内部来设置规则,headers传入urllib2后我们可以得到error等信息。所以首先我们需要先将urllib2设置好:可以参考python爬虫的urllib2设置requests设置下面这个代码我们设置request的头部信息和cookie等,通过urllib2程序内部的beautifulsoup_extract_tags函数对request_headers和error进行解析:urllib2接收了url的请求头和请求tags,tags对应了请求的关键字。

于是requests就请求成功了。最终我们会得到一个url,需要解析出信息的数据就可以得到最终的结果了。由于是分析评论,我们需要了解各个评论的总和,其中评论人数top25是列表,有名字就可以直接进行爬取了。将总和相加会得到ulist,ulist可以获取评论的总数。并且ulist是包含评论人数信息的一个文本文件。

这里我们要使用解析json格式的方法解析出评论信息:解析完后就可以进行机器学习挖掘了,可以用一些分词,聚类,关联性,反文本等等的方法去利用分析的结果去挖掘用户画像。上面这部分文字是没有写入sql数据库的,我们还是需要将数据写入mysql:获取到文本后,本质上需要解析得到评论数据,再将数据存储。为此需要知道标题,评论链接,评论内容等等评论数据,我们常用的有json格式的方法,这里也是需要进行相应处理的。

否则需要写入特定的文件里再将结果同步到mysql。评论发布得到文本后,我们还需要制作评论在页面中的*敏*感*词*,也就是在标题下面会出现一些小的链接,这些链接是每一个评论的开始,我们只需要找到这些就可以将这些短评很好的记录下来。首先还是通过链接上的长短来将*敏*感*词*切分:将所有标题前面加上---link,这个可以将短评划分成多个部分,同时如果不想打开超链接,可以加上一些link白名单。

然后就将*敏*感*词*填入数据库:数据分析的方式首先使用pandas库将得到的数据进行整理。再次是将分析结果存储为csv格式,我们采用的是excel作为分析结果。首先有两种方式进行处理数据,一种是用脚本直接将文本发布出去,另一种是使用数据库。