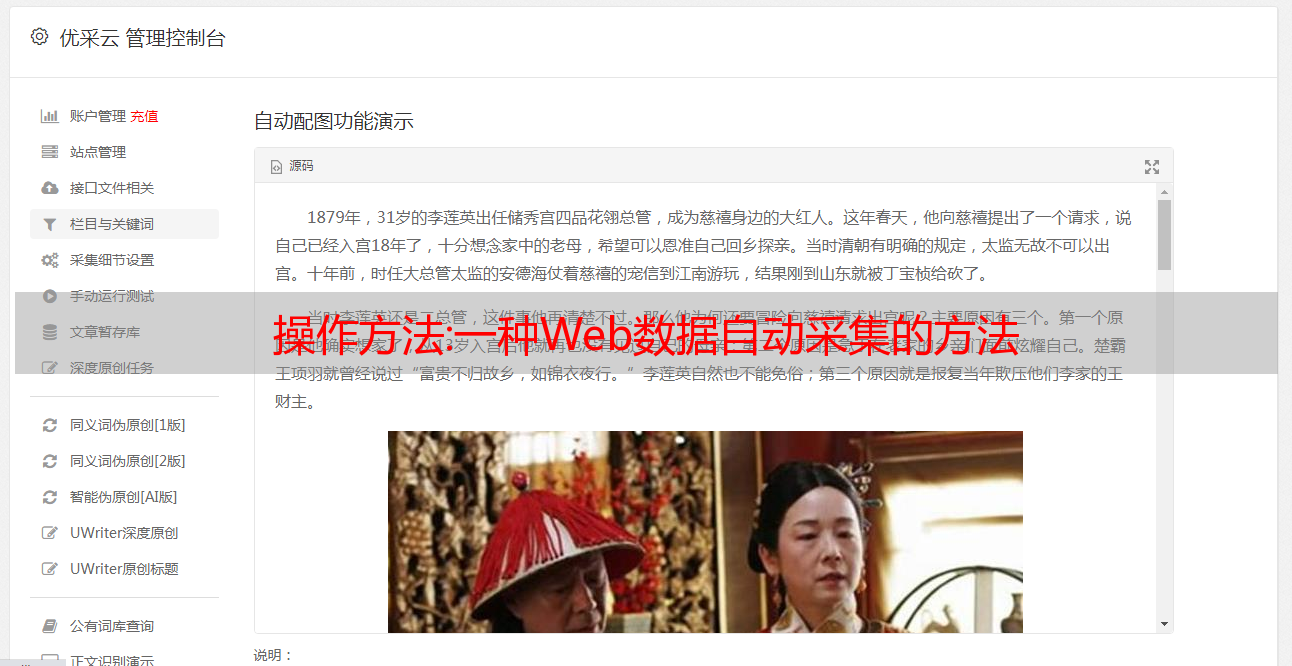

操作方法:一种Web数据自动采集的方法

优采云 发布时间: 2022-11-06 05:26操作方法:一种Web数据自动采集的方法

一种自动采集网络数据的方法

【摘要】本发明公开了一种网络数据自动采集的方法,包括以下步骤:网络机器人技术和网络数据提取技术;原理、深度优先搜索策略和广度优先搜索策略、网络陷阱、平衡访问和超链接提取;网页数据提取技术包括网页纯文本的提取和文本中特殊字符的分析处理;本发明提供一种Web数据自动化采集方法,充分利用网络机器人技术和网页数据提取技术,形成Web自动化采集方法,从海量信息中采集有价值的数据并进行分析和分析。研究,形成各类企业。

【专利说明】一种向上力数据自动采集的方法

【技术领域】

[0001] 本发明涉及数据采集技术,特别是一种数据自动采集的方法。

【背景技术】

随着网络资源的不断丰富和网络信息的不断扩展,人们对网络的依赖越来越强,但也带来了服务对象从浩瀚的互联网资源中快速找到自己需要的具体资源。不便; 信息自古以来就具有无限价值。随着时代的不断发展,人类在不知不觉中已经进入了信息时代。各行各业都充斥着无数信息,信息的价值在于数据的流通。只有能够及时流通和传递,才能发挥信息真正的不可比拟的价值;在市场经济条件下,采集数据成为重要的工具和手段。

如何从海量信息中采集有价值的数据并进行分析研究,形成企业各种决策的依据,是数据人员和市场研究人员面临的问题;快速查找和获取他们需要的信息和服务变得越来越困难。在查询信息时,服务对象往往会失去目标或得到一些有偏见的结果;数据必须经过聚合、整合、分析才能产生价值,分散的信息只能是新闻,不能反映真实的商业价值;对于企业和信息分析师来说,一方面要从大量信息中筛选出有效价值点,同时减少相应价值点的获取。

互联网的普及和信息技术的发展,形成了大量的信息资源;从海量信息中提取有用资源是目前急需解决的问题,而1613页面表达的主要信息通常隐藏在大量不相关的结构和文字中,阻碍用户快速获取主题信息和限制了166的可用性,auto采集有助于解决这个问题,auto采集省时省力,信息覆盖面广,但信息提取质量不高,会影响准确率;所以大部分数据采集工作现在都是自动化的采集;自动采集技术在此上下文中生成。

【发明内容】

[0005] 本发明针对上述问题,通过网络机器人技术和应用网页数据提取技术,开发了一种166数据自动采集的方法。

本发明的技术手段如下:

一种数据自动采集的方法,其特征在于包括以下步骤:

八、网络机器人技术:

八 1、设计网络机器人工作流程:以一个或一组嘴为浏览起点的机器人访问相应的胃文档,所述胃文档为文档;

八 2、制定网络机器人设计原则;

21、制定机器人不包括的项目标准:在服务器上创建机器人文本文件,在该文本文件中说明网站不能访问链接和网站拒绝访问的机器人;[0012] ]A22. 制定机器人META标签:即用户在页面上添加META标签,META标签允许页面所有者指定是否允许机器人程序对页面进行索引或从页面中提取链接;

A3,深度优先搜索策略和广度优先搜索策略;

A31、深度优先搜索策略是从起始节点开始,分析第一个文档后检索第一个链接指向的页面,分析完页面后检索其第一个链接指向的文档重复执行直到一个文档找到不收录任何超链接的,将其定义为一个完整的链,然后返回一个文档,继续选择该文档中剩余的超链接。搜索结束的标志是 all 超链接已经搜索过;

A32、广度优先搜索策略,就是在分析完第一个文档后,搜索本网页中的所有超链接,然后继续下一层的搜索,直到底部搜索完成;

A4、网络陷阱;

A41、将列列表中的URL与要搜索的URL和访问新URL前的已搜索URL进行比较,这个比较是URL对象之间的比较,将未收录在列列表中的URL添加到URL中被搜索。避免掉入网络陷阱的 URL 列表;

A42、在提取Web文档的超链接时忽略所有提供参数的URL;

A43,限制机器人搜索深度;达到阈值搜索深度后停止向下搜索,其中每进入下一级子链接即表示已达到新的搜索深度。或者设置访问Web服务器的最大时长,当机器人访问Web服务器的第一个网页时,计时开始。超过最大时间段后,在服务器上爬行的机器人程序立即断开与服务器的所有链接;

A5、平衡访问;设置访问Web服务器的最大线程数,并使用等待模式来限制机器人程序或进程对特定服务器和网段的访问频率;每当机器人程序或进程从某个网站获取文件后,该机器人程序或进程会等待一定的时间间隔再次对该网站进行新的访问,根据网站处理能力和网络通信情况确定等待时间的长短能力,下次访问该网站的时间T1是当前时间T2加上在互联网上访问该网站所需的时间,访问该网站所需的时间是网络传输时间Τ3乘以设定系数;

A6、超链接提取;机器人程序在获取URL链接的同时,继续对获取的链接对应的Web源文档进行data采集,并将Web源文档转换为字符流的形式;

B、网页数据提取技术;

B1、网页纯文本的提取;将得到的HTML源文件过滤处理并删除标签控制字符提取文本信息,过滤网页数据后统一网页数据字符格式;

[0024] B2、对文本中的特殊字符进行分析处理。

由于采用上述技术方案,本发明提供的一种Web数据自动化方法,充分利用网络机器人技术和网页数据提取技术,形成Web自动化方法,从海量信息中采集有价值的数据进行分析研究形成企业各种决策的依据,解决数据采集人员和市场研究人员面临的问题,扩展Web的可用性。数据采集,特别是自动数据采集的开发做出了一定的贡献。

【专利图纸】

【图纸说明】

图1为本发明的网络机器人工作流程图;

[0027] 图2为本发明HTML网页纯文本提取的流程图。;在自己的页面上添加一个腿丁巴标记;Ruler01301:ruler01301 程序索引你自己的页面或从这个页面

战略;

开始,分析完第一个文档后,取回第一个链接指向的文档,反复执行,这是一条完整的链,然后返回某个结束标志,没有其他超链接可以搜索

分析后,首先搜索胃613页面中的所有3层;:确定设计者采用的优先策略;由于机器实现的关键问题是我们从末尾添加要搜索的队列,从头开始取出,就构成了广度优先遍历;形成深度优先遍历;1:描述流程,直到处理完文档中所有的“<8”标记:在连接时,II连接和获取的链接对应的数据应该是连续连接的;为了更准确的执行显示

确定信息的效率和质量采集;

i肌肉11个源文件在输入所有“?”后过滤去除相邻“>”标记的位置 标记和“?” 在源文档上标记,然后去掉两个写,定位后续阶段。由相邻的“<”标记的位置,然后是记数所描述的文本的特征,所以在提取文本时要注意,如果遇到开始标记,可以解析;另一种排除方法是暂时把它当作3处理。如果是脚本则不采集;网页中的分隔符在实际处理文本时,必须根据标签的含义进行分隔。

ETC。; 此类标签在本发明所公开的技术范围内,任何熟悉本【技术领域】的技术人员的语言,均根据本发明的技术方案及其发明构思进行等同替换或变化,均应收录在本发明的保护范围内。

【权利要求】

1.一种Web数据自动采集的方法,其特征在于包括以下步骤: A、网络机器人技术: A1、设计网络机器人工作流程:以机器人以一个或一组URL为浏览起点对应的 WWW 文档是 HTML 文档;A2。制定网络机器人的设计原则;A21。制定机器人未收录的项目标准:在服务器上创建机器人文本文件,文本文件描述网站不可访问的链接和网站拒绝访问的机器人;A22。制作机器人META标签:即用户给页面添加一个META标签,META标签允许页面的拥有者指定是否允许机器人程序对页面进行索引或者从页面中提取链接;A3,深度优先搜索策略和广度优先搜索策略;A31, depth first 搜索策略从起始节点开始,分析第一个文档并检索第一个链接指向的页面,分析页面并检索第一个链接指向的文档,并重复执行。直到找到一个不收录任何超链接的文档,定义为一个完整的链,然后返回一个文档,继续选择文档中剩余的超链接。搜索结束的标志是所有超链接都已搜索完毕;A32、广度优先搜索策略是先分析第一个文档,搜索网页中的所有超链接,然后继续下一层搜索,直到底部搜索完成;A4、网络陷阱;A41,在访问新 URL 之前,将要搜索的 URL 列表中的 URL 与已搜索的 URL 进行比较。此比较是 URL 对象之间的比较。未收录在要搜索的 URL 列表中的 URL 将添加到要搜索的 URL 列表中。进入网络陷阱;A42、提取Web文档超链接时忽略所有带参数的URL;A43、限制机器人的搜索深度;当达到阈值搜索深度时停止向下搜索,并且下一级子链接的每个条目都表明已经达到新的搜索深度;或设置访问 Web 服务器的最长时间。当机器人访问网络服务器的第一个网页时,计时器开始计时。达到最大时长后,在服务器上爬行的机器人程序立即断开连接。与服务器的所有链接;A5、平衡访问;设置访问Web服务器的最大线程数,通过等待将机器人程序或进程的访问频率限制在特定的服务器和网段;站点获取文档后,机器人程序或进程会等待一定的时间间隔,然后重新访问该站点。等待时间的长短根据站点处理能力和网络通信能力来确定。下次访问该网站的时间T1是当前时间T2加上访问该网站所需时间,访问该网站所需时间是网络传输时间T3乘以设定系数;A6、超链接提取;机器人程序同时获取URL链接继续对获取的链接采集对应的Web源文档进行数据处理,并将Web源文档转换为字符流的形式;B.网页数据提取技术;B1、网页纯文本提取;对获取的HTML源文件进行过滤,删除标签控制字符提取文本信息,对网页数据进行过滤后统一网页数据的字符格式;B2、分析处理文本中的特殊字符。对网页数据进行过滤后,统一网页数据的字符格式;B2、分析处理文本中的特殊字符。对网页数据进行过滤后,统一网页数据的字符格式;B2、分析处理文本中的特殊字符。

【文件编号】G06F17/30GK103838786SQ2

【公示日期】2014年6月4日申请日期:2012年11月27日优先日期:2012年11月27日

【发明人】苏晓华、李勇申请人:大连菱东科技发展*敏*感*词*

汇总:案例——Shell定时采集数据到HDFS

在线网站每天都会生成日志数据。如果有这样的需求:需要在运营开始的前一天早上24:00上传日志文件,准实时上传到HDFS集群。如何做到这一点?实施后能否实现周期性上传需求?如何计时?我们可以使用定时任务+shell脚本来完成!!!实现过程中日志文件生成的逻辑由业务系统决定,比如每小时滚动一次,或者一定大小滚动一次,避免单个日志文件太大,操作不便。例如,滚动文件名为 access.log.x,其中 x 是一个数字。正在写入的日志文件称为 access.log。这种情况下,如果日志文件的后缀是1\2\3这样的数字,文件符合要求即可上传,将文件移至待上传的工作区目录。工作区有文本