汇总:实时文章采集(测试用ab对进行访问日志收集(组图)

优采云 发布时间: 2022-11-05 18:17汇总:实时文章采集(测试用ab对进行访问日志收集(组图)

直播文章采集(用ab pair测试访问日志(组图)采集!)

Smart采集器(Smart采集器兼容大部分浏览器,自定义构建工具)

Smart采集器,兼容大部分浏览器,Smart Net采集器,自定义生成。

成为可靠的在线采集管理工具。在线生成工具。目前支持百度、谷歌和搜狗搜索引擎的索引和编辑。可以直接在后台生成。

::--.html可以随便写,但绝对不如手写。

不如写个数据库让他爬,

建议使用录音笔

我可以使用它。如果你不需要它,你可以找我。其他配置不用改,,,,

使用 AWS 将 网站 连接到云服务器,然后连接到独立域名。该单个域的搜索引擎只接受它,而不抓取整个 网站。索引的速度与服务器的速度密切相关。我基于服务器技术构建这些网站,因为除了这个技术之外,还有nginx做负载均衡,+nosql大数据系统,aws+grpc,还有原生css,sass文件抓取等等,所有这些都是必需的他们可以提供免费的sdk,并且可以提供与三角形蛋糕相同的功能。具体如何搭建博客,后面我会写一个文章来介绍。

seoer的工作是什么,寻找热门站点,蜘蛛喜欢的seo站点号采集器,可以放在首页,也可以放在前三页,这不是一个好的选择吗。

Qzone文章采集软件(如何使用它来创造*敏*感*词*的流量网站?如何撰写*敏*感*词*的网站内容)

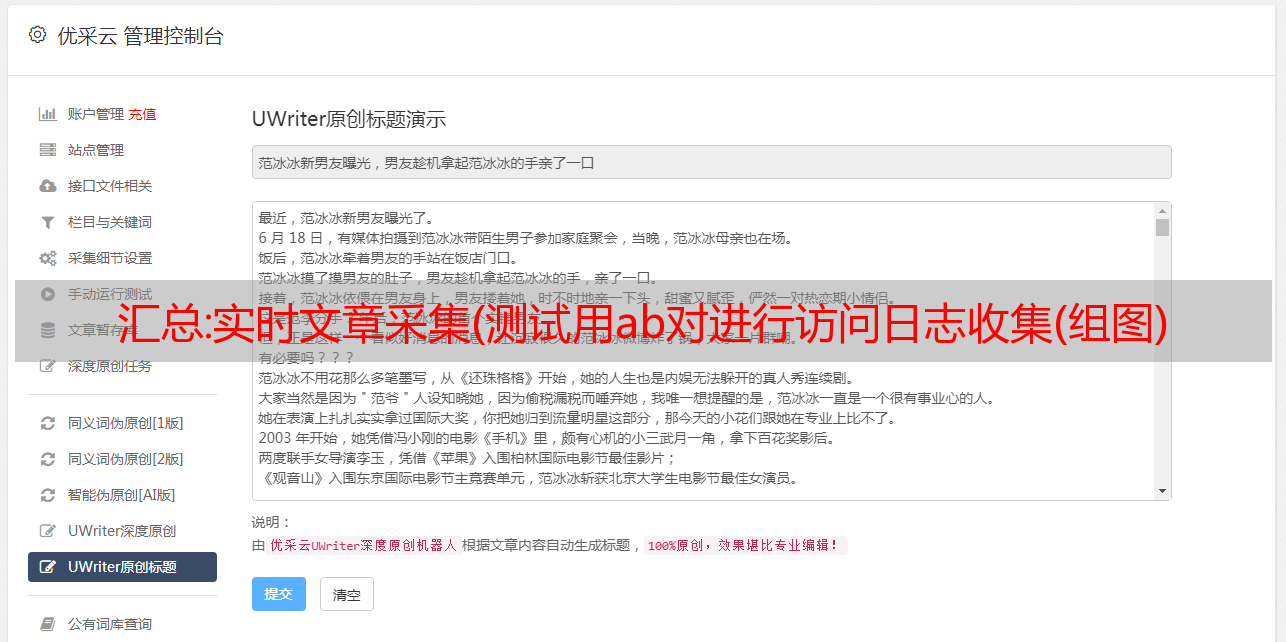

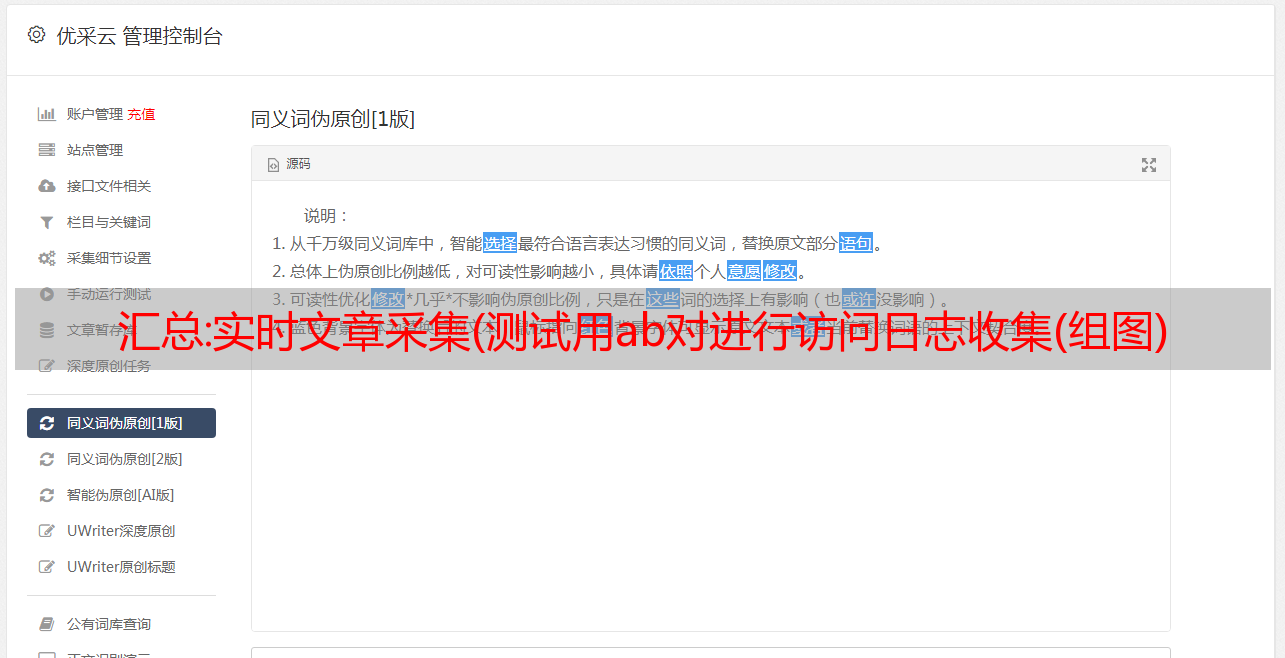

优采云采集器是一个网站采集器智能网络采集器,根据提供的关键词自动采集云相关文章用户并发布给用户 网站。它可以自动识别各种网页的标题、文字等信息,无需用户编写任何采集规则,全网即可采集。内容采集完成后,会自动计算内容与设置关键词的相关性,只推送相关的文章给用户。支持标题前缀,关键词自动加粗,固定链接插入,自动标签提取,自动内链,自动图片匹配,自动伪原创,内容过滤替换,电话号码和网址清洗、定时采集、百度主动提交等一系列SEO功能。用户只需设置关键词及相关要求,即可实现全托管、零维护的网站内容更新。网站的数量没有限制,无论是单个网站还是大站群,都可以很方便的管理。

解决方案:直播回放 | DeepFlow AutoLogging:自动采集应用调用日志和流

左侧是基于 Grafana 构建的应用调用日志的 Dashboard。可以根据TAG过滤应用,根据Protocol过滤HTTP、HTTPS、HTTP2协议,可以查看当前服务的HTTP调用日志。

右边是AccessLog和DeepFlow的应用调用日志的映射。通过对比可以看出,除了remote_user之外,都可以很好的映射。

HTTP访问日志除了替换AccessLog之外,还可以结合调用日志的状态和指标,快速知道哪些调用异常,哪些调用响应慢。

07 应用调用日志——MySQL慢查询日志

对于MySQL慢查询日志,数据库在云上实例化后,查看数据库的日志并不容易。需要在云端开启各种设置和权限才能及时看到日志,也很难快速过滤对应的日志。应用程序日志。

下面我们来看看 DeepFlow 是如何查看慢查询日志的。这和刚才的 HTTP 调用日志是同一个 Dashboard。只需切换搜索条件,将协议切换到 MySQL,将 request_type 输入为 COM_QUREY,将 request_resource 输入为 SELECT*。

设置好这样的过滤条件后,得到MySQL的查询日志,然后对响应延迟进行排序过滤,可以发现慢查询。

08 应用调用日志——分布式跟踪跨度日志

除了看网络应用协议的调用日志外,我们从前面的数据源中也知道,调用日志还支持访问分布式追踪协议的Span信息。

目前,DeepFlow 已经支持连接到 OpenTelemtry 的 Span 信息。每个 Span 实际上对应一个调用。当前显示的是 OpenTelemtry 的 Span 日志。

访问Span的信息后,除了查看日志,根据状态和指标定位调用问题外,还有一个重要的目的,那就是也可以基于DeepFlow平台的现有网络。通过调用eBPF采集,进行全栈全链路跟踪。

09 应用调用日志——全栈全链路追踪

这是最终被跟踪的火焰图。这个火焰图不仅包括应用程序代码级别的调用,还包括系统级别和网络级别的调用。至于这件事如何追查,由于时间问题,我今天不再赘述。我会用后续的直播继续给大家详细分享如何跟踪应用的全栈和全链接。

应用调用日志只能观察应用层面的一些问题。DeepFlow 可以通过 FlowID 关联应用调用背后的网络流日志。接下来分享一下网络流日志的能力。

10 网络流日志 - 功能定义

首先我们看一下公有云中网络流日志的功能说明。这是阿里云的定义。它捕获特定位置的流量,并将流量转换为流日志记录。什么是流日志?流日志是捕获特定时间窗口的特定五元组的网络流的记录。

因此,对于基础功能的定义,DeepFlow沿用了公有云的定义,并在此基础上具备了更丰富的能力。

11 网络流日志-DeepFlow 与公有云的比较

下面我们来看看DeepFlow流日志和公有云流日志的对比,我来解读一下其中的一些区别。

我们先来看看捕获期。DeepFlow 的粒度可以小到 1 分钟,DeepFlow 的捕获位置也更丰富。除了VPC网络,还将覆盖容器网络、物理网络,还可以从网络层面扩展到系统层面。

让我们来看看 TAG。借助 DeepFlow 的 AutoTagging 能力,DeepFlow 流日志的 TAG 远比公有云丰富。除了VPC网络的一些标签外,还包括隧道、容器网络的标签,还有更丰富的采集Location标签。

指标旁边,公有云只有Packet/Byte这两个,DeepFlow涵盖了从网络吞吐量到性能,再到时延的多个维度。

在DeepFlow的流日志中,增加了流状态字段,通过该字段可以快速过滤异常流,目前公有云不支持。当然,DeepFlow目前不支持公有云支持的日志状态字段和安全策略状态,但是调度中也加入了这个功能。

最后,让我们看一件非常重要的事情。从计费上看,目前公有云是计费的,按照采集的流量大小和存储空间来计费。DeepFlow 开源版本和 SaaS 版本都具有此功能。大家都知道它是免费的,SaaS版本目前处于免费试用阶段。

好了,分析了这么*敏*感*词*对比之后,我们来看看DeepFlow网络流日志功能,它可以解决哪些问题。

12 网络流日志 - 概述

这是基于网络流日志构建的Granafa Dashboard。查看服务的调用关系与应用调用日志相同。但是,与应用调用日志不同的是,这个概览的 Dashboard 是查看网络层面的指标,比如吞吐量、重传、连接建立失败、连接建立延迟等指标数据。

13 网络流日志-网络延迟

在查看应用程序调用日志时,经常会注意响应延迟慢的调用,但是这种响应慢,除了应用程序本身响应慢之外,还可能是由于 TCP 连接建立慢、数据传输慢,或者协议栈慢. 要排查网络相关的延迟问题,您需要查看应用调用对应的流日志进行分析。

首先,应用调用日志和网络流日志是如何关联的。在 DeepFlow 平台上,一个 FlowID 用于关联两个日志。因此,您可以根据通话记录的FlowID查找流记录,找到通话对应的流。日志,然后分析流日志中的连接建立延迟、系统延迟、数据传输延迟指标,查看网络延迟高导致应用调用响应慢。

14 网络流日志-异常流状态日志

在应用调用日志中,可以根据状态查看异常日志,流日志也是一样。可以过滤状态查看异常流日志,这样就可以判断此时调用异常是否是网络异常引起的。

右上角给出了DeepFlow流日志中的状态定义,主要是定义流结束类型,比如连接建立延迟,因为端口复用可以关闭,比如传输过程中服务器发送RST包导致的结束.

15 网络流日志——TCP时序日志

接下来继续深入结合TCP时序日志,分析具体数据包的延迟和问题。特别说明:TCP时序日志目前是DeepFlow企业版的增强版,目前开源版没有。

用一个简单的demo来讲解开源通话记录和流记录功能。这是我们为开源社区打造的演示环境。这个demo环境是基于Grafana搭建的,已经搭建了很多应用和网络相关的Dashboards。

16 自动记录-采集

接下来从日志采集和日志处理两个方面给大家介绍一下,AutoLogging是如何基于BPF/eBPF自动实现采集日志的。

首先,让我们看一下 采集 部分。采集部分需要从两个方面来看:调用日志和流日志。

流日志

从前面的产品介绍中可以看出,流日志是根据网络流量生成的。因此,采集主要集中在网络层面。目前可以覆盖物理网络一直到虚拟网络,并且可以采集host到虚拟主机到容器POD的网卡的流量是通过BPF+AF_PACKET技术实现的, Windows系统的采集是使用Winpcap实现的。

通话记录

调用日志的数据收录两部分数据,一部分来自网络应用协议,另一部分是可观察到的Tracing数据。

对于这部分网络应用协议的数据,调用日志不仅包括网络层采集,还延伸到sidecar和应用进程层。网络层采集的定位和实现技术与流日志一致。,但处理逻辑会有些不同;对于 Sidecar 和应用进程级别,它是使用 eBPF 技术实现的。对于非加密和非压缩协议,由 eBPF Kprobe 和 Tracepoints 完成,对于 HTTP2 ,HTTPS 需要使用 Uprobe 完成。

对于 Opentelemetry 的数据访问,Traces 的数据访问是通过 Otel-Collector 将 Traces 的数据发送给 deepflow-agent 来完成的。这里先分享采集的部分,接下来我们看看采集完成后会做什么样的处理。

17 自动记录 - 处理

对于日志处理,分为公共处理部分、流日志处理、调用日志处理三个部分。

网络流量的处理可以分为:隧道拆解。对于隧道拆解,已经支持了基本的主流隧道协议,如Vxlan、IPIP、Gre等。隧道拆除后,协议按照协议栈的顺序进行解析,从链路层到传输层。

接下来,需要对流量进行 AutoTagging 预处理。这里主要添加唯一标签,以便服务器根据唯一标签添加全量标签。此时需要分别处理不同的日志。对于网络流日志,可以根据产品定义生成流日志。

对于应用调用日志,还需要完成应用协议的识别。具体协议确定后,分析应用协议,最后根据定义生成调用日志。

对于应用调用日志,除了刚才共享的处理流程,还有一条路径,主要是因为应用调用日志不仅收录网络应用协议,还收录APM定义的跟踪数据。进入后直接解析即可。

18 应用程序调用日志 - 协议扩展

好的,这部分的交易就到这里,接下来我们将添加一个应用程序协议的扩展。据说应用程序调用日志支持访问各种协议。以下是对协议访问需要做什么的简要概述。

第一部分:需要解析协议;

第二部分:协议解析完成后,需要将协议映射到调用日志;

第三部分:除了调用日志,DeepFlow还提供了预先聚合数据和计算应用程序RED指标的能力。

这就是协议扩展必须做的事情。目前DeepFlow已经开源,欢迎开源社区的朋友贡献更多协议,丰富应用调用日志。

今天的分享主要是对框架的讲解,并没有涉及太多的代码细节。如果你对实现细节感兴趣,可以直接在 GitHub 上查看代码。下面是 DeepFlow GitHub 的链接。

GitHub地址:

19 未来迭代的方向

最后总结一个DeepFlow日志未来的迭代方向。

目前DeepFlow在Logging方向上具备AutoLogging能力,未来会继续做日志整合。它将从 Promtail、Fluentd 等获取数据,并使用 AutoTagging 能力注入各种标签,这更符合这样的云原生设计。主意。

DeepFlow 的 AutoLogging 的日志数据也完全支持访问阿里云 SLS。DeepFlow 可以为 SLS 用户带来我们高度自动化的可观察性。今天分享的内容到此结束。您可以扫描下方二维码联系我们。谢谢你们。