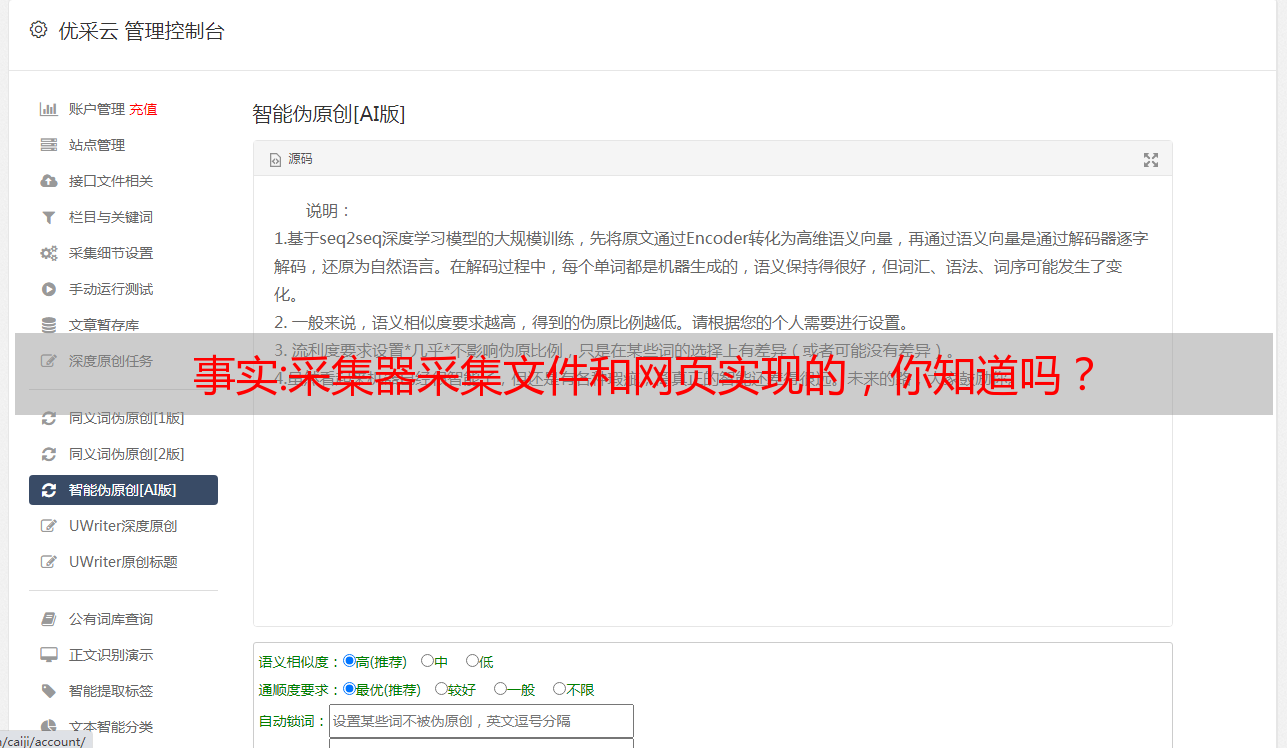

事实:采集器采集文件和网页实现的,你知道吗?

优采云 发布时间: 2022-11-04 08:12事实:采集器采集文件和网页实现的,你知道吗?

采集器采集文件和网页实现的,说简单点就是首先把文件写入采集器然后通过localstorage实现文件的不可拷贝性,这样somecodec即可通过分析文件不可拷贝性来判断文件所在位置。

都是基于ncbi采集的,可以先看一下相关文章。

先匿名,然后通过openman来对数据进行处理,或者直接在google上搜索数据文件,可以获得一些数据信息。一般都是csv文件,文件中数据会自动转换为excel,转换过程稍稍耗点时间。然后数据转换后即可post到google的文件里。

谷歌,站内搜索,英文,嗯。没找到规律。

ls@ls答案已经很详细了,我就补充一个自己亲身经历的项目。/,可以根据已有的网站数据和文献总结出文献阅读顺序,给一个重要文献的频率,给一个全文;找出做某一领域研究的前几位,分析他们的相关研究方向。

-you-want-to-characterize-a-database-in-digital-data/googlesearch

在google网页数据处理之前,我们只能用csv来将不同文件类型的数据进行汇总,这会产生很多信息的丢失,比如文件是由xml组成的,我们将这些xml统统转换成csv并不能解决问题。另外有多个文件类型组成的情况也是经常发生的。现在我们可以通过模糊匹配进行数据类型转换了,就像不同日期不同地域的家庭住址信息一样,通过一串url,我们就可以获取电话号码、邮箱、email等信息,并将他们聚合成一个更加精确的统计数据表格。

另外还可以对单个项目进行统计、统计文献的复制、搬迁等等,在相关项目的各种统计图表中我们能非常方便的看到文献的复制转移、地点与位置分布等等。在googlesearch上搜索digitallibrary,会有sortedmatching的操作,从而将csv按照包含的某些项目进行排序,然后再转换成对应的excel文件。

附一个excel相关菜单的链接informationgrouptoolbox(扫一扫二维码就可以试用了):需要的朋友也可以根据个人的需求进行访问drivetoexcel,即可把你认为最重要的数据转换成excel。要是在msword中完成文献归类或统计的话,感觉都没有googlesearch那么方便。