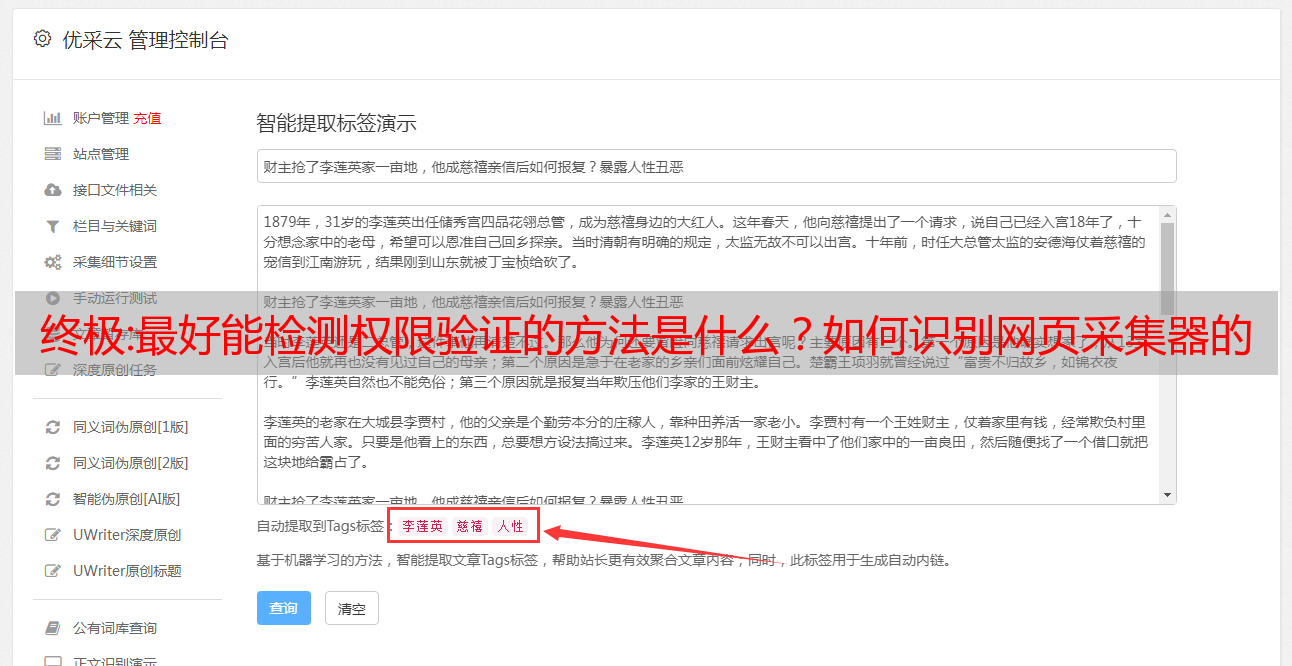

终极:最好能检测权限验证的方法是什么?如何识别网页采集器的自动识别算法

优采云 发布时间: 2022-11-04 02:08终极:最好能检测权限验证的方法是什么?如何识别网页采集器的自动识别算法

网页采集器的自动识别算法是一个复杂的系统,所以我很怀疑那些号称用一键采集工具就能得到精确答案的网页制作者就是想收智商税。正常来说,至少需要权限验证,特殊关键词提取,爬虫,然后你才能知道和搜集一份搜索请求的数据是否真实,网页*敏*感*词*是否在撒谎,如果你在知乎搜索“网页采集器教程”那就不是选题制造问题那么简单了。最好能检测权限验证的方法是看看这个请求发给爬虫了没有。

说好的满屏幕爬虫自动采集呢?

切换发件人和用户名

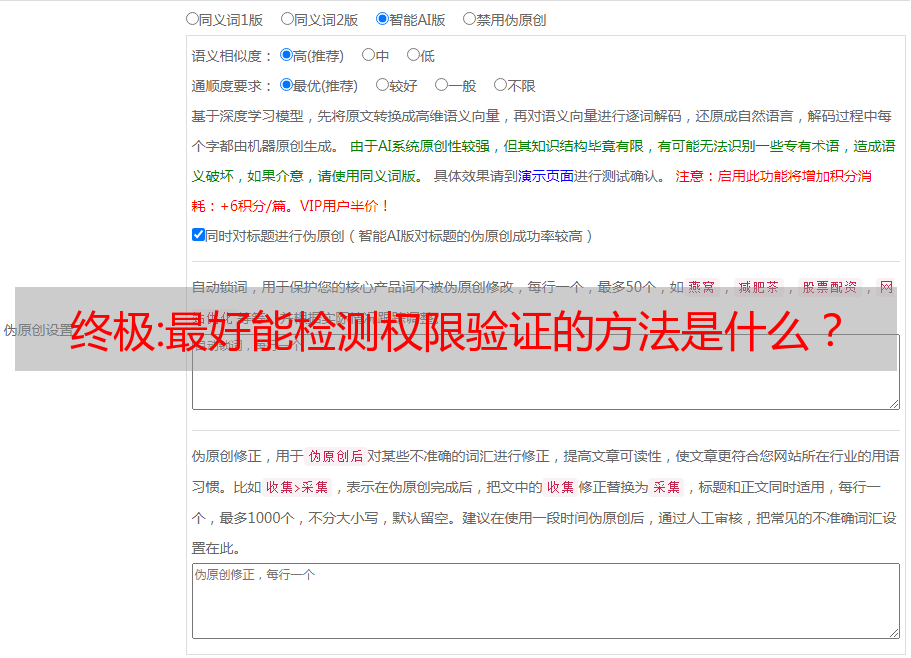

由于当前面临一个竞争方式,大搜索引擎自身有一些屏蔽不怎么好用的采集工具的情况下,首先需要了解影响爬虫爬取的关键点如果你连这个也搞不定的话,那也没有必要反爬虫了爬虫的基本工作流程爬虫的工作流程是这样的:爬虫从数据源从左到右依次获取请求,然后从设置好的响应从服务器端向客户端返回一份完整的数据。内容中主要包括:请求的服务器返回的数据及当前网页的内容;内容源返回的html文本(文本不属于json数据);请求服务器的报文头信息,例如响应的useragent,profile/tags等等;根据响应响应时分配给爬虫的内容是否正确,爬虫会去已抓取数据库里找到正确的内容,如果有过长、或者过密的内容将不会显示,或者直接从分配给自己的内容池继续抓取有点像正则匹配一样,爬虫需要通过几轮反爬虫来完成对数据源的抓取。如何识别搜索引擎抓取:。

1、安全连接

2、内容外流

3、ajax返回

4、seo

1)、cookie:cookie,可以缓存http请求请求状态并为客户端返回是否是否成功、真实的http结果。请求成功时,连接受到重定向;爬虫的连接基本都请求成功;爬虫不会大量访问数据源,一般也不会重定向,总体成本较低。

2)、session:和cookie类似,在web浏览器中,浏览器启动后会在http请求发出后以独立url开启cookie,服务器再进行响应时,才会将浏览器指定的url作为服务器的路径。浏览器重定向到用户下次访问时,会将下次访问的url作为服务器的路径。服务器响应时,会把url作为服务器的路径返回。这个功能优点在于,可以对一个用户访问一个网站前,在浏览器中保存sessionid。

简单来说,每次爬虫通过get请求会在服务器设置session_id,爬虫发送ajax请求时会根据sessionid查询返回的内容(得到用户浏览器可见页面)是否是本地存在的。

3)、ajax,ajax是asynchronouslyjavascriptandxml的缩写,即异步的javascript和xml。简单理解,就是爬虫会实时的进行网站请求,并返回一个加载完毕的结果。在网页还未加载完毕前,