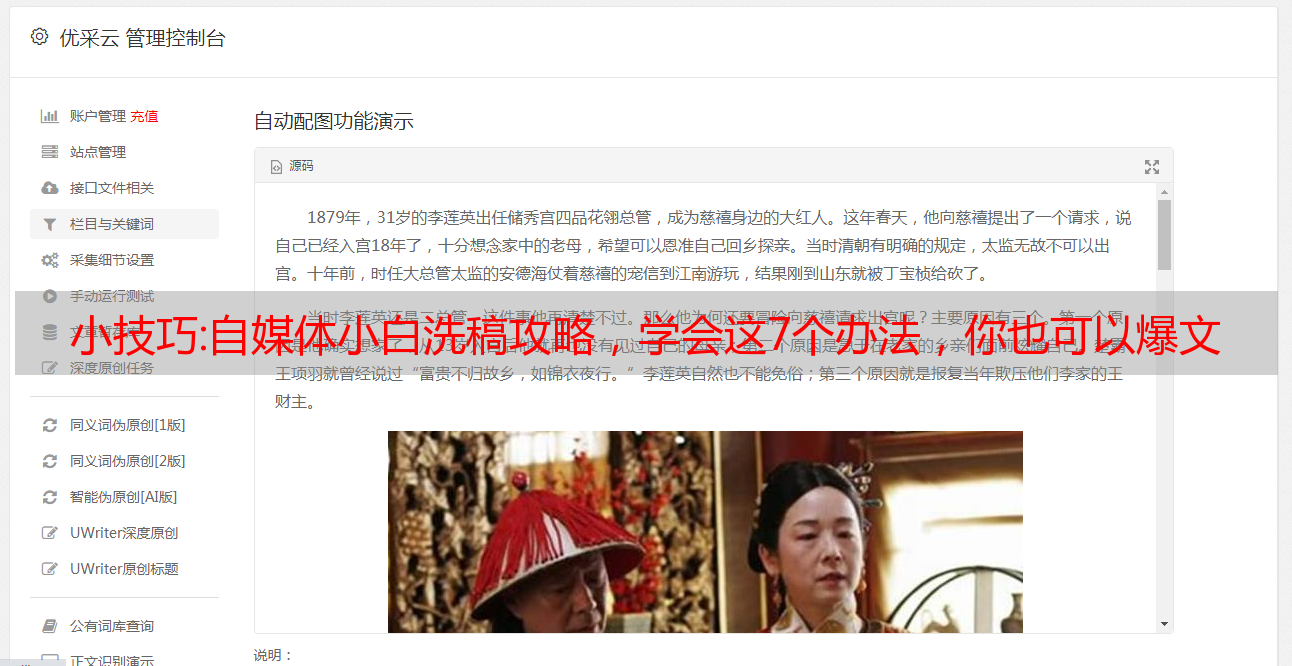

小技巧:自媒体小白洗稿攻略,学会这7个办法,你也可以爆文

优采云 发布时间: 2022-11-02 23:46小技巧:自媒体小白洗稿攻略,学会这7个办法,你也可以爆文

说到文案,很多人都觉得很难。很多朋友私下问我爆文怎么写比较快?想过整理7种洗稿方法,现在一一告诉大家:

文章伪原创方法一:更改文章的原标题,标题要新颖,收录关键词。考虑使用数字替换或单词替换。

文章伪原创方法二:拆分方法将较长的文章的原创内容平均分成若干个文章。在新的 文章 之间创建一个链接。

文章伪原创 方法三:修改第一段文字,文章去除重复时,从头开始审稿,在开头找不到抄袭。

文章伪原创 方法四:将原来的几个具有相似内容的文章整合成一个文章。这时要注意书写的顺序和逻辑。.

文章伪原创 方法 5:将 文章 段落倒置。如果重新排列段落不影响 文章 的内容,您可以将段落 Row 的原创顺序打乱。

文章伪原创方法六:关键字标注,大家都知道关键字很重要,所以可以加关键字标注,当然还要考虑关键字出现的频率。

文章伪原创方法七:省略法用代词/图片替换或省略一些没有实际用途的词,以减少文章的相似度。

让我们仔细研究这7种方法,相信它们会对你有用。

干货:《作文精编大全》,Python程序员用爬虫制作的

文章目录

⛳️实战场景

本篇博客是另一个Python爬虫实战。目标站点是作文,一个充满作文的网站,因为它的网站有一点付费需求,所以一个父亲级的开发工程师不高兴,决定写一个小爬虫,他要的不多,只是一点点作文一年级。

就是下面这张图,让程序员们干活~

打开一年级作文列表页面,页面如下,第一步要完成的是这个列表页面采集的数据。

⛳️ 采集列表页面

在 Python 中编写简单的爬虫时,requests + lxml 是最简单的方法。

import requests

import json

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/106.0.0.0 Safari/537.36"

}

res = requests.get('https://www.zuowen8.com/xiaoxue/yinianjizuowen/', headers=headers)

print(res.text)

如果直接运行代码,会得到一个中文乱码界面,如下图。

设置响应对象的编码,代码如下:

res = requests.get('https://www.zuowen8.com/xiaoxue/yinianjizuowen/', headers=headers)

res.encoding = 'utf-8' # 编码错误

print(res.text)

<p>

</p>

结果设置了utf-8后,编码还是不对。这时候需要查看网页源码中具体的编码设置,打开开发者工具,查看源码编码,发现网站使用的是gb2312,参考这个值进行设置向上。

res = requests.get('https://www.zuowen8.com/xiaoxue/yinianjizuowen/', headers=headers)

res.encoding = 'gb2312'

print(res.text)

⛳️ 提取列表组成地址

获取到页面源码后,可以提取出作文详情页面的地址,即下图中红框区域的链接。

res.encoding = 'gb2312'

e = etree.HTML(res.text)

h3_list = e.xpath("//h3/a/@href")

print(h3_list)

获取到链接后,需要拼接在一起才能得到详情页的完整地址,可以使用f-strings来完成。

base_domain = 'https://www.zuowen8.com'

for url in h3_list:

url = base_domain+url

print(url)

详情页地址拼接后,再次使用requests模块捕获详情页源码。

for url in h3_list:

url = base_domain+url

<p>

detail = requests.get(url,headers=headers)

detail.encoding = 'gb2312'

print(detail.text)

</p>

获取作文详情页面的源码,提取作文内容,即下图红框区域显示的信息。

⛳️提取成分8内容

看上图可以看到,合成内容都在class等于content的div中,所以可以解析。

for url in h3_list:

url = base_domain+url

detail = requests.get(url,headers=headers)

detail.encoding = 'gb2312'

d = etree.HTML(detail.text)

content = d.xpath('//div[@class="content"]//p/text()')

print(content)

上面的xpath表达式只提取了div元素中子标签p的内部文本,而只是忽略了标签u中的防爬信息,即下图中的绿框数据需要忽略。

运行代码,得到的内容如下,每篇文章按照段落提取成一个列表。

['今天,我和妹妹到楼下去抓蚂蚁。我抓了很多只大蚂蚁,大……', '后来,我又用棍子挑蚂蚁,', '谁知蚂……来。', '地上掉了一只辣椒,我看见很多蚂蚁在啃辣椒,有些蚂蚁被辣得跑掉了,有些蚂蚁在津津有味地啃着辣椒,还有几只蚂蚁想拖动辣椒,但是拖了半天都没拖动。']

最后,您只需将列表中的内容进行拼接,即可完成您的“论文集”。

您正在阅读[梦橡皮擦]的博客

看完可以点个赞