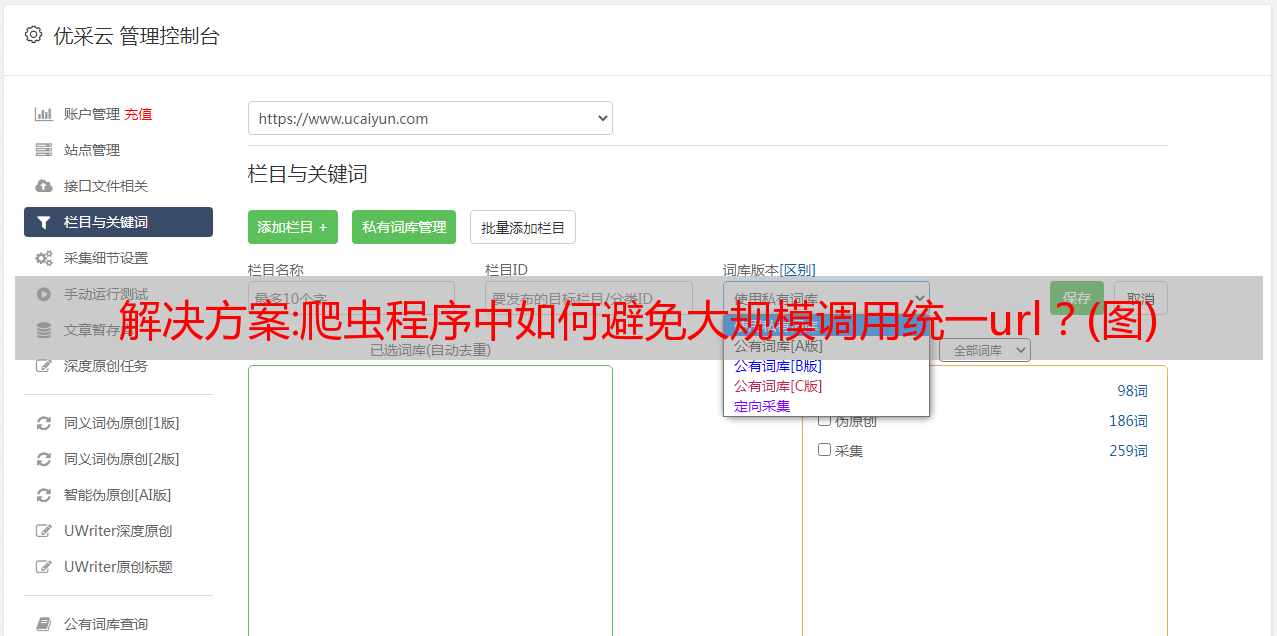

解决方案:爬虫程序中如何避免*敏*感*词*调用统一url?(图)

优采云 发布时间: 2022-11-01 14:18解决方案:爬虫程序中如何避免*敏*感*词*调用统一url?(图)

文章采集完毕、数据处理完毕后,把结果报给爬虫程序便可。爬虫程序可能会遇到下面的问题:爬虫程序需要调用大量url,而这些url是有规律的,爬虫程序经常需要建立统一的mapping,让每个mapping包含的url是一样的;即使是在java/python等语言中,这些统一的url也可能是相对较*敏*感*词*的;同一个url可能会被多个爬虫程序调用多次,各个爬虫程序之间数据差异较大等等。

经过反复调试后,要从爬虫程序中处理出最接近原始结果的url,确实是一个技术活。这篇文章我们将解决第二个问题:数据量较大的时候,如何避免*敏*感*词*调用统一url。

一、数据量较大的时候,应该如何处理原始mapping我们知道了爬虫爬取的数据是有规律的,而这些规律又是有内在规律的,而在统一url调用的时候会遇到的问题就是:统一url调用的mapping和爬虫抓取到的mapping信息可能不同,比如统一url调用的mapping信息可能是url中某一个参数的内容,也可能是最终数据,还可能是各个参数对应的数据类型等等。

这些错误的信息是根据当前数据类型计算出来的,所以要避免第一种问题,我们就需要构建统一的mapping来维护它们之间的关系,这个统一的mapping就是我们常说的“爬虫数据库”。

二、爬虫抓取信息难以描述导致数据误读这一问题比较好解决,数据抓取之后的数据库即时设置参数中就会把已抓取的信息中的所有信息都匹配进来,直接放进数据库即可。但如果爬虫抓取的信息中有数据类型相同的数据时,那数据库就更加麻烦了。正因为此,爬虫程序中往往会创建一个统一url来对数据进行描述,比如分别有hashtable与哈希表的url,即使他们的内容类型是一样的,但在调用的时候,如果用了哈希表,也需要利用expiryseeker来进行更新。

更为严重的是,在爬虫程序爬取网站的时候,由于爬虫的调用会根据最近请求的url来根据先后顺序进行顺序抓取,这些url并不会因为调用同一个url而重复抓取。爬虫程序中使用的url最终会换成新的url,并且之前的url也会随之变化,这时候,你的url可能被你的爬虫程序重复抓取。这样极其不合理,相当于原本在url中可以正确匹配数据类型的url被覆盖,从而影响最终的url抓取结果。

虽然url的统一url调用很多时候对爬虫而言并不麻烦,但我们会经常遇到数据类型不匹配的情况,比如爬虫存在scrapy,java等库,那么爬虫程序的调用也会有scrapy、java等库。再比如爬虫存在ip地址填错等问题,那么调用同一个url的时候也会出错。

三、爬虫程序运行不稳定导致数据丢失有时候爬虫程序经常用到异步处理,