技巧:【4-20】后SEO时代杂谈

优采云 发布时间: 2022-11-01 02:44技巧:【4-20】后SEO时代杂谈

从2008年接触百度SEO到2009年开始学习谷歌SEO到现在已经有好几年了创业,也因为“掌握”了SEO,才意识到梦想和距离真的很遥远。

问题1:SEO现在还有效吗?

“对不起,你已经是历史了”

真的会是这样吗?其实我说的还是中立的,因为我哥不听命。

对于百货公司的产品,我的观点是你不必直接去想。SEO引流分为几个阶段:

第一阶段:最早的外贸B2C和一群淘金者在做仿品,还有一些卖魔兽金币的。

第二阶段:工厂贸易,以阿里巴巴为代表,阿里巴巴80%的流量来自搜索引擎(当然上市后不再准确)

第三阶段:这就是我要讲的,后SEO时代。

到了后SEO时代,你会发现之前学过的所有方法似乎都失效了。让我举个例子:

1、现场优化:标题、关键词、描述、元标签、JS代码优化、源码优化;

2.贴外链,天天发,从人工外链到软件海量外链。记得有家公司有几百人,手动发外链,有多疯狂;

3.头发太慢,有钱的老板会买外链。最后发展到SEO黑链、黑页、SHELL各种黑法;

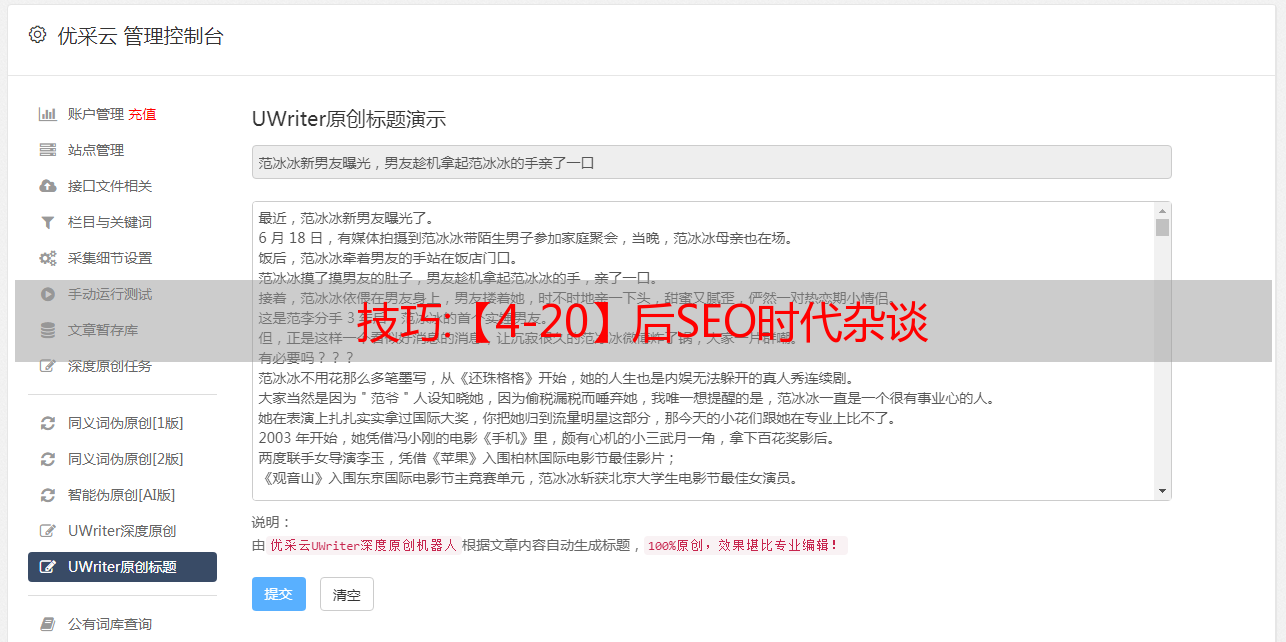

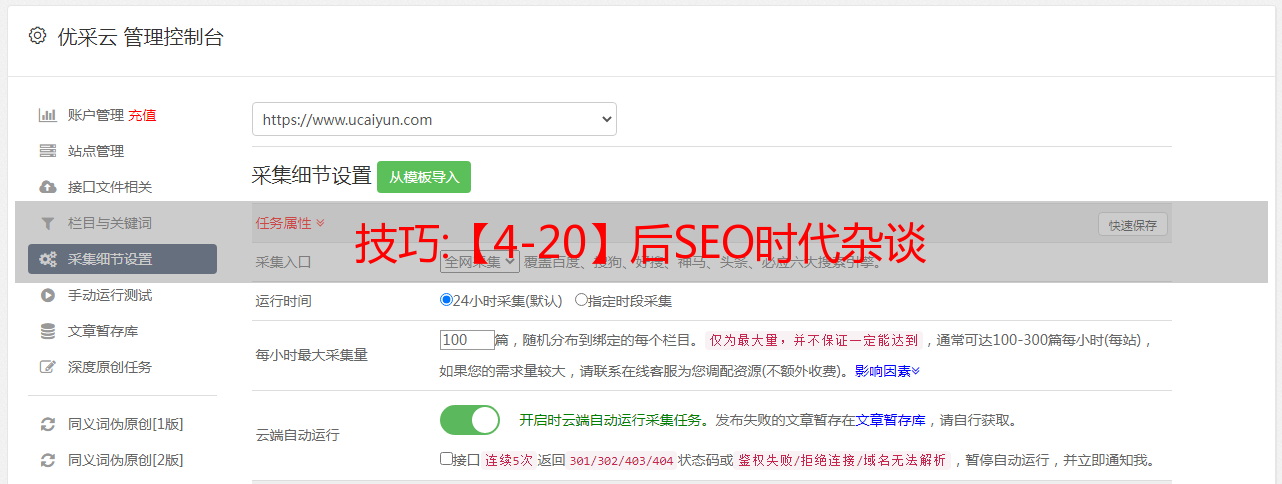

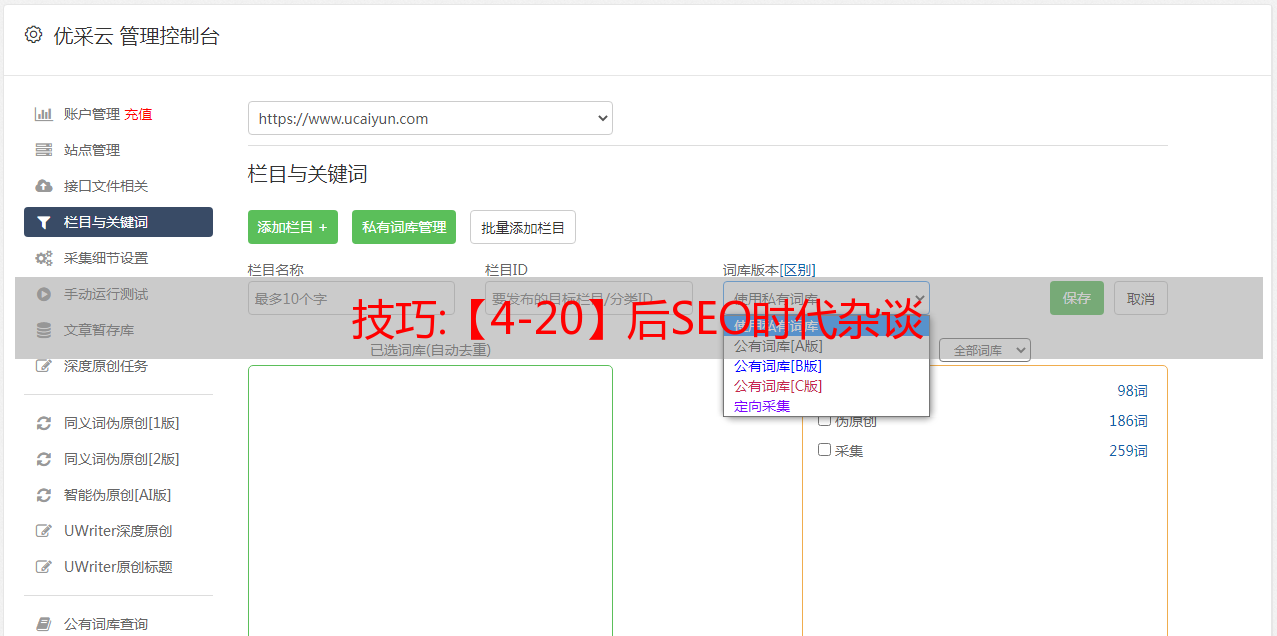

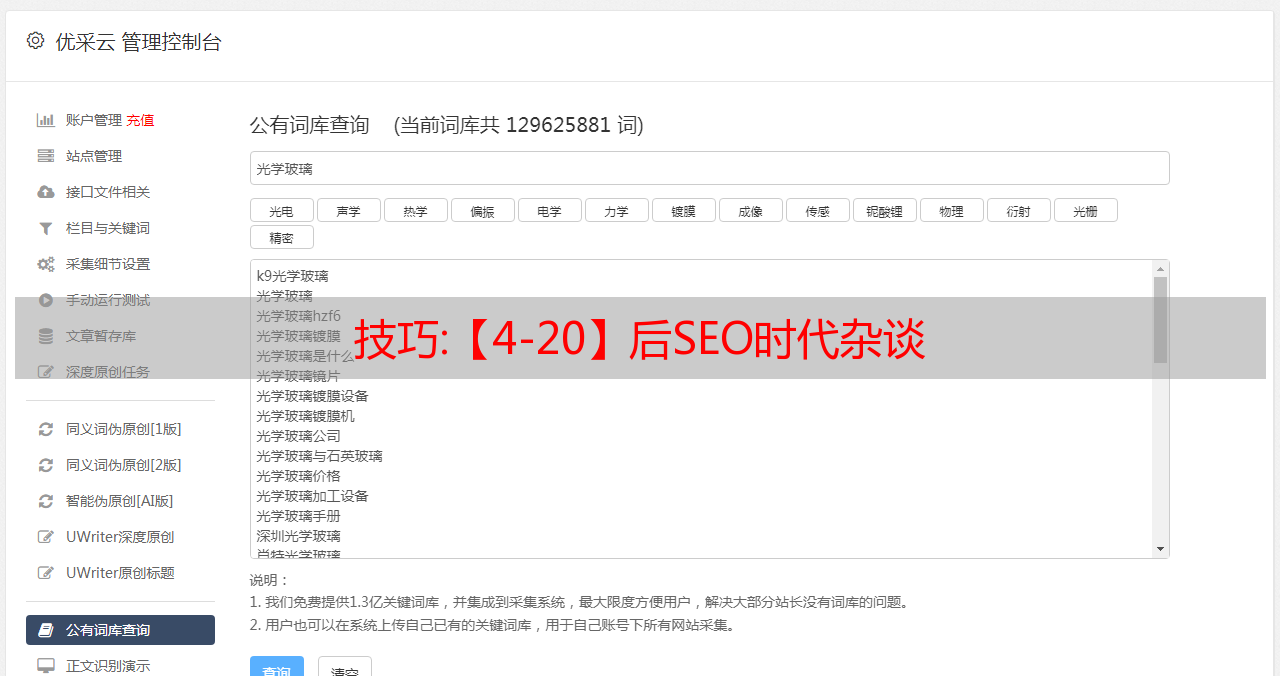

4. 制作内容时,搜索引擎是基于文本的。做SEO的人很聪明。从批采集到伪原创,我以前主要关注文字,用谷歌翻译成英文。质量很高的原创,谷歌收录不错;

5、做SNS的时候,不知道为什么SEO和SNS可以强联结在一起。估计是外链的情况。发送外链的手段真的很强大,各种SNS平台作为外链发布工具;

问题二:SEO是一种低成本的推广方式

十年前,你这样想是对的,但现在,你还在想谷歌排名快,这是不可行的。

SEO其实是一个非常昂贵的运营渠道。

中国SEO神级人物国平曾表示,综合搜索引擎可能有一天会倒闭。为什么,以百度为例,你买衣服,你不会去百度搜索,但你买机票,你会去携程搜索,你搜索团购,你会去大众点评。

[之后如何做SEO。后面会写,结合一些案例来分析。】

问题3:企业在后SEO时代更重要

对于B2B来说,无论是哪个阶段,SEO营销都是必须的,因为后时代的SEO已经是泛化的SEO,已经不可能通过一两个小方法实现流量暴增。

在这个SEO时代,我们必须有一个全面的运营思路,才能在激烈的竞争中找到出路。怎么做,请听下节分解。

教程:Python学习汇总,做数据采集的一些小技巧,干货满满

我学习 Python 已经有一段时间了。在学习的过程中,我不断地实践所学的各种知识。我做的最多的是爬虫,也就是简单的数据采集,里面有采集图片(这个是最多的……),有的下载电影,有的和学习有关,比如爬虫ppt模板,当然我也写过诸如收发邮件、自动登录论坛发帖、验证码相关操作等等!

这些脚本有一个共同点。它们都与网络有关。总是使用一些获取链接的方法。在这里总结一下,分享给正在学习的朋友。

安装相关

其实python的各个版本差别不大,用3.6还是3.7不用太担心。

至于我们经常使用的库,建议大家先了解安装哪些库,安装哪些库。

有的同学会纠结,库装不上。百度搜索推荐这个:python whl 是第一个。其中每个库都有不同的版本。选择对应的下载,用pip安装文件的全路径安装。能!

最基本的抓取站——获取源码

导入请求#导入库

html = requests.get(url)#获取源代码

对于静态网页

网站反“反爬”

大部分网站(各种中小网站)都需要你的代码有headers信息,如果没有,会直接拒绝你的访问!大型网站,尤其是门户网站,如新浪新闻、今日头条图集、百度图片的爬虫等很少。!

对于有防爬措施的网站,大部分可以按照添加UA信息的顺序添加到headers数据(字典格式)中——添加HOST和Referer(防盗链)信息!代码格式 requestts.get(url,headers=headers)

UA信息是浏览器信息。它告诉另一个服务器我们是什么浏览器。通常,我们可以采集相关信息来制作一个UA池。我们可以在需要的时候调用,也可以随机调用,防止被网站发现。是的,如果是移动端,一定要注意移动网页和PC端的区别。例如,我们更喜欢移动端作为微博爬虫。其抗爬网能力远低于PC端。网站 反爬很厉害,可以到手机端(手机登录复制url),说不定有惊喜!

用户信息

HOST信息,网站的主机信息,这个一般不变

Referer信息,这是“防盗链”的关键信息。简单来说就是你来到当前页面的地方,破解也很简单,把url放进去就行了!

如果上面的方法还是绕不过反爬的话,那就比较麻烦了,把所有信息都写在headers里。

终极反“反爬”:学硒,少年!

保存文件

其实可以简单的分为两类:字符串内容保存和其他内容保存!代码中这么简单的2就可以解决

a+是文本末尾的附加书写方式,适合字符串内容的书写。注意排版。也可以在'a+'后面加上参数encoding='utf-8'来指定保存文本的编码格式

wb为二进制写入方式,适用于找到对象的真实下载地址后,以二进制方式下载文件

未完待续

篇幅有限,本来想写完的,但是有人说我写的太多了,没人看。. . 这很尴尬!那就先写到这里吧!

也是时候重新整理一下以下内容了,大概是:自动登录(cookie pool)和登录、ip代理、验证码(这是个大项目)以及scarpy框架的一些注意事项。

有其他技能或者问题的同学也可以在评论区写,一起讨论吧!