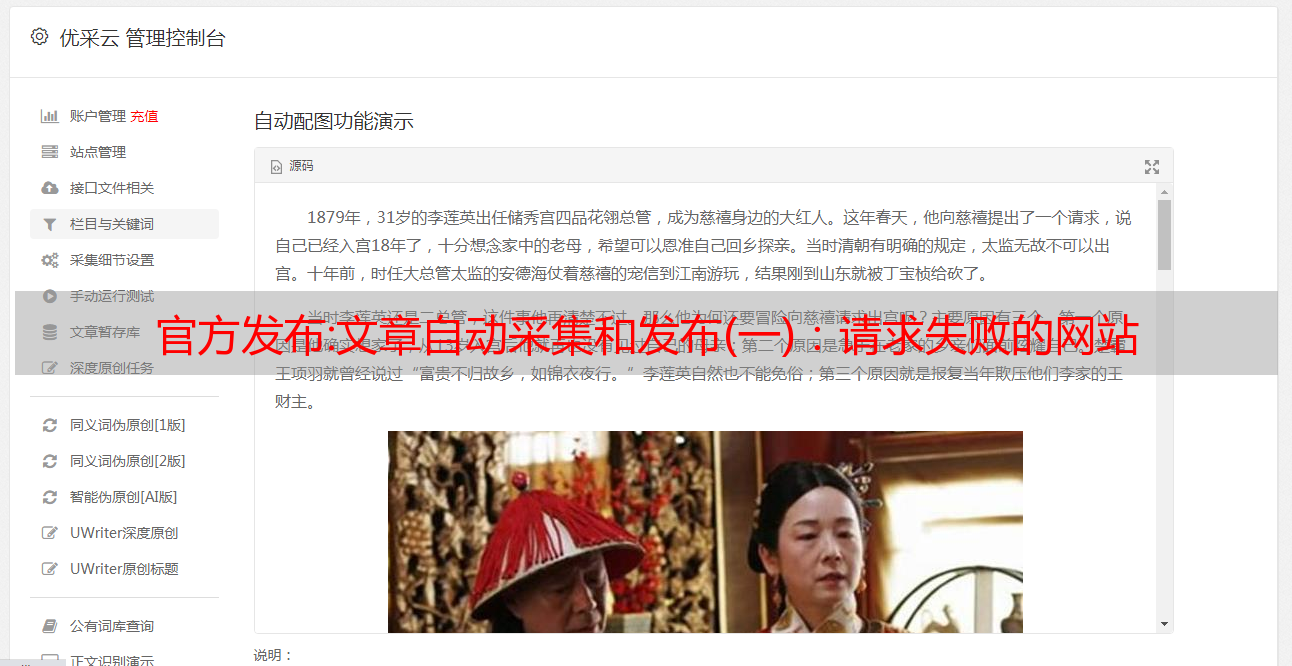

官方发布:文章自动采集和发布(一):请求失败的网站

优采云 发布时间: 2022-11-01 00:15官方发布:文章自动采集和发布(一):请求失败的网站

文章自动采集和发布为了实现这个目标,你必须要有基础的爬虫、python、web开发和数据分析能力。而发布?也很简单,只要编写一个ajax页面代码,从不同的后端请求数据即可,只是这样做开发效率很低。那么,我们要的效果是什么呢?比如说如何实现在不同的网站都可以发布和爬取我们的数据,数据格式一致不需要频繁修改就能同步更新。

这些不同的网站是有差异的,我这个项目可能发布到n多个网站,需要使用的数据源不一样,那么如何让我一次就能把数据发布到n个网站?这里我们要一次性多发布几次,保证第一个网站能给用户正确的答案。提高效率那么,爬虫每发布一次就得给后端发出一次请求,网站每发布一次就得给我一次请求,只有同步加载,不用for循环的次数是有限的,要实现同步,必须要将网页内容和数据同步,再次开始进行请求。

代码如下:#-*-coding:utf-8-*-importurllib2url=""defsimpledivlist(request):#爬虫请求html=urllib2.urlopen(request.read())html=html.read().decode("gbk")ifnothtml.errors.error():#是否需要数据类型检查html=parse.read_html(html)html.encode("utf-8").decode("gbk")html.decode("utf-8").unsigned()try:html=html.replace(u'\d+',html)exceptrequest.errorase:print(e.data)urllib2.urlopen('http://'+this,timeout=3。

0)print("请求失败{}次(次)".format(urllib2.urlopen('http://'+this)))returnurllib2.urlopen('http://'+this,timeout=3

0)defmain(a):#这是操作页面的部分defsimpledivlist(request):#爬虫请求html=urllib2。urlopen(request。read())html=html。read()。decode("gbk")ifnothtml。errors。error():#是否需要数据类型检查html=parse。

read_html(html)html。encode("utf-8")。decode("gbk")html。decode("utf-8")。unsigned()try:returnurllib2。urlopen('http://'+this,timeout=3。

0)print("请求失败{}次(次)".format(urllib2.urlopen('http://'+this)))urllib2.urlopen('http://'+this,timeout=3

0)print("请求失败{}次(次)".format(urllib2.urlopen