解读:通过关键词采集文章采集api第一步:利用爬虫框架

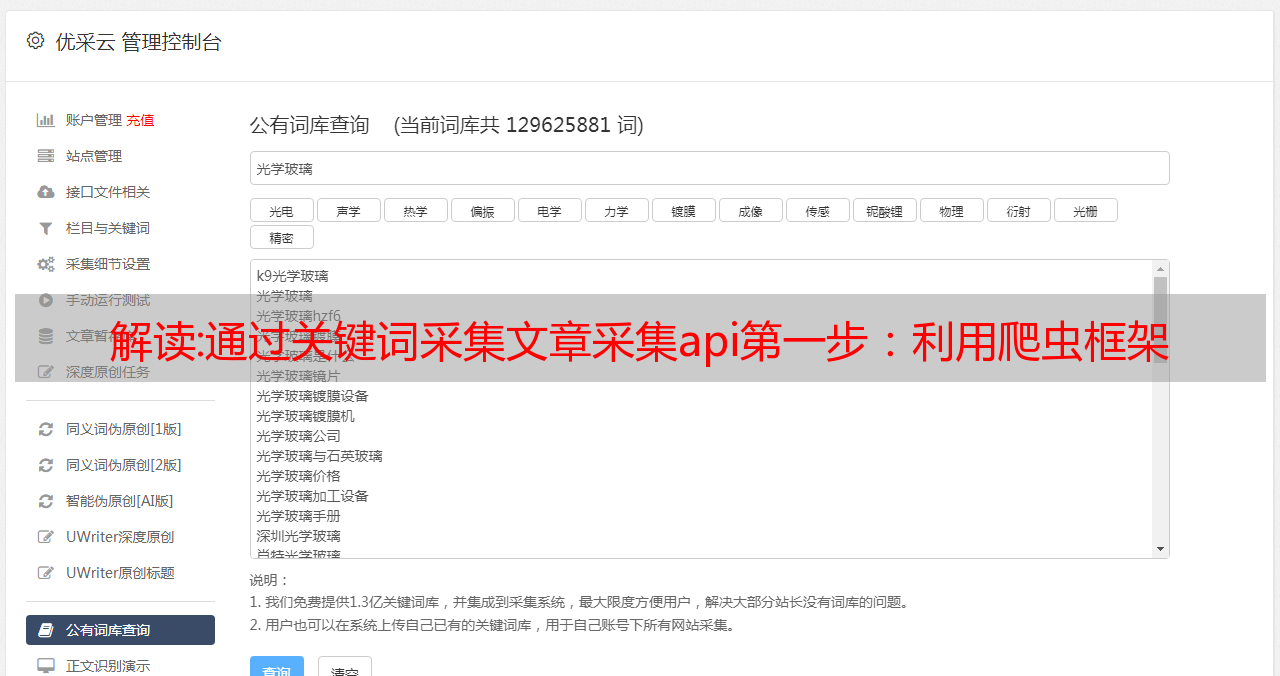

优采云 发布时间: 2022-10-31 19:17通过关键词采集文章采集api第一步:关键词采集利用python写爬虫的方法并不是强制需要,是自愿进行。关键词采集很简单,将自己关键词做好爬取设置,将对应网站链接和api地址丢到一个excel表格里面。按照用户找到的链接查看对应的源码即可。简单快捷的采集目标api文章目标网站首页html在代码中如下目标网站的权重:3第二步:数据爬取在爬取数据之前需要爬取网站链接的情况下可以使用python爬虫框架scrapy,这个框架是很多大型爬虫开发者用的比较多的一个,scrapy模块非常强大,支持python3开发,真正的一分钟开发。

scrapy官网::利用爬虫框架进行api的抓取现在最常用的api可以分为以下2类一种是通过代理网络进行的一种是通过代理池进行的每个网站对应的代理服务器的位置可以根据需要自行建立。爬虫框架+scrapy抓取网站的过程具体可以参考:采集请求本地网站scrapy+代理池抓取目标网站scrapy+代理池抓取请求本地网站注意:本文写的过程主要以api进行,如果需要html爬取请酌情使用其他方法进行。

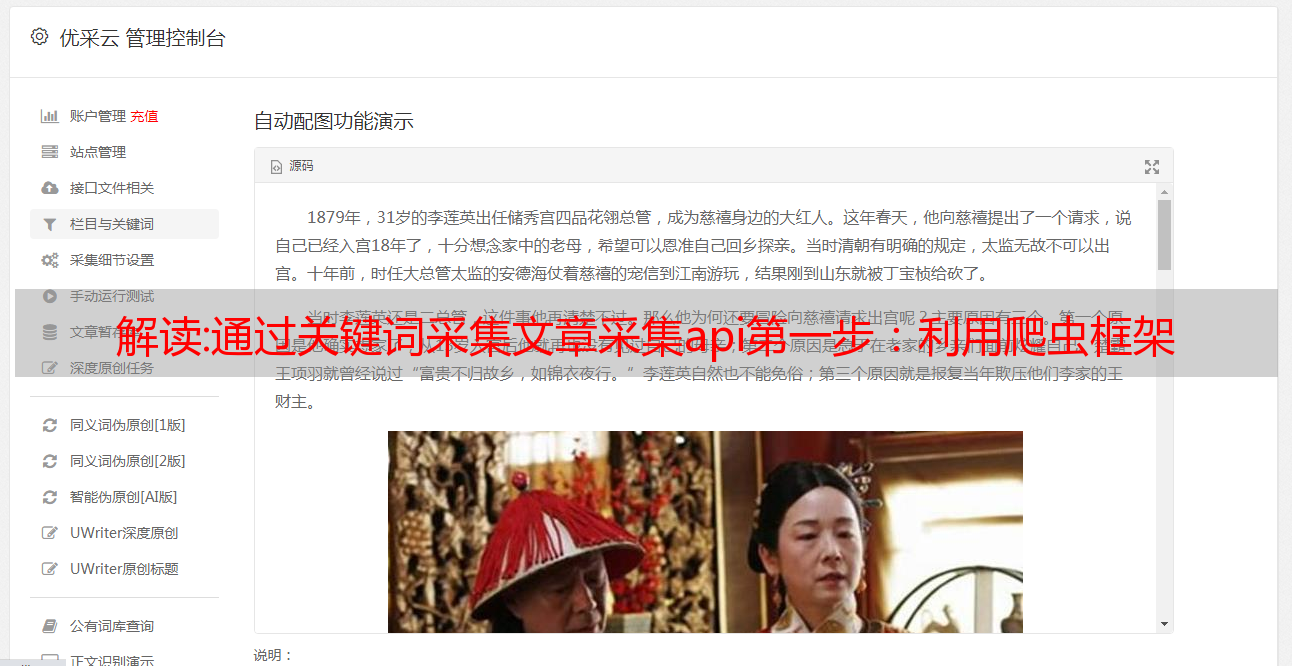

大家有没有想过,如果有什么爬虫工具可以抓到那些公众号的文章并且可以帮助自己写文章呢?我想大多数人想到的肯定是爬虫工具,但我们又不想用大量的爬虫工具,所以我们还可以爬取到其他人的文章作为参考。我们已经知道这样的大目标,可能会涉及到的问题就是抓取的过程有可能会花费我们很多的时间和精力。今天我为大家介绍一款api工具,来帮助我们爬取文章并且可以辅助写文章。

首先,我们先创建一个小目标,即我们将爬取文章中的一些单词,然后我们通过创建一个爬虫,然后我们可以使用这个爬虫来抓取它们。大家可以利用生成自己的apiid。其次,我们可以新建一个爬虫运行这个爬虫,这个爬虫是这样的:爬虫的生成我们可以在这里设置。然后在那个页面中,有几个按钮,按一下,我们就能得到所要的结果。

最后我们要做的就是把这个抓取的结果传递给数据库。这是我们要爬取的链接:当然,还有一些别的链接,我们可以通过修改我们的爬虫运行的情况来修改链接。我们在github上有一个项目:。这个项目分为2个部分,第一个部分是实现我们爬取数据。另外一个部分是一些更重要的,如技术方面的东西。我们建议大家安装这个项目,这里我推荐一个高质量,而且更新很快的,很简单易用的github。

安装在vmware下面安装centos。然后打开/etc/yum.repos.d/中的httpd.repo,如下图所示:如果一切正常,这个版本应该会将api注册到httpd的.repo文件中,