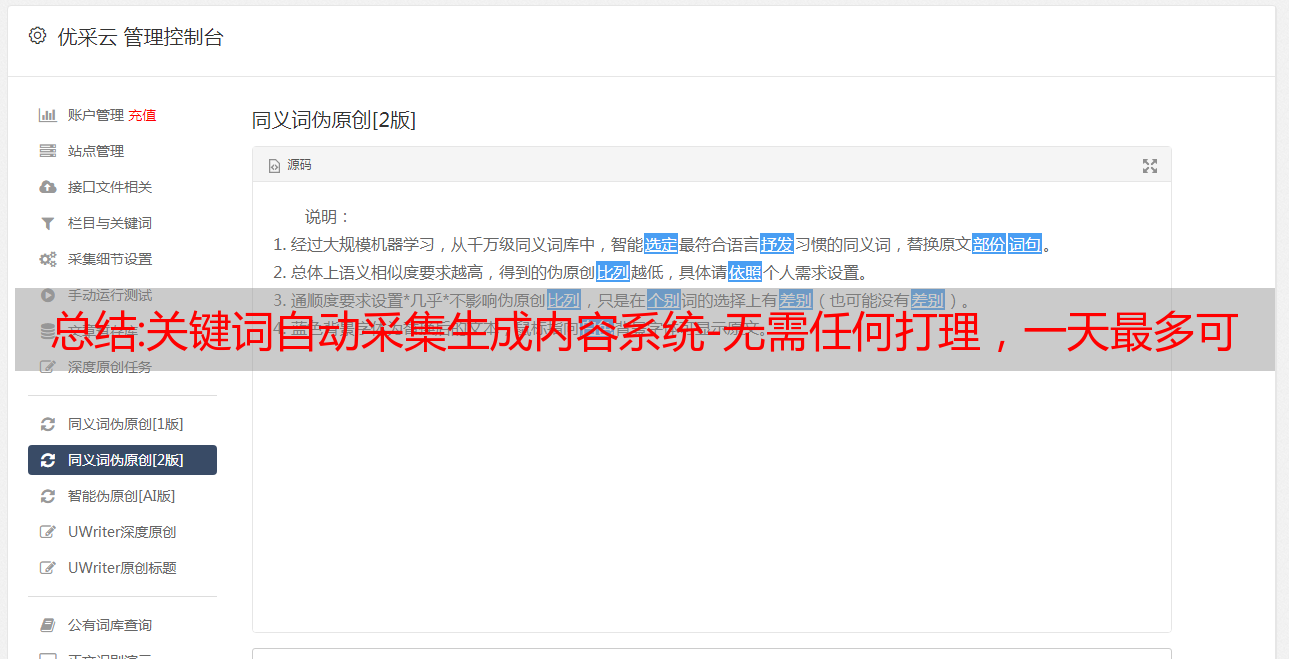

总结:关键词自动采集生成内容系统-无需任何打理,一天最多可以采集5篇

优采云 发布时间: 2022-10-31 06:12总结:关键词自动采集生成内容系统-无需任何打理,一天最多可以采集5篇

关键词自动采集生成内容系统-无需任何打理,自动采集作者文章,包括原文,摘要,关键词,博客链接等,一天最多可以采集5篇,

个人推荐:我的文章助手。非常方便快捷,你可以免费试用看看。

googleanalytics

googleanalytics和googletrends都挺好用的。

搜狗网站导航要不就用谷歌的terms,

我觉得这个网站不错:,有些东西挺不错的。

google+

很多国内的自媒体比如一点资讯、腾讯新闻、今日头条等等的新闻源都很多,其实这些都是从googlesearch结果中采集过来的。而且通过这些url,还可以很容易做到自动发布或者搜索推广。建议楼主可以考虑用一个专门做新闻源的小程序,名字是好贷网,有全网新闻源定制和引用功能,但是这个功能有30天的有效期,小程序上的新闻源采集时间要求5小时之内不得重复,同时这个小程序也还有引用功能,因为总能有新的点击和引用过来的站点。

下载rsseditor和coreldraw,采用wordpress/facebookreview的软件技术,实现超过500,000的文章和图片全部自动采集过来。大约持续2分钟即可实现。

转帖我分享给多位老师的多平台数据采集。都是谷歌访问量比较大的,适合要写论文可以参考一下。多平台数据采集步骤1采集建议使用谷歌访问量比较大的网站,采用wordpress的review功能,原则上只允许一个review,或者至少有一个review也可以,以保证核心的人群能看到你的内容,而不是非目标的内容。

不需要使用代理,不需要挂代理,第一时间定位到我们需要的内容。如果要降低成本,按照我们的思路和方法基本是要找实时流量小,访问量小的网站,或者相关性要求比较低的网站,比如说不论是个人站还是企业站,都是没有必要为了追求流量小或者非目标人群看到我们的内容而采集的。另外,在百度、搜狗、360搜索等流量大的搜索引擎上,也是有办法能采集一些文章的,主要看自己的想法和需求。

比如说你要写一篇相关性非常大的文章,或者说你需要收集的是和某个主题相关的可能有60万篇文章,那么你可以试试谷歌访问量500,000的网站有多少篇搜索量比较大的文章或图片。实际上这对于技术能力不是太强的初创者来说,通过爬虫方式,百万级网站30分钟就能爬下来。但对于爬虫抓取来说,这些比赛拿到的数据不是很值钱,我们仍然需要做全网爬取。

2原始站点和目标站点的内容分类如何划分比较合理,比如我分享教育网站,但是很多做教育的网站不太适合做自媒体,定位清晰很重要。这时候你可以通过转码,把采集出来的内容,先做内容。