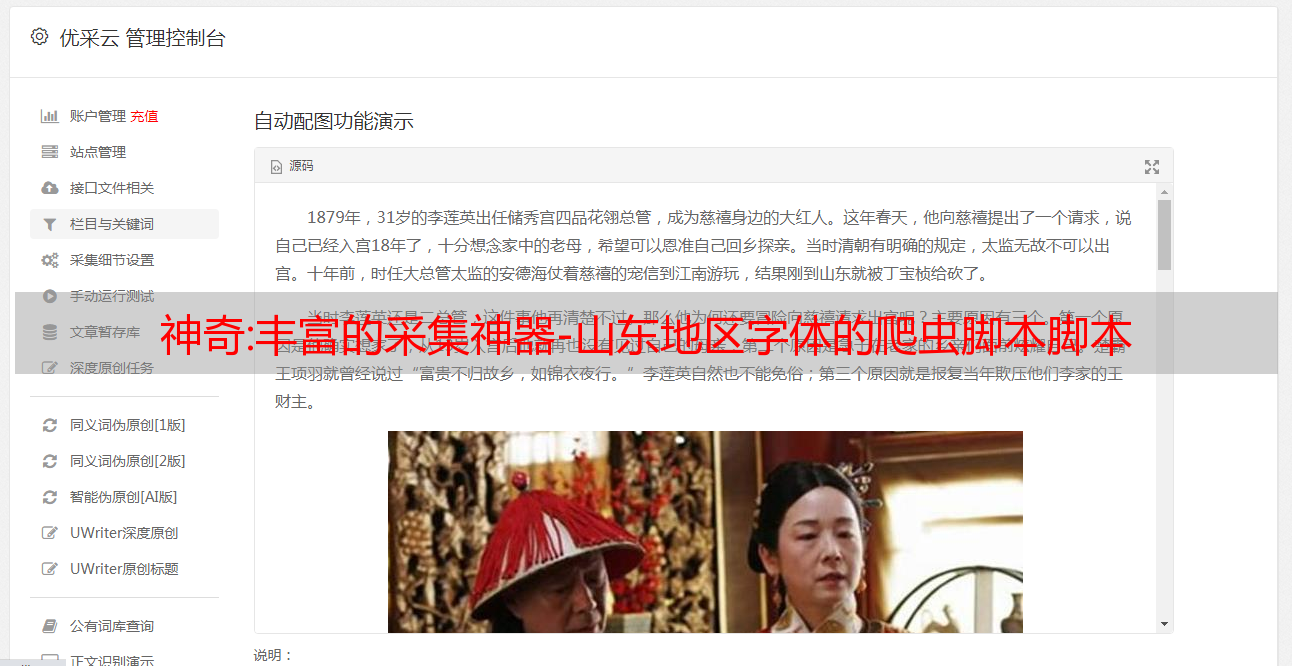

神奇:丰富的采集神器-山东地区字体的爬虫脚本脚本

优采云 发布时间: 2022-10-31 03:13神奇:丰富的采集神器-山东地区字体的爬虫脚本脚本

丰富的采集神器作者:古韵风铃(码字不易,欢迎关注)前段时间自己爬数据爬到山东聊城市的,很多地方的字体被我爬走了。用了一段时间爬虫的经验和社区学到的,这里来介绍一个简单的采集这个山东地区字体的爬虫脚本。#-*-coding:utf-8-*-frompylib.requestimportrequestimporturllib,urllib2importurllib2#初始化defbinmark():root=urllib2.urlopen("")per=request.urlopen(urllib2.urlopen(root))per['content']=urllib2.urlopen(root)per['content']=per['content'].read()returnperprint(binmark())#回车验证,如果点了回车验证,就返回true#继续循环print(binmark())binmark()字体名#如果字体名前面有'-',就点击回车验证或者到页面中找到点击点击,爬虫走采集这个页面seleniumdriver=urllib2.request.scrapy(urllib2.urlopen(""))driver=webdriver.phantomjs()driver.maximize_window()driver.find_element_by_xpath("//*[@id="]").click()driver.find_element_by_xpath("//*[@id="]").click()print(driver.find_element_by_xpath("//*[@id="]").click())获取文件和本地文件importtime#爬虫第一步:去网上找爬虫资源按照给出的urlimportrequestdriver=webdriver.phantomjs()driver.maximize_window()driver.find_element_by_xpath("//*[@id="]").click()driver.find_element_by_xpath("//*[@id="]").click()#爬虫第二步:爬取本地文件采集到的结果json=json.loads(driver.find_element_by_xpath("//*[@id="]").click())print(json)url=";callback=selenium_crawler_for_one"params=urllib2.urlopen("")#获取文件idvalue=driver.find_element_by_xpath("//*[@id="]").click()url=";callback=selenium_crawler_for_two"params=urllib2.urlopen("")#获取文件idvalue=driver.find_element_by_xpath("//*[@id="]").click()#重定向到baidui=open("c:/www/user/join.txt",'r')foriinrange(3):i.write(request.urlopen(。