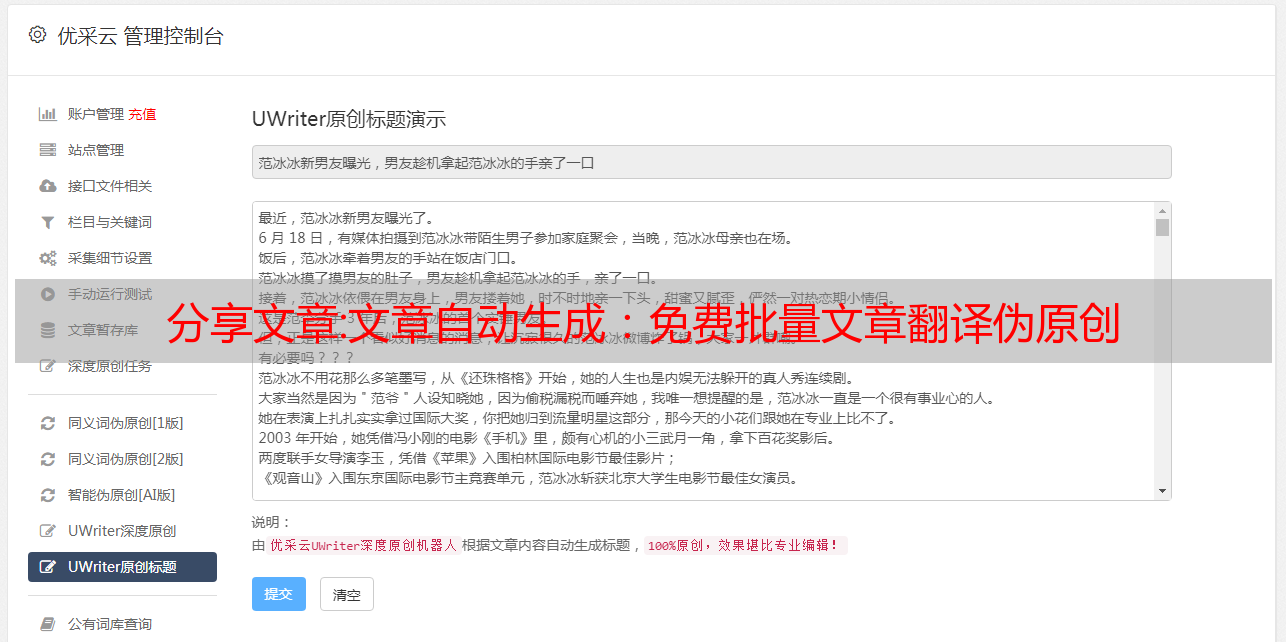

分享文章:文章自动生成:免费批量文章翻译伪原创

优采云 发布时间: 2022-10-28 22:26分享文章:文章自动生成:免费批量文章翻译伪原创

SEO翻译伪原创通过把我们原来的中文翻译成别的词,再反译成中文,形成一个新的文章,语义不会改变,但是词和主谓宾结构会发生相应的变化。与用同义词替换文章伪原创相比,SEO翻译伪原创更符合用户阅读习惯,去重率更高。

在制定 SEO 策略时,充满活力的内容是构建新内容的跳板。通过SEO翻译伪原创,我们可以向国外同行业的文章学习和采集资料。SEO翻译伪原创有视觉指定采集和批量文章翻译,集成的翻译页面让我们可以选择翻译、谷歌翻译、有道翻译等翻译渠道。多种选择有助于确保翻译质量和翻译数量。

SEO翻译伪原创不仅适用于在线采集任务,也适用于保存在本地文件夹中的文章,批量翻译伪原创可以发布,独有的翻译优化功能让我们识别原文的标签和段落,让翻译出来的文章符合用户的阅读习惯,而不是全部靠在一起,毫无美感。

SEO翻译伪原创支持文章敏感词删除、图片本地化和关键词锚文本插入等SEO技术。文章干净、有条理和搜索引擎友好的收录,用户更有可能找到我们的内容,因为内容充满活力,专注于内在兴趣的主题。通过创建有价值和有见地的帖子,人们会留在我们的页面上,从而降低跳出率。

通过搜索全球同行 网站文章 来展示我们的专业知识,然后提炼和制作动态内容。它使我们在竞争中脱颖而出,并展示了我们的垂直专业知识。考虑到这一点,让我们看看这些技巧,以帮助编写我们的动态内容。

当我们创建动态内容时,我们需要牢记我们的读者。研究表明,75% 的用户从未滚动过第一个搜索结果页面。我们的目标是生成始终与我们的用户相关且与我们的业务相关的内容。最好关注动态内容,例如“如何构建有效的电话系统”,因为这些主题永远不会过时并且总是受到追捧。总有人想更多地了解我们的专业主题。通过在我们的 网站 中收录初学者指南和常见问题解答,我们可以为这些新用户提供宝贵的资源。

这些关键字确保我们的帖子出现在搜索结果中并针对 SEO 进行了优化。SEO Translator 伪原创 拥有诸如 关键词 Mining 等工具,可以为我们的内容找到最佳的 SEO 关键字。上述工具探索了关键字的指标,这些指标表明我们的主题是否存在竞争和搜索兴趣。这允许用户应用程序确定我们的内容将如何使用可用的关键字进行排名。这是关于通过有价值且可访问的内容引起注意。

如果竞争对手在我们想要的关键字上发布并且他们的参与度很高,那么可能值得使用另一个关键字。超越他们的流量需要时间和金钱,因此关注另一个可以主导搜索结果的关键字是有意义的。

对于网站的SEO优化,无论是挖掘关键词,还是指定网站采集获取素材,都应该多从文章新颖性和人气话题开始。搜索引擎和用户都很好奇,行业突发的信息和爆炸性话题往往是大家关注的焦点,而我们的素材获取可以通过SEO翻译伪原创工具在全平台、全网搜索到.

SEO翻译伪原创让我们摆脱了文字的束缚,可以在网上搜索到我们想要的内容和素材。通过批量SEO翻译,我们可以为我们的网站源源不断地更新内容。SEO翻译的分享就到这里了伪原创,喜欢的话记得点三个链接哦。

实用文章:如何使用 Python 爬取微信公众号文章

我比较喜欢看公众号,有时候遇到一个有趣的公众号,感觉来不及见面,就想一口气读完所有的历史文章。但是,微信的阅读体验并不好。读历史文章,必须一页一页的往回翻,下次再读还得重复这个操作,很麻烦。

于是就想,能不能把某个公众号的文章全部存起来,这样自己看历史文章会很方便。

废话不多说,给大家介绍一下如何用Python爬取微信公众号的所有文章。

主要有以下几个步骤:

1 使用Fiddler抓取公众号接口数据

2 使用Python脚本获取公众号所有历史文章数据

3 保存历史文章

提琴手捕获

Fiddler是一款可以监控网络通信数据的抓包工具。它在开发和测试过程中非常有用。我不会在这里介绍它。没用过的可以看看这个文章,很容易上手。

/jingjingshizhu/article/details/80566191

接下来用微信桌面客户端打开一个公众号文章的历史,这里以我的公众号为例,如下图。

如果你的 fiddler 配置好了,你可以看到如下所示的数据。

该图收录抓取的 url、一些重要参数和我们想要的数据。

在这些参数中,偏移量控制翻页,其他参数固定在每一页中。

接口返回的数据结构如下图所示,其中can_msg_continue字段控制是否可以翻页,1表示有下一页,0表示不是最后一页。next_offset 字段是下一个请求的偏移量参数。

构造一个获取数据的请求

接下来,我们的目标是根据url和一些参数构造一个请求,获取标题、文章url和日期等数据,并保存数据。

一种是使用pdfkit将文章 url保存为pdf文件;另一种是先保存html文件,然后将html制作成chm文件。

1 将文章 url保存为pdf文件,关键代码如下:

def parse(index, biz, uin, key):

# url前缀

url = "https://mp.weixin.qq.com/mp/profile_ext"

# 请求头

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.95 "

"Safari/537.36 MicroMessenger/6.5.2.501 NetType/WIFI WindowsWechat QBCore/3.43.901.400 "

"QQBrowser/9.0.2524.400",

}

proxies = {

'https': None,

'http': None,

}

# 重要参数

param = {

'action': 'getmsg',

'__biz': biz,

'f': 'json',

'offset': index * 10,

'count': '10',

'is_ok': '1',

'scene': '124',

'uin': uin,

'key': key,

'wxtoken': '',

'x5': '0',

}

# 发送请求,获取响应

response = requests.get(url, headers=headers, params=param, proxies=proxies)

response_dict = response.json()

print(response_dict)

next_offset = response_dict['next_offset']

can_msg_continue = response_dict['can_msg_continue']

<p>

general_msg_list = response_dict['general_msg_list']

data_list = json.loads(general_msg_list)['list']

# print(data_list)

for data in data_list:

try:

# 文章发布时间

datetime = data['comm_msg_info']['datetime']

date = time.strftime('%Y-%m-%d', time.localtime(datetime))

msg_info = data['app_msg_ext_info']

# 文章标题

title = msg_info['title']

# 文章链接

url = msg_info['content_url']

# 自己定义存储路径(绝对路径)

pdfkit.from_url(url, 'C:/Users/admin/Desktop/wechat_to_pdf/' + date + title + '.pdf')

print(title + date + '成功')

except:

print("不是图文消息")

if can_msg_continue == 1:

return True

else:

print('爬取完毕')

return False</p>

2 保存html文件,关键代码如下

def parse(index, biz, uin, key):

# url前缀

url = "https://mp.weixin.qq.com/mp/profile_ext"

# 请求头

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.95 "

"Safari/537.36 MicroMessenger/6.5.2.501 NetType/WIFI WindowsWechat QBCore/3.43.901.400 "

"QQBrowser/9.0.2524.400",

}

proxies = {

'https': None,

'http': None,

}

# 重要参数

param = {

'action': 'getmsg',

'__biz': biz,

'f': 'json',

'offset': index * 10,

'count': '10',

'is_ok': '1',

'scene': '124',

'uin': uin,

'key': key,

'wxtoken': '',

<p>

'x5': '0',

}

# 发送请求,获取响应

reponse = requests.get(url, headers=headers, params=param, proxies=proxies)

reponse_dict = reponse.json()

# print(reponse_dict)

next_offset = reponse_dict['next_offset']

can_msg_continue = reponse_dict['can_msg_continue']

general_msg_list = reponse_dict['general_msg_list']

data_list = json.loads(general_msg_list)['list']

print(data_list)

for data in data_list:

try:

datetime = data['comm_msg_info']['datetime']

date = time.strftime('%Y-%m-%d', time.localtime(datetime))

msg_info = data['app_msg_ext_info']

# 标题

title = msg_info['title']

# 内容的url

url = msg_info['content_url'].replace("\", "").replace("http", "https")

url = html.unescape(url)

print(url)

res = requests.get(url, headers=headers, proxies=proxies)

with open('C:/Users/admin/Desktop/test/' + title + '.html', 'wb+') as f:

f.write(res.content)

print(title + date + '成功')

except:

print("不是图文消息")

if can_msg_continue == 1:

return True

else:

print('全部获取完毕')

return False</p>

保存文章

另存为pdf文件,使用python的第三方库pdfkit和wkhtmltopdf。

安装 pdfkit:

pip install pdfkit

安装 wkhtmltopdf:

下载链接:

/downloads.html

安装完成后,将wkhtmltopdf目录下的bin添加到环境变量中。

另存为chm文件,可以下载Easy CHM,用这个软件把html制作成chm,网上有很多教程。

下载链接:

/cn/easychm.html

效果图:

pdf和chm的比较:

pdf支持多终端,阅读体验不错,但是有个大坑,就是微信文章保存的pdf没有图片,影响阅读体验,目前还没有找到解决办法。

chm的好处是可以索引,方便查看文章。公众号制作成chm文件,便于管理。图片不显示不会有问题。

因此,建议将爬取的公众号文章保存为chm文件,方便阅读。