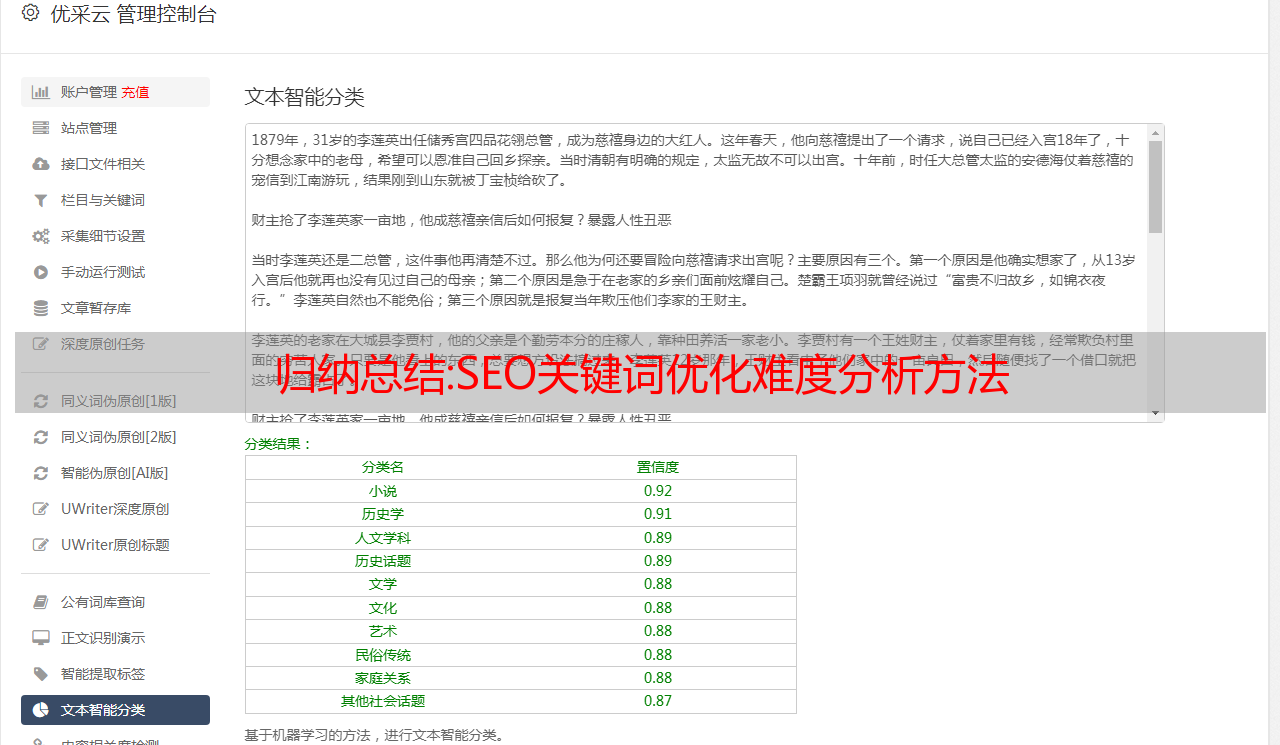

归纳总结:SEO关键词优化难度分析方法

优采云 发布时间: 2022-10-27 11:25归纳总结:SEO关键词优化难度分析方法

对于那些不熟悉 SEO 的人来说,SEO网站关键词优化似乎整天都牢记在心。虽然,无论是网站内部锚点还是外部链接,都使用网站的主要关键词并指向对应的URL。结果,我做了几个月,但一点效果都没有。接下来曼朗为大家带来关键词优化难点分析,希望对关键词的优化有所帮助。

1、关键词指数一般来说,日均搜索量越大,优化难度越大。

我们先来了解一下百度官方工具——“百度指数”(),查看关键词在百度的搜索状态,比如日均搜索量和相关搜索词。类似于360指数、搜狗指数、微信指数等,都可以在站长之家()上看到。

2、百度搜索中相关结果的数量一般来说,相关结果的数量越多,优化的难度就越大。

3、关键词的商业价值 一般来说,百度竞价广告越多,竞价越高,优化难度越大。

4、前两页的内页占比多少一般来说,网站首页占比越大,优化难度越大。相反,如果网站的内页(如文章页面)占比较大,优化难度会更低。

5、标题是否收录关键词 一般来说,如果网页标题收录关键词,就证明了SEO优化的意识,优化难度更大。使用 intitle 更容易查询。如intitle:漫浪。出现的页面标题中收录 Manlang。

六、行业核心关键词top几个网站权重核心关键词top几个网站可以通过SEO综合搜索()、爱站Net()、等,评估网站外部链接的数量和质量,网站权重,网站结构,网站文章页面优化等,来判断词的优化难度。一般来说,这些网站的权重越高,利用首页优化核心关键词的难度就越大。

7、行业核心关键词的top网站类型一般来说,如果核心关键词top几个网站多是信息网站、百科全书和know-how,等等百度产品,那么优化就很难了。相反,如果他们都在同一个行业,那么优化的难度就会降低。比如搜索“楼”,前十名中只有3个是企业网站,其余分别是信息网站、百度图片、百度百科、百度地图。在这种情况下,优化将非常困难。

8、通过SEO关键词难度分析在线工具或网站管理员之家等软件提供此类在线工具。

以上就是SEO网站关键词优化难度分析的全部内容,希望能给大家带来一些帮助。

方法和步骤:Prometheus原理与部署

Prometheus 根据 HTTP 调用(http/https 请求)定期从配置文件中指定的网络端点(endpoint/IP:port)获取指标数据。

许多环境和被监控对象不具备直接响应/处理 HTTP 请求的功能。Prometheus-exporter 可以在被监控端采集所需的数据。集合后会标准化,转换成prometheus exporter。标识、可用数据(兼容格式)

2. 采集数据:

监控理念:白盒监控、黑盒监控

白盒监控:自省方式,在被监控终端内部,可以生成自己的指标,等采集时监控系统提供即可

黑盒监控:不侵入被监控系统,对其没有直接“影响”,类似于基于探针机制(snmp协议)的监控

Prometheus 支持通过三种方式(基于白盒监控)从目标中“刮取”指标数据;

Exporters ——> 工作在被监控端,定时抓取数据并转换成pro兼容的格式等待prometheus采集,不要自己push

Instrumentation ——> 表示被监控对象本身具有数据采集和监控的功能,只需要prometheus直接获取即可

Pushgateway——>短周期5s-10s数据采集

3.prometheus(获取方法)

与其他 TSDB 相比,Prometheus 有一个非常典型的特点:主动从各个 Target 中拉取(pull)数据,而不是等待被监控端推送(push)数据

两种获取方式各有优缺点。其中,Pull 模型的优点是:

集中控制:有利于在 Prometheus 服务器上完成配置集,包括指标和取值;

Prometheus 的基本目标是采集预先聚合在 rarget 上的聚合数据,而不是事件驱动的存储系统

通过目标(识别特定的被监控终端)

例如配置文件中的targets:['localhost:9090']

prometheus 生态组件

prometheus 生态系统收录多个组件,其中一些是可选的

Prometheus Server:采集和存储时间序列数据

通过抓取获取数据并入库(TSDB时序数据库),制定Rules/Alerts:告警规则,服务发现是自动发现需要监控的节点Client Library:Client库的目的是提供Instrumentation为期待原生功能应用提供便捷的开发路径;Push Gateway:接收通常由短期作业产生的指标数据的网关,支持Prometheus Server的指标拉取操作;Exporters:用于暴露现有的应用程序或服务(不是支持 Instrumentation 的指标,交给 Prometheus Server,pro 内置了数据样本 采集器,可以通过配置文件定义,告诉 prometheus 去监控object 采集指标数据,在prometheus 采集之后,它将存储在自己内置的 TSDB 数据库中,提供 promQL 支持查询和过滤操作,并支持自定义规则作为警报规则,以持续分析指标。一旦发生,会通知alerer发送报警信息,同时也支持对接。用于显示数据的外部 UI 工具 (grafana)

采集,抓取数据是自己的功能,但是一般抓取的数据通常来自:export/instrumentation(指标数据暴露器),或者应用本身内置的测量系统(汽车仪表盘之类,测量, display) 完成Alertmanager:通过报警规则对接,收到Prometheus Server发来的“报警通知”后,通过去重、分类

经过分组、路由等预处理功能后,可以高效地向用户发送告警信息。发现要监控的目标,从而完成监控配置的重要组成部分,这在容器化环境中特别有用;该组件目前由 PropetheusServer 引入,内置支持 Exporters

node-exporter组件,因为prometheus抓取数据是通过http调用的,如果抓取的数据是操作系统的资源负载,而Linux操作系统内核没有内置http协议,不支持直接通过http方式,所以需要在每个被监控端安装node-exporter,它从内核中获取各种状态信息,然后通过prometheus兼容的指标格式暴露给prometheus

对于没有内置 Instrumentation 的应用,又不方便添加此类组件来暴露指标数据,常用的方法是在被监控的目标应用程序之外运行一个独立的指标暴露程序。这种类型的程序统称为出口商。

PS:Prometheus网站上提供了大量的Exporter。如果使用docker技术运行多个服务,应该使用docker-exportes来监控系统环境,而docker容器内部服务的监控需要使用cAdvisor容器

警报简介

捕获异常值,异常值并不意味着服务器的告警仅仅基于用户自定义的规则和标准,prometheus通过告警机制发现并发送告警。

alter负责:报警仅由prometheus根据用户提供的“报警规则”计算生成。好的监控可以提前预知报警,提前处理。alter 接受服务器发送的告警指示,并根据用户定义的告警路由(route)向告警接收者(用户定义)发送告警信息

ps:PromQL语句将用于数据查询和报警规则

普罗米修斯服务器

内置数据样本采集器可以通过配置文件定义告诉Prometheus采集指标数据到哪个监控对象,在prometheus采集之后会存储在自己构建的-在TSDB数据库中,提供promQL,支持查询和过滤操作,支持自定义规则作为告警规则,持续分析一个指标。一旦发生,通知alter发送告警信息,也支持对接外部ui工具(grafana)来展示数据,prometheus自带的web展示图片信息比较简单。

采集,抓取数据是它自己的功能。但它通常是通过导出/仪器(指标数据的公开),或从服务本身的内置测量系统来完成的。

普罗米修斯部署

服务器分配

主机名地址安装包

普罗米修斯 192.168.32.10 prometheus-2.27.1.linux-amd64.tar.gz

server1 192.168.32.20 node_exporter-1.1.2.linux-amd64.tar.gz

服务器2 192.168.32.30

服务器3 192.168.32.40

所有主机

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

vim /etc/selinux/config

SELINUX=disabled

vim /etc/reslove.conf

nameserver 114.114.114.114

ntpdate ntp1.aliyun.com #时间同步

将安装包上传到/opt

tar zxvf prometheus-2.37.1.linux-amd64.tar.gz -C /usr/local

cd /usr/local/prometheus-2.37.1.linux-amd64

cat prometheus.yml

# my global config

global: //全局组件

//每隔多久抓取一次指标,不设置默认1分钟

scrape_interval: 15s # Set the scrape interval to every 15 seconds. Default is every 1 minute.

//内置告警规则的评估周期

evaluation_interval: 15s # Evaluate rules every 15 seconds. The default is every 1 minute.

# scrape_timeout is set to the global default (10s).

//对接的altermanager(第三方告警模块)

# Alertmanager configuration

<p>

alerting:

alertmanagers:

- static_configs:

- targets:

# - alertmanager:9093

# Load rules once and periodically evaluate them according to the global 'evaluation_interval'.

rule_files: //告警规则

# - "first_rules.yml"

# - "second_rules.yml"

# A scrape configuration containing exactly one endpoint to scrape:

# Here it's Prometheus itself.

scrape_configs:

# The job name is added as a label `job=` to any timeseries scraped from this config.

- job_name: 'prometheus' //对于指标需要打上的标签,对于PrometheusSQL(查询语句)的标签:比如prometheus{target='values'}

# metrics_path defaults to '/metrics' //收集数据的路径

# scheme defaults to 'http'.

static_configs: //对于Prometheus的静态配置*敏*感*词*端口具体数据收集的位置 默认的端口9090

- targets: ['localhost:9090']

</p>

2.运行服务查看端口是否开放

直接打开Prometheus

./普罗米修斯

打开另一个终端查看9090端口

ss-natp | grep 9090

访问网页(表达式浏览器)

1.查看表达式浏览器

访问 192.168.32.10:9090

监控数据可以通过:9090/metrics查看:

(5) 部署和监控其他节点

如果prometheus要监控其他节点,需要使用node_exporter,下载地址

1.解压安装包,命令优化路径,设置服务控制,启动服务

tar zxvf node_exporter-1.4.0.linux-amd64.tar.gz

cd node_exporter-1.4.0.linux-amd64

cp node_exporter /usr/local/bin #f 复制命令让系统可以识别

./node_exporter --help #查看命令选项

服务开启方法一、使用systemctl控制

vim /usr/lib/systemd/system/node_exporter.service

[Unit]

Description=mysqld_exporter

Documentation=https://prometheus.io/

After=network.target

[Service]

Type=simple

ExecStart=/usr/local/bin/node_exporter \

--collector.ntp \

--collector.mountstats \

--collector.systemd \

--collector.tcpstat

ExecReload=/bin/kill -HUP $MAINPID

Restart=on-failure

[Install]

WantedBy=multi-user.target

<p>

</p>

2. 访问 192.168.32.20:9100/metrics 查看抓取的内容 在此处插入代码片段 在此处插入代码片段

如果需要加入其他节点监控终端,需要在192.168.32.10的prometheus服务器上停止prometheus,修改配置文件并添加静态目标使server1节点加入

网络统计-nautp | grep 普罗米修斯

killall -9 普罗米修斯

vim /usr/local/prometheus-2.37.1.linux-amd64/prometheus.yml

更改配置文件后,重启服务

访问普罗米修斯服务器

回到web管理界面→点击Status→点击Targets→可以看到多了一个监控目标

同理部署server2和3节点

tar zxvf node_exporter-1.4.0.linux-amd64.tar.gz

cd node_exporter-1.4.0.linux-amd64

cp node_exporter /usr/local/bin

./node_exporter

停止服务,修改并重启

修改vim /usr/local/prometheus-2.37.1.linux-amd64/prometheus.yml 在192.168.32.10

表达式浏览器

2、表达式浏览器的常规使用

prometheusUI 控制台提供数据过滤功能

简单用法:

总 CPU 使用率

node_cpu_seconds_total

#进阶一:

计算过去 5 分钟的 CPU 使用率

PromQL: irate(node_cpu_seconds_total{mode="idle"}[5m])

解析:

irate:速率计算函数(非常敏感)

node_cpu_seconds_total:node节点的总CPU使用率

mode="idle" 空闲指示器

5m:过去5分钟内所有CPU空闲计数的样本值,每个值进行rate计算

#进阶2:

5组内每台主机的平均CPU使用率

PromQL:(1- avg (irate(node_cpu_seconds_total{mode='idle'}[5m]))by (instance))* 100

解析

平均:平均

avg(irate(node_cpu_seconds_total{mode='idle'}[5m]):可以理解为CPU空闲的百分比

by (instance): 代表所有节点

(1- avg (irate(node_cpu_seconds_total{mode='idle'}[5m]))by (instance))* 100:5 分钟内的平均 CPU 使用率

其他常用指标:

1.查询1分钟平均负载超过主机CPU数两倍的时间序列

node_load1 > on (instance) 2 * count (node_cpu_seconds_total{mode='idle'}) by(instance)

2.内存使用

node_memory_MemTotal_bytes

node_memory_MemFree_bytes

node_memory_Buffers_bytes

node_memory_Cached_bytes

计算用量:

可用空间:上面最后三个指标的总和

已用空间:总空间减去可用空间

利用率:已用空间除以总空间