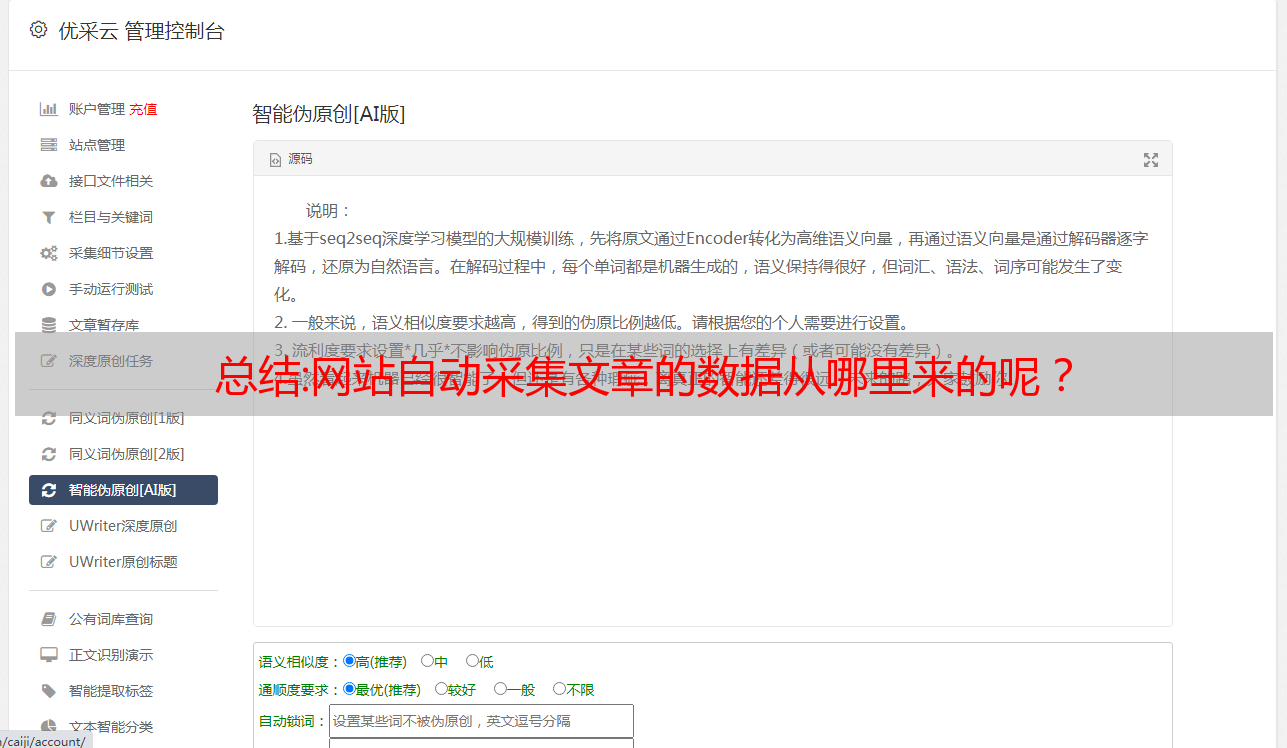

总结:网站自动采集文章的数据从哪里来的呢?

优采云 发布时间: 2022-10-27 03:11总结:网站自动采集文章的数据从哪里来的呢?

网站自动采集文章,数据抓取工具导语:我相信许多网站主非常熟悉,使用百度网页搜索吧,百度网页搜索的文章来源从哪里来的?它的文章数据从哪里来的呢?答案是,外部文章链接,也就是各种网站中各种网站链接,这就是互联网上百度站长最常用的代码生成的网站二维码,找到了这些网站,就相当于拿到了互联网这个水电表,可以爬到所有互联网的文章了。

直接就拿到了搜索结果,而且是各大网站的链接,我们需要的就是把这些网站和内容链接生成二维码,二维码是采集器必备的,打开aa采集器生成二维码插件下载软件,下载安装打开软件,提示生成二维码的教程,已经告诉你了,如下图所示:。

1、在input框中输入你要生成的数据源码,和对应的二维码或者扫码文件,点击save确定。

2、保存链接

3、手动复制输入地址去搜索引擎搜索“”然后点击手动分享(将网址复制到扫码框中)手动分享的结果就是地址,如果你找不到,可以继续下图说明。二维码是采集器必备的,爬虫采集的数据经过编码处理后,就是二维码,鼠标只要放到二维码的二维码文件中,二维码都会自动扫描并成功显示二维码,其实这个二维码还是非常重要的,因为它可以生成各种数据格式的文档,比如公司公众号里有大量的pdf格式的数据,我想把这些数据用二维码显示出来,但是没有办法,有的数据来源都是国外的,url中只有地址没有内容。

二维码可以同时分享到qq、微信等,快速爬取所有的网站数据。爬虫采集的数据从何而来呢?方法是关键,网站自动采集数据的方法有三种。第一种,分类采集法,就是按照网站的特性,分好类,比如:新闻类网站,新闻频道就不需要采集,新闻单元对应的标题和数据源码已经爬取了,剩下的页面就可以全采集了。图片分类采集法也一样,找好分类。

第二种是配合主题采集法,就是某一网站中包含和主题相关的内容,这里没有特定的网站,比如某一网站是文字类的,某一网站是视频类的,某一网站是音乐类的,这就需要你慢慢找了,可以按照主题来找,也可以按照地域来找,还可以找这个网站相关的网站,比如通过css采集主题关键词的网站,前提是你收集这些关键词时,这些网站中一定会包含这些内容。

第三种就是搜索爬取法,就是要把网站的关键词字典匹配出来,通过一些专门的搜索工具,查找出来一些关键词。比如要搜索“网址站点网址都有哪些”第四种就是借助工具。类似于浏览器扩展,它会根据你分析的网站,爬取网页到他自己的内存池,然后存到他自己的数据库里面,然后就不断增加网页了,网页采集器就这样不断的采集,相当于不断给数据库。