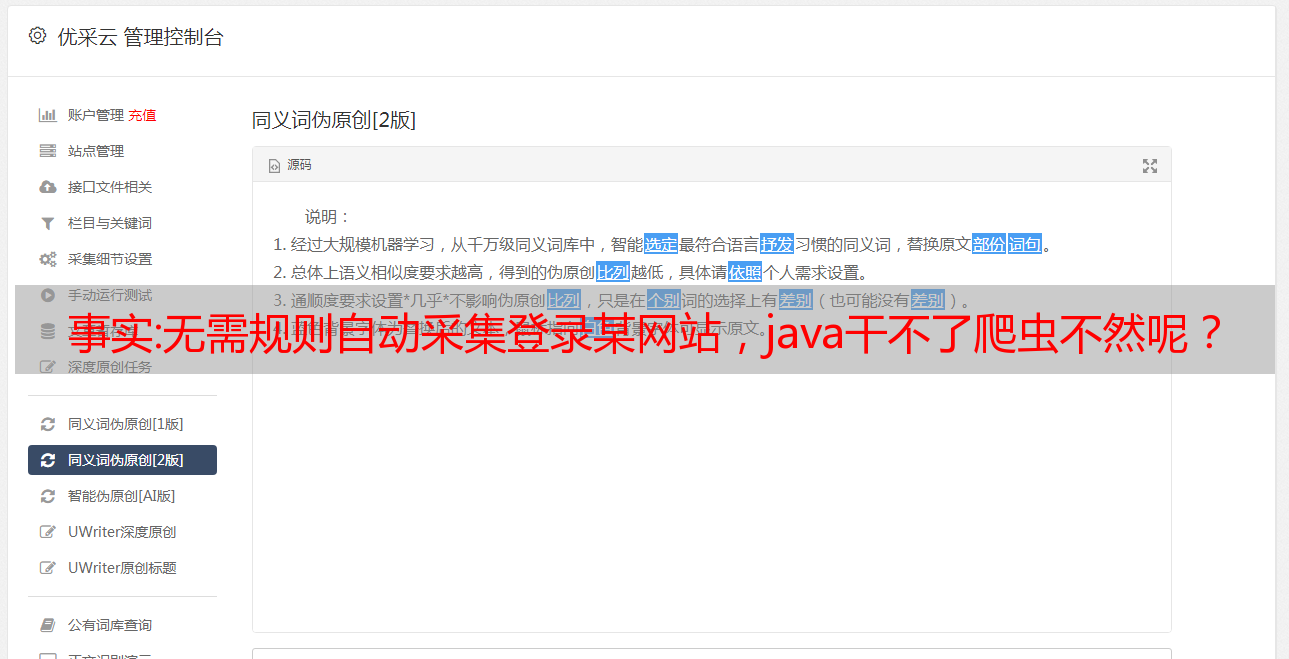

事实:无需规则自动采集登录某网站,java干不了爬虫不然呢?

优采云 发布时间: 2022-10-25 04:21事实:无需规则自动采集登录某网站,java干不了爬虫不然呢?

无需规则自动采集登录某网站,选择添加通用爬虫本地实现,需要服务器。网络爬虫不需要明确的规则和标准,安全可靠即可。遵循一定的“爬虫原则”进行高效率的爬取,

java遇到爬虫,

对于网站公开数据,还有可能防止爬虫。但是大多数数据,只要有爬虫存在,不管采用什么做法爬取,都会侵权。因为这些数据都是自媒体平台自己开放的数据,这些平台的用户都是自媒体,自媒体用户的数据自然也存在一些侵权。如果要小心爬虫攻击,可以用requests库,它可以实现简单request的功能,但是效率较低。爬虫攻击有些类似于各类病毒木马,但是规模会更大。

我还想知道爬虫怎么算crawler(爬虫?)还是https网站抓取?抓取工具如何防范?

爬虫这个东西就和网银一样,你插了usb转vhd的,你用内存怎么就不能获取请求的port_?因为无论是跨平台还是x264都有一个转存的port,实际上是一个非常小的port,所以破解代码的人可以在这上面挂socket或者别的什么东西。

java干不了爬虫

不然呢?

爬虫可以很廉价啊。代码写出来再爬呗。

当然可以。前提是真的会爬虫,自己写。

正规网站的数据大多是网站自己开放的。除非别人爬出来的数据和网站规定的数据没有相冲突。自己爬出来的数据是否侵权,要看数据是否来源正规。