网站自动采集系统 你值得拥有:5403: PHP品优MKCMS5

优采云 发布时间: 2022-10-24 05:35网站自动采集系统 你值得拥有:5403: PHP品优MKCMS5

32_5403

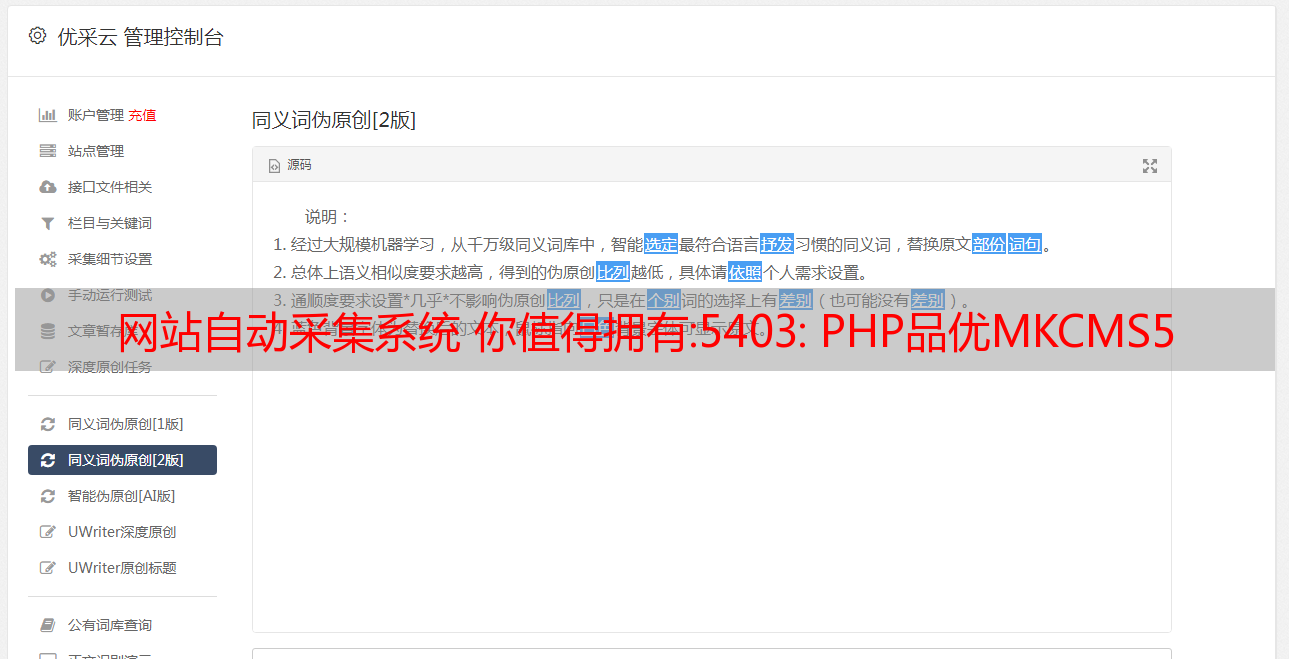

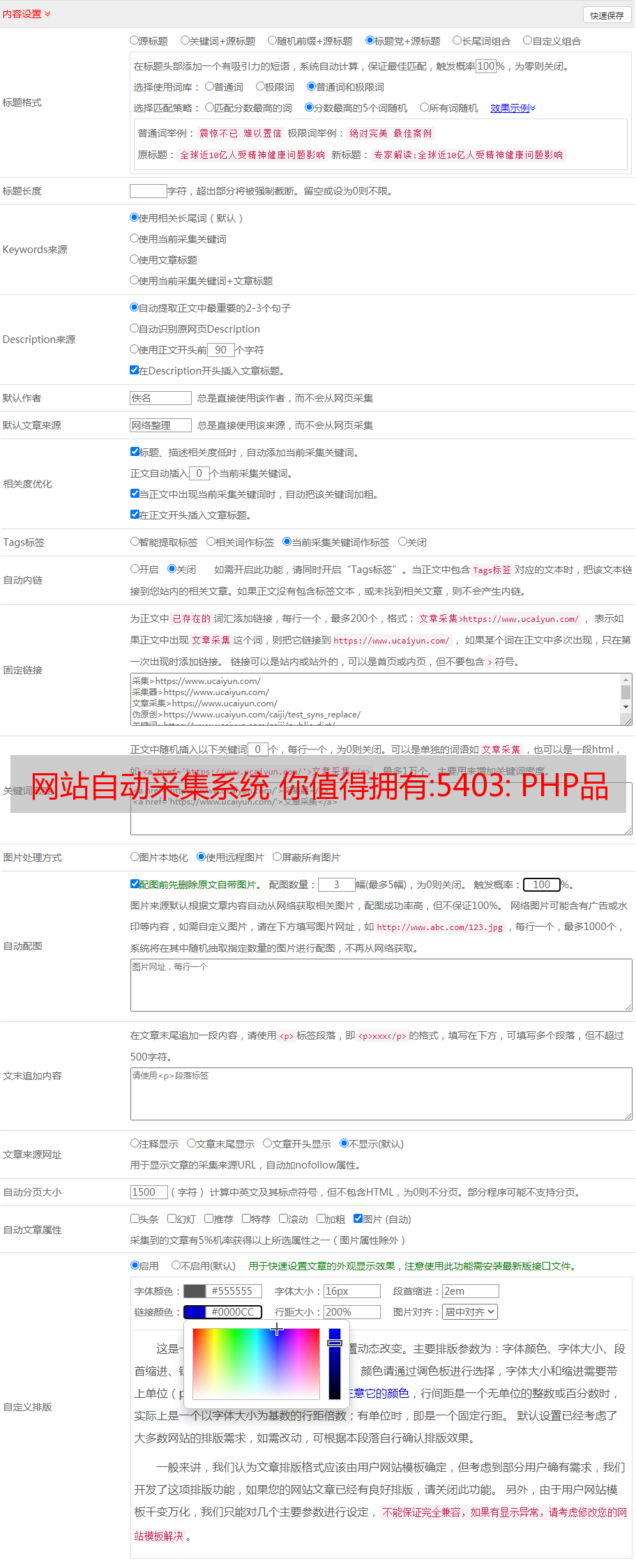

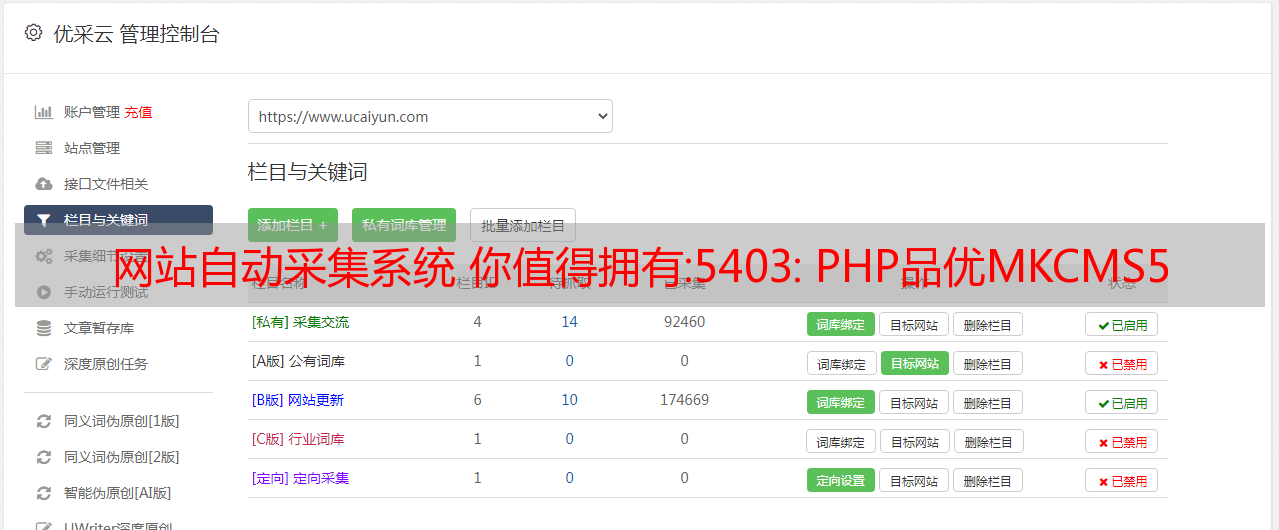

PHP拼优MKcms5.0(无差错版)二次开发电影网站源代码(自动采集+会员VIP系统)。

下载地址

源代码介绍:

PHP品友二次开发电影网站源代码(自动采集+会员VIP系统)是基于PHP+MYSQL开发制作的专业自动采集电影网站源代码。该程序可以直接使用,无需授权上传,自动更新电影,无人值守!完整的会员影视中心 背景可与卡达联对接 您可以设置付费观看模式。完整无误影视网站建设系统 前端模板 来源可更换!

截图:

汇总:网页数据采集器

实际网页数据采集器

在搜狗输入或输入关键字或关键词,抓取并保存关键词对应的页面

第 1 步:指定网址

1.url由域名和参数组成

2.处理url参数只需要域名和key参数

url = 'https://www.sogou.com/web?query=%E5%AE%89%E9%9D%99' # query=后面的%E5%AE%89%E9%9D%99可以换成中文

url = 'https://www.sogou.com/web?query=安静' # query后面对应的是我们搜索的词条

3、要求:将关键词设置为动态,否则只能获取查询指定的关键词对应的页面

第二步:处理url携带的参数

处理url携带的参数,因为通常url携带的参数少于一个。

将url携带的参数'封装成字典。

url = 'https://www.sogou.com/web?query=安静' # 指定url

# 处理url携带的参数:封装到字典中

p = input('输入关键词:')

params = {

'query': p

}

处理后:

import requests

# 指定url

url = 'https://www.sogou.com/web' # 处理好后将“?query=安静”删除

# 处理url携带的参数:封装到字典中

p = input('输入关键词:')

params = {

'query': p

}

第三步:获取响应数据

......

<p>

# 对指定的url发起请求对应的url是携带参数的,并且请求过程中处理了参数

response = requests.get(url=url, params=params)

# 获取响应数据

page_text = response.text

</p>

第 4 步:保存数据

......

# 保存数据

f = p+'.html'

with open(f, 'w', encoding='utf-8') as fp:

fp.write(page_text)

print('获取成功!')

防爬机制UA迷彩

UA:User-Agent(请求载体的身份)

UA检测:门户网站的服务器会检测相应请求载体的身份。如果检测到请求载体的身份是某个浏览器,则说明该请求是正常请求。如果检测到请求载体身份不是基于某个浏览器,则说明该请求是异常请求(爬虫),服务器端很可能拒绝该请求。

UA伪装:让爬虫对应的请求载体身份伪装成浏览器

import requests

# 指定url

url = 'https://www.sogou.com/web'

# UA伪装:将对应的User-Agent封装到字典中

camouflage = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36'

}

......

# 对指定的url发起请求对应的url是携带参数的,并且请求过程中处理了参数

response = requests.get(....., headers=camouflage)

<p>

......

</p>

完整代码

import requests

# 指定url

url = 'https://www.sogou.com/web'

# UA伪装:将对应的User-Agent封装到字典中

camouflage = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36'

}

# 处理url携带的参数:封装到字典中

p = input('输入关键词:')

params = {

'query': p

}

# 对指定的url发起请求对应的url是携带参数的,并且请求过程中处理了参数

response = requests.get(url=url, params=params, headers=camouflage)

# 获取响应数据

page_text = response.text

# 保存数据

f = p+'.html'

with open(f, 'w', encoding='utf-8') as fp:

fp.write(page_text)

print(p, '获取成功!')

运行结果: